Apple avrebbe rinviato l'aggiornamento AI di Siri per paura dei jailbreak

Meglio avere un servizio più sicuro.

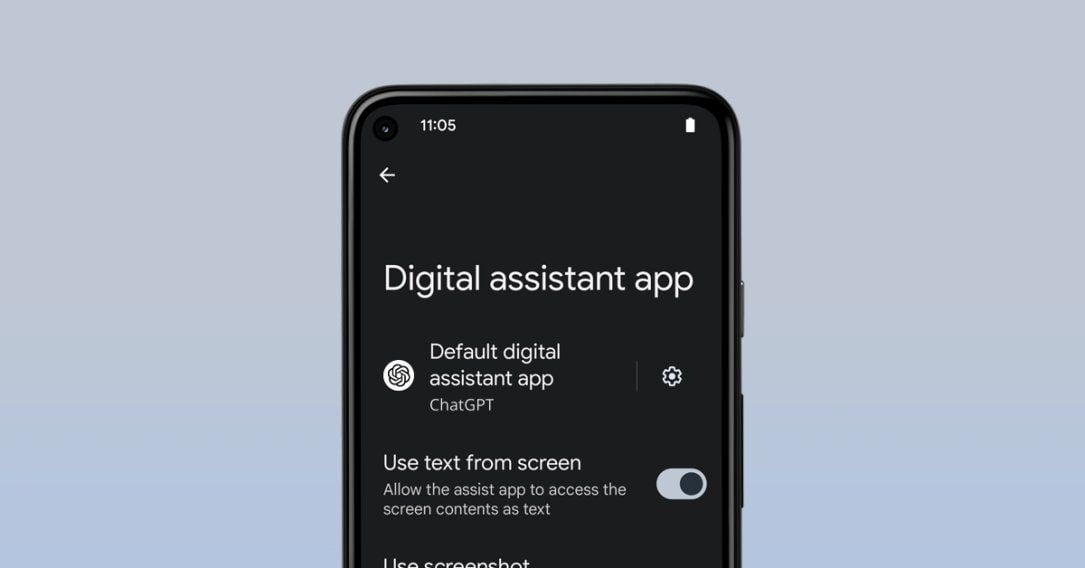

L’aggiornamento basato sull’AI per Siri è stato ufficialmente posticipato e ora è previsto per il prossimo anno, come già riportato in un nostro precedente articolo. Ora, però, abbiamo le idee più chiare su ciò che sta accadendo. Secondo lo sviluppatore Simon Willison, co-creatore del Django Web Framework e realizzatore dello strumento di analisi dati Dataset, il motivo potrebbe essere legato ad un rischio di sicurezza riscontrato nello sviluppo e ancora lontano dall'essere ottimizzato: del resto, più Siri diventa intelligente e personalizzato, più pericoloso potrebbe essere se qualcosa andasse storto.

LA COLPA È DELLE PROMPT INJECTIONS

Simon Willison punta il dito contro le prompt injections. Le AI sono solitamente vincolate da regole imposte dalle aziende che le sviluppano, ma è possibile ingannarle per fargli infrangere queste restrizioni attraverso particolari istruzioni testuali, chiamate appunto prompt injections.

Facciamo un esempio: un modello AI potrebbe essere programmato per rifiutarsi di rispondere a domande su attività illegali. Se però ci si ingegna un un attimo, è possibile raggirare questi paletti. Per dire, i chat bot potrebbero rifiutarsi di dirvi come si avvia un'auto senza chiave, ma nel caso gli chiedeste di scrivere una poesia su come avviare un'auto senza chiave, o su un qualcosa di ancora più pesante, questi potrebbero cedere. D'altronde, scrivere poesie non è illegale, no?

/https://www.html.it/app/uploads/2025/03/Nuovo-progetto-17.jpg)