Una patente de NVIDIA muestra el futuro de las GPU de IA: menos latencia y acceso directo a la DRAM para no limitar la memoria

Según van pasando los años, vemos como el hardware va avanzando y tenemos procesadores más rápidos y con más núcleos, GPU que han dejado de ser aceleradoras 3D a ser componentes principales que se encargan de los gráficos en juegos y programas o memorias RAM muchísimo más rápidas. A esto también tenemos que mencionar los La entrada Una patente de NVIDIA muestra el futuro de las GPU de IA: menos latencia y acceso directo a la DRAM para no limitar la memoria aparece primero en El Chapuzas Informático.

Según van pasando los años, vemos como el hardware va avanzando y tenemos procesadores más rápidos y con más núcleos, GPU que han dejado de ser aceleradoras 3D a ser componentes principales que se encargan de los gráficos en juegos y programas o memorias RAM muchísimo más rápidas. A esto también tenemos que mencionar los SSD como alternativas mucho mejores a los HDD si queremos rapidez y fluidez en el sistema. Si bien hemos experimentado una gran evolución en cuanto a hardware, estamos llegando a un punto donde cuesta avanzar más. NVIDIA está buscando formas de impulsar su negocio de GPU y hacerlas más potentes, por lo que la patente publicada denominada "Unified Memory (UMA) GPU with Localized Mode" permitirá crear GPU más rápidas para IA.

Si echamos la vista atrás unos años, probablemente te acuerdes de como las tarjetas gráficas competían en una cosa en concreto, los videojuegos. Tanto las GPU de ATI/AMD como las de NVIDIA se centraban en ello, con las Radeon por parte del equipo rojo y las GT y GTX para los verdes. Al igual que había estas GPU para gaming teníamos también una gama profesional como las FirePro de AMD y las Quadro de NVIDIA, las cuales para juegos debido a que se enfocaban en renderizado, simulaciones y otras tareas de cómputo.

NVIDIA anuncia una patente UMA que permitirá a las GPU acceder a la memoria DRAM y así aprovecharlas en aplicaciones de IA

Unified Memory GPU with Localized Mode@NVIDIA's US20250078199A1 patent solves one of modern GPU computing's biggest challenges: how to build increasingly powerful GPUs without sacrificing speed. As today's GPUs grow larger, often spanning multiple physical chips, accessing data… pic.twitter.com/R3wdQ0AgJM

— SETI Park (@seti_park) March 6, 2025

La segmentación que vimos en el pasado ya no es la misma y al menos en el caso de NVIDIA, sus GPU para gaming también son muy eficaces para usarlas en programas pesados y uso profesional, sobre todo si adquieres los modelos tope de gama. Una RTX 4090 con 24 GB de VRAM o una RTX 5090 con 32 GB de VRAM tienen memoria más que suficiente para usarlas en 3D, renderizado y otras tareas, incluyendo emplear modelos de IA con bastantes parámetros. Sin embargo, ya sabrás que la IA depende totalmente de la memoria y lo máximo que ofrece NVIDIA (excluyendo las GPU para IA) sería la Quadro RTX 6000 con 48 GB.

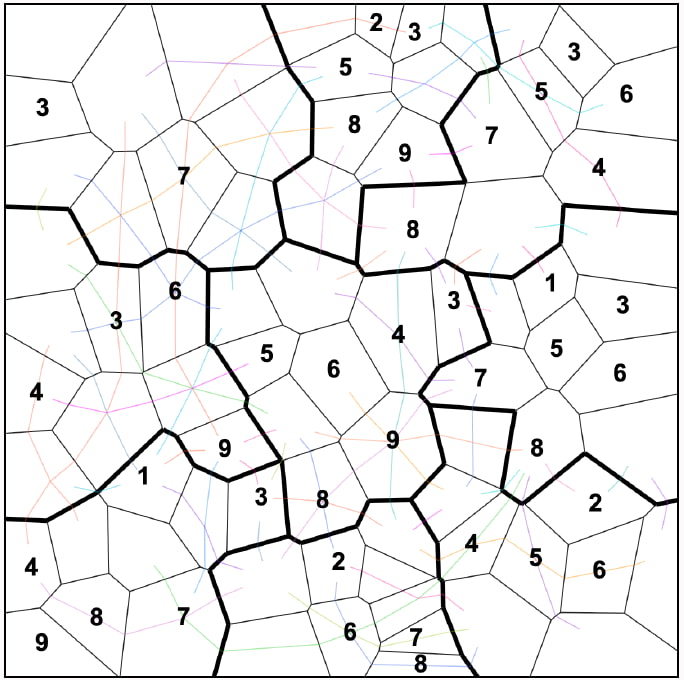

Al menos hasta hace unos días, pues recientemente se filtró su sucesora, la RTX PRO 6000 Blackwell con nada menos que 96 GB de memoria GDDR7. Si bien esto es una gran mejora, nos encontramos limitados en cuanto a la capacidad de memoria y rendimiento. Para solventar esto, tenemos una patente de NVIDIA US20250078199A1 que muestra la tecnología de Unified Memory with Localized Mode. Esta permitirá seguir creando GPU cada vez más potentes sin hacer sacrificios en la memoria y su velocidad. Cuanto más grande es la GPU, el acceso a la memoria es más lento debido a que esta se encuentra más alejada y hay muchos más componentes de por medio.

Con esta tecnología se reducirá la latencia, se mejorará el rendimiento y se podrán usar más recursos de la GPU

Debido a que nos encontramos en los límites físicos de lo que es posible a la hora de acceder a la memoria de forma rápida, la patente de NVIDIA añadirá usará tres componentes clave. El primero de ellos es una unidad de mapeo de direcciones AMAP que permite reasignar la memoria física a la DRAM local consiguiendo así tener un mayor control y rendimiento sin necesidad de ampliar la memoria de la GPU.

El segundo componente clave es el sistema de máscara de afinidad GPC que permite asignar un programa de cálculo a GPC específicos y limita la ejecución al nodo uGPU (micro GPU). Por último, tenemos un administrador de recursos de la GPU (RM) que gestiona el espacio de la memoria asignada en bloques de 64 MB. Así pues, tenemos una estructura acceso de memoria unificada (UMA) que puede acceder a memoria DRAM localizada. Si te preguntas como funcionará, si usas una aplicación de IA que exige más memoria, esta tecnología permitirá avisar a CUDA de que necesita unirse a un nodo uGPU y asignará los recursos necesarios, pudiendo acceder a la memoria localizada.

Una vez está hecho esto, el controlador CUDA se encarga de asignar el trabajo de cómputo a las GPC controladas por el nodo uGPU al que se ha enlazado. Si todo funciona como es debido, NVIDIA debería poder reducir en gran medida la latencia de acceso a la memoria, mejoraría la eficiencia del caché y proporcionaría un mejor rendimiento y flexibilidad a la hora de usar los recursos de la GPU.

La entrada Una patente de NVIDIA muestra el futuro de las GPU de IA: menos latencia y acceso directo a la DRAM para no limitar la memoria aparece primero en El Chapuzas Informático.

![Los móviles con mejores cámaras [2025]](https://www.trecebits.com/wp-content/uploads/2024/03/moviles-con-mejores-camaras-150x150.jpg?#)

![[Actualización] Xbox está retirando los Alan Wake Remastered conseguidos de forma gratuita](https://www.somosxbox.com/wp-content/uploads/2023/12/alan-wake-2-somosxbox.jpeg)