DeepSeek FlashMLA: así es como China ha conseguido multiplicar por 8 la potencia en TFLOPS de las NVIDIA H800

Estados Unidos se considera el país más avanzado en cuanto a tecnología si tenemos en cuenta que la mayoría de empresas importantes están ubicadas allí. Eso no implica que destaque en todos los sectores, pues por ejemplo, en cuanto a empresas de semiconductores, TSMC en Taiwán sigue estando por delante de Intel y otras mientras La entrada DeepSeek FlashMLA: así es como China ha conseguido multiplicar por 8 la potencia en TFLOPS de las NVIDIA H800 aparece primero en El Chapuzas Informático.

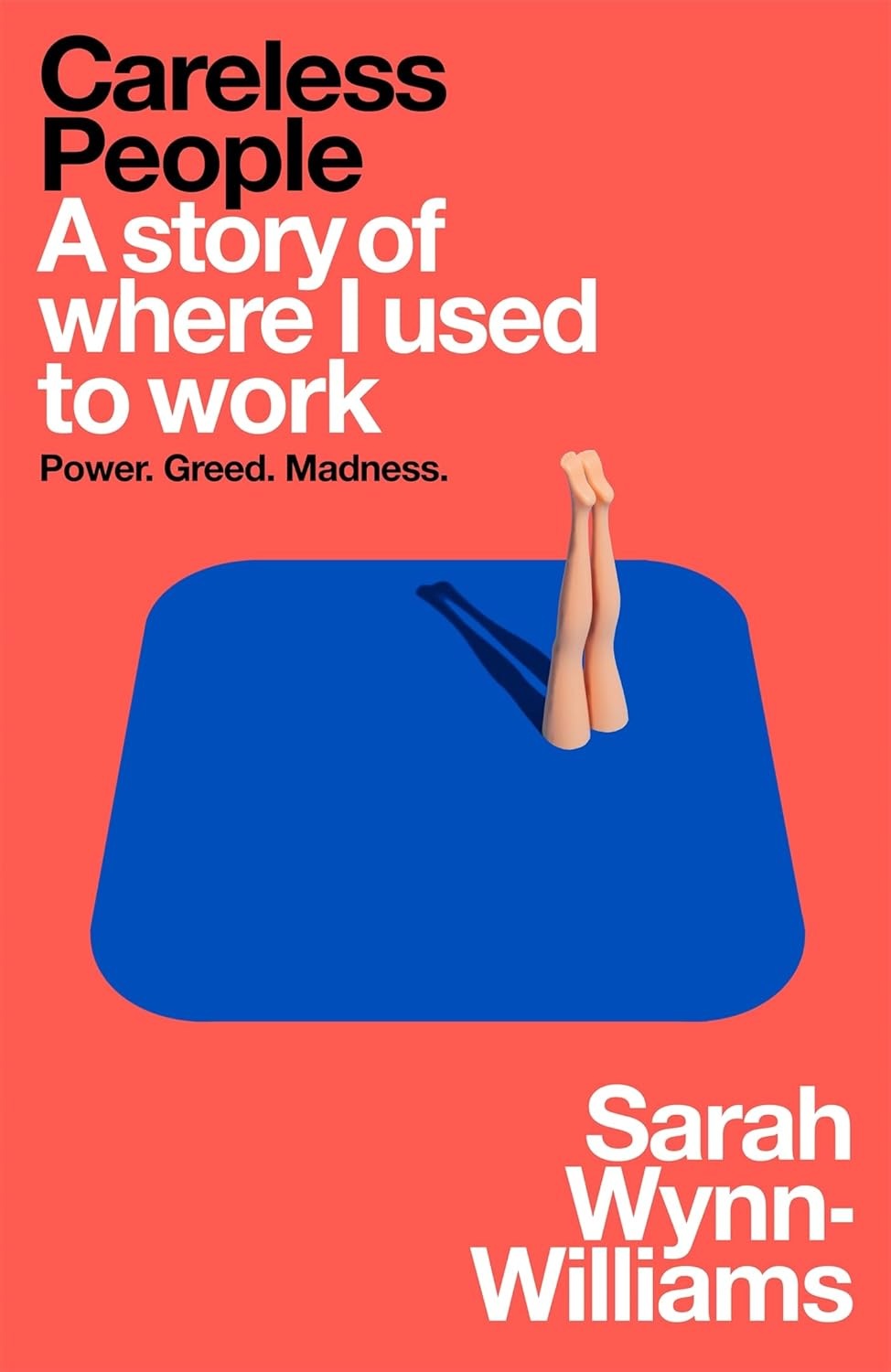

Estados Unidos se considera el país más avanzado en cuanto a tecnología si tenemos en cuenta que la mayoría de empresas importantes están ubicadas allí. Eso no implica que destaque en todos los sectores, pues por ejemplo, en cuanto a empresas de semiconductores, TSMC en Taiwán sigue estando por delante de Intel y otras mientras que en maquinaria de creación de chips, ASML está como líder y se encuentra en Europa. En cambio, si hablamos de inteligencia artificial, EE.UU. tiene todas las de ganar, aunque eso no significa que otros países hayan abandonado. DeepSeek revolucionó completamente el sector por ser una empresa china que consiguió llegar al nivel de OpenAI usando mucho menos hardware y ahora revelan que su secreto es FlashMLA, que permite conseguir optimizar y lograr mucho más rendimiento con GPU.

Antes de que la inteligencia artificial generativa empezara a popularizarse y tuviera su gran auge, Estados Unidos decidió golpear a China donde más dolía. Se encargó de que el gigante asiático no tuviera acceso a los chips de alto rendimiento para IA ni tampoco a la maquinaria para crear chips avanzados. Con esto, Estados Unidos no tendría ningún rival que pudiera peligrar su ascenso a la fama y el dominio absoluto del sector de la inteligencia artificial. Al menos eso es lo que creían, pero hace poco vimos como China si podía llegar a pelear y poner en apuros a las mejores empresas estadounidenses.

DeepSeek FlashMLA: decodificador por kernel que se encarga de optimizar y mejorar el rendimiento de las GPU NVIDIA Hopper

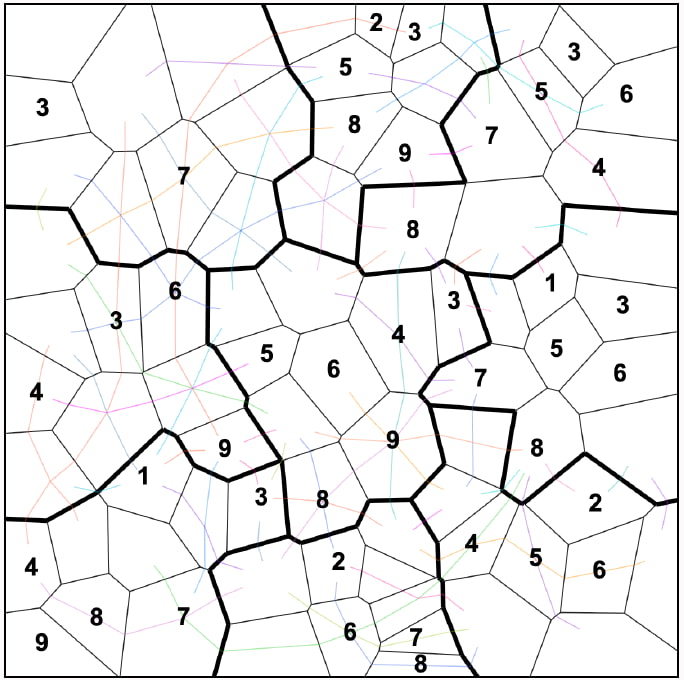

This is crazy.

-> Blazing fast: 580 TFLOPS on H800, ~8x industry avg (73.5 TFLOPS).

-> Memory wizardry: Hits 3000 GB/s, surpassing H800’s 1681 GB/s peak.— Visionary x AI (@VisionaryxAI) February 24, 2025

DeepSeek lanzó su modelo R1 el mes pasado y provocó pérdidas multimillonarias a Microsoft, OpenAI y sobre todo a NVIDIA, la cual fue la que más sufrió. La razón de esta gran caída fue debido a que DeepSeek logró hacer un modelo de IA comparable a OpenAI y al de otras grandes empresas usando una fracción de su hardware y tiempo. Lo que provocó esto es que el argumento de comprar decenas de miles de GPU de NVIDIA para entrenar un modelo de inteligencia artificial avanzado no eran tan necesario como se había asegurado previamente.

En el caso de DeepSeek, se estima que usaron miles de GPU NVIDIA H800 recortadas para IA, pues China no puede comprar directamente las H100 y otras GPU más avanzadas. Ahora DeepSeek ha anunciado FlashMLA, su kernel de decodificación MLA que se encarga de optimizar las GPU de la familia Hopper de NVIDIA. Una gráfica como la H800 con FlashMLA logra conseguir 3.000 GB/s de ancho de banda de memoria y nada menos que 580 TFLOPS de potencia de cálculo.

DeepSeek logró 580 TFLOPS de potencia (8x más que la media) y casi el doble de ancho de banda con esta optimización por software

Para que nos hagamos una idea, los 580 TFLOPS implican 8 veces más potencia de cálculo que la media de la industria que se encuentra en 73,5 TFLOPS. De hecho, esto supera por mucho la potencia de una gráfica como la RTX 4090 o la RTX 5090 que ha salido hace poco y en el caso de GPU para IA, implicaría poner una H800 por encima de otras gráficas de NVIDIA más modernas. Además de esto, conseguir 3.000 GB/s es otro de los logros de DeepSeek FlashMLA, pues aquí implica casi duplicar el máximo de 1.681 GB/s que consigue la H800 de normal.

DeepSeek ha revelado esta tecnología en el primer día de la semana Open Source, donde muestra como consiguió lograr lo que consiguieron las mejores empresas estadounidenses con una parte de sus recursos y hardware. Con FlashMLA, consiguieron añadir soporte para BF16 en las Hopper H800 y también un caché KV paginado por bloques que asigna memoria de forma dinámica en función de las tareas. Todo esto lo ha conseguido con optimizaciones a nivel de software que no modifican el hardware y de hecho, es una de las claves por las que DeepSeek no necesita las GPU de NVIDIA más potentes y caras para ser competitiva.

La entrada DeepSeek FlashMLA: así es como China ha conseguido multiplicar por 8 la potencia en TFLOPS de las NVIDIA H800 aparece primero en El Chapuzas Informático.

![Los móviles con mejores cámaras [2025]](https://www.trecebits.com/wp-content/uploads/2024/03/moviles-con-mejores-camaras-150x150.jpg?#)