Akamai lance Akamai Cloud Inference

Akamai renforce son expertise en intelligence artificielle avec le lancement d'Akamai Cloud Inference Ce nouveau service permet aux entreprises de tripler leur débit, de réduire leur temps de latence de 60 % et de diminuer leurs coûts de 86 % par rapport à une infrastructure hyperscale traditionnelle. - Produits

Akamai dévoile Akamai Cloud Inference, une solution destinée à accélérer l'innovation pour les organisations souhaitant transformer les modèles prédictifs et les grands modèles de langage (LLM) en actions concrètes. Akamai Cloud Inference repose sur Akamai Cloud, le réseau le plus distribué au monde, afin de répondre aux contraintes des modèles cloud centralisés.

La nouvelle solution d'Akamai offre aux ingénieurs et développeurs des outils optimisés pour les applications d'IA ainsi que des charges de travail riches en données à proximité des utilisateurs finaux. Cette solution propose un débit trois fois supérieur tout en réduisant la latence jusqu'à 2,5 fois. En outre, les entreprises peuvent économiser jusqu'à 86 % sur les charges de travail d'inférence d'IA et d'IA agentique par rapport à l'infrastructure hyperscale traditionnelle. Akamai Cloud Inference comprend :

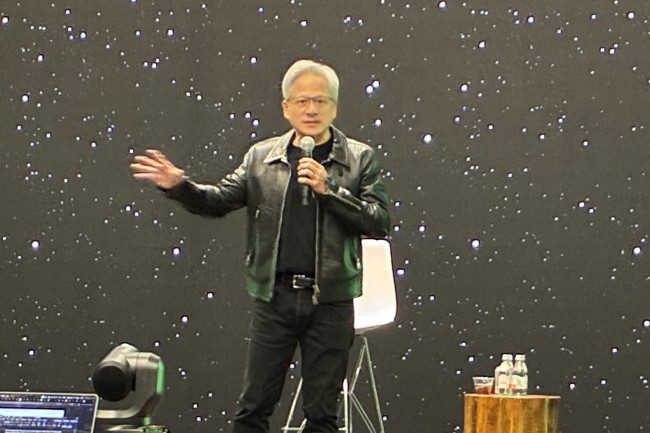

• Calcul : Akamai Cloudpropose une gamme d'options de calcul, des processeurs classiques aux GPU optimisés, en passant par les VPU ASIC sur mesure. L'intégration à l'écosystème AI Enterprise de Nvidia, en tirant parti de Triton, de Tao Toolkit, de TensorRT et de NvFlare assure une inférence IA optimisée sur les GPU Nvidia.

• Gestion des données : En collaboration avec VAST Data, Akamai fournit un accès simplifié aux données en temps réel. À cela s'ajoute un stockage d'objets évolutif et une intégration avec les principaux fournisseurs de bases de données vectorielles, dont Aiven et Milvus, pour permettre la génération augmentée de récupération (RAG).

Grâce à son système de gestion des données, Akamai stocke en toute sécurité des modèles d'IA optimisés et leurs éléments d'apprentissage, permettant une intelligence artificielle rapide et efficace à l'échelle mondiale.

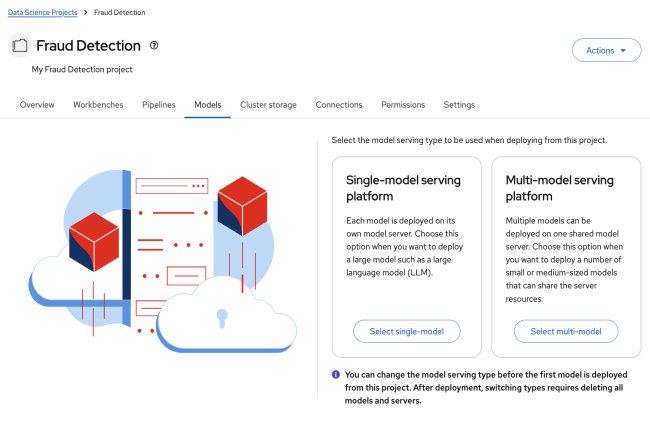

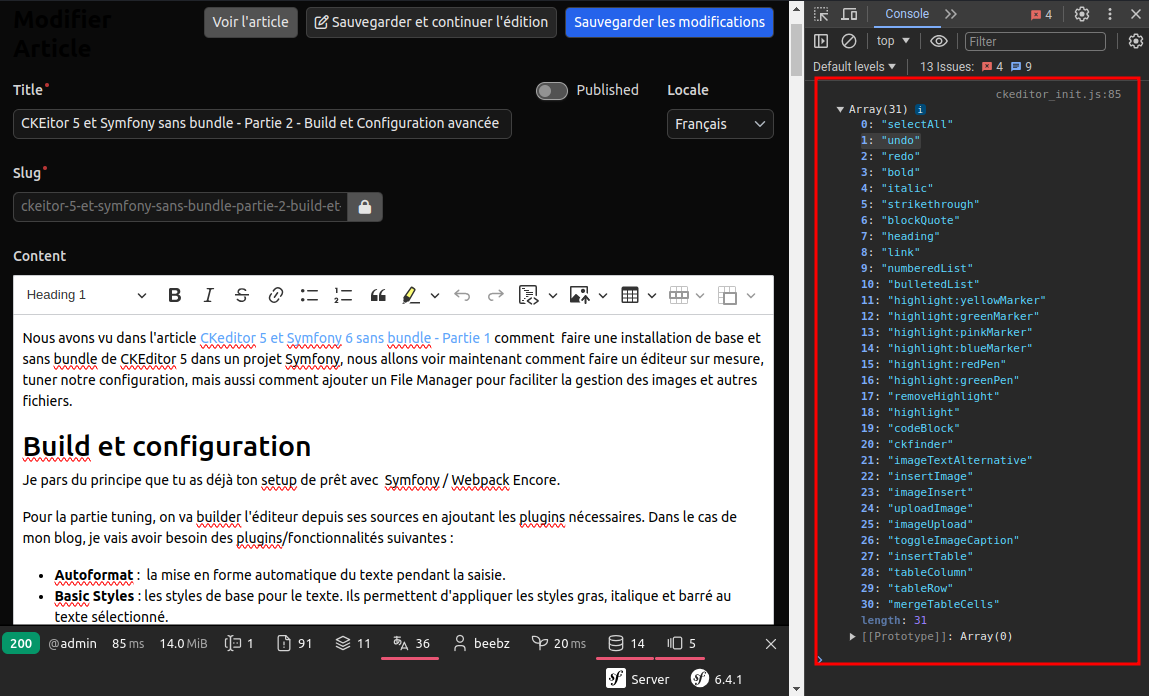

• Mise en conteneur : Grâce à Kubernetes, Akamai assure une mise à l'échelle automatique, une meilleure résilience et une optimisation des coûts. Soutenu par Linode Kubernetes Engine - Enterprise, et de la plateforme d'applications Akamai, Akamai Cloud Inference permet de déployer rapidement une plateforme prête pour l'IA de projets Kubernetes open source, notamment Kserve, KubeFlow et SpinKube, parfaitement intégrés pour rationaliser le déploiement de modèles d'IA pour l'inférence.

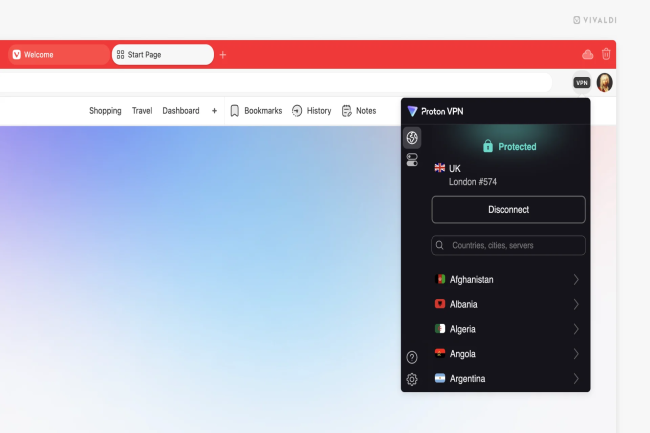

• Edge computing : Akamai AI Inference exploite des fonctionnalités WebAssembly (WASM) permettant aux développeurs d'exécuter des inférences pour les LLM directement à partir d'applications serverless, permettant d'exécuter du code léger en périphérie pour créer des applications sensibles à la latence.

Ces fonctionnalités forment une plateforme puissante, capable de supporter plus d'un pétaoctet par seconde de débit. Avec plus de 4 100 points de présence répartis sur 1 200 réseaux dans 130 pays, Akamai Cloud accélère les performances des applications et renforce leur évolutivité.

À mesure que l'IA se démocratise, les entreprises réalisent que la popularité des LLM a souvent détourné l'attention des solutions IA plus adaptées aux défis métier spécifiques. Les LLM excellent dans les tâches générales (synthèse, traduction, le service client) mais restent coûteux et complexes à entraîner. A l'inverse, les modèles d'IA légers, conçus pour des problèmes spécifiques, offrent une meilleure rentabilité en exploitant des données propriétaires pour des résultats précis et mesurables.

Selon Gartner, 75 % des données seront générées hors des centres de données centralisés d'ici 2025. Cette évolution stimule la demande de solutions d'IA exploitant la donnée directement à son origine, nécessitant une infrastructure adaptée pour des décisions plus rapides et plus intelligentes. Akamai Cloud Inference répond à cette exigence en proposant une architecture cloud distribuée, idéale pour les cas d'usage en intelligence opérationnelle. Parmi les premiers exemples de clients de la solution, on peut citer l'assistance vocale embarquée, gestion agricole assistée par l'IA, optimisation des images le e-commerce, expériences d'achat en réalité augmentée, automatisation de descriptions de produits et analyse des avis clients.

(2).webp)

![Bilan 2024 : Les nouveautés Agorapulse pour booster votre stratégie sociale [Infographie]](https://www.agorapulse.com/fr/blog/wp-content/uploads/sites/3/2025/03/FR-New-Favorite-Agorapulse-Features-of-2024-Blogpost-Header-scaled.jpg?#)