DeepSeek & Co. kostenlos auf eigenem PC lokal starten

Sogenannte KIs wie Deepseek oder andere ChatGPT-Klone lassen sich auch lokal auf dem eigenen Rechner speichern. Der Vorteil: Niemand sieht eure Eingaben und die KI arbeitet für euch. Für euch ganz allein! Wie ihr euren eigenen KI-Assistenten in Windows, macOS und Linux einrichtet, seht ihr hier.

Sogenannte KIs wie Deepseek oder andere ChatGPT-Klone lassen sich auch lokal auf dem eigenen Rechner speichern. Der Vorteil: Niemand sieht eure Eingaben und die KI arbeitet für euch. Für euch ganz allein! Wie ihr euren eigenen KI-Assistenten in Windows, macOS und Linux einrichtet, seht ihr hier.

DeepSeek und KI-Klone auf dem PC speichern

Es gibt zwei beliebte Methoden, um KI-Modelle wie ChatGPT lokal auf dem eigenen Rechner zu starten: Entweder man nutzt ein einfaches Kommandozeilen-Fenster in Kombination mit der Software-Plattform Ollama oder das Programm „LM Studio“ mit einer grafischen Benutzeroberfläche (GUI).

KI-Modelle laufen am besten, wenn ihr eine schnelle dedizierte Grafikkarte habt (Beispiele: NVIDIA GeForce RTX 3080, AMD Radeon RX 6800 XT), da die notwendige Berechnungen von diesen schneller durchgeführt werden. Die meisten KI-Modelle funktionieren aber auch ohne dedizierte GPU. Es dauert dann aber deutlich länger, bis eine Antwort generiert wird.

KI mit „LM Studio“ speichern und starten (GUI)

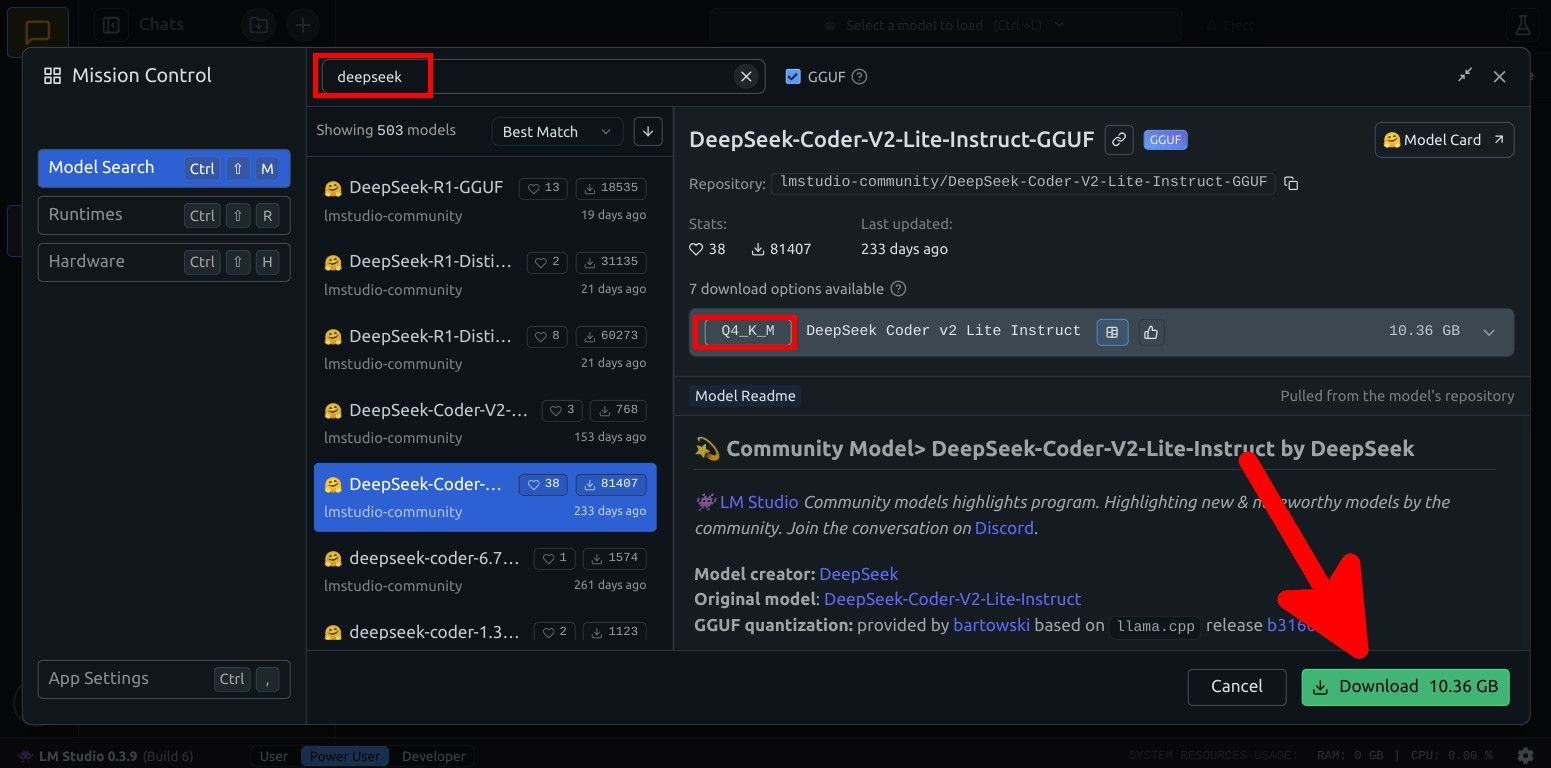

Die erste Methode nutzt eine grafische Benutzeroberfläche (GUI), über die man KI-Modelle auf dem PC speichern und starten kann. Dies ist etwa für diejenigen gedacht, die ein bekanntes Chat-Fenster haben wollen, ähnlich wie man es von Chat-GPT und Co. kennt.KI-Modelle herunterladenLadet euch das Programm LM Studio für euer Betriebssystem herunter und installiert es. Im Programm selbst klickt ihr links dann auf das Lupen-Symbol, um nach kompatiblen KI-Modellen zu suchen. Orientiert euch bei den verfügbaren Parameter- und Quantisierungsangaben bei der obigen Ollama-Anleitung. Klickt auf den Button „Download“, um das KI-Modell herunterzuladen. Dabei wird auch die benötige Speichergröße angezeigt. Hier könnt ihr Modelle suchen und herunterladen.KI-Modell starten

Hier könnt ihr Modelle suchen und herunterladen.KI-Modell starten

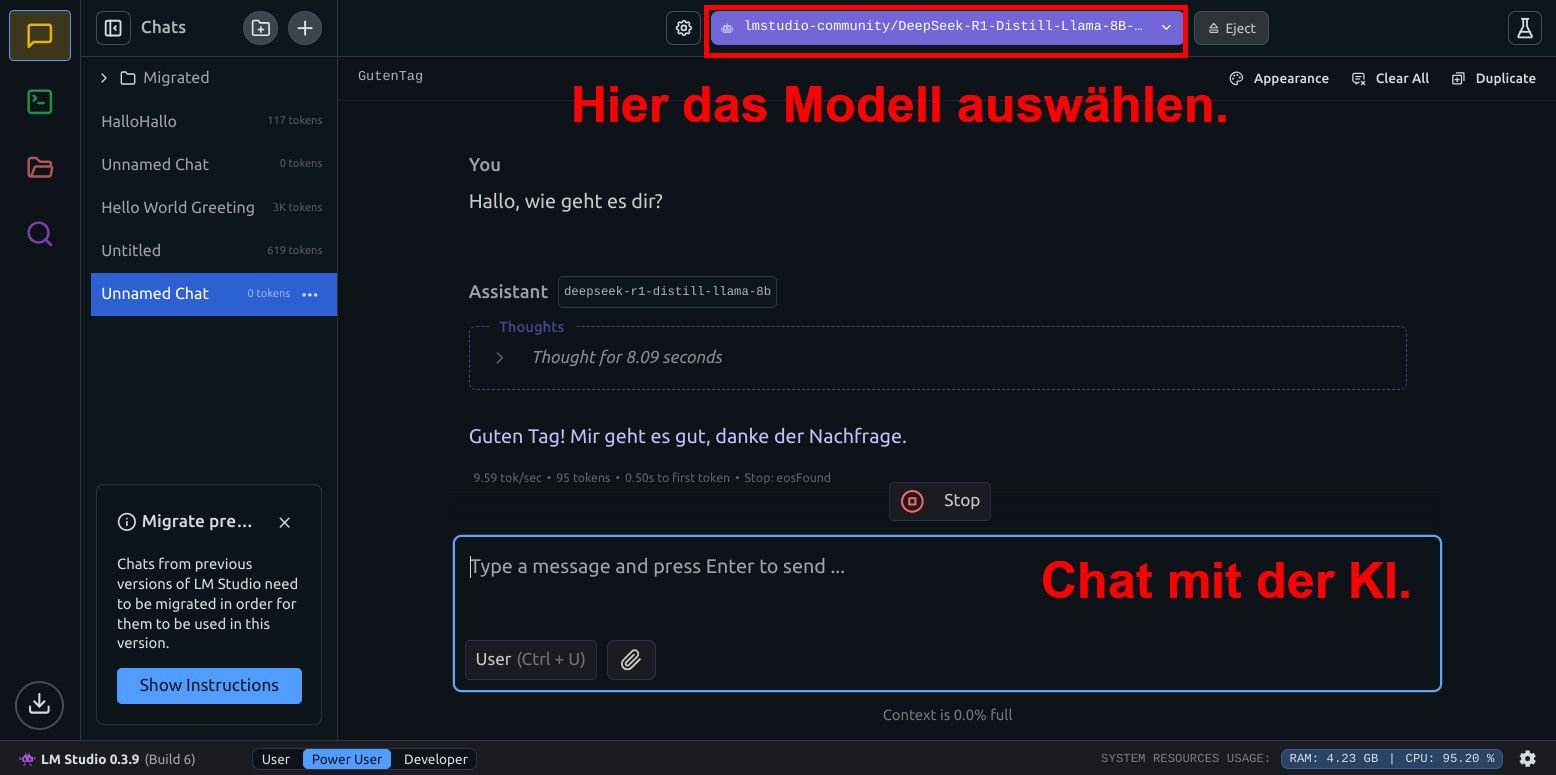

Wenn ihr ein KI-Modell heruntergeladen habt, könnt ihr es im Hauptfenster von „LM Studio“ starten.Klickt oben auf den Button „Select a model to load“ und wählt euer heruntergeladenes KI-Modell aus. Es erscheint ein Fenster mit den gewünschten Einstellungen. Am besten lasst ihr die Voreinstellungen und klickt auf den Button „Load Model“. Danach könnt ihr im Chat-Fenster eure Fragen stellen. Oben ladet ihr das Modell, unten wird gechattet.

Oben ladet ihr das Modell, unten wird gechattet.

Um ein KI-Modell wieder zu löschen, klickt ihr im Hauptfenster links auf das rote Ordner-Symbol. Ihr seht nun eine Liste aller installierten KI-Modelle. Klickt auf die drei Punkte (…) neben dem entsprechenden Modell und wählt „Delete“ aus, um es wieder zu entfernen.

DeepSeek oder ChatGPT? Was ist besser? Hier gehen wir auf die Unterschiede ein:Link

KI mit Ollama speichern und starten (Terminal)

Dies Variante ist vermutlich eher etwas für Power-User, weil man die KI-Modelle einfach per Terminal-Fenster verwalten und starten kann.Ollama installieren

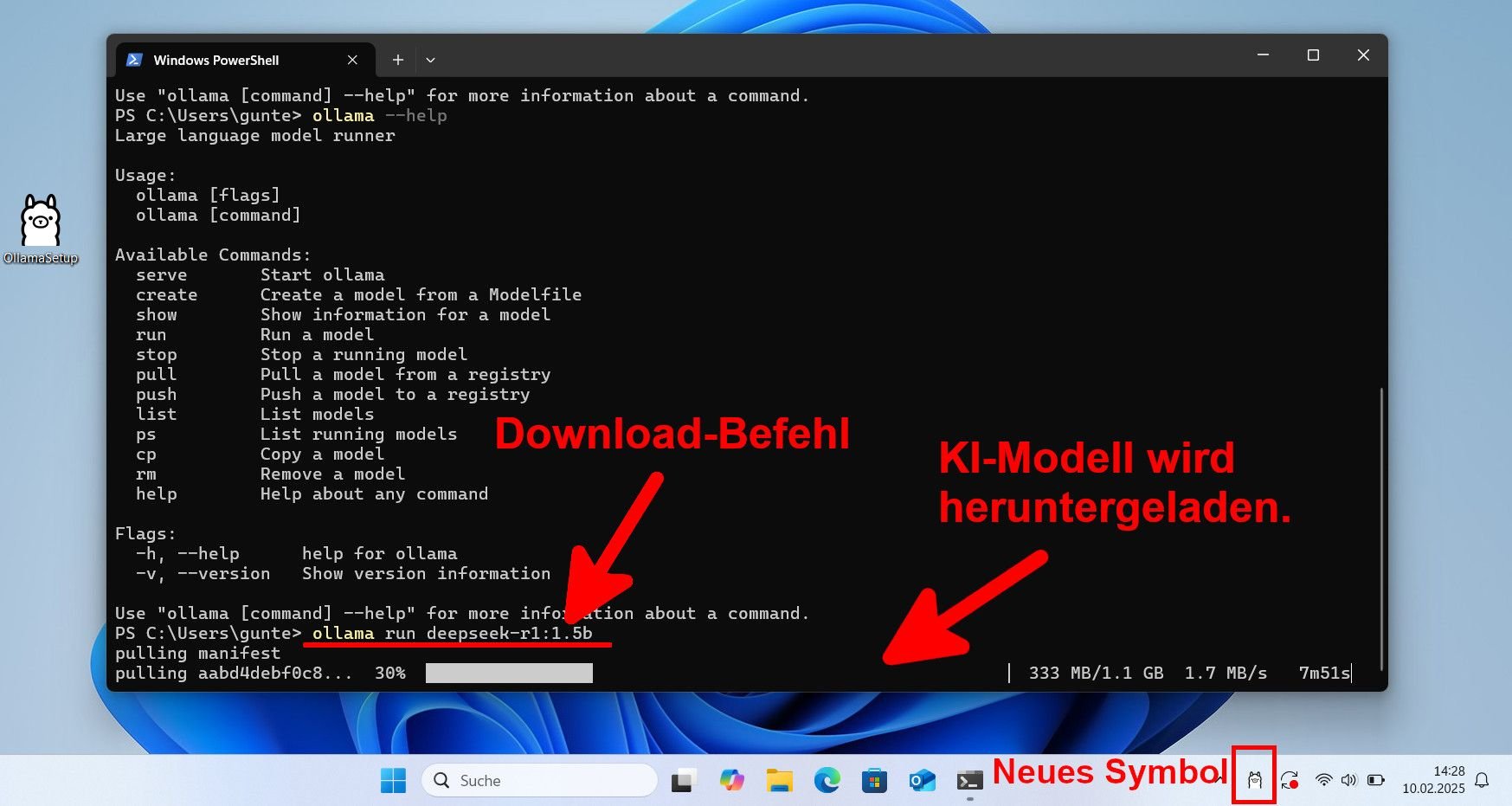

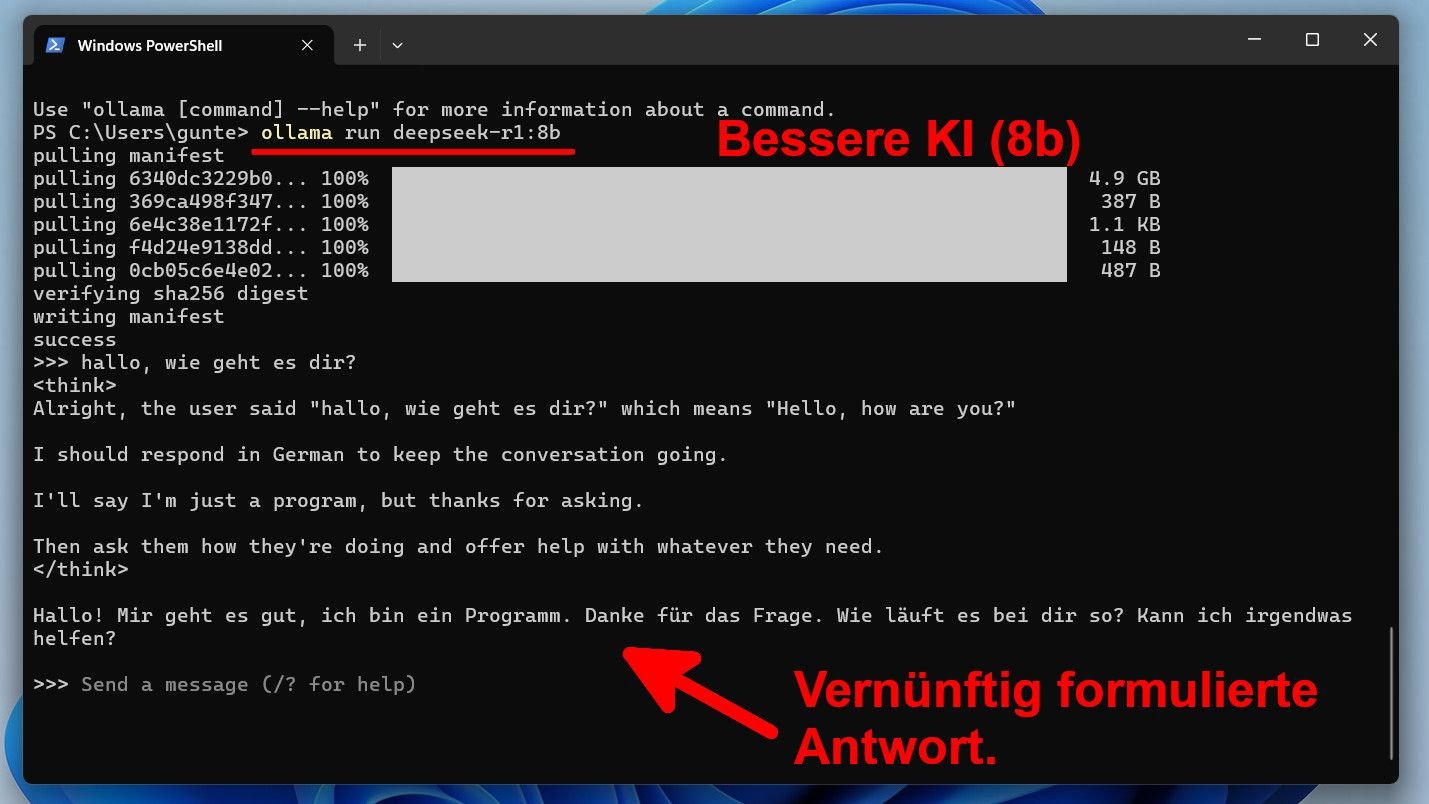

Zunächst müsst ihr das Programm Ollama auf eurem Betriebssystem installieren:Für Windows 10/11 ladet ihr euch die Datei „OllamaSetup.exe“ von der Ollama-Webseite herunter und installiert sie per Doppelklick. In Linux führt ihr dazu im Terminal laut Ollama-Webseite den folgenden Befehl aus: curl -fsSL https://ollama.com/install.sh | sh Für macOS 11 oder später ladet ihr euch die Datei „Ollama-darwin.zip“ von der Ollama-Webseite herunter.Ollama starten und KI-Modelle herunterladenNach der Installation von Ollama seht ihr in Windows unten rechts in der Taskleiste ein neues Lama-Symbol. Öffnet nun die Powershell, indem ihr mit der rechten Maustaste auf den Startbutton klickt und in Windows 11 „Terminal“ auswählt beziehungsweise „Windows PowerShell“ in Windows 10. In Linux beziehungsweise macOS öffnet ihr das Terminal. Um nun beispielsweise DeepSeek in einer sehr einfachen Form herunterzuladen und zu starten, gebt ihr den Befehl ollama run deepseek-r1:1.5b ein und drückt Enter. Wartet bis die erforderlichen Dateien heruntergeladen werden und „success“ angezeigt wird. Das KI-Modell startet danach automatisch. Nun könnt ihr dem KI-Modell im Terminal eure Fragen stellen, ähnlich wie bei ChatGPT oder DeepSeek. Das gewählte Modell ist aber ziemlich klein und die Antworten sind eher rudimentär formuliert. Anhand des kleinen Modells könnt ihr aber schon mal testen, ob das Programm auf eurem PC funktioniert. Danach könnt ihr mit dem Befehl ollama run deepseek-r1:8b ein deutlich stärkeres Modell mit intelligenteren Antworten herunterladen. Achtet aber darauf, vorher aber das laufende kleine Modell mit dem Befehl /bye zu beenden. Das KI-Modell wird heruntergeladen und danach lokal gestartet.Bedienung: Hilfreiche Befehle & Tastenkombinationen

Das KI-Modell wird heruntergeladen und danach lokal gestartet.Bedienung: Hilfreiche Befehle & Tastenkombinationen

Mit diesen Befehlen könnt ihr KI-Modelle anzeigen, herunterladen, starten, beenden und löschen.

Alle installieten KI-Modelle anzeigen

Der Befehl ollama list zeigt alle derzeit heruntergeladenen lokalen KI-Modelle an.

Ein KI-Modell starten (oder herunterladen und dann starten)

Der Befehl ollama run (gefolgt von einem Namen, der bei „ollama list" ausgegeben wird) startet die jeweilige KI.Beispiel: ollama run deepseek-r1:1.5b

Das derzeitige KI-Modell beenden

Die Tastenkombination Strg + D beendet die jeweilige KI. Alternativ könnt ihr auch /bye eintippen und Enter drücken.

Alle laufenden KI-Modelle anzeigen

Der Befehl ollama ps zeigt alle derzeit laufende Ki-Modelle an (falls ihr beispielsweise ein Modell in einem anderen Terminal-Fenster laufen habt, wird das dann angezeigt).

Ein KI-Modell löschen

Der Befehl ollama rm (gefolgt von einem Namen, der bei „ollama list" ausgegeben wird) löscht die jeweilige KI. Sie muss das nächste mal also wieder aus dem Internet heruntergeladen werden mit olama run … .Wie erkenne ich gute KI-Modelle?

Dies ist eine stark vereinfachte Erklärung. Als Beispiel nehmen wir das KI-Modell „deepseek-r1:1.5b“ von oben:Die Zahl hinten (1.5b) bedeutet, dass das Modell ungefähr 1,5 Milliarden Parameter hat. Je höher dieser Wert ist, desto leistungsfähiger ist das Modell und desto besser kann es komplexe Muster in den Daten erkennen und euch antworten. Ein gutes Mittelmaß sind Modelle mit 6 bis 8 Milliarden Parametern (6B bis 8B), da sie eine starke Leistung bieten, ohne zu hohe Ressourcen zu benötigen. Allerdings ist es von eurer Hardware abhängig, ob die Modelle auch einigermaßen zügig antworten. Außerdem belegen sie mit 4 bis 9 GB mehr Speicherplatz auf eurer Festplatte. Das KI-Modell hat mehr Parameter und ist damit „klüger“.Neue KI-Modelle von Ollama herunterladen

Das KI-Modell hat mehr Parameter und ist damit „klüger“.Neue KI-Modelle von Ollama herunterladen

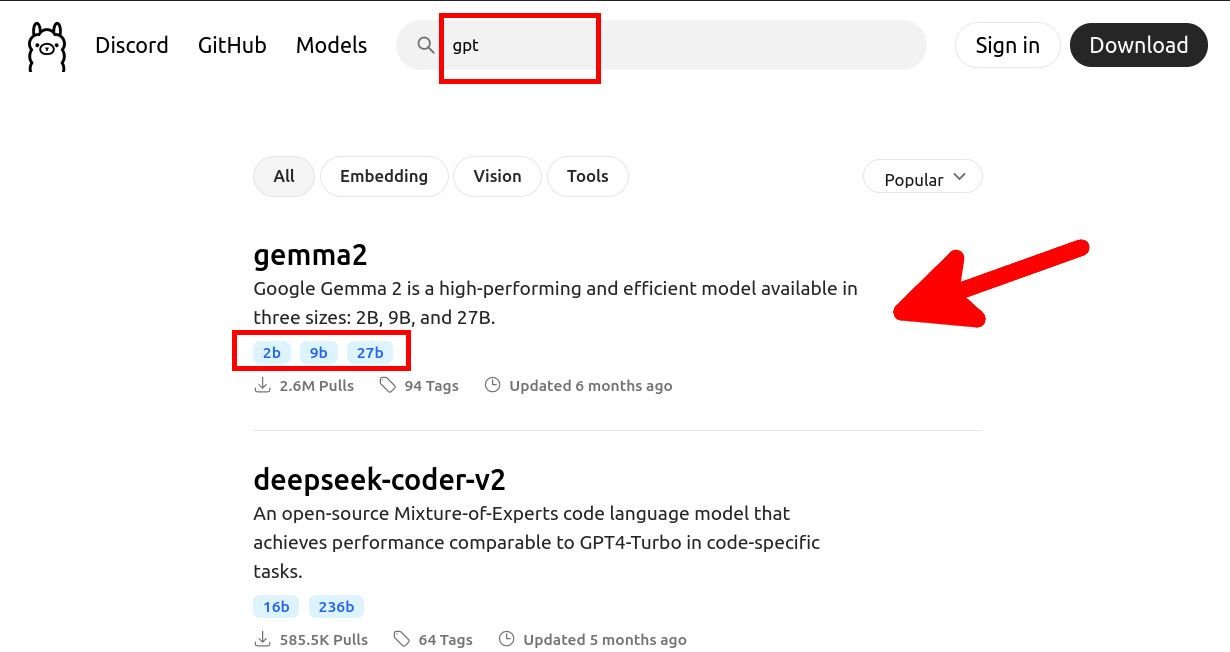

Nun könnt ihr die Webseite Ollama öffnen und oben links auf „Models“ klicken. Sucht hier nach bestimmten Modellen wie „deepseek“ oder „gpt“. Unter dem jeweiligen Sucheintrag seht ihr dann auch mit wie vielen Parametern das Modell verfügbar ist. Hier sucht ihr nach KI-Modellen.

Hier sucht ihr nach KI-Modellen.

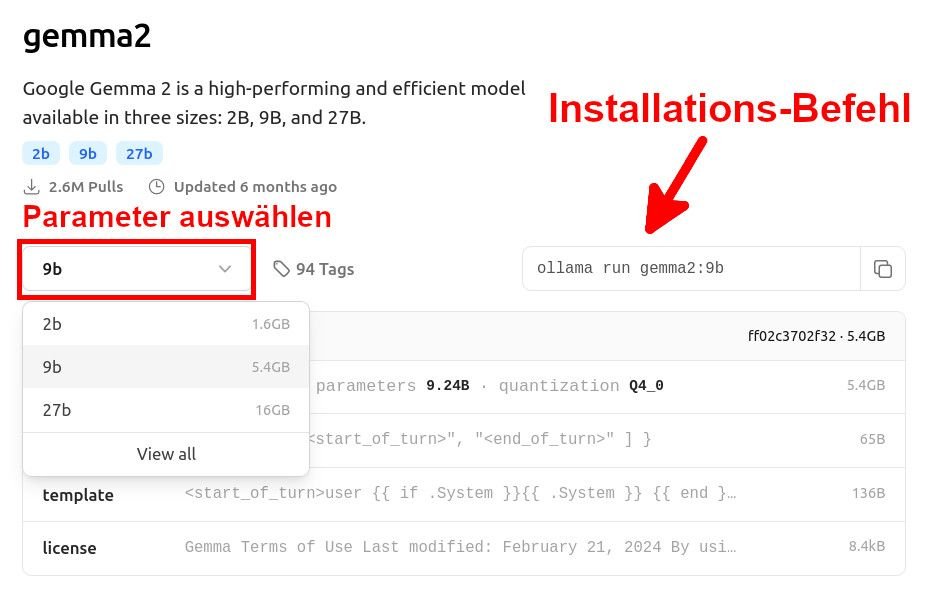

Wenn ihr ein Modell angeklickt habt, wählt ihr im Reiter links die Parameter-Anzahl aus (Beispiel: 2b, 9b oder 27b), Je größer, desto „klüger“ ist die KI. Rechts daneben seht ihr dann den nötigen Befehl, um diese KI mit den ausgewählten Parametern im Kommandozeilen-Fenster zu installieren. Außerdem seht ihr bei „Pulls“, wie oft das Modell heruntergeladen wurde, was ein Hinweis dafür sein kann, ob das Modell beliebt und/oder gut ist. Hier wählt ihr aus, wie „gut“ das Modell sein soll (Parameter). Daneben steht der Download-Befehl.

Hier wählt ihr aus, wie „gut“ das Modell sein soll (Parameter). Daneben steht der Download-Befehl.

In unserem Beispiel wäre es also der Befehl ollama run gemma2:9b, um das Modell „Google Gemma 2“ mit 9b in unserem Terminal-Fenster- beziehungsweise Powershell-Fenster herunterzuladen und zu starten.

Zusammen mit den obigen Befehlen wisst ihr nun alle Grundlagen, um KI-Modelle zu finden und ausprobieren zu können.Weitere KI-Modelle von „Hugging Face“ herunterladen

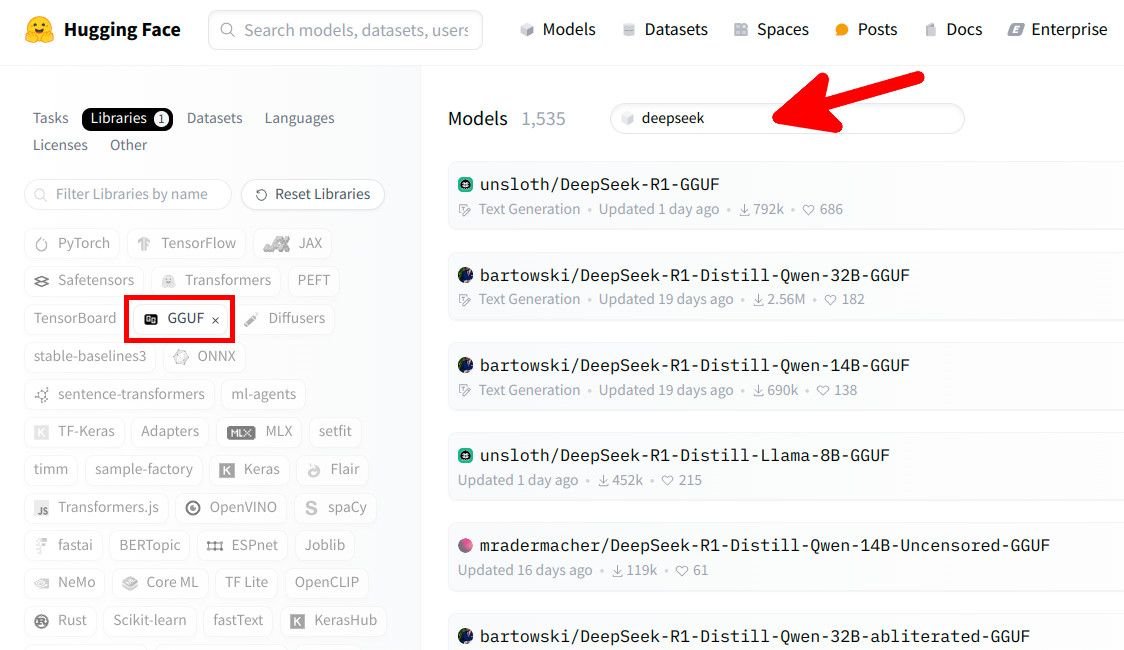

Alternativ zu Ollama findet ihr weitere KI-Modelle auf der Webseite „Hugging Face“. Allerdings müsst ihr dafür den richtigen Download-Befehl herausfinden. Das geht so:

Klickt auf der Webseite oben auf „Models“ und dann links in der Navigation auf „Libraries“. Wählt darunter das Format „GGUF“ aus.

Bei Bedarf könnt ihr unter „languages“ auch noch „German“ für die deutsche Sprache auswählen, die meisten englischsprachigen Modelle antworten euch aber auch ziemlich gut auf Deutsch, wenn ihr sie später dazu auffordert.

Nun könnt ihr im rechten Fensterbereich im Suchfeld „Models“ nach weiteren Modellen suchen. Die Parameterzahl (B) findet ihr oft bereits in der Überschrift angezeigt. So findet ihr kompatible KI-Modelle auf Hugging-Face.

So findet ihr kompatible KI-Modelle auf Hugging-Face.

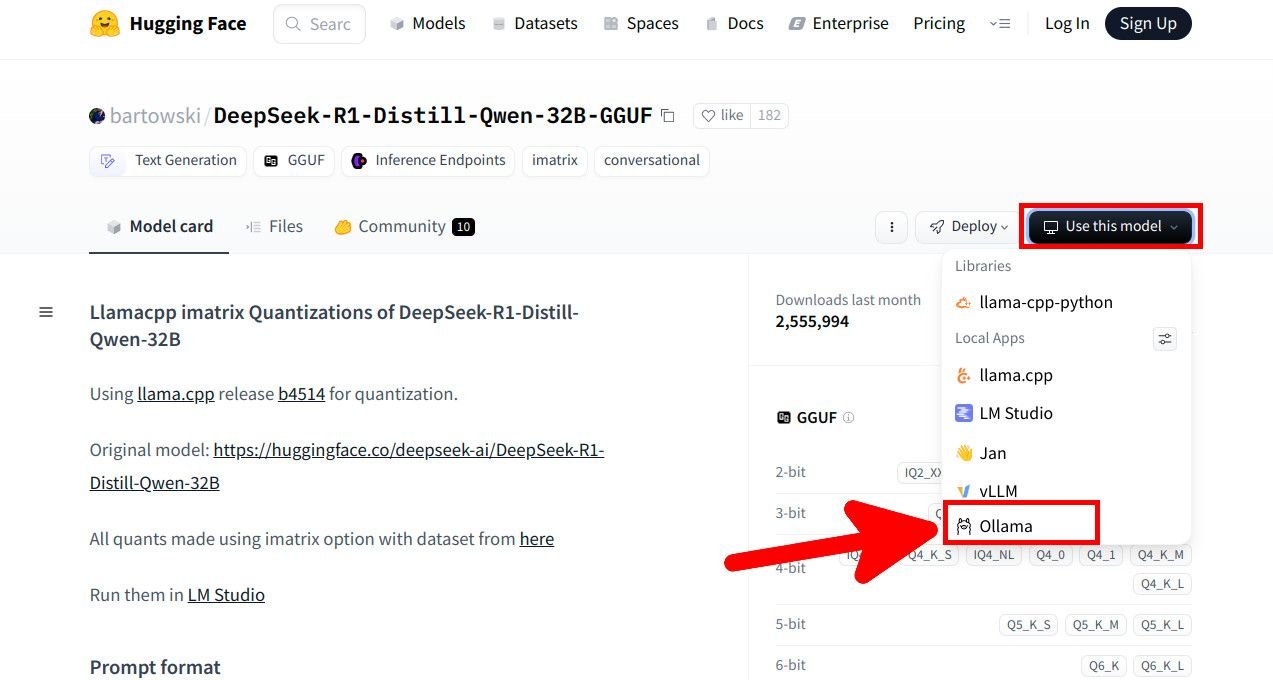

Nachdem ihr ein Modell angeklickt habt, seht ihr rechts die Download-Zahlen. Klickt auf den Button „Use this model“ > „Ollama“. Klickt hier, um das richtige Modell auszuwählen.

Klickt hier, um das richtige Modell auszuwählen.

Es öffnet sich ein kleines Fenster, indem ihr nun die sogenannte Quantisierung auswählt. Sie bestimmt, wie die Präzision der Modellparameter reduziert wird, um Speicherbedarf und Berechnungszeiten zu verringern, während die Leistung des Modells weitgehend erhalten bleibt. Ein guter Richtwert ist Q4_K_M, sofern vorhanden. Scrollt ansonsten auf der Webseite des jeweiligen KI-Modells herunter, um eine Empfehlung für eine geeignete Quantisierung zu finden. Danach klickt ihr daneben auf „Copy“, um den nötigen Terminal-Befehl in eure Zwischenablage zu kopieren. Wählt die Quantisierung aus und kopiert den Befehl per „Copy“ in die Zwischenablage.

Wählt die Quantisierung aus und kopiert den Befehl per „Copy“ in die Zwischenablage.

In unserem Beispiel lautet der kopierte Befehl also ollama run hf.co/bartowski/DeepSeek-R1-Distill-Qwen-32B-GGUF:Q4_K_M, um das KI-Modell in Ollama herunterzuladen und zu starten. Ihr entfernt sie wieder mit den obigen gezeigten Befehlen.

Vor- und Nachteile von lokalen KI-Modellen

Die folgende Auflistung zeigt die wichtigsten Vor- und Nachteile von lokalen KI-Modellen, die vor allem von Privatnutzern betrieben werden.Die Vorteile

Lokale KI-Modelle haben folgende Vorteile gegenüber den üblichen Cloud-Varianten, die man im Internet über Browser oder Smartphone-App startet.Datenschutz & Sicherheit: Eure Daten bleiben lokal, eure Eingaben werden nicht an Dritte gesendet (etwa zu KI-Trainingszwecken etc.). Ohne Internetverbindung: Ihr könnt KI-Modelle ohne ständige Internetverbindung verwenden. Kostenersparnis: Ihr vermeidet laufende Kosten für kostenpflichtige Cloud-Dienste und KI-Modelle. Anpassungsfähigkeit: Ihr habt Kontrolle über das KI-Modell, Integration und eventuelle Anpassungsmöglichkeiten.Die Nachteile

Allerdings gibt es vor allem für Privatnutzer auch folgende Nachteile.Hardware-Kosten: Hohe Investitionen in leistungsstarke Hardware wie GPUs. Erhöhter Energieverbrauch: KI-Modelle verbrauchen verhältnismäßig viel Strom. Speicherbedarf: KI-Modelle brauchen je nach Variante viel Speicherplatz (etwa zwischen 2 und 400 GB). Manuelle Wartung: Updates und Wartung müssen selbst durchgeführt werden. Skalierbarkeit: Begrenzte Skalierbarkeit im Vergleich zu Cloud-Lösungen. Komplexität: Erhöhte technische Anforderungen und mehr Fachwissen nötig.Link

![VPN für gratis Formel 1 auf Reisen [inkl. Special-Deal mit 4 Gratis-Monaten]](https://www.macerkopf.de/wp-content/uploads/2025/03/expressvpn_f1.jpg)

![Die SEO-Debatte: Kann KI-generierter Content ranken? [Search Camp 366]](https://blog.bloofusion.de/wp-content/uploads/2025/02/Search-Camp-Canva-366.png)

![SEO-Monatsrückblick Februar 2025: Google AIO in DE, AI-Studien + mehr [Search Camp 365]](https://blog.bloofusion.de/wp-content/uploads/2025/03/Search-Camp-Canva-365.png)

![SEO für unterschiedliche Branchen: Warum Branchenkenntnisse soooo wichtig sind! [Search Camp 364]](https://blog.bloofusion.de/wp-content/uploads/2025/02/Search-Camp-Canva-364.png)

![Deals: Dashcam bis zur Switch - Gerade bekommt ihr eine langlebige microSD fast zum halben Preis! [Anzeige]](https://images.cgames.de/images/gamestar/4/sandisk-high-endurance-512-gb_6342722.jpg?#)

![Deals: Gitarren-Gott - Mit diesem Gerät werdet ihr keine weiteren Amps und Pedals brauchen [Anzeige]](https://images.cgames.de/images/gamestar/4/hotone-ampero-ii-stage-teaser_6342426.jpg?#)

![Deals: Neue Budget-SSD - Diese NVMe SSD war jahrelang meine Budget-Empfehlung – bis jetzt! [Anzeige]](https://images.cgames.de/images/gamestar/4/kingston-nv3-teaserbild-2_6342609.jpg?#)

:quality(80)/p7i.vogel.de/wcms/bf/01/bf01a246097d7bfc395c18b6e2862c0b/0123574390v2.jpeg?#)

:quality(80)/p7i.vogel.de/wcms/b0/05/b005e943c3eb3e3872ffa1af74caf388/0123578819v1.jpeg?#)

:quality(80)/p7i.vogel.de/wcms/5c/f2/5cf215b88bac71bde56a9d7d776f4fb5/0121908675v1.jpeg?#)

:quality(80)/p7i.vogel.de/wcms/a0/85/a0853cfaa188082528bf368526d0a7e5/0123564156v2.jpeg?#)