Roost : OpenAI, Google et Discord unissent leurs forces pour lutter contre les contenus abusifs

Lors du Sommet mondial de l’IA à Paris, OpenAI, Google, Discord, Mozilla et Roblox ont annoncé le lancement de Roost, une suite d’outils open-source visant à améliorer la sécurité en ligne, en particulier pour les enfants et les plateformes vulnérables aux abus numériques. Cette initiative marque une réponse coordonnée des géants de la tech face...

Lors du Sommet mondial de l’IA à Paris, OpenAI, Google, Discord, Mozilla et Roblox ont annoncé le lancement de Roost, une suite d’outils open-source visant à améliorer la sécurité en ligne, en particulier pour les enfants et les plateformes vulnérables aux abus numériques. Cette initiative marque une réponse coordonnée des géants de la tech face aux menaces croissantes liées aux contenus abusifs et à l’exploitation de l’intelligence artificielle à des fins malveillantes.

Pas le temps de tout lire ? Voici l’essentiel à retenir :

Roost pourrait révolutionner la modération en ligne, mais son succès dépendra de son adoption par l’ensemble des acteurs du numérique.

Roost : un projet collaboratif pour sécuriser le web

Développé en collaboration avec l’Université Columbia, Roost (Robust Open Online Safety Tools) met à disposition des outils interopérables et gratuits pour aider les entreprises à détecter et signaler les contenus dangereux.

Une réponse face à la montée des contenus abusifs

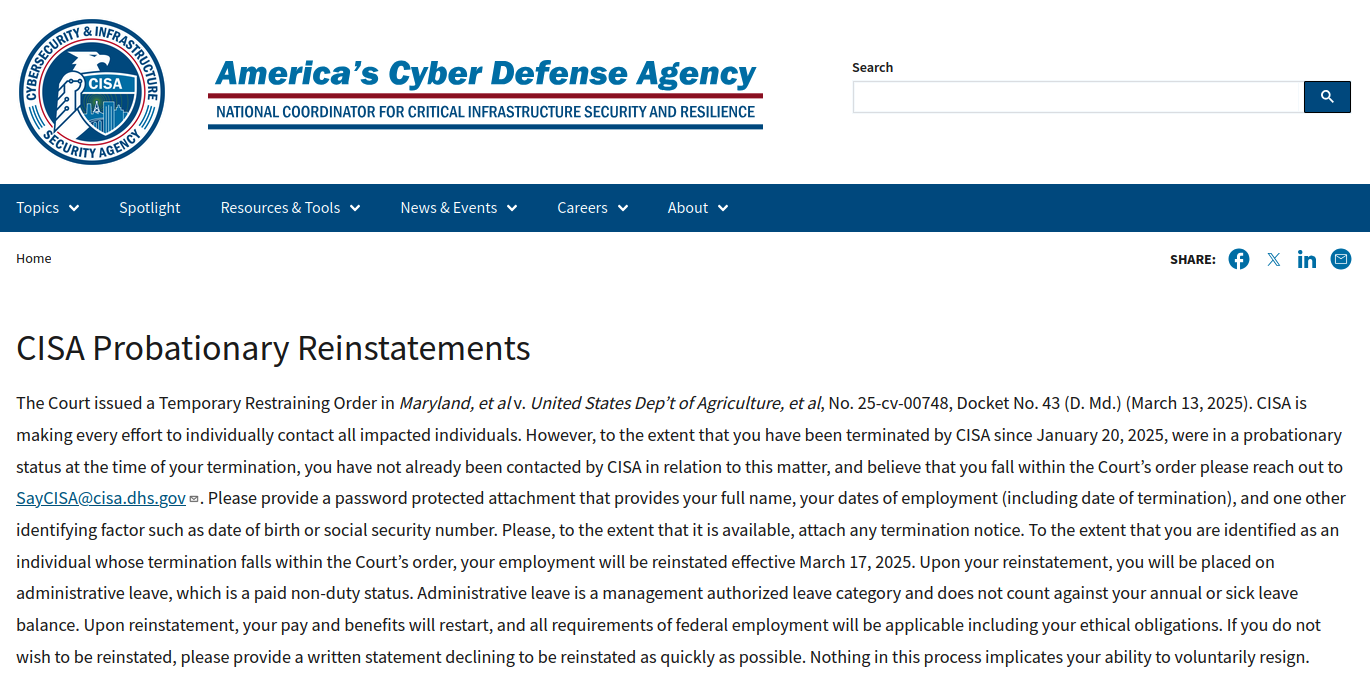

L’explosion des plateformes sociales et des outils d’intelligence artificielle a entraîné une hausse inquiétante des abus numériques. Selon le National Center for Missing and Exploited Children, plus de 36,2 millions de signalements d’abus en ligne ont été enregistrés en 2023, une augmentation de 12 % par rapport à l’année précédente. Face à cette menace croissante, les petites entreprises et les organisations publiques peinent à mettre en place des solutions efficaces, souvent par manque de ressources techniques et financières.

Roost, qui bénéficie du soutien de l’université Columbia, propose une approche open-source pour pallier ce manque. En combinant intelligence artificielle et infrastructures de cybersécurité, cette initiative veut offrir aux entreprises des outils prêts à l’emploi pour sécuriser leurs espaces numériques.

Des outils concrets pour renforcer la modération en ligne

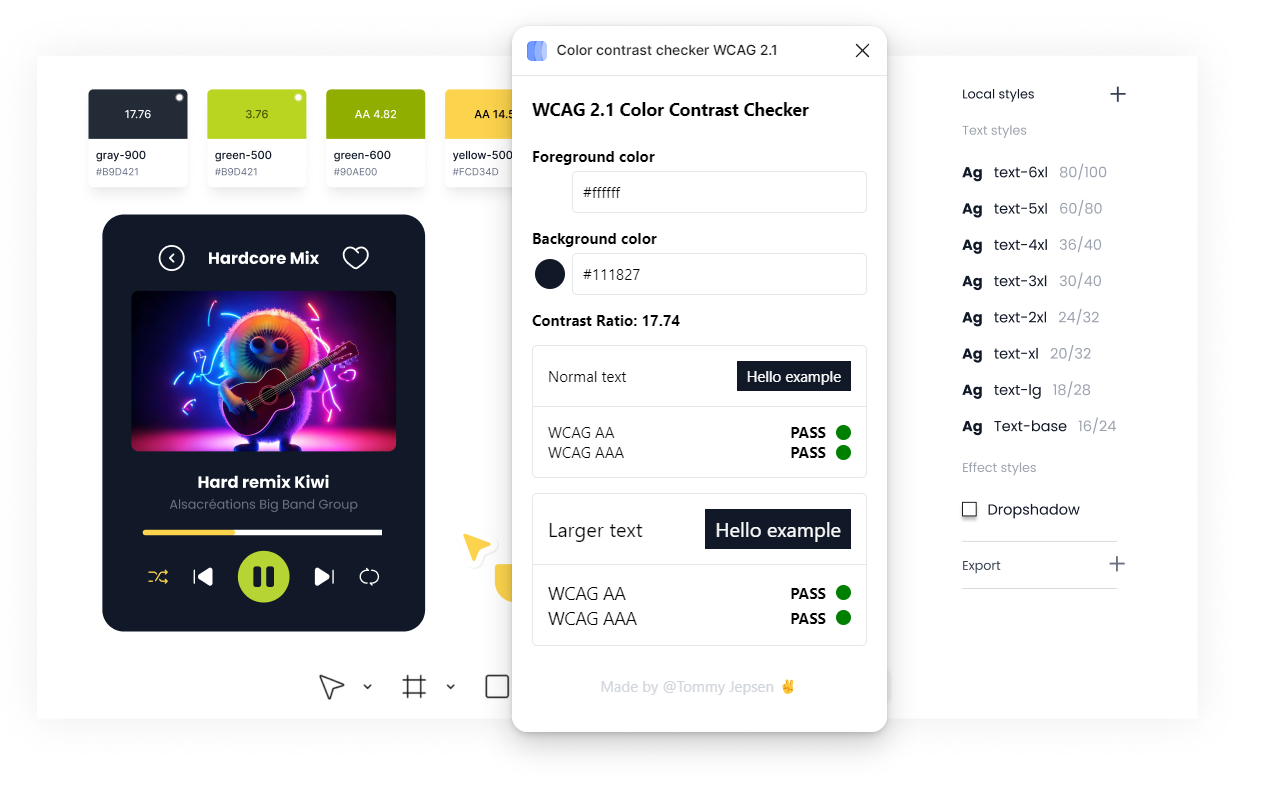

Roost repose sur une série de technologies de détection et de signalement des contenus abusifs. L’objectif est de faciliter l’intégration de ces solutions dans les infrastructures existantes afin d’améliorer la modération des plateformes numériques.

Le projet met l’accent sur la protection des mineurs, un enjeu particulièrement sensible pour des plateformes comme Roblox, qui a été critiquée pour des failles en matière de sécurité infantile. Discord, Google et OpenAI apportent également leur expertise et leur savoir-faire pour garantir une détection plus efficace des menaces en ligne, en particulier via l’intelligence artificielle et l’analyse des comportements suspects.

Roost prévoit d’utiliser des modèles de langage avancés (LLM) pour détecter les contenus problématiques et faciliter leur modération. Ces technologies permettront de repérer des images, vidéos et conversations à caractère illicite avant qu’elles ne se propagent.

Un projet ambitieux mais confronté à des défis majeurs

Si Roost représente une avancée significative dans la lutte contre les abus numériques, son adoption massive reste un défi. L’intégration avec des outils de modération existants, comme PhotoDNA de Microsoft, doit être assurée pour éviter la dispersion des efforts. Par ailleurs, la question de la protection des données et des régulations sur l’IA pourrait ralentir son développement à grande échelle.

Les fondateurs de Roost ont déjà réuni 27 millions de dollars pour financer le projet pendant ses quatre premières années. L’ambition est d’élargir rapidement l’accès à ces outils afin d’en faire une référence mondiale en matière de cybersécurité.

Avec une adoption large et une coopération entre les différents acteurs du numérique, Roost pourrait transformer la manière dont la modération des contenus est gérée sur internet. Reste à savoir si cet effort open-source trouvera suffisamment de partenaires pour imposer un standard de sécurité réellement efficace face aux menaces croissantes du numérique.

Pas le temps de tout lire ? Voici l’essentiel à retenir :

Roost pourrait révolutionner la modération en ligne, mais son succès dépendra de son adoption par l’ensemble des acteurs du numérique.

.webp)