I chatbot mentono: nuovo studio rivela inaccuratezza delle risposte AI

Mostrano un preoccupante tasso di errore nelle informazioni fornite agli utenti

Secondo un nuovo studio condotto dal Tow Center for Digital Journalism, i chatbot basati sull'intelligenza artificiale generativa dimostrano un'allarmante tendenza a fornire informazioni errate con estrema sicurezza. Non è la prima volta che emerge un dato simile ma è interessante constatare che, nonostante i miglioramenti introdotti con i nuovi modelli, il problema persiste. La ricerca, pubblicata sulla Columbia Journalism Review, ha analizzato le risposte di diversi motori di ricerca AI a 200 query basate su articoli giornalistici, rivelando risultati preoccupanti.

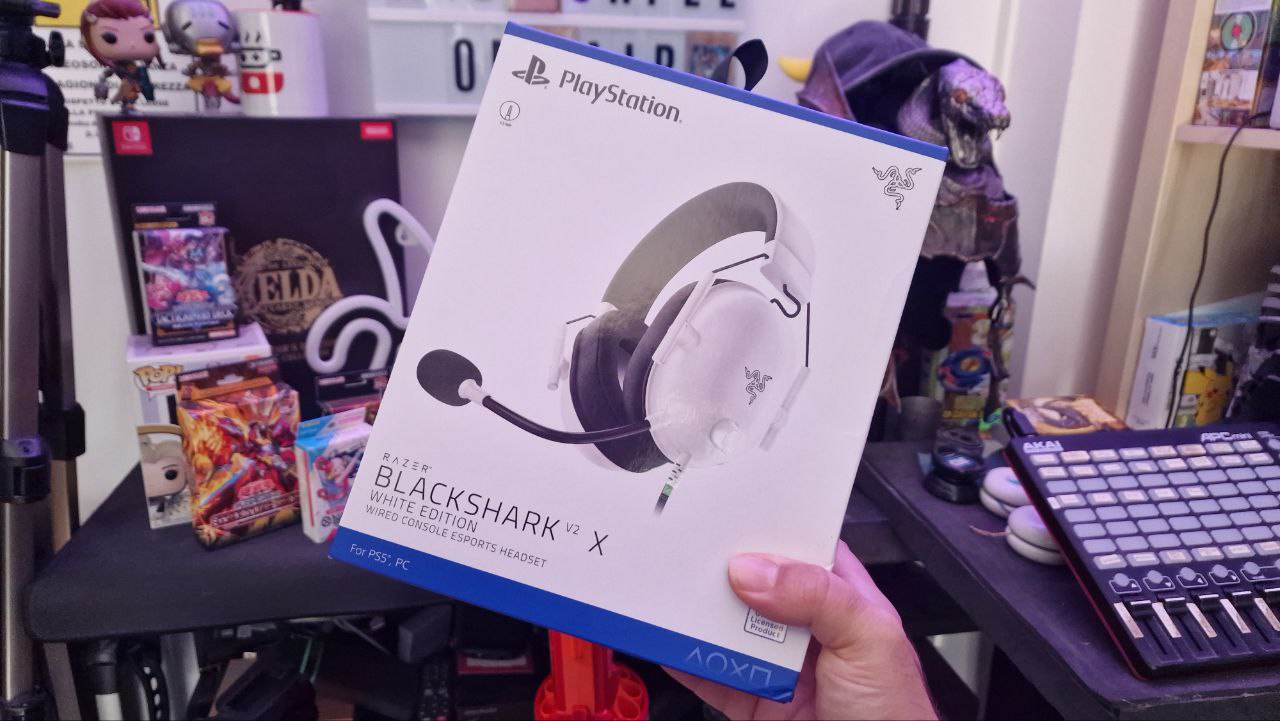

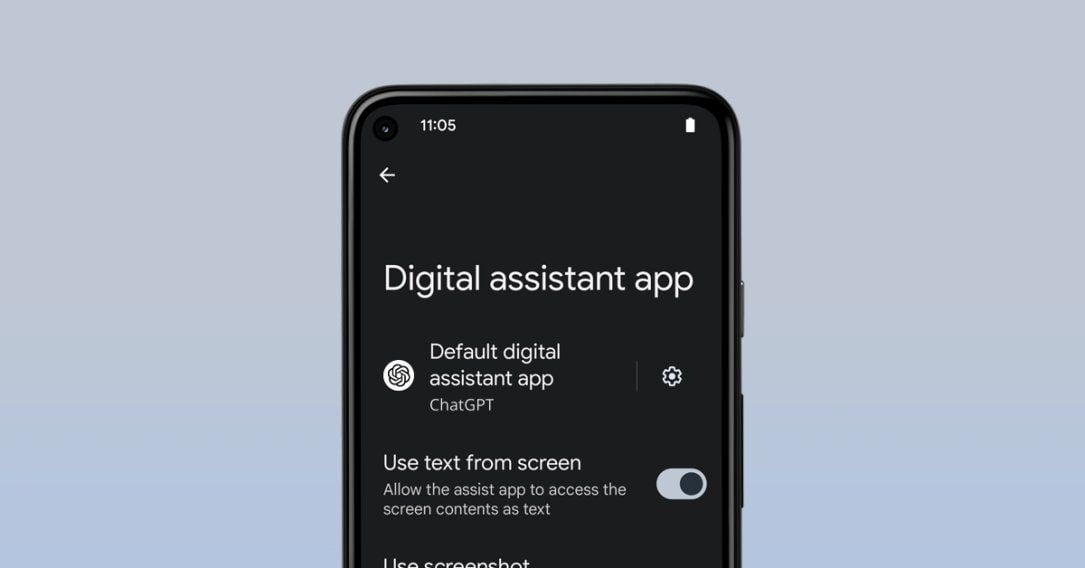

ChatGPT Search è risultato l'unico strumento AI a rispondere a tutte le 200 domande, ma solo il 28% delle risposte era completamente accurato, mentre ben il 57% conteneva informazioni totalmente errate. Questa tendenza conferma quanto già osservato nel 2023 da Ted Gioia in un articolo aneddotico per "The Honest Broker", dove dimostrava come ChatGPT rispondesse con sicurezza a numerose domande generali fornendo informazioni false.

Lo studio ha rilevato che anche quando il sistema ammette un errore, spesso prosegue con altre informazioni inventate, evidenziando come questi modelli linguistici siano programmati per rispondere a qualsiasi costo alle richieste degli utenti.

/https://www.ilsoftware.it/app/uploads/2023/12/tribunale-giudice-generico.jpg)

/https://www.ilsoftware.it/app/uploads/2024/08/2-6.jpg)

/https://www.html.it/app/uploads/2025/03/ragazza-con-scritta-yes.jpg)