Las Big Tech tienen una buena razón para quemar cantidades ingentes de dinero en la IA ahora: no poder hacerlo después

El analista Ethan Mollick reflexionaba recientemente sobre "las dos leyes del escalado" a las que hace años ya se refería OpenAI en un estudio. Cuanto más grandes, mejor. La primera de ellas es la del entrenamiento: cuanto más grande es el modelo, más prestaciones ofrece, pero entrenar estos modelos requiere cada vez más computación, datos y energía. Por eso las empresas están gastando cantidades ingentes de dinero para "escalar" los modelos de IA, invirtiendo más recursos aunque últimamente el salto en capacidad no es tan destacable. En Xataka La opinión del director general de Microsoft acerca de la IA es inusual. Y sospecha cuánto crecerá la economía global gracias a ella Pero si piensan más, también son mejores. La segunda es sorprendente, porque deja claro que puedes lograr que la IA se comporte mejor si simplemente le das más tiempo para pensar. Como señala Mollick, OpenAI descubrió con o1 que si le dejas a un modelo invertir más tiempo y más recursos para la inferencia, es capaz de ofrecer mejores resultados al resolver problemas y contestar a preguntas. Esta segunda ley es la que ha dado lugar a la tendencia por crear modelos de razonamiento. IA supervitaminada. Lo que están haciendo las empresas de IA es combinar ambas tendencias. Sus modelos son más grandes y capaces que nunca, pero el salto respecto a los anteriores no era tan notable como el de generaciones previas. Para compensarlo (de sobra quizás) ahora ofrecen capacidades de razonamiento que hacen que los modelos de IA sean capaces ahora de ofrecer respuestas mucho más precisas. No son perfectos, ni mucho menos, pero la combinación de ambas leyes funciona. Los modelos grandes dan lugar a fantásticos modelos pequeños. Más importante aún es lo que demostró DeepSeek R1: los modelos grandes pueden dar lugar a modelos pequeños y muy baratos que se comportan excepcionalmente bien. Y si encima pueden razonar, tenemos una combinación aún más prometedora. O lo que es lo mismo... El test CPQA pone a prueba a los modelos de IA. Aquí se puede ver cómo la puntuación de Gemini 1.5 Flash es mejor que la de GPT-4, que apareció un año antes, y que durante ese tiempo el coste po rmillón de tokens se ha reducido en un 99,7%. Fuente: One Useful Thing La IA cada vez es mejor, pero también más barata. Los expertos llevan tiempo señalando que el coste de usar estos modelos no para de bajar, como así está sucediendo. Cuando GPT-4 llegó al mercado, un millón de tokens costaban 50 dólares, pero con Gemini 1.5 Flash, que apareció después y que es incluso mejor a GPT-4, ese coste se ha reducido ahora a 12 centavos de dólar. Es una reducción del 99,7% del coste por millón de tokens. Todo ese dispendio merece la pena. Todas las empresas de IA están quemando el dinero como si no hubiera mañana, pero lo hacen porque saben que este no es el momento de ser rentables. También saben que el retorno a futuro será el de modelos mucho mejores a menor precio. Estamos no en el momento de la rentabilidad, sino en el de quemar dinero para no hacerlo en el futuro. La IA ya no solo aumentará la productividad. Mollick argumenta que quizás deberíamos dejar de pensar en la IA como una forma de automatizar trabajos rutinarios y de bajo nivel. "Necesitamos considerar las formas en las que la IA puede servir como un compañero intelectual de verdad", explica. Así, estos modelos pueden crear conocimiento y descubrirnos cosas que no se nos habían ocurrido o que hubiéramos tardado mucho más en descubrir. Imagen | Solen Feyissa En Xataka | La gente está utilizando la IA en TikTok para "viajar en el tiempo" a algunas de las mayores catástrofes de la historia - La noticia Las Big Tech tienen una buena razón para quemar cantidades ingentes de dinero en la IA ahora: no poder hacerlo después fue publicada originalmente en Xataka por Javier Pastor .

El analista Ethan Mollick reflexionaba recientemente sobre "las dos leyes del escalado" a las que hace años ya se refería OpenAI en un estudio.

Cuanto más grandes, mejor. La primera de ellas es la del entrenamiento: cuanto más grande es el modelo, más prestaciones ofrece, pero entrenar estos modelos requiere cada vez más computación, datos y energía. Por eso las empresas están gastando cantidades ingentes de dinero para "escalar" los modelos de IA, invirtiendo más recursos aunque últimamente el salto en capacidad no es tan destacable.

Pero si piensan más, también son mejores. La segunda es sorprendente, porque deja claro que puedes lograr que la IA se comporte mejor si simplemente le das más tiempo para pensar. Como señala Mollick, OpenAI descubrió con o1 que si le dejas a un modelo invertir más tiempo y más recursos para la inferencia, es capaz de ofrecer mejores resultados al resolver problemas y contestar a preguntas. Esta segunda ley es la que ha dado lugar a la tendencia por crear modelos de razonamiento.

IA supervitaminada. Lo que están haciendo las empresas de IA es combinar ambas tendencias. Sus modelos son más grandes y capaces que nunca, pero el salto respecto a los anteriores no era tan notable como el de generaciones previas. Para compensarlo (de sobra quizás) ahora ofrecen capacidades de razonamiento que hacen que los modelos de IA sean capaces ahora de ofrecer respuestas mucho más precisas. No son perfectos, ni mucho menos, pero la combinación de ambas leyes funciona.

Los modelos grandes dan lugar a fantásticos modelos pequeños. Más importante aún es lo que demostró DeepSeek R1: los modelos grandes pueden dar lugar a modelos pequeños y muy baratos que se comportan excepcionalmente bien. Y si encima pueden razonar, tenemos una combinación aún más prometedora. O lo que es lo mismo...

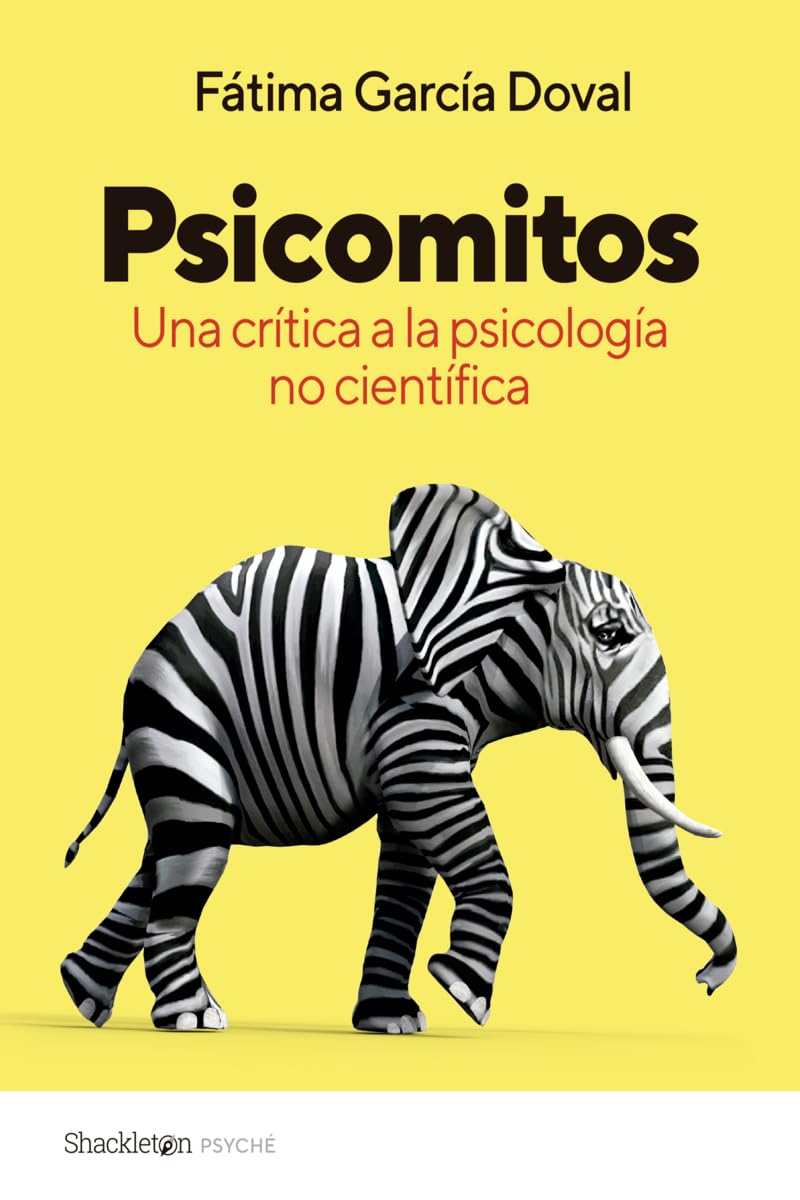

El test CPQA pone a prueba a los modelos de IA. Aquí se puede ver cómo la puntuación de Gemini 1.5 Flash es mejor que la de GPT-4, que apareció un año antes, y que durante ese tiempo el coste po rmillón de tokens se ha reducido en un 99,7%. Fuente: One Useful Thing

El test CPQA pone a prueba a los modelos de IA. Aquí se puede ver cómo la puntuación de Gemini 1.5 Flash es mejor que la de GPT-4, que apareció un año antes, y que durante ese tiempo el coste po rmillón de tokens se ha reducido en un 99,7%. Fuente: One Useful Thing

La IA cada vez es mejor, pero también más barata. Los expertos llevan tiempo señalando que el coste de usar estos modelos no para de bajar, como así está sucediendo. Cuando GPT-4 llegó al mercado, un millón de tokens costaban 50 dólares, pero con Gemini 1.5 Flash, que apareció después y que es incluso mejor a GPT-4, ese coste se ha reducido ahora a 12 centavos de dólar. Es una reducción del 99,7% del coste por millón de tokens.

Todo ese dispendio merece la pena. Todas las empresas de IA están quemando el dinero como si no hubiera mañana, pero lo hacen porque saben que este no es el momento de ser rentables. También saben que el retorno a futuro será el de modelos mucho mejores a menor precio. Estamos no en el momento de la rentabilidad, sino en el de quemar dinero para no hacerlo en el futuro.

La IA ya no solo aumentará la productividad. Mollick argumenta que quizás deberíamos dejar de pensar en la IA como una forma de automatizar trabajos rutinarios y de bajo nivel. "Necesitamos considerar las formas en las que la IA puede servir como un compañero intelectual de verdad", explica. Así, estos modelos pueden crear conocimiento y descubrirnos cosas que no se nos habían ocurrido o que hubiéramos tardado mucho más en descubrir.

Imagen | Solen Feyissa

-

La noticia

Las Big Tech tienen una buena razón para quemar cantidades ingentes de dinero en la IA ahora: no poder hacerlo después

fue publicada originalmente en

Xataka

por

Javier Pastor

.

![Los móviles con mejores cámaras [2025]](https://www.trecebits.com/wp-content/uploads/2024/03/moviles-con-mejores-camaras-150x150.jpg?#)