Les attaques sur les LLM et l'IA en forte progression selon JFrog

JFrog a publié rson rapport Software Supply Chain State of the Union 2025. Il dresse un panorama de la sécurité sur les plateformes de supply chain logiciels. Cette dernière étude confirme les problèmes de sécurité autour de l'IA et des modèles LLM qui ne cessent de progresser. "De nombreuses organisations adoptent avec enthousiasme les modèles ML publics pour stimuler l'innovation rapide, démontrant un engagement fort à exploiter l'IA pour la croissance. Cependant, plus d'un tiers d'entre elles comptent encore sur des efforts manuels pour gérer l'accès aux modèles sécurisés et approuvés, ce qui peut conduire à des négligences potentielles," a déclaré Yoav Landman, CTO et co-fondateur de JFrog. "L'adoption de l'IA va croître encore plus rapidement. Par conséquent, pour que les organisations prospèrent à l'ère de l'IA, elles doivent automatiser leurs chaînes d'outils et leurs processus de gouvernance avec des solutions prêtes pour l'IA, garantissant qu'elles restent à la fois sécurisées et agiles tout en maximisant leur potentiel d'innovation."Principaux éléments du rapport :une combinaison de vulnérabilités de sécurité menace la chaîne d'approvisionnement logicielle : on peut citer les multiples CVE, les packages malveillants (qui se multiplient partout), les expositions de secrets, et les mauvaises configurations/erreurs humaines. Par exemple, l’équipe de recherche en sécurité de JFrog a détecté 25 229 secrets/tokens exposés dans des registres publics (augmentation de 64 % par rapport à l'année précédente). La complexité croissante des menaces de sécurité logicielle rend plus difficile le maintien d’une sécurité cohérente dans la chaîne d'approvisionnement logicielle.La prolifération et les attaques des modèles AI/ML augmentent : En 2024, plus de 1 million de nouveaux modèles ML ont été ajoutés sur Hugging Face, accompagnés d'une augmentation de 6,5x des modèles malveillants, ce qui indique que les modèles AI et ML deviennent de plus en plus une cible privilégiée pour les acteurs malveillants.La gouvernance manuelle des modèles ML augmente les risques : la majorité des entreprises (94 %) utilisent des listes certifiées pour gouverner l'utilisation des artefacts ML, mais plus d'un tiers (37 %) de ces entreprises s'appuient sur des efforts manuels pour créer et maintenir leurs listes de modèles ML approuvés. Cette dépendance excessive à la validation manuelle crée de l'incertitude sur l'exactitude et la cohérence de la sécurité des modèles ML.Le manque de scans de sécurité est un véritable angle mort : la situation est à la fois alarmante et incomphérensible ! Seulement 43 % des professions de l'IT disent que leur entreprises réalisent des scans de sécurité à la fois sur le code et les binaires. Il y a un mieux par rapport à 2024 mais ce n'est pas glorieux pour les entreprisesLes vulnérabilités critiques continuent d'augmenter : En 2024, les chercheurs en sécurité ont divulgué plus de 33 000 nouveaux CVE, soit une augmentation de 27 % par rapport à 2023, dépassant le taux de croissance de 24,5 % des nouveaux packages logiciels. Cette tendance soulève des inquiétudes car le nombre croissant de CVE augmente la complexité et la pression sur les développeurs et les équipes de sécurité, pouvant freiner l'innovation. Par ailleurs, l’équipe de sécurité de JFrog a constaté que seulement 12 % des CVE de haut niveau notées "critiques" (CVSS 9.0-10.0) par les organisations gouvernementales justifient le niveau de sévérité critique qui leur a été attribué, car elles sont susceptibles d'être exploitées par des attaquants₁. Ce modèle est préoccupant en raison d'une méthodologie de notation centralisée et inchangée au fil du temps, ce qui augmente le risque de faux positifs dans les évaluations et contribue à la "fatigue de vulnérabilité" chez les développeurs.Le manque de visibilité sur l'origine des codes utilisés est toujours d'actualité (le vibe coding va contribuer à faire exploser ce problème) et constitue une réelle menace pour l'intégrité des apps. Tout comme, il est totalement anormal de télécharger des extensions et des templates pour son IDE sans un minimum de vérification. Les hacks et vulnérabilités concernent les OS, les langages, les frameworks, les codes ! Catégorie actualité: SécuritéJFrog, CVE, hackingImage actualité AMP:

JFrog a publié rson rapport Software Supply Chain State of the Union 2025. Il dresse un panorama de la sécurité sur les plateformes de supply chain logiciels. Cette dernière étude confirme les problèmes de sécurité autour de l'IA et des modèles LLM qui ne cessent de progresser.

"De nombreuses organisations adoptent avec enthousiasme les modèles ML publics pour stimuler l'innovation rapide, démontrant un engagement fort à exploiter l'IA pour la croissance. Cependant, plus d'un tiers d'entre elles comptent encore sur des efforts manuels pour gérer l'accès aux modèles sécurisés et approuvés, ce qui peut conduire à des négligences potentielles," a déclaré Yoav Landman, CTO et co-fondateur de JFrog. "L'adoption de l'IA va croître encore plus rapidement. Par conséquent, pour que les organisations prospèrent à l'ère de l'IA, elles doivent automatiser leurs chaînes d'outils et leurs processus de gouvernance avec des solutions prêtes pour l'IA, garantissant qu'elles restent à la fois sécurisées et agiles tout en maximisant leur potentiel d'innovation."

Principaux éléments du rapport :

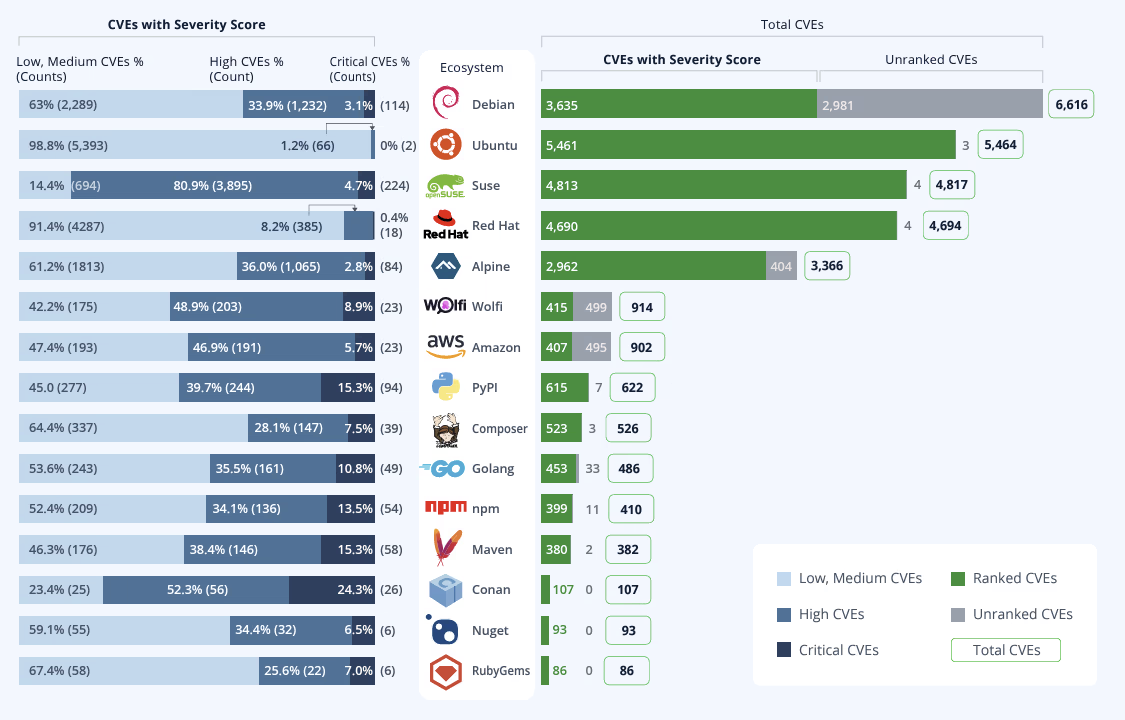

- une combinaison de vulnérabilités de sécurité menace la chaîne d'approvisionnement logicielle : on peut citer les multiples CVE, les packages malveillants (qui se multiplient partout), les expositions de secrets, et les mauvaises configurations/erreurs humaines. Par exemple, l’équipe de recherche en sécurité de JFrog a détecté 25 229 secrets/tokens exposés dans des registres publics (augmentation de 64 % par rapport à l'année précédente). La complexité croissante des menaces de sécurité logicielle rend plus difficile le maintien d’une sécurité cohérente dans la chaîne d'approvisionnement logicielle.

- La prolifération et les attaques des modèles AI/ML augmentent : En 2024, plus de 1 million de nouveaux modèles ML ont été ajoutés sur Hugging Face, accompagnés d'une augmentation de 6,5x des modèles malveillants, ce qui indique que les modèles AI et ML deviennent de plus en plus une cible privilégiée pour les acteurs malveillants.

- La gouvernance manuelle des modèles ML augmente les risques : la majorité des entreprises (94 %) utilisent des listes certifiées pour gouverner l'utilisation des artefacts ML, mais plus d'un tiers (37 %) de ces entreprises s'appuient sur des efforts manuels pour créer et maintenir leurs listes de modèles ML approuvés. Cette dépendance excessive à la validation manuelle crée de l'incertitude sur l'exactitude et la cohérence de la sécurité des modèles ML.

Le manque de scans de sécurité est un véritable angle mort : la situation est à la fois alarmante et incomphérensible ! Seulement 43 % des professions de l'IT disent que leur entreprises réalisent des scans de sécurité à la fois sur le code et les binaires. Il y a un mieux par rapport à 2024 mais ce n'est pas glorieux pour les entreprises

Les vulnérabilités critiques continuent d'augmenter : En 2024, les chercheurs en sécurité ont divulgué plus de 33 000 nouveaux CVE, soit une augmentation de 27 % par rapport à 2023, dépassant le taux de croissance de 24,5 % des nouveaux packages logiciels. Cette tendance soulève des inquiétudes car le nombre croissant de CVE augmente la complexité et la pression sur les développeurs et les équipes de sécurité, pouvant freiner l'innovation. Par ailleurs, l’équipe de sécurité de JFrog a constaté que seulement 12 % des CVE de haut niveau notées "critiques" (CVSS 9.0-10.0) par les organisations gouvernementales justifient le niveau de sévérité critique qui leur a été attribué, car elles sont susceptibles d'être exploitées par des attaquants₁. Ce modèle est préoccupant en raison d'une méthodologie de notation centralisée et inchangée au fil du temps, ce qui augmente le risque de faux positifs dans les évaluations et contribue à la "fatigue de vulnérabilité" chez les développeurs.

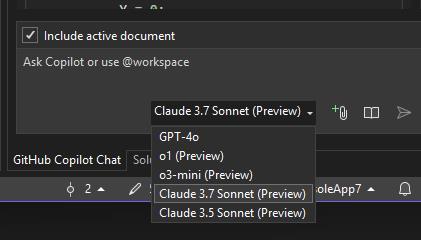

Le manque de visibilité sur l'origine des codes utilisés est toujours d'actualité (le vibe coding va contribuer à faire exploser ce problème) et constitue une réelle menace pour l'intégrité des apps. Tout comme, il est totalement anormal de télécharger des extensions et des templates pour son IDE sans un minimum de vérification.

Les hacks et vulnérabilités concernent les OS, les langages, les frameworks, les codes !