Foxconn presenta FoxBrain, LLM in cinese tradizionale con capacità di ragionamento

E' stato addestrato in solo quattro settimane

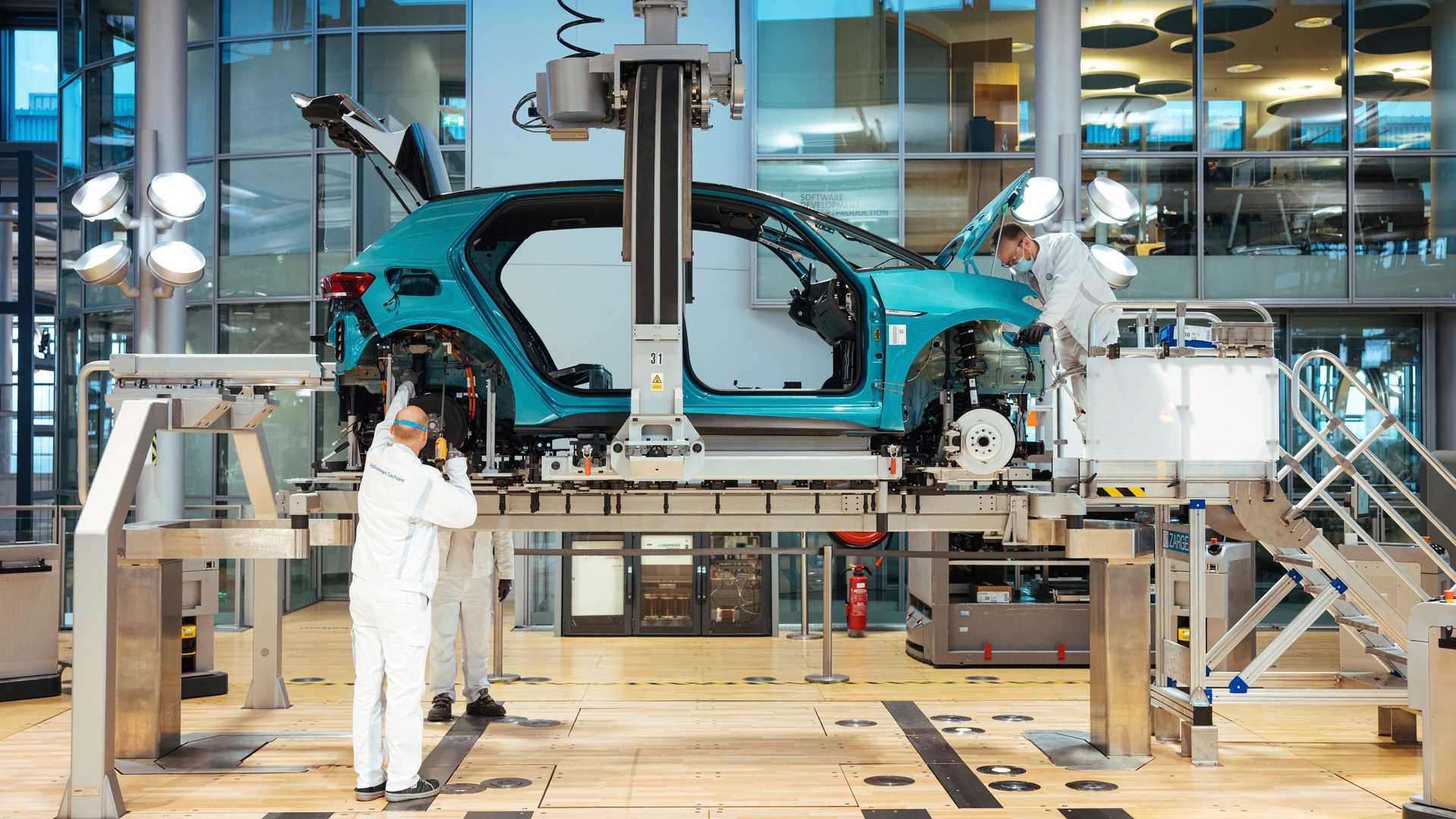

L'Hon Hai Research Institute, istituto di ricerca supportato dall'Hon Hai Technology Group, che conosciamo meglio come Foxconn, ha annunciato oggi il lancio di FoxBrain, il primo Large Language Model (LLM) in cinese tradizionale. L'istituto ha sviluppato FoxBrain inizialmente per applicazioni interne al gruppo, con funzionalità che spaziano dall'analisi dei dati al supporto decisionale, dalla collaborazione documentale alla generazione di codice. Il modello di intelligenza artificiale, addestrato in solo quattro settimane, sarà reso open source in futuro.

PRESTAZIONI EFFICIENTI E OTTIMIZZAZIONE DEL TRAINING

FoxBrain si distingue per le sue capacità di comprensione e ragionamento, con prestazioni eccellenti nei test matematici e logici. "Negli ultimi mesi, l'ottimizzazione del ragionamento e l'uso efficiente delle GPU sono diventati centrali nello sviluppo dell'IA. FoxBrain adotta una strategia di addestramento mirata a ottimizzare il processo, evitando l'accumulo indiscriminato di potenza di calcolo", ha dichiarato Dr. Yung-Hui Li, direttore dell'Artificial Intelligence Research Center di Hon Hai Research Institute.

L'addestramento di FoxBrain è stato eseguito con 120 GPU NVIDIA H100, connesse tramite NVIDIA Quantum-2 InfiniBand, e completato in circa quattro settimane. FoxBrain si basa sull'architettura Meta Llama 3.1 e conta 70 miliardi di parametri. Nei benchmark TMMLU+, supera il modello Llama-3-Taiwan-70B nella stessa categoria, con un netto vantaggio nei test di matematica e ragionamento logico.

/https://www.ilsoftware.it/app/uploads/2023/12/tribunale-giudice-generico.jpg)

/https://www.ilsoftware.it/app/uploads/2024/08/2-6.jpg)