IA de atendimento inventa política da empresa e confunde usuários

Falha no Cursor, editor de código com IA, derrubava sessões por bug, mas chatbot respondeu com base em uma política inventada. Representante da empresa pediu desculpas. IA de atendimento inventa política da empresa e confunde usuários

Resumo

- O editor de código Cursor sofreu um bug que causava desconexões, e o suporte automatizado respondeu com uma política fictícia criada por um bot de IA.

- Michael Truell, cofundador do produto, pediu desculpas e esclareceu que não há restrições para uso do Cursor em múltiplos dispositivos.

- A empresa passou a identificar mensagens geradas por IA no suporte para evitar mal-entendidos.

O cofundador do Cursor, Michael Truell, pediu desculpas publicamente nesta semana após um erro no suporte gerar confusão entre usuários. O motivo: um bug real no editor de código com inteligência artificial foi explicado por um bot de IA de suporte, que se baseou em uma política de uso totalmente invetada.

Bug real, explicação inventada

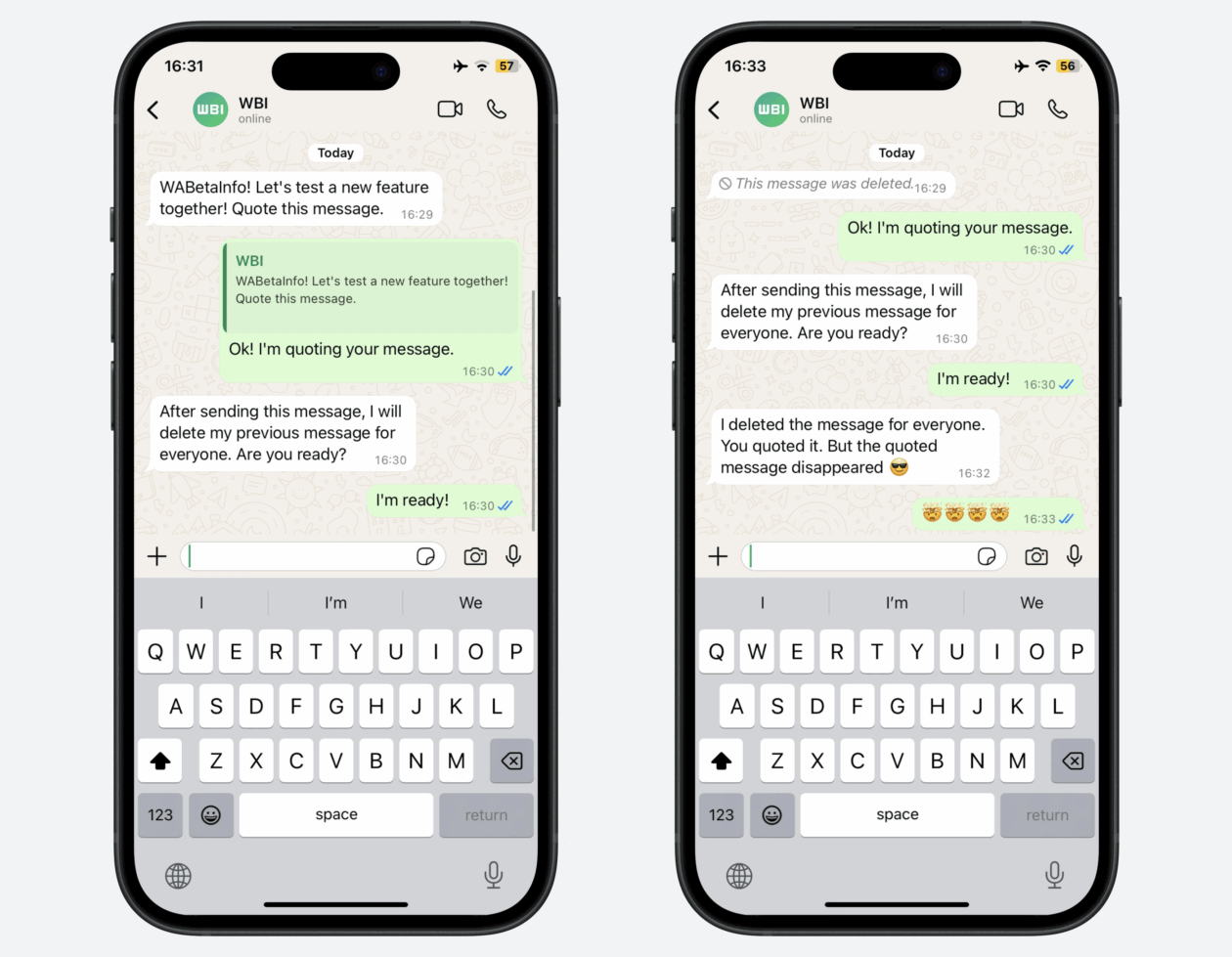

O caso começou com um relato no Reddit. Um usuário de nome BrokenToasterOven disse que estava sendo desconectado do Cursor ao alternar entre o PC, notebook e ambiente de desenvolvimento remoto — um fluxo de trabalho comum para quem programa em diferentes lugares.

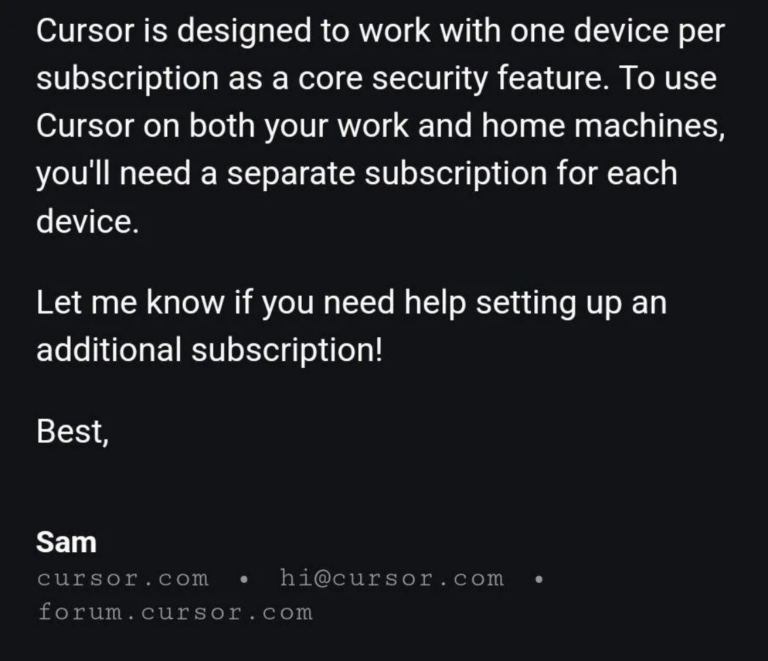

Ao entrar em contato com o suporte, o desenvolvedor recebeu uma resposta por email que parecia oficial: segundo o agente Sam, o Cursor, agora, só funcionaria em um único dispositivo por assinatura, como parte de uma nova política de segurança.

O problema é que essa política não existia — e Sam era um bot. Atualmente, o Cursor oferece o plano Pro, que custa US$ 20 por mês, e o Business, de US$ 40 mensais, além de um plano gratuito com limitações.

Ainda assim, a resposta gerou confusão: após a publicação no Reddit, outros usuários entenderam que se tratava de uma mudança oficial de política da empresa e começaram a cancelar suas contas, incluindo o próprio autor do post.

IA que alucina (e convence)

Esse tipo de falha é a clássica alucinação da IA. Acontece quando modelos de linguagem geram respostas que parecem convincentes, mas não têm relação com a realidade. Em vez de admitir que não sabem, esses sistemas preenchem a lacuna com informações falsas, porém plausíveis.

Em fevereiro de 2024, a Air Canada passou por algo semelhante: foi condenada a cumprir uma política de reembolso inventada por seu próprio chatbot, após uma decisão judicial entender que a empresa era responsável pelo erro.

No caso do Cursor, o agravante foi o uso de um nome humano (“Sam”) para assinar a mensagem, sem qualquer indicação de que se tratava de um agente automatizado. “LLMs fingindo ser pessoas têm claramente a intenção de enganar”, comentou um usuário no Hacker News.

Empresa responde (de verdade)

A confusão foi esclarecida cerca de três horas depois, no próprio Reddit. O cofundador do Cursor, Michael Truell, afirmou que não existe nenhuma limitação quanto ao uso em múltiplos dispositivos.

“Você tem liberdade para usar o Cursor em várias máquinas”, escreveu. “Infelizmente, esta é uma resposta incorreta de um bot de suporte de IA da linha de frente”.

Truell também publicou um pedido de desculpas no Hacker News. Ele explicou que o problema técnico foi causado por uma alteração no backend, implementada para melhorar a segurança das sessões, mas que acabou gerando desconexões involuntárias. O usuário afetado foi reembolsado.

Ainda de acordo com o cofundador, a empresa passou a marcar as mensagens geradas por IA no atendimento por email, para evitar novos mal-entendidos.

Com informações da Ars Technica

IA de atendimento inventa política da empresa e confunde usuários