Robôs de IA mentem para ler as páginas na web e irritam desenvolvedores

Desenvolvedores bloqueiam acessos para conter crawlers de inteligência artificial. Volume de tráfego é tão grande que derruba gits e se assemelha a ataques DDoS. Robôs de IA mentem para ler as páginas na web e irritam desenvolvedores

Resumo

- Robôs de IA sobrecarregam servidores de projetos open-source, gerando tráfego semelhante a ataques DDoS e levando a bloqueios de IPs.

- Empresas como a Amazon contornam restrições usando IPs residenciais e mudando agentes.

- Read The Docs relata que bloqueios de robôs de IA reduziram o tráfego em 75%, economizando US$ 1.500 mensais no gasto com largura de banda.

Diversos desenvolvedores estão relatando o impacto dos robôs de IA em projetos de código aberto. Esses robôs estão sobrecarregando e desestabilizando os servidores de sites gits, nos quais desenvolvedores publicam códigos open-source e contribuem para projetos. Em alguns casos, devs estão bloqueando o acesso de alguns países aos seus servidores.

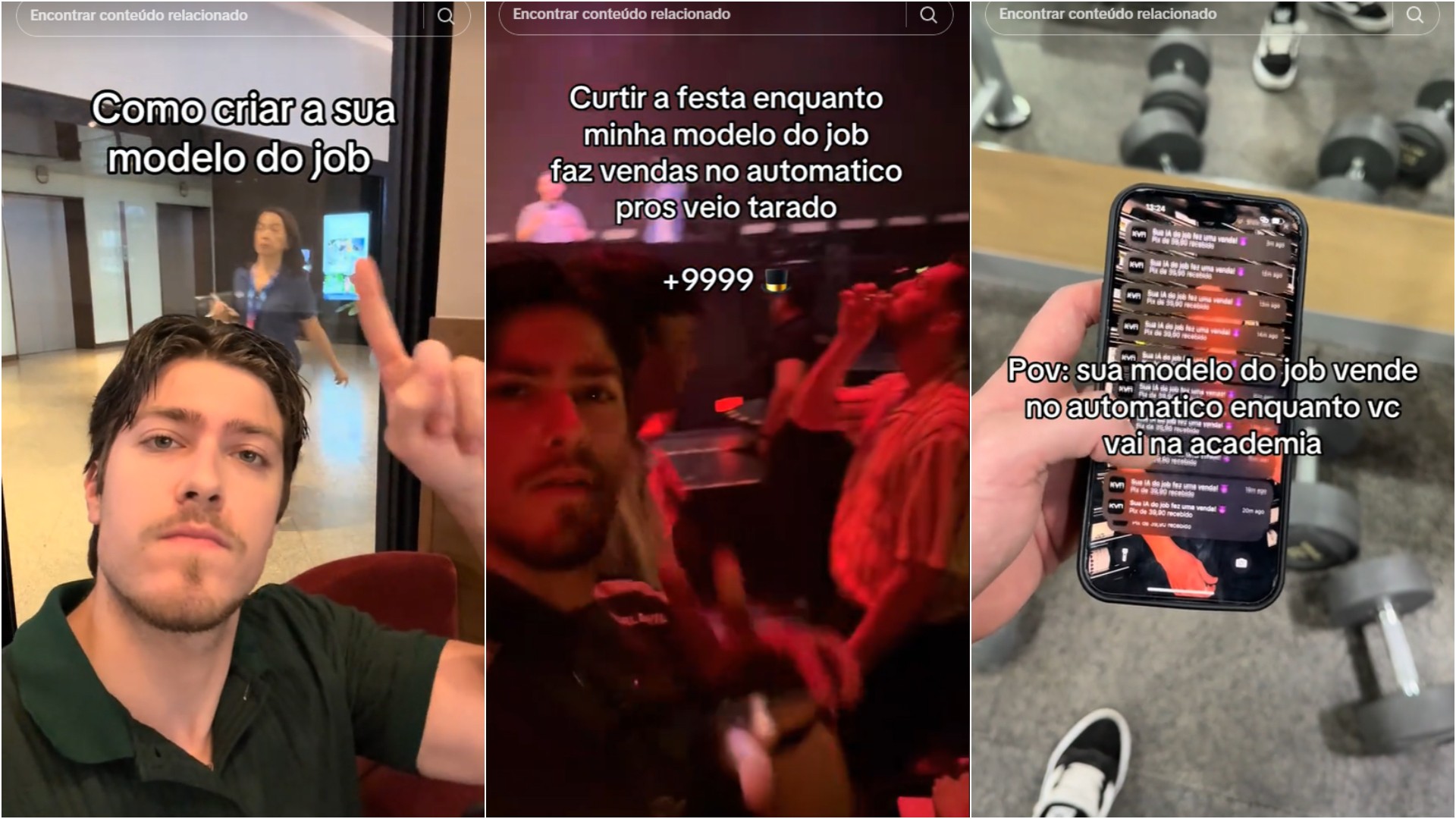

Xe Iaso, um dos desenvolvedores que publicou um relato sobre a situação, conta que os crawlers de IA (robôs que varrem a internet por dados para treinamento) da Amazon chegaram a derrubar seu servidor — praticamente como um ataque DDoS. Iaso explica ainda que a big tech desenvolve robôs mentirosos para driblar as restrições ao uso do conteúdo para treinamento de IA.

Como os robôs enganam os sites para acessar seus conteúdos?

Entre as táticas aplicadas pela Amazon para burlar os bloqueios de sites estão usar IPs residenciais como proxies e mudar o agente (escondendo que a Amazon é a autora). Em seu blog, Iaso publicou um relato frustrante sobre como a big tech é incisiva e agressiva na sua “busca por conhecimento”.

Para tentar solucionar a queda do seu servidor git, Iaso o protegeu com uma VPN e criou um sistema de verificação batizado de Anubis. O Anubis é praticamente um captcha, no qual quem deseja acessar o conteúdo da biblioteca precisa resolver um problema.

Um estudo da LibreNews mostra que em torno de 97% do tráfego de alguns projetos de código aberto vem de robôs de IA. A “sede” das empresas de IA por treinar seus LLMs vem sobrecarregando os servidores devido ao enorme aumento de tráfego. Isso também eleva os custos de largura de banda dos servidores.

Outro projeto afetado pelo alto volume de tráfego foi o Fedora Pagure. Uma das medidas tomadas pela equipe para se proteger do “DDoS” de crawlers de IA foi bloquear todo o tráfego vindo do Brasil. O GitLab de infraestrutura da KDE foi derrubado por um alto volume de tráfego de robôs com IPs da Alibaba.

Anubis é útil, mas também tem problemas

Como as empresas burlam as restrições, seja ignorando os bloqueios do robots.txt ou mudando o IP para evitar a sua detecção, o sistema Anubis criado por Iaso foi adotado por outros projetos de código-aberto. Contudo, ainda que eficiente, o sistema sofre com atrasos quando é acessado por muitos usuários — sejam eles legítimos ou não.

O alto tráfego também aumenta os custos dos projetos open-source. O Read The Docs relatou que o bloqueio de robôs de IA derrubou em 75% o tráfego nos sites, saindo de 800 GB de transferência de dados por dia para 200 GB por dia. Isso gerou uma redução de US$ 1.500 (R$ 8.601) no gasto com largura de banda.

No início do mês, uma pesquisa mostrou que as IAs, além de darem respostas erradas em 60% do tempo, também violam as restrições de sites contra crawlers.

A comunidade de projetos de código-aberto trabalha em conjunto para se proteger dos robôs. Uma das medidas colaborativas da comunidade é listar os crawlers e desenvolver códigos padrão para bloquear o acesso desses robôs.

Com informações da Ars Technica

Robôs de IA mentem para ler as páginas na web e irritam desenvolvedores

![Como mudar a sensibilidade do Siri Remote [Apple TV]](https://macmagazine.com.br/wp-content/uploads/2021/05/22-siri_remote-1260x709.jpg?#)