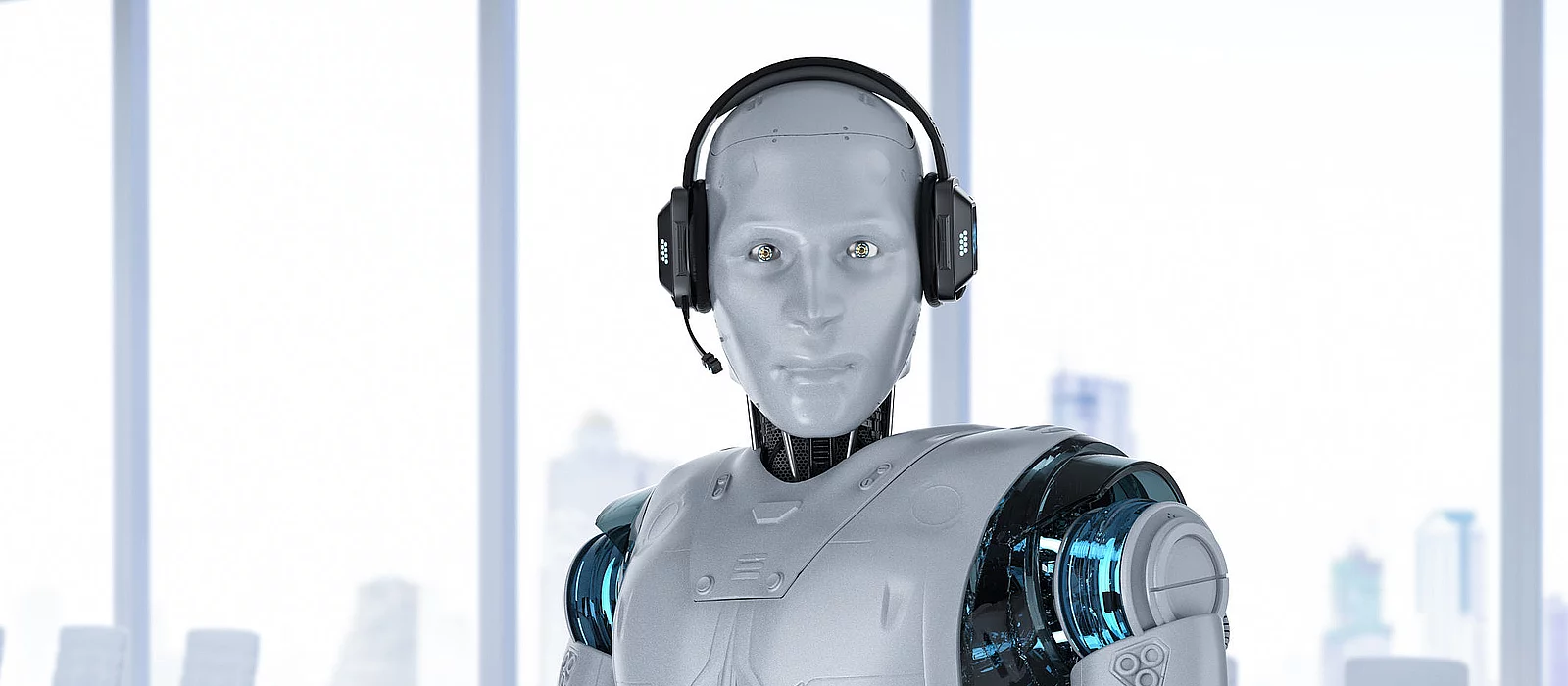

Россиян предупредили о мошеннических голосовых роботах: что известно

Аферисты используют передовые ИИ-технологии для обмана. Эксперты рассказали главное о новом методе обмана. Мошенники используют голосовые нейросети для обмана жителей России. Об этом Hi-Tech Mail рассказали в компании Neuro.net, создающей человекоподобных виртуальных операторов и голосовых помощников на основе ИИ-технологий. Эксперты отметили, что ассистенты с помощью разработок на базе RAG (Retrieval-Augmented Generation — генерация ответа с учетом найденной релевантной информации) стали прорывом в обработке естественного языка. Они анализируют многослойные запросы и дают точные ответы в режиме реального времени. Однако этим пользуются не только компании, работающие с клиентами, но и злоумышленники. Аферисты могут применять аналогичные инструменты, имитируя звонки от сотрудников банков или государственных учреждений. Так называемые ИИ-мошенники в реальном времени структурируют ответы жертвы, чтобы подстраиваться под конкретные ситуации. Технологии позволяют имитировать эмоциональную окраску голоса, чтобы сделать атаки максимально убедительными. В Neuro.net подчеркнули, что особую опасность представляет возможность массового обзвона, в котором каждый звонок персонализировать с учетом утечек личных данных. При этом для работы с такими инструментами мошенникам не нужно обладать профессиональными навыками. Специалисты обращают внимание, что скамеры используют урезанные и небезопасные версии ИИ-технологий. Добросовестные разработчики применяют методы многоуровневой защиты, которые в том числе помогают обнаружить подозрительную активность.

Аферисты используют передовые ИИ-технологии для обмана. Эксперты рассказали главное о новом методе обмана.

Мошенники используют голосовые нейросети для обмана жителей России. Об этом Hi-Tech Mail рассказали в компании Neuro.net, создающей человекоподобных виртуальных операторов и голосовых помощников на основе ИИ-технологий.

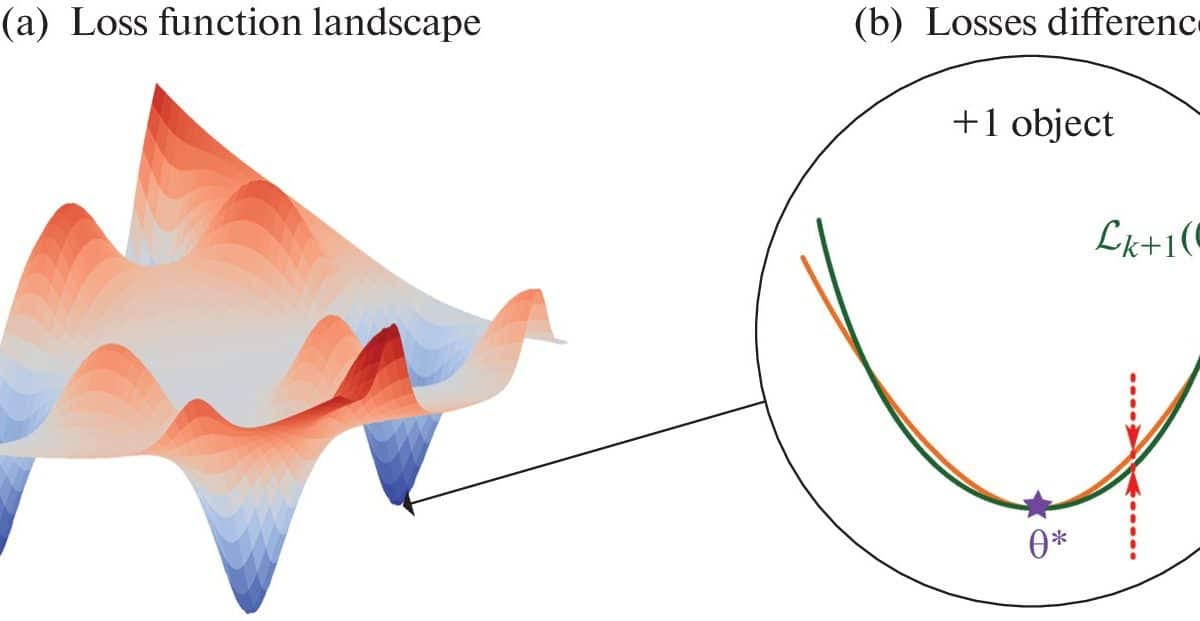

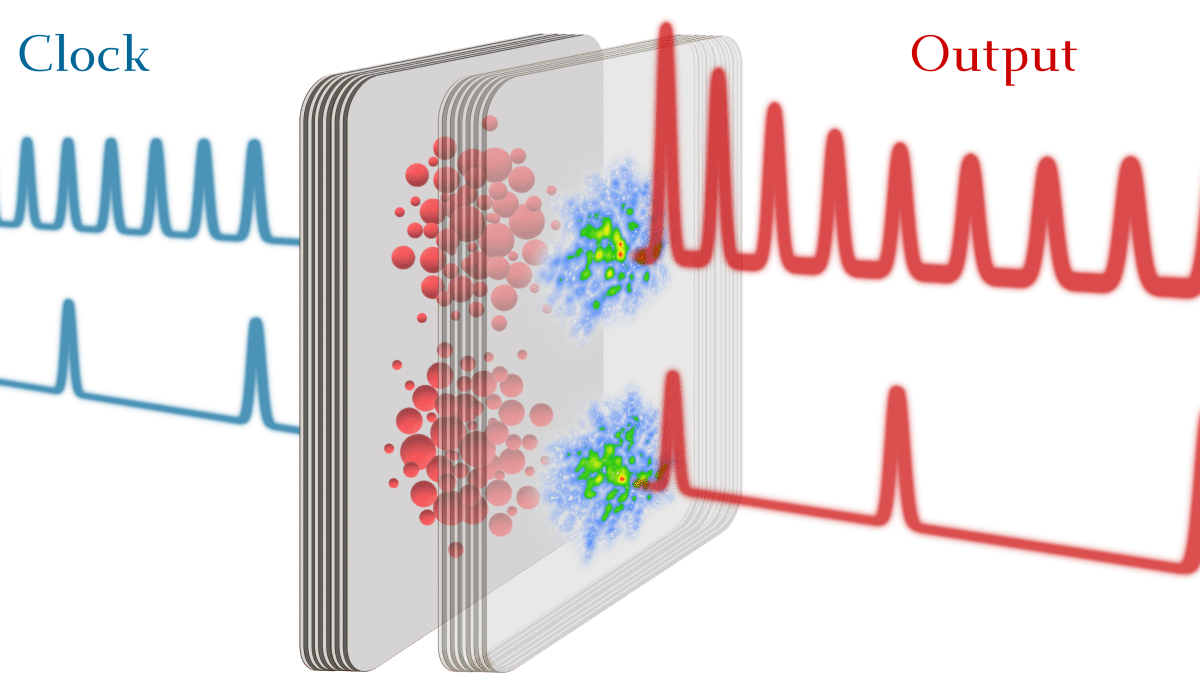

Эксперты отметили, что ассистенты с помощью разработок на базе RAG (Retrieval-Augmented Generation — генерация ответа с учетом найденной релевантной информации) стали прорывом в обработке естественного языка. Они анализируют многослойные запросы и дают точные ответы в режиме реального времени. Однако этим пользуются не только компании, работающие с клиентами, но и злоумышленники.

Аферисты могут применять аналогичные инструменты, имитируя звонки от сотрудников банков или государственных учреждений. Так называемые ИИ-мошенники в реальном времени структурируют ответы жертвы, чтобы подстраиваться под конкретные ситуации. Технологии позволяют имитировать эмоциональную окраску голоса, чтобы сделать атаки максимально убедительными.

В Neuro.net подчеркнули, что особую опасность представляет возможность массового обзвона, в котором каждый звонок персонализировать с учетом утечек личных данных. При этом для работы с такими инструментами мошенникам не нужно обладать профессиональными навыками.

Специалисты обращают внимание, что скамеры используют урезанные и небезопасные версии ИИ-технологий. Добросовестные разработчики применяют методы многоуровневой защиты, которые в том числе помогают обнаружить подозрительную активность.

![С миру по нитке [25.04.2025]](http://tesera.ru/images/items/2474823,15/125x125xpa/photo.png)