OpenAI introduce controlli d’identità per accedere ai suoi modelli più avanzati

OpenAI annuncia un'importante novità per garantire maggiore sicurezza nell'accesso e nell'utilizzo delle proprie tecnologie.

In un contesto in cui l’intelligenza artificiale gioca un ruolo sempre più influente nella società, OpenAI annuncia un’importante novità per garantire maggiore sicurezza nell’accesso e nell’utilizzo delle proprie tecnologie. La società ha infatti reso noto che introdurrà un processo di verifica dell’identità per alcune organizzazioni che intendono utilizzare i suoi modelli di AI più avanzati. Il cambiamento, descritto in una nuova pagina di supporto sul sito ufficiale, rappresenta una stretta significativa alle modalità di accesso all’API di OpenAI.

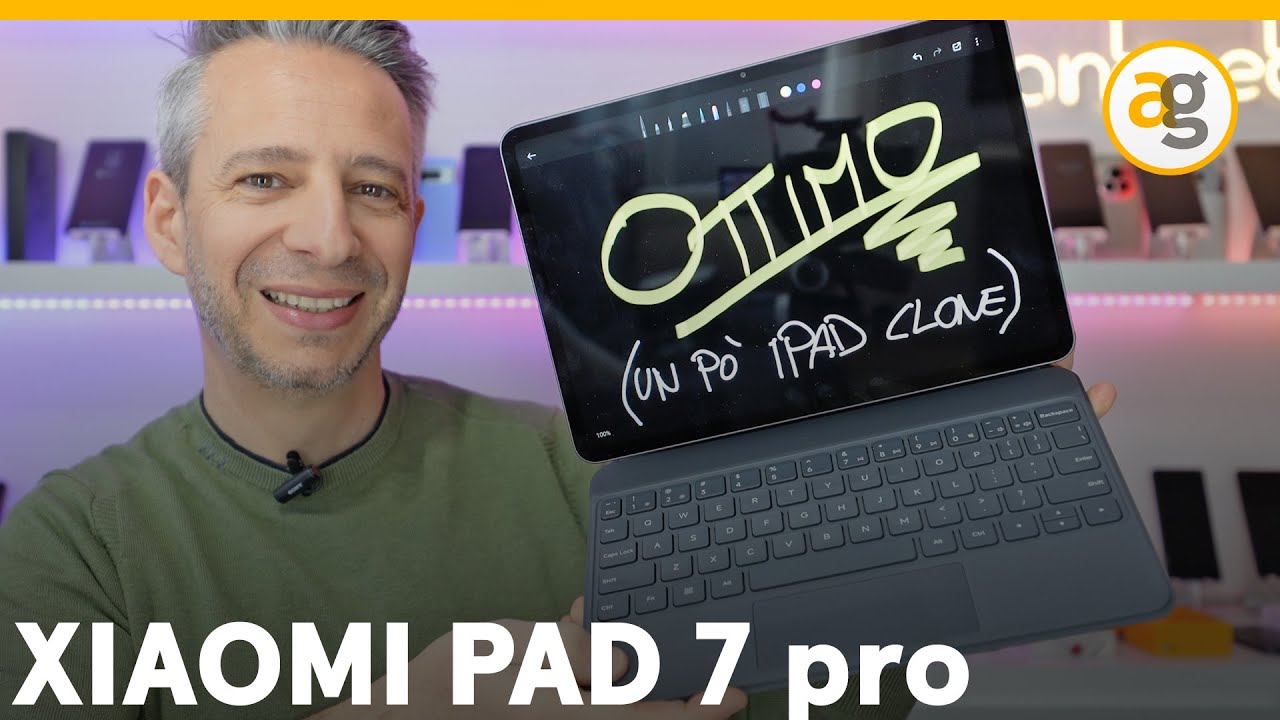

Una nuova barriera di sicurezza per OpenAI: Verified Organisation

Il processo, chiamato Verified Organisation, sarà un prerequisito per gli sviluppatori e le aziende che vogliono sbloccare le funzionalità più evolute disponibili sulla piattaforma di OpenAI. Secondo le informazioni pubblicate, per completare la verifica sarà necessario presentare un documento d’identità emesso dal governo di un paese in cui l’API di OpenAI è disponibile.

La misura non è solo amministrativa. Dietro questa scelta, c’è la chiara volontà della società di rendere l’intelligenza artificiale più sicura e responsabile. OpenAI ha infatti dichiarato che “prende molto seriamente la propria responsabilità nel garantire che l’AI sia accessibile ma anche usata in modo sicuro”. L’obiettivo della verifica è quello di ridurre i rischi legati a un uso scorretto delle API, pur continuando a offrire le funzioni più avanzate a una comunità più ampia di sviluppatori.

Un documento, una sola organizzazione ogni 90 giorni

Un aspetto rilevante del nuovo processo riguarda la limitazione: una sola organizzazione potrà essere verificata con un documento ogni 90 giorni. Non tutte le richieste, inoltre, saranno accettate, segno che OpenAI intende adottare criteri rigorosi nel selezionare gli accessi alle proprie risorse più sensibili. Questo elemento introduce anche una prima forma di selezione qualitativa tra le organizzazioni che vogliano accedere ai modelli più potenti di AI.

Lotta contro l’abuso e il furto di proprietà intellettuale

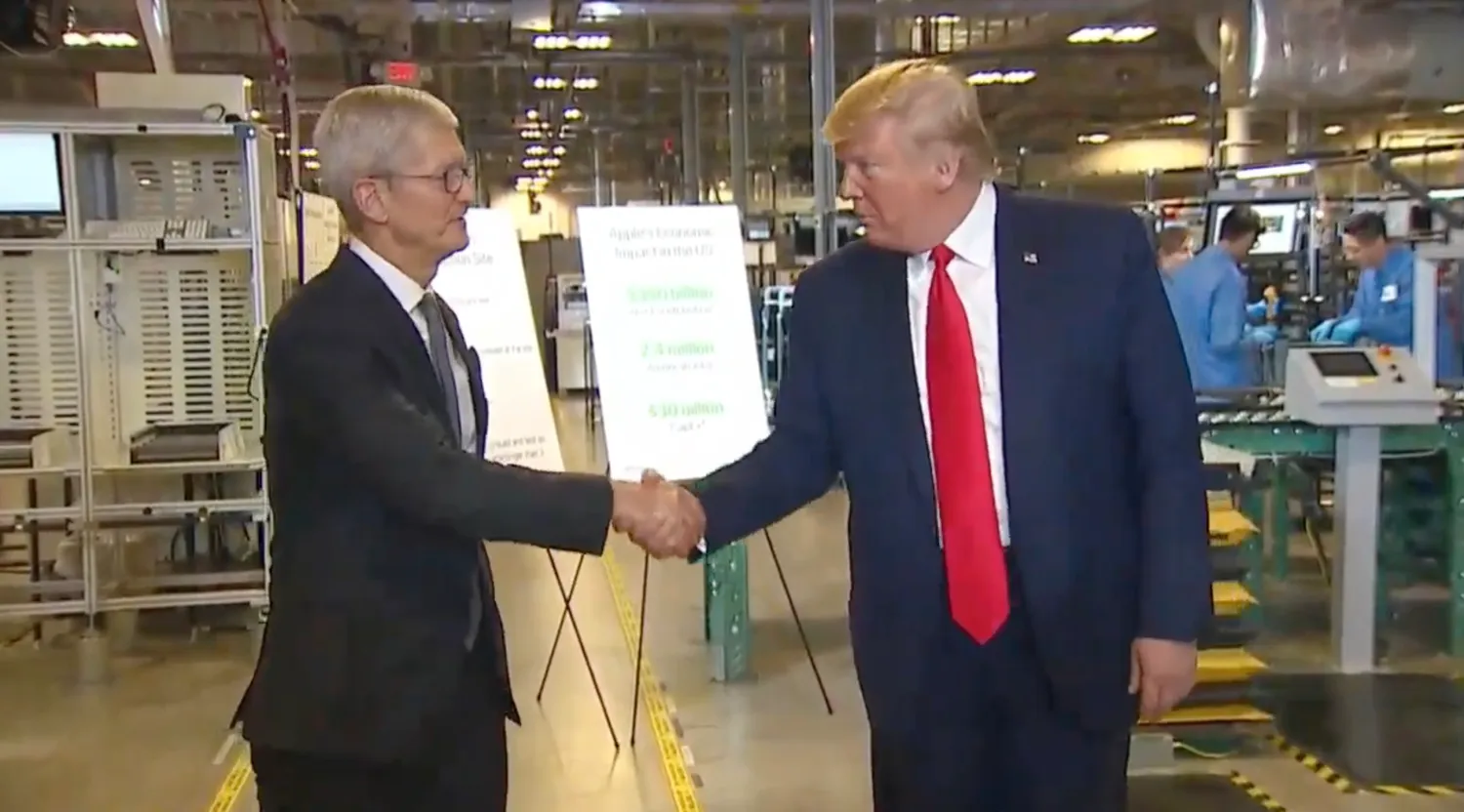

L’introduzione della verifica arriva dopo che OpenAI ha pubblicato vari rapporti sui tentativi di utilizzo illecito delle sue tecnologie. Gruppi presumibilmente collegati alla Corea del Nord, secondo quanto riportato, avrebbero cercato di sfruttare i modelli di OpenAI per finalità non autorizzate.

Ma non è solo un problema geopolitico. Le misure riguardano anche la protezione della proprietà intellettuale. A inizio 2024, come rivelato da Bloomberg, OpenAI ha avviato un’indagine per verificare se un gruppo collegato al laboratorio cinese DeepSeek abbia estratto massicci volumi di dati attraverso l’API di OpenAI, con l’intenzione sospetta di addestrare i propri modelli in violazione delle condizioni d’uso.

In un altro caso, emerso a febbraio, diversi account cinesi sono stati bannati per aver utilizzato ChatGPT in attività legate al monitoraggio dei social media, come riferito da un report sull’intelligence sulle minacce. Questo esempio sottolinea ulteriormente le preoccupazioni di OpenAI riguardo all’utilizzo della propria piattaforma per fini non autorizzati o potenzialmente dannosi.

Accesso responsabile e tecnologie avanzate

Alla luce di queste dinamiche, l’azienda guidata da Sam Altman sembra voler trovare un delicato equilibrio tra l’accessibilità della tecnologia AI e la sua regolamentazione responsabile. Il messaggio è chiaro: chi vuole accedere ai modelli più performanti, dovrà prima dimostrare di essere un soggetto affidabile.

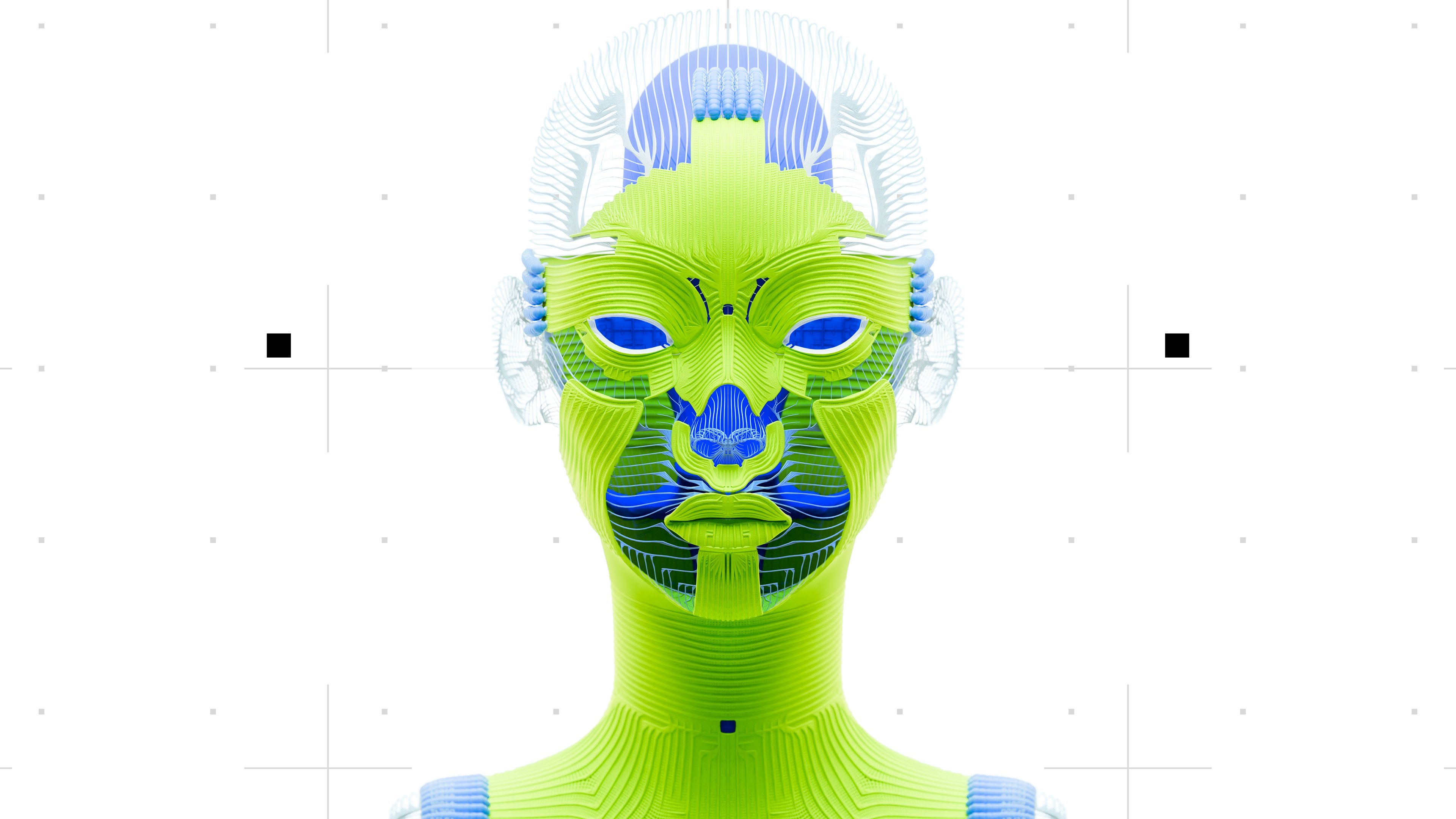

L’iniziativa può anche essere interpretata come un segnale verso la maturità crescente dell’ecosistema AI. Man mano che i modelli diventano più complessi e capaci, aumentano anche i tentativi di manipolazione, clonazione o sfruttamento illecito. In questo scenario, la verifica delle organizzazioni diventa una sorta di filtro di sicurezza, capace di limitare l’uso improprio mantenendo un ambiente di innovazione aperta.

Un impatto sulla comunità degli sviluppatori

Sebbene le intenzioni siano orientate alla protezione e alla responsabilità, la nuova politica potrebbe anche suscitare reazioni nella comunità degli sviluppatori. Alcuni potrebbero percepire l’aggiunta della verifica come un ostacolo nell’accesso all’innovazione, soprattutto se si trovano in paesi con restrizioni sull’uso dell’API o se non riescono a soddisfare i requisiti imposti.

Tuttavia, OpenAI ha chiarito che si tratta di una misura rivolta a una minoranza che viola deliberatamente le politiche di utilizzo. Per la grande parte degli sviluppatori che operano nel rispetto delle regole, la verifica non dovrebbe rappresentare un limite, ma piuttosto una protezione ulteriore contro gli usi non autorizzati che potrebbero compromettere l’intero ecosistema.

Verso un’intelligenza artificiale più sicura

Con questa mossa, OpenAI ribadisce il proprio impegno verso una intelligenza artificiale etica e sicura, ponendo un nuovo standard per il settore. La crescente attenzione ai temi di sicurezza, proprietà intellettuale e responsabilità etica mostra come l’AI non sia soltanto una questione di efficienza tecnologica, ma anche di governance e controllo.

Mentre i modelli diventano sempre più performanti, l’introduzione della verifica rafforza la necessità di un dialogo continuo tra innovazione e etica dell’uso. E OpenAI, con questa scelta, sembra voler guidare il settore non solo in termini di avanzamento tecnologico, ma anche di leadership responsabile.

/https://www.html.it/app/uploads/2025/04/wp_drafter_547803.jpg)

/https://www.ilsoftware.it/app/uploads/2024/06/YouTube-Music.jpg)

/https://www.ilsoftware.it/app/uploads/2023/06/OpenAI-Logo-GPT-ChatGPT-IA-min.jpg)

/https://www.html.it/app/uploads/2025/04/windows-11.jpg)