Używasz „proszę” i „dziękuję” w ChatGPT? OpenAI płaci za to dziesiątki milionów dolarów

Uprzejmość pozostaw na rozmowy z ludźmi, AI ceni precyzję i dokładność. Interakcje ze sztuczną inteligencją, taką jak ChatGPT od OpenAI, Gemini od Google, Claude od Anthropic i wiele innych maszynowych rozmówców stają się coraz bardziej naturalne, a użytkownicy często używają zwrotów grzecznościowych, takich jak „proszę” czy „dziękuję”. To nie tylko niepotrzebne, a wręcz potencjalnie szkodliwe, […] Artykuł Używasz „proszę” i „dziękuję” w ChatGPT? OpenAI płaci za to dziesiątki milionów dolarów pochodzi z serwisu ANDROID.COM.PL - społeczność entuzjastów technologii.

Uprzejmość pozostaw na rozmowy z ludźmi, AI ceni precyzję i dokładność. Interakcje ze sztuczną inteligencją, taką jak ChatGPT od OpenAI, Gemini od Google, Claude od Anthropic i wiele innych maszynowych rozmówców stają się coraz bardziej naturalne, a użytkownicy często używają zwrotów grzecznościowych, takich jak „proszę” czy „dziękuję”. To nie tylko niepotrzebne, a wręcz potencjalnie szkodliwe, choć istnieje też pozytywny aspekt. Dlaczego? Poniżej odpowiedź.

Uprzejmość się nie opłaca

Oczywiście chodzi o uprzejmość w rozmowie z maszyną. Jak informuje New York Post, OpenAI, firma stojąca za ChatGPT, ponosi z tego tytułu ogromne koszty operacyjne, są one znacznie niezależnie od tego, z którego z modeli OpenAI użyjemy w zapytaniu. Według dyrektora generalnego OpenAI, Sama Altmana, odpowiadanie na te uprzejme zwroty generuje dodatkowe wydatki na energię elektryczną rzędu dziesiątek milionów dolarów rocznie (dokładnych kwot OpenAI nie ujawnia), co jest związane z ogromną mocą obliczeniową potrzebną do przetwarzania każdego zapytania.

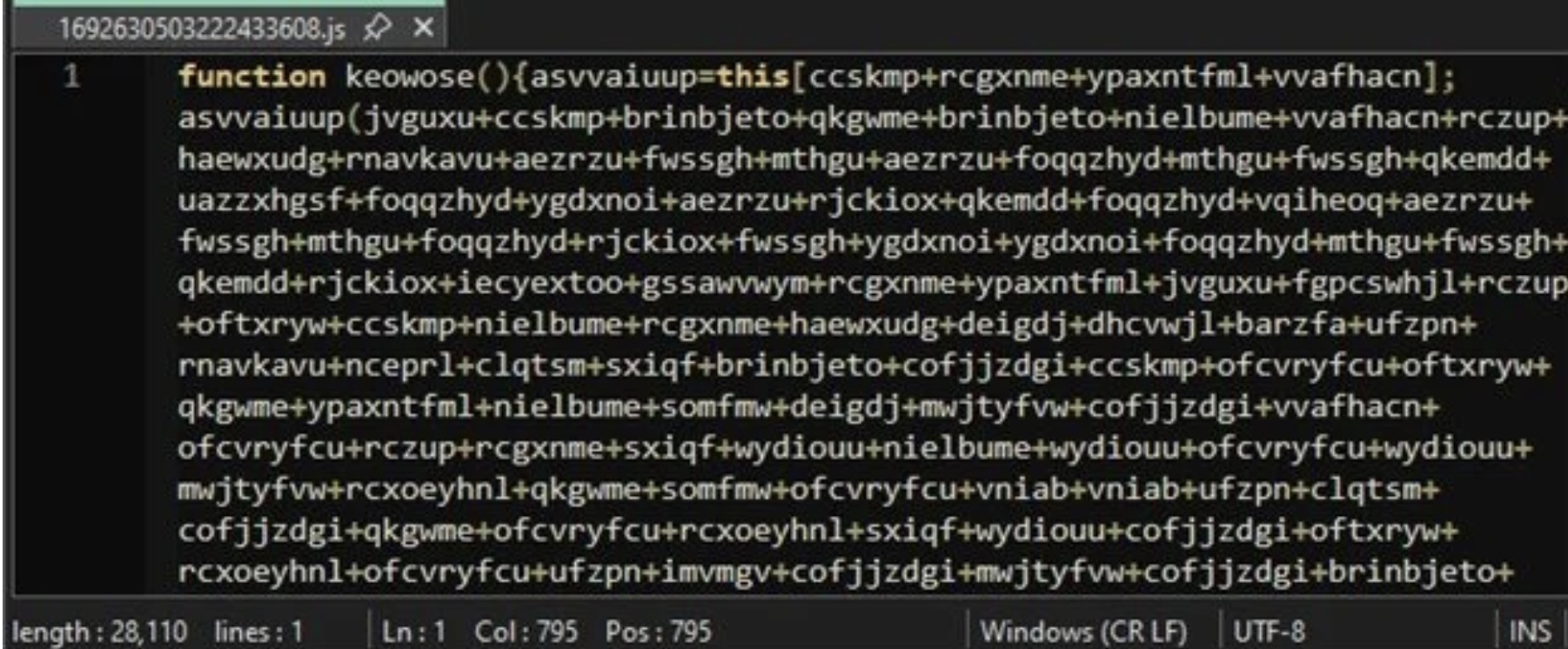

Koszty wynikają z faktu, że każda wiadomość, nawet tak prosta jak „dziękuję”, wymaga od ChatGPT pełnej odpowiedzi generowanej w czasie rzeczywistym, co angażuje zaawansowane systemy obliczeniowe. Centra danych obsługujące modele językowe, takie jak ChatGPT, zużywają ogromne ilości energii – szacuje się, że pojedyncze zapytanie do ChatGPT zużywa około 10 razy więcej energii niż standardowe wyszukiwanie w Google. To jednak rodzi kolejne pytanie: ile energii zużywa pojedyncze zapytanie w wyszukiwarce Google?

Gigant z Mountain View tego aktualnie nie podaje, a ostatnie dane w tym zakresie, jakimi się podzielił, pochodzą z 2009 roku i wynoszą ok. 0,3 Wh (watogodziny) na zapytanie. Łatwo zatem policzyć, że trzymając się wspomnianego mnożnika (10x) napisanie „dziękuję” czatowi ChatGPT pochłania ok. 3 Wh na przetworzenie naszej uprzejmości. To nie jedyny przypadek „przepalania energii”. Podobny problem powstał w korelacji do trendu Barbie AI, czy podczas masowego generowania grafik w stylu Ghibli.

Z ponad miliardem zapytań dziennie oznaczałoby to pochłonięcie 3 GWh energii przez ChatGPT na dobę! Ile to jest 3 GWh? To ilość energii, która wystarczyłaby na naładowanie floty ok. 60 tysięcy samochodów elektrycznych wyposażonych w akumulatory o pojemności 50 kWh. to niemal cała elektromobilna flota Polski (do końca stycznia 2025 roku zarejestrowano łącznie 82 508 samochodów elektrycznych (BEV), dotyczy to zarówno aut osobowych jak i dostawczych). Mam jednak tutaj dobrą wiadomość – te szacunki są mocno zawyżone.

Optymalizacja centrów danych

Przede wszystkim chodzi o to, że kluczowa dana wejściowa – zużycie energii przez Google Search na poziomie 0,3 Wh – jest mocno nieaktualna (pochodzi z 2009 roku), ale to jedyna dostępna publicznie informacja tego typu (Google później przestało publikować podobne statystyki). Użycie tej starej wartości prowadzi do zawyżenia szacowanego zużycia energii przez ChatGPT w tym konkretnym porównaniu. Chociaż prawdą jest, że zapytania do AI są bardziej energochłonne niż tradycyjne wyszukiwanie, bazowanie na danych sprzed ponad 15 lat daje mylący obraz skali tego zużycia.

Od 2009 roku (czyli od publikacji danych dotyczących zużycia energii na pojedyncze zapytanie w Google) minęło ponad 15 lat (mamy kwiecień 2025). W tym czasie efektywność energetyczna centrów danych drastycznie wzrosła. Google i inne firmy (również OpenAI) zainwestowały ogromne środki w optymalizację zużycia energii przez serwery, systemy chłodzenia (wskaźniki PUE – Power Usage Effectiveness – znacznie się poprawiły) i wykorzystanie odnawialnych źródeł energii.

Kolejna kwestia to optymalizacja algorytmów wyszukiwania i samego sprzętu. Nowsze procesory, pamięci i oprogramowanie są znacznie bardziej wydajne energetycznie niż te dostępne w 2009 roku.

W rezultacie dzisiejsze zużycie energii przez jedno zapytanie do wyszukiwarki Google jest znacznie niższe niż 0,3 Wh z 2009 roku. Chociaż Google nie publikuje aktualnych, dokładnych danych na ten temat, szacunki sugerują, że obecne zużycie może być nawet o rząd wielkości mniejsze.

Koszty i tak są olbrzymie

Jednak i tak powinniśmy pamiętać o tym, że optymalizacja to nie redukcja zużycia. Istota opisywanego tu zjawiska: czyli zużycie energii związane z niepotrzebnymi maszynie zwrotami grzecznościowymi pozostaje realnym problemem. Nawet drobne zwroty grzecznościowe znacząco zwiększają rachunki za prąd. Co więcej, procesy te wymagają wody do chłodzenia serwerów, co dodatkowo podnosi koszty i obciążenie środowiska. Niemniej tu pocieszę tych, którzy byli uprzejmi w rozmowach z ChatGPT i innymi AI: i tak zużyliście mniej energii niż osoby, które wykorzystują technologie OpenAI w nieetyczny sposób.

Przeczytaj też: Smartfon z dobrą baterią w 2025 roku. Ranking modeli wartych uwagi.

Mimo wysokich kosztów, Sam Altman żartobliwie uważa te wydatki za „dobrze wydane pieniądze”. Jego komentarz nawiązuje do popularnych żartów o potencjalnej przyszłości, w której sztuczna inteligencja mogłaby „pamiętać” ludzką uprzejmość. Istnieje jednak również pewien praktyczny aspekt tego zagadnienia: AI uczy się na ludzkich odpowiedziach. Innymi słowy uprzejme zapytania poprawiają jakość odpowiedzi sztucznej inteligencji.

Mimo wszystko wydaje się, że racjonalnym podejściem byłoby pozostawienie uprzejmości na rozmowy z ludźmi, a w interakcjach z maszyną skupienie się na precyzji zapytań i dokładności w wyrażaniu tego, czego od AI oczekujemy. To znacznie lepsze. I dla jakości wyników wygenerowanych przez sztuczną inteligencję i dla planety.

Źródło: opracowanie własne, NY Post. Zdjęcie otwierające: miss.cabul / Shutterstock

Część odnośników to linki afiliacyjne lub linki do ofert naszych partnerów. Po kliknięciu możesz zapoznać się z ceną i dostępnością wybranego przez nas produktu – nie ponosisz żadnych kosztów, a jednocześnie wspierasz niezależność zespołu redakcyjnego.

Artykuł Używasz „proszę” i „dziękuję” w ChatGPT? OpenAI płaci za to dziesiątki milionów dolarów pochodzi z serwisu ANDROID.COM.PL - społeczność entuzjastów technologii.

![Weekendowa Lektura: odcinek 620 [2025-04-19]. Bierzcie i czytajcie](https://zaufanatrzeciastrona.pl/wp-content/uploads/2024/02/library.jpg)

-d6c719af745595225dd21cd9f28ccda6.jpg)