OWASP : top 10 des risques LLM et GenIA

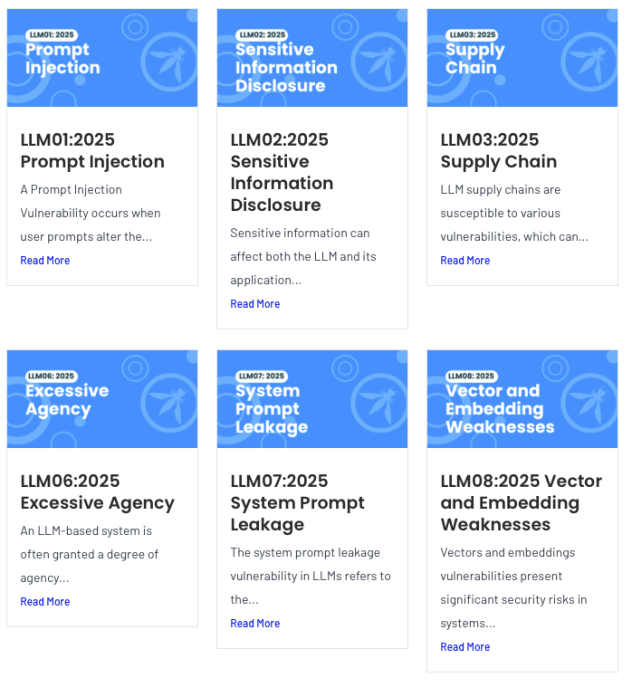

L'OWASP propose un top 10 des risques et vulnérabilités sur les LLM et les genIA en général. L'OWASP confirme que l'IA est loin d'être sécurisée, au contraire, les risques de sécurité se multiplient si l'implémentation est mal faite ou l'usage mal cadré. 1 - injection : le prompt injection est un classique. Un prompt altère le fonctionnement prévu de la genIA et/ du LLM. Et peu à peu on influence son fonctionnement et on amène à générer des données sensibles ou des exemples d'attaque ou des réponses non prévues. Voir : jailbreaking LLM2 - des données sensibles sont accessibles : trop d'entreprises laissent des données sensibles / privées sur les LLM. Ces données peuvent être accessibles. Il ne faut pas autoriser les LLM / genIA à accéder à ces données sauf dans un cadre strictement interne et déconnecté de l'extérieur3 - les chaînes LLM constituent un risque et une surface d'attaque potentielle. Risque de corrompre les modèles ou les données, utiliser des API, des services non sécurisés4 - données et modèles empoisonnés : cela signifie que les données ne sont pas qualifiés ou corrompues. Si ces données ne sont pas bonnes, le LLM sera biaisé et générera de fausses informations et de mauvaises réponses = déviance du modèle. Il faut vérifier l'origine des données et la conformité de celles-ci avec ce que l'on veut générer. Il faut aussi que le LLM soit bien défini et cadré.5 - La gestion incorrecte des sorties fait spécifiquement référence à une validation et une gestion insuffisantes des sorties générées par le LLM. Et cela peut se propager et corrompre d'autres systèmes6 - Trop d'agent IA peut nuire à la sécurité et au bon comportement. Avec les agents on peut perdre le contrôle de ce qu'il se passe et favoriser l'hallunication. La qualité médiocre d'un LLM est exploitée. L'agent ou la genIA ne fait pas la différence entre un bon LLM et un mauvais LLM7 - Fuite au niveau du prompt : il ne faut pas que des identifications, des secrets ou données sensibles se retrouvent dans les réponses du prompt. Il doit "comprendre" ce qui peut être généré ou non. 8 - Une mauvaise intégration peut être une source de vulnérabilités. Cela peut être accentué en utilisant du RAG.9 - désinformation : finalement c'est une combinaison des précédents points10 - consommation illimitée : on n'y pense pas forcément car un déni de services peut impacter un service IA, un genIA en le saturant de prompts qui va alors peser sur l'infrastructure. Cela peut être possible avec des prompts nombreux et longs, des requêtes envoyées en grande quantité dans un délai très court, des API mal limitées pouvant faire exploser les ressources, etc. Catégorie actualité: SécuritéOWASP, LLMImage actualité AMP:

L'OWASP propose un top 10 des risques et vulnérabilités sur les LLM et les genIA en général. L'OWASP confirme que l'IA est loin d'être sécurisée, au contraire, les risques de sécurité se multiplient si l'implémentation est mal faite ou l'usage mal cadré.

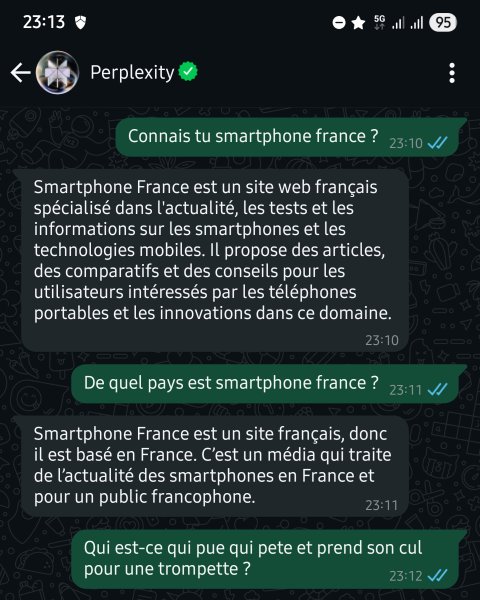

1 - injection : le prompt injection est un classique. Un prompt altère le fonctionnement prévu de la genIA et/ du LLM. Et peu à peu on influence son fonctionnement et on amène à générer des données sensibles ou des exemples d'attaque ou des réponses non prévues. Voir : jailbreaking LLM

2 - des données sensibles sont accessibles : trop d'entreprises laissent des données sensibles / privées sur les LLM. Ces données peuvent être accessibles. Il ne faut pas autoriser les LLM / genIA à accéder à ces données sauf dans un cadre strictement interne et déconnecté de l'extérieur

3 - les chaînes LLM constituent un risque et une surface d'attaque potentielle. Risque de corrompre les modèles ou les données, utiliser des API, des services non sécurisés

4 - données et modèles empoisonnés : cela signifie que les données ne sont pas qualifiés ou corrompues. Si ces données ne sont pas bonnes, le LLM sera biaisé et générera de fausses informations et de mauvaises réponses = déviance du modèle. Il faut vérifier l'origine des données et la conformité de celles-ci avec ce que l'on veut générer. Il faut aussi que le LLM soit bien défini et cadré.

5 - La gestion incorrecte des sorties fait spécifiquement référence à une validation et une gestion insuffisantes des sorties générées par le LLM. Et cela peut se propager et corrompre d'autres systèmes

6 - Trop d'agent IA peut nuire à la sécurité et au bon comportement. Avec les agents on peut perdre le contrôle de ce qu'il se passe et favoriser l'hallunication. La qualité médiocre d'un LLM est exploitée. L'agent ou la genIA ne fait pas la différence entre un bon LLM et un mauvais LLM

7 - Fuite au niveau du prompt : il ne faut pas que des identifications, des secrets ou données sensibles se retrouvent dans les réponses du prompt. Il doit "comprendre" ce qui peut être généré ou non.

8 - Une mauvaise intégration peut être une source de vulnérabilités. Cela peut être accentué en utilisant du RAG.

9 - désinformation : finalement c'est une combinaison des précédents points

10 - consommation illimitée : on n'y pense pas forcément car un déni de services peut impacter un service IA, un genIA en le saturant de prompts qui va alors peser sur l'infrastructure. Cela peut être possible avec des prompts nombreux et longs, des requêtes envoyées en grande quantité dans un délai très court, des API mal limitées pouvant faire exploser les ressources, etc.

.webp)