Una de las empresas que mejor usa la IA sufrió gravemente una IA que alucina: se inventó una respuesta mientras hacía de soporte

Llevamos un buen tiempo utilizando tecnologías y herramientas basadas en inteligencia artificial generativa como para saber que uno de sus principales problemas es que 'alucinan', es decir, que a veces puede ocurrir que la IA ofrezca información incorrecta o inventada como si fuera cierta. Esto suele pasar cuando no tiene datos suficientes o interpreta mal el contexto, y aun así da una respuesta errónea con seguridad. En un reciente incidente con Cursor, un IDE (entorno de desarrollo integrado) reconocido por integrar funciones de IA para programar, las alucinaciones de su IA han vuelto a poner de manifiesto este problema. La IA de Cursor que alucina con sus propias políticas Todo comenzó con un problema técnico aparentemente simple. Usuarios de Cursor empezaron a ser desconectados automáticamente cuando intentaban trabajar desde múltiples dispositivos. Al cambiar del ordenador de sobremesa al portátil, por ejemplo, se dieron cuenta de que la plataforma les echaba, sin ningún tipo de aviso o notificación. Algunos de los desarrolladores afectados acudieron al soporte técnico para intentar averiguar qué es lo que sucedía. Según cuenta un usuario de Ycombinator, el supuesto equipo de soporte respondió a los usuarios que esto era un "comportamiento esperado" bajo una nueva política de inicio de sesión de Cursor. En Genbeta Tras muchas decepciones, esto es lo que Google está haciendo en IA para que nadie más le gane. Solo le queda lo más difícil El problema precisamente es que no existía tal política, ni tampoco un equipo humano de soporte. Y es que las respuestas provenían de un bot de IA diseñado para "imitar respuestas humanas", que se había inventado completamente esta explicación. La respuesta fabricada por la IA se propagó rápidamente entre los usuarios. De hecho, hasta algunos desarrolladores, que dependen fundamentalmente de poder trabajar en múltiples dispositivos, comenzaron a cancelar sus suscripciones a la plataforma. Como señaló uno de los afectados, poder trabajar en varios dispositivos es una característica básica para cualquier desarrollador, y un supuesto cambio tan importante en las políticas debería, como mínimo, haber sido anunciado previamente. A medida que los usuarios debatían sobre sus teorías y comenzaban a sospechar que algo no encajaba, el hilo principal en Reddit sobre el tema fue primero bloqueado y posteriormente eliminado, lo que solo aumentó la confusión y el descontento. Michael Truell, cofundador y CEO de Cursor, tuvo que intervenir públicamente para aclarar la situación. En un comentario en Ycombinator, explicó: "Pedimos disculpas, algo salió claramente mal. Ya hemos comenzado a investigar. Cualquier respuesta de IA utilizada para el soporte por correo electrónico ahora está claramente etiquetada como tal. Utilizamos respuestas asistidas por IA como primer filtro para el soporte por correo". En Reddit, Truell fue aún más directo sobre el incidente: "No tenemos tal política. Por supuesto que puedes usar Cursor en múltiples máquinas. Desafortunadamente, esta es una respuesta incorrecta de un bot de soporte de primera línea con IA". Según explicó Truell, el problema técnico que desencadenó toda la situación fue una "condición de carrera" que aparece en conexiones de internet muy lentas. Este error provocaba la creación de numerosas sesiones innecesarias que terminaban desplazando a las sesiones reales, provocando las desconexiones. Truell asegura que ya han implementado una solución. Que una IA alucine puede ser divertido en determinados momentos en los que trasteamos con ella sin ningún objetivo en mente. Sin embargo, cuando lo hace en sectores críticos puede ocasionar graves problemas. Por suerte, en este caso la cosa no ha ido a mayores. Imagen de portada | Christopher Gower En Genbeta | Del 'vibe coding' al 'vibe hacking': la IA ya es todo un agente de ciberseguridad. Apunta a cambiarlo todo en empresas pequeñas - La noticia Una de las empresas que mejor usa la IA sufrió gravemente una IA que alucina: se inventó una respuesta mientras hacía de soporte fue publicada originalmente en Genbeta por Antonio Vallejo .

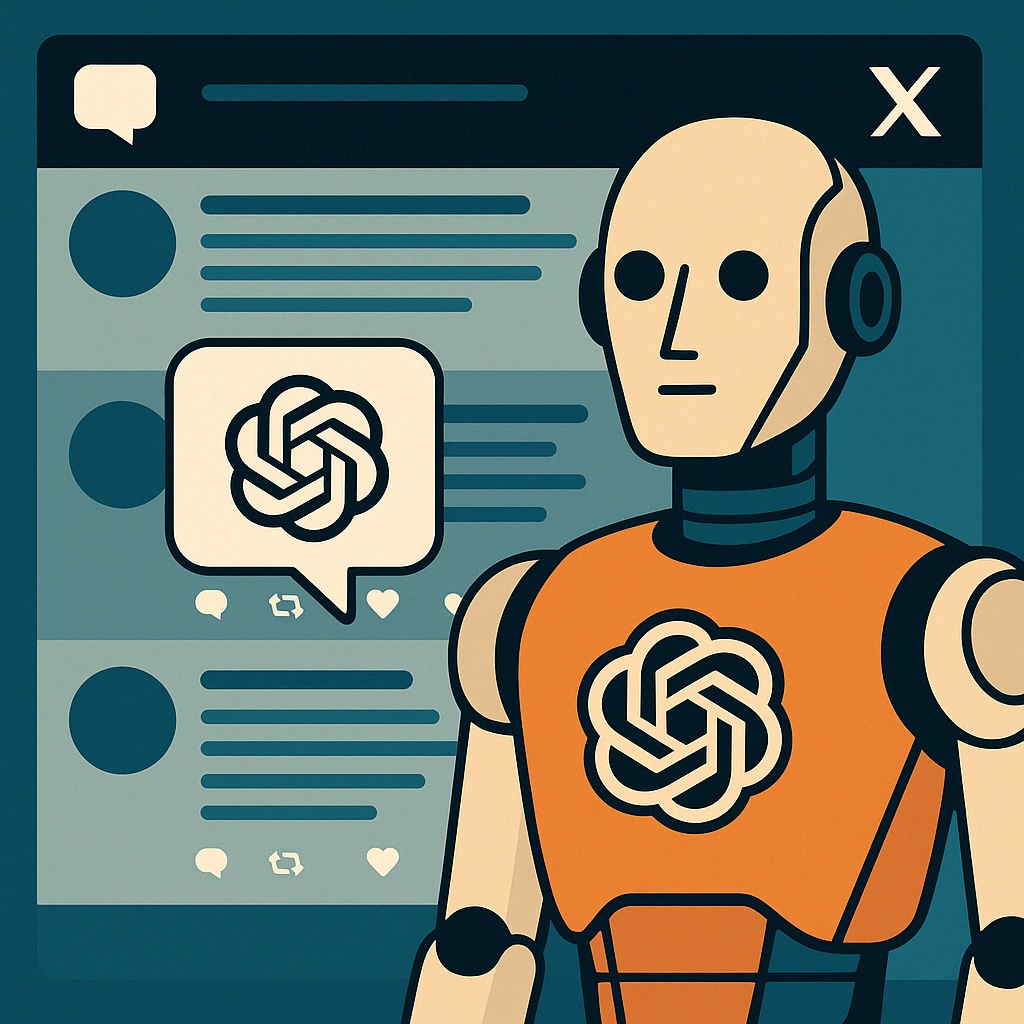

Llevamos un buen tiempo utilizando tecnologías y herramientas basadas en inteligencia artificial generativa como para saber que uno de sus principales problemas es que 'alucinan', es decir, que a veces puede ocurrir que la IA ofrezca información incorrecta o inventada como si fuera cierta. Esto suele pasar cuando no tiene datos suficientes o interpreta mal el contexto, y aun así da una respuesta errónea con seguridad.

En un reciente incidente con Cursor, un IDE (entorno de desarrollo integrado) reconocido por integrar funciones de IA para programar, las alucinaciones de su IA han vuelto a poner de manifiesto este problema.

La IA de Cursor que alucina con sus propias políticas

Todo comenzó con un problema técnico aparentemente simple. Usuarios de Cursor empezaron a ser desconectados automáticamente cuando intentaban trabajar desde múltiples dispositivos. Al cambiar del ordenador de sobremesa al portátil, por ejemplo, se dieron cuenta de que la plataforma les echaba, sin ningún tipo de aviso o notificación.

Algunos de los desarrolladores afectados acudieron al soporte técnico para intentar averiguar qué es lo que sucedía. Según cuenta un usuario de Ycombinator, el supuesto equipo de soporte respondió a los usuarios que esto era un "comportamiento esperado" bajo una nueva política de inicio de sesión de Cursor.

El problema precisamente es que no existía tal política, ni tampoco un equipo humano de soporte. Y es que las respuestas provenían de un bot de IA diseñado para "imitar respuestas humanas", que se había inventado completamente esta explicación.

La respuesta fabricada por la IA se propagó rápidamente entre los usuarios. De hecho, hasta algunos desarrolladores, que dependen fundamentalmente de poder trabajar en múltiples dispositivos, comenzaron a cancelar sus suscripciones a la plataforma. Como señaló uno de los afectados, poder trabajar en varios dispositivos es una característica básica para cualquier desarrollador, y un supuesto cambio tan importante en las políticas debería, como mínimo, haber sido anunciado previamente.

A medida que los usuarios debatían sobre sus teorías y comenzaban a sospechar que algo no encajaba, el hilo principal en Reddit sobre el tema fue primero bloqueado y posteriormente eliminado, lo que solo aumentó la confusión y el descontento.

Michael Truell, cofundador y CEO de Cursor, tuvo que intervenir públicamente para aclarar la situación. En un comentario en Ycombinator, explicó:

"Pedimos disculpas, algo salió claramente mal. Ya hemos comenzado a investigar. Cualquier respuesta de IA utilizada para el soporte por correo electrónico ahora está claramente etiquetada como tal. Utilizamos respuestas asistidas por IA como primer filtro para el soporte por correo".

En Reddit, Truell fue aún más directo sobre el incidente: "No tenemos tal política. Por supuesto que puedes usar Cursor en múltiples máquinas. Desafortunadamente, esta es una respuesta incorrecta de un bot de soporte de primera línea con IA".

Según explicó Truell, el problema técnico que desencadenó toda la situación fue una "condición de carrera" que aparece en conexiones de internet muy lentas. Este error provocaba la creación de numerosas sesiones innecesarias que terminaban desplazando a las sesiones reales, provocando las desconexiones. Truell asegura que ya han implementado una solución.

Que una IA alucine puede ser divertido en determinados momentos en los que trasteamos con ella sin ningún objetivo en mente. Sin embargo, cuando lo hace en sectores críticos puede ocasionar graves problemas. Por suerte, en este caso la cosa no ha ido a mayores.

Imagen de portada | Christopher Gower

-

La noticia

Una de las empresas que mejor usa la IA sufrió gravemente una IA que alucina: se inventó una respuesta mientras hacía de soporte

fue publicada originalmente en

Genbeta

por

Antonio Vallejo

.