La organización con ventaja a la hora de adoptar inteligencia artificial

También: Anthropic entierra al loro estocástico: en Claude están emergiendo elementos de inteligencia; La realidad económica de apps y videojuegos que les lleva a parecerse al contenido digital

Hoy volvemos al formato de varios temas de tendencias en tecnología

Un tipo de organización con ventaja a la hora de adoptar inteligencia artificial

Se ha comentado mucho el memo filtrado de Tobias Lütke, CEO de Shopify (aquí traducido), como una de las apuestas de integración de inteligencia artificial en la empresa.

Lütke adopta una postura maximalista: usar Al de manera efectiva es ahora una expectativa fundamental de todos en Shopify, añadirán preguntas sobre el uso de Al a su cuestionario de rendimiento, no ve factible optar por no aprender la habilidad de aplicar IA en el trabajo… aunque evita hablar de despidos o reducciones de plantilla.

Lo más interesante, creo, es la metodología implícita con la que plantea el uso de la inteligencia artificial: de abajo hacia arriba, con los empleados y equipos experimentando, compartiendo lo descubierto y, tal como él admite, cometiendo errores. El CEO de Shopify parte de una experiencia que comparto: usar bien la IA es una habilidad que necesita ser aprendida... practicándola mucho.

Comparto el punto final del memo, sin duda el más comentado:

“Antes de pedir más personal y recursos, los equipos deben demostrar por qué no pueden obtener lo que quieren hacer usando la IA. ¿Cómo se vería esta área si los agentes autónomos de IA ya fueran parte del equipo? Esta pregunta puede llevar a discusiones y proyectos realmente divertidos.”

Si Lütke tiene razón, las organizaciones con una cultura y organización menos jerárquica y más abierta a la autonomía de equipos y empleados van a tener mucha ventaja en la adopción de la IA. Es mucho más probable encontrar los aumentos de productividad y los casos de uso “de abajo hacia arriba” que a partir de decisiones de directivos o mandos intermedios que lo tengan clarísimo a priori.

Anthropic entierra al loro estocástico: en Claude están emergiendo elementos de inteligencia

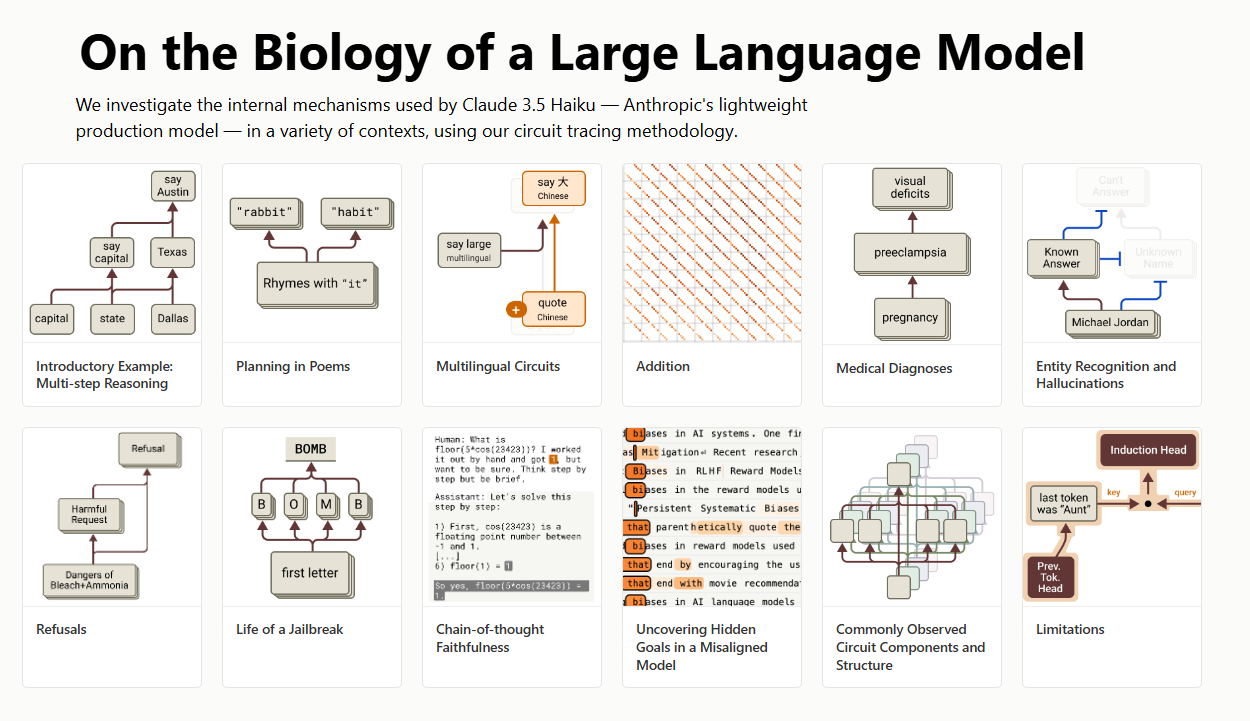

Una investigación de Anthropic aborda la crítica fundamental de que los Modelos de Lenguaje Grandes (LLM) como los GPTs o Claude son "cajas negras", cuyo funcionamiento interno es opaco incluso para sus creadores. Aunque podríamos decir que esta falta de explicabilidad también es, en parte, común a los humanos (aunque nosotros pensemos que mediante la introspección podemos encontrar nuestras razones, eso es bastante discutible), el no saber por qué la IA decide algo y no lo contrario dificulta la confianza, la seguridad y la predicción de errores como las "alucinaciones".

Utilizaron una técnica llamada "grafos de atribución" en su modelo Claude 3.5 Haiku, funcionando como una "resonancia magnética" para la IA. Esto les permitió mapear qué partes del modelo se activan y cómo fluye la información durante la generación de respuestas, revelando la "biología" (ejem) interna del LLM.

Para los investigadores, los hallazgos clave desafían la idea de que los LLM son simples "loros estocásticos" que predicen la siguiente palabra. Se descubrió que Claude:

Planifica con antelación: Por ejemplo, identifica palabras para rimar antes de escribir un verso.

Usa conceptos abstractos: Activa una idea general (como "grandeza") antes de dar un antónimo específico en un idioma.

Realiza razonamiento interno: Infiere relaciones (como "Dallas está en Texas" para hallar su capital) sin necesidad de escribirlo explícitamente.

Posee circuitos especializados: Presenta patrones neuronales para tareas como la aritmética o la simulación de diagnósticos médicos.

Muestra discrepancias: Su proceso interno no siempre coincide con la explicación que genera ("Chain-of-Thought").

Creo que es un estudio fascinante que nos incomoda en dos direcciones. Por un lado tenemos esa diferencia entre lo que nos indica el modelo sobre como ha llegado a un resultado y lo que ha “razonado” realmente cuando miramos dentro.

Por otro esta la complejidad que parece haber emergido en el entrenamiento: conceptos abstractos, razonamientos internos, planificación, especialización como en nuestro cerebro.

Es posible que los resultados de esta investigación contenten a las dos facciones enfrentadas en la investigación que busca la inteligencia artificial general.

Los escépticos para con los LLMs (que van desde “es autocompletador sofisticado como mucho” o “es algo útil pero tiene un techo que estamos tocando”) pueden ver en esa invención de las razones que nos dice un nuevo lado de alucinación y aleatoridad.

Los entusiastas de este camino pueden señalar que queda demostrado que están emergiendo elementos de inteligencia mucho más allá del cálculo de probabilidades del próximo token. El loro estocástico, por tanto, habría muerto.

La realidad económica de apps y videojuegos que les lleva a parecerse al contenido digital

Scharon Harding en Ars Technica rompe la ilusión de que se vaya a acabar el convertir todo en una suscripción. El análisis de datos de ingresos de aproximadamente 70,000 aplicaciones móviles revela una realidad económica "aleccionadora”: una vasta mayoría de las aplicaciones generan ingresos muy bajos o prácticamente nulos; los decepcionantes ingresos de los modelos tradicionales (pagar por la app o la publicidad) explican por qué cada vez más desarrolladores presionan a los usuarios para que adopten modelos de suscripción.

Y, claro, desde la perspectiva del desarrollador, las suscripciones ofrecen un flujo de ingresos más predecible y recurrente. Esto les permite financiar el desarrollo continuo, el mantenimiento, las actualizaciones y los costes operativos a lo largo del tiempo, en lugar de depender de un flujo constante de nuevas compras únicas.

Un buen reportaje de Blanca Gispert en La Vanguardia sobre si el periodo actual del sector de los videojuegos sea una crisis de transformación o simplemente un ajuste frente a las expectativas infladas en la pandemia. Despidos, cierres de estudio y la sensación de que el modelo de juego como servicio se está imponiendo al de comprar y jugar.

¿Qué cabe esperar? Con la bajada de la barrera de entrada y el aumento de productividad, tendremos una explosión de apps y videojuegos en el mercado. Cuando hablamos del impacto en el mundo del desarrollo software de la IA, apuntamos a que no es sólo que los no programadores puedan crear pequeños proyectos, es que los que sí saben programar o equipos pequeños pueden hacer mucho más.

Intuyo que el software, sean apps, servicios web o videojuegos, se parecerá cada vez más al contenido digital. Y que su éxito y distribución seguirá la lógica del mismo. Cada vez más importante el descubrimiento y la viralidad (hay demasiado para la atención disponible) y no tanto “la calidad” del producto en sí. Cuento los días para que alguien acuñe un término como “meme apps”.

Breves

Bill Gates libera el código fuente de Altair Basic, el primer sistema operativo de Microsoft. En su web.

M. Mcloughlin en El Confidencial sobre Klarna y sus planes de sustituir a los trabajadores humanos con inteligencia artificial.

Demo Peláez sobre las dos ventas del año en la Málaga tecnológica. En Málaga Hub.

En EsencialTech envían cada día un resumen de lo esencial: innovación, inteligencia artificial, gadgets y más.

En el rincón más oscuro de las criptomonedas, un suicidio se convierte en otro meme Coin. El oscuro descenso de un hombre de 23 años a las criptoestafas acabó pegándose un tiro en un livestream. Kevin T. Dugan en WSJ.

España y startups. Por Javi Santana.

La historia de la creación de Balatro (mi droga absoluta), por su creador, LocalThunk. Resumen de Javier Pastor.