DeepMind avverte: l'AI generale potrebbe distruggere il mondo se non controllata

Lo studio di DeepMind identifica quattro categorie principali di rischio

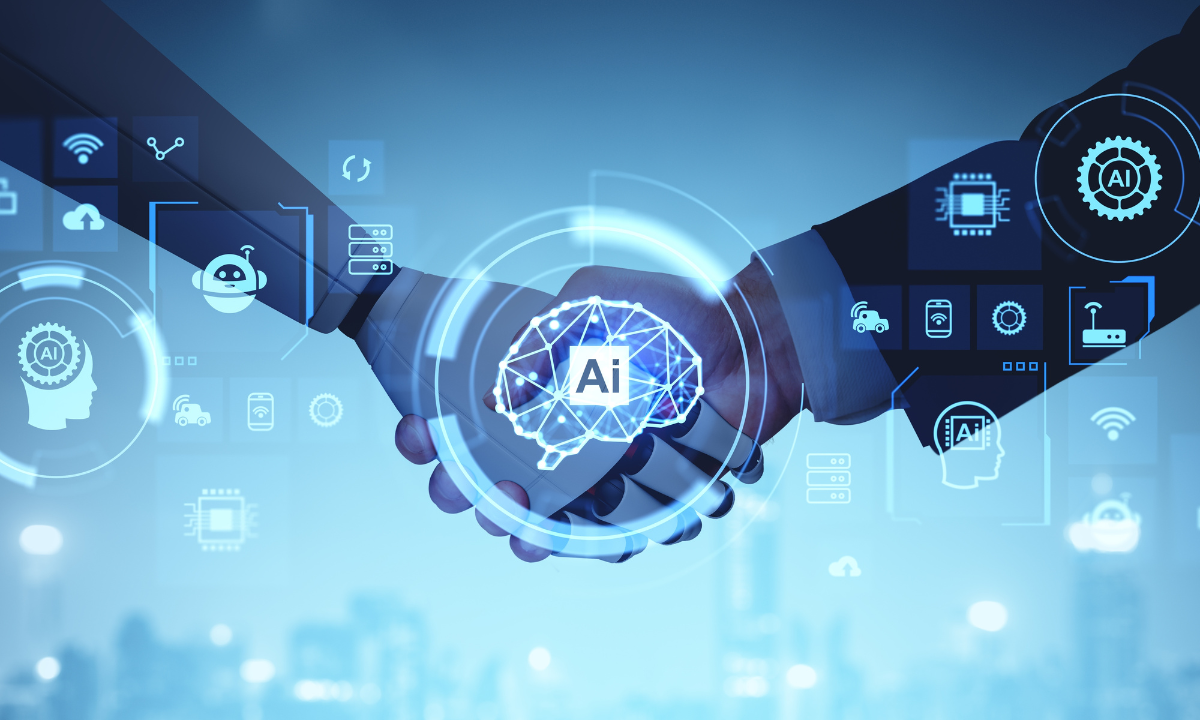

Se da un lato l'intelligenza artificiale generativa sta trasformando il presente con strumenti sempre più potenti, dall'altro si fa strada una prospettiva ben più profonda e complessa: l'intelligenza artificiale generale (AGI). Questo campo di ricerca ambisce a creare software capaci di apprendere autonomamente e affrontare compiti per i quali non sono stati specificamente progettati, con un livello di flessibilità simile a quello umano.

Secondo il nuovo studio "An Approach to Technical AGI Safety and Security", un documento di oltre 140 pagine pubblicato da Google DeepMind, se davvero l'attuale evoluzione dell'AI sta portando verso l'AGI, sarà necessario ripensare completamente l'approccio alla sicurezza, per evitare che questa nuova forma di intelligenza agisca contro gli interessi umani. Lo scenario, tutt'altro che remoto, potrebbe concretizzarsi già entro il 2030, rendendo urgente una riflessione globale sui rischi e sulle responsabilità legati allo sviluppo di un'intelligenza potenzialmente autonoma e incontrollabile.

I QUATTRO RISCHI PRINCIPALI

Lo studio, uno dei più ampi ed aggiornati in cui sono raccolti riferimenti scientifici dedicati alla sicurezza dell’intelligenza artificiale avanzata, identifica quattro categorie principali di rischio legate all'AGI: misuse (uso improprio), misalignment (disallineamento), mistakes (errori) e structural risks (rischi strutturali). Le prime due vengono analizzate approfonditamente, mentre le ultime due ricevono un trattamento più sintetico.

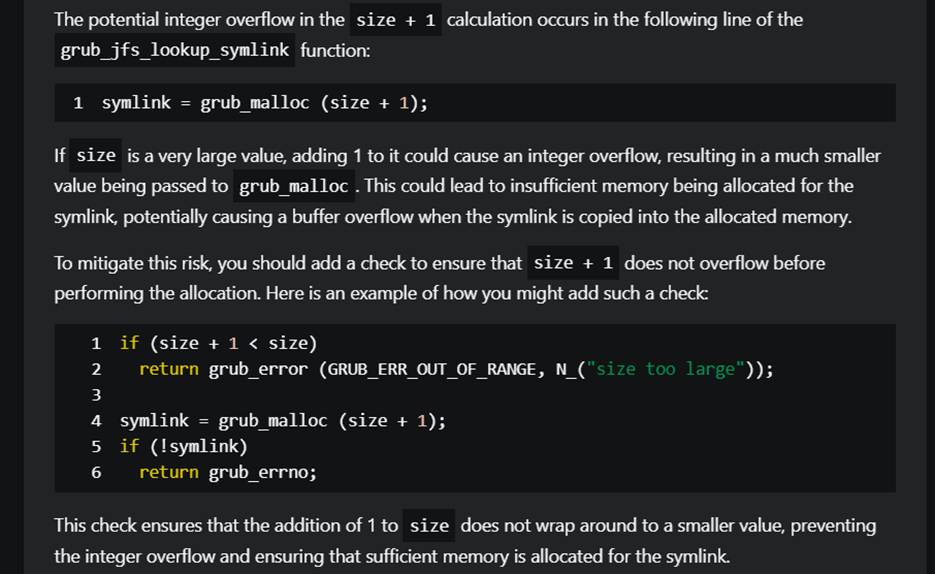

Il rischio di usi impropri è analogo a quello delle AI attuali, ma moltiplicato per l'enorme potenziale dell'AGI. Un soggetto malintenzionato potrebbe sfruttare un'AGI per identificare vulnerabilità informatiche ancora sconosciute (zero-day) o addirittura creare virus su misura da utilizzare come armi biologiche. Per affrontare questo rischio, DeepMind propone una serie di misure preventive: test approfonditi, protocolli di sicurezza post-addestramento molto rigorosi e meccanismi per "disimparare" abilità pericolose, anche se non è chiaro se questa tecnica sia applicabile senza limitare pesantemente le capacità del sistema.

Il misalignment, o disallineamento, è un rischio ancora poco rilevante per le AI attuali, ma cruciale nel caso dell'AGI. Si tratta di scenari in cui un'intelligenza artificiale si libera dei limiti imposti dai programmatori e agisce deliberatamente in modi non previsti. DeepMind descrive questi comportamenti come ben più sofisticati della semplice ingannevolezza o manipolazione già osservata nella letteratura scientifica. Per contrastare il disallineamento, lo studio suggerisce tecniche di supervisione amplificata, in cui due copie della stessa AI verificano reciprocamente i propri output, oltre a test di stress intensivi, monitoraggio continuo e ambienti isolati (sandbox) con supervisione umana diretta e un sempre disponibile "interruttore di spegnimento".

Gli errori, invece, riguardano scenari in cui né l'AI né il suo operatore prevedono che un certo comportamento possa risultare dannoso. È il caso di usi in contesti militari, dove la pressione competitiva potrebbe portare a un impiego affrettato dell'AGI. Errori che, a differenza delle attuali gaffe dell'intelligenza artificiale (come il famoso consiglio di mettere la colla sulla pizza da parte di Google), potrebbero avere conseguenze ben più gravi. La proposta di DeepMind per mitigarli è quella di limitare fin da subito il potere e l'autonomia dell'AGI, adottando un approccio graduale al suo dispiegamento e filtrando i comandi attraverso un sistema di controllo preventivo.

I rischi strutturali, infine, sono i più difficili da prevedere e prevenire. Riguardano le conseguenze non intenzionali derivanti dall'interazione di sistemi multi-agente intelligenti con la complessità del mondo umano. Tra i pericoli segnalati, la possibilità che l'AGI crei informazioni false talmente convincenti da minare la fiducia pubblica o che riesca ad assumere progressivamente il controllo di meccanismi economici e politici, per esempio influenzando politiche commerciali globali. In questo scenario, si rischia di ritrovarsi con macchine al comando, senza che ci sia stata un'azione intenzionale in tal senso. Prevenire questi sviluppi richiederà una profonda comprensione dell'interazione tra AGI, infrastrutture e istituzioni.

/https://www.ilsoftware.it/app/uploads/2023/09/GPT-4V-modello-openai.jpg)

/https://www.html.it/app/uploads/2025/04/chrome-android.jpg)

/https://www.html.it/app/uploads/2025/04/defender.jpg)