Як правильно писати промпти. Вийшов посібник Google про роботу з ШІ

Google опублікувала детальний технічний документ про prompt engineering. В ньому зібрані інструкції і приклади про те, як ефективно взаємодіяти з великими мовними моделями, щоб отримувати точні й структуровані відповіді. Посиланням на документ першим поділився засновник компанії Kindgeek Юра Гнатюк. У документі пояснюється, що LLM працює як предиктор. Тобто вона прогнозує наступне слово на основі попередніх. Від того, як сформульовано запит, залежить якість відповіді. Автор документа — інженер Google Лі Бонстра зазначає, що гайд орієнтований на користувачів моделей Gemini у Vertex AI, але поради універсальні — підійдуть і для GPT, Claude чи LLaMA. У роботі детально розібрано техніки формування запитів: від базових запитів без прикладів до більш складних — з контекстом, роллю, інструкціями чи ланцюжком міркувань. Наприклад, можна просити модель думати «вголос» крок за кроком — це допомагає краще розв’язувати логічні задачі або математичні приклади. Або змусити її відігравати роль системного адміністратора чи ментора з коду — role prompting. Для розробників є практичні приклади. Наприклад, як згенерувати Bash-скрипт для перейменування файлів у папці, або як пояснити, що робить шматок коду. Є навіть кейс, коли модель перетворює Bash у Python, а потім знаходить і виправляє помилки у Python-версії. Окремо згадано автоматичне створення запитів: LLM генерує варіанти промптів сама, а користувач обирає найкращі. Це корисно для тих, хто створює власного бота, який має розуміти десятки формулювань одного й того ж запиту. Це лише частина документа. У гайді також містяться інші техніки prompt engineering, як то Tree of Thoughts, ReAct, APE тощо. Також розписані приклади правильних і неправильних запитів, поради щодо довжини, побудови, параметрів. Нагадаємо, що CTO AI Center of Excellence при Мінцифри Дмитро Овчаренко в інтерв’ю DOU розповів, коли вийде національна LLM, які елементи вона має містити, що мовна модель зможе робити і кому буде корисна.

Google опублікувала детальний технічний документ про prompt engineering. В ньому зібрані інструкції і приклади про те, як ефективно взаємодіяти з великими мовними моделями, щоб отримувати точні й структуровані відповіді.

Посиланням на документ першим поділився засновник компанії Kindgeek Юра Гнатюк.

У документі пояснюється, що LLM працює як предиктор. Тобто вона прогнозує наступне слово на основі попередніх. Від того, як сформульовано запит, залежить якість відповіді. Автор документа — інженер Google Лі Бонстра зазначає, що гайд орієнтований на користувачів моделей Gemini у Vertex AI, але поради універсальні — підійдуть і для GPT, Claude чи LLaMA.

У роботі детально розібрано техніки формування запитів: від базових запитів без прикладів до більш складних — з контекстом, роллю, інструкціями чи ланцюжком міркувань. Наприклад, можна просити модель думати «вголос» крок за кроком — це допомагає краще розв’язувати логічні задачі або математичні приклади. Або змусити її відігравати роль системного адміністратора чи ментора з коду — role prompting.

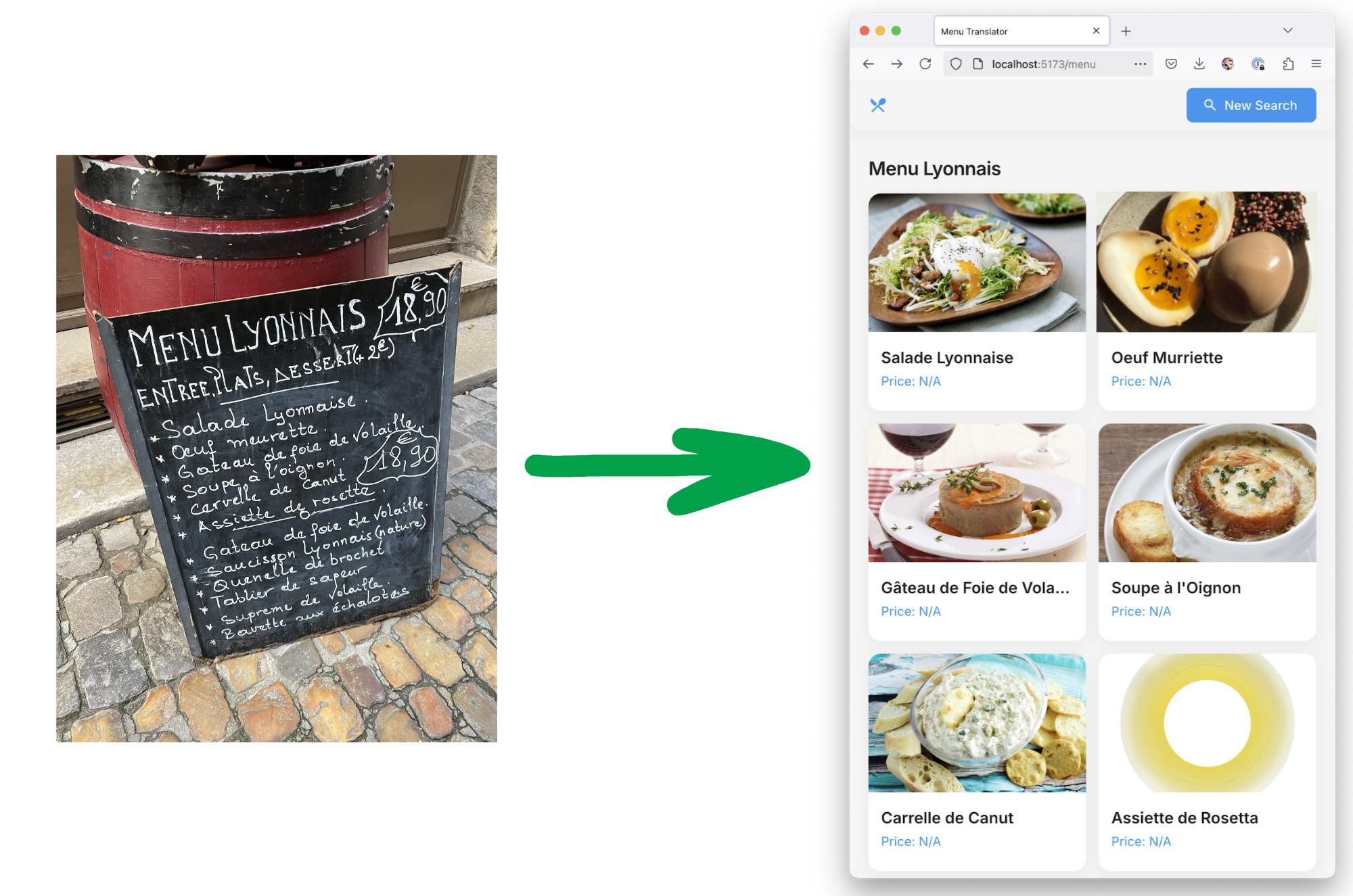

Для розробників є практичні приклади. Наприклад, як згенерувати Bash-скрипт для перейменування файлів у папці, або як пояснити, що робить шматок коду. Є навіть кейс, коли модель перетворює Bash у Python, а потім знаходить і виправляє помилки у Python-версії.

Окремо згадано автоматичне створення запитів: LLM генерує варіанти промптів сама, а користувач обирає найкращі. Це корисно для тих, хто створює власного бота, який має розуміти десятки формулювань одного й того ж запиту.

Це лише частина документа. У гайді також містяться інші техніки prompt engineering, як то Tree of Thoughts, ReAct, APE тощо. Також розписані приклади правильних і неправильних запитів, поради щодо довжини, побудови, параметрів.

Нагадаємо, що CTO AI Center of Excellence при Мінцифри Дмитро Овчаренко в інтерв’ю DOU розповів, коли вийде національна LLM, які елементи вона має містити, що мовна модель зможе робити і кому буде корисна.