Нейросети: дискретность и непрерывность, квантовость и квантовоподобность

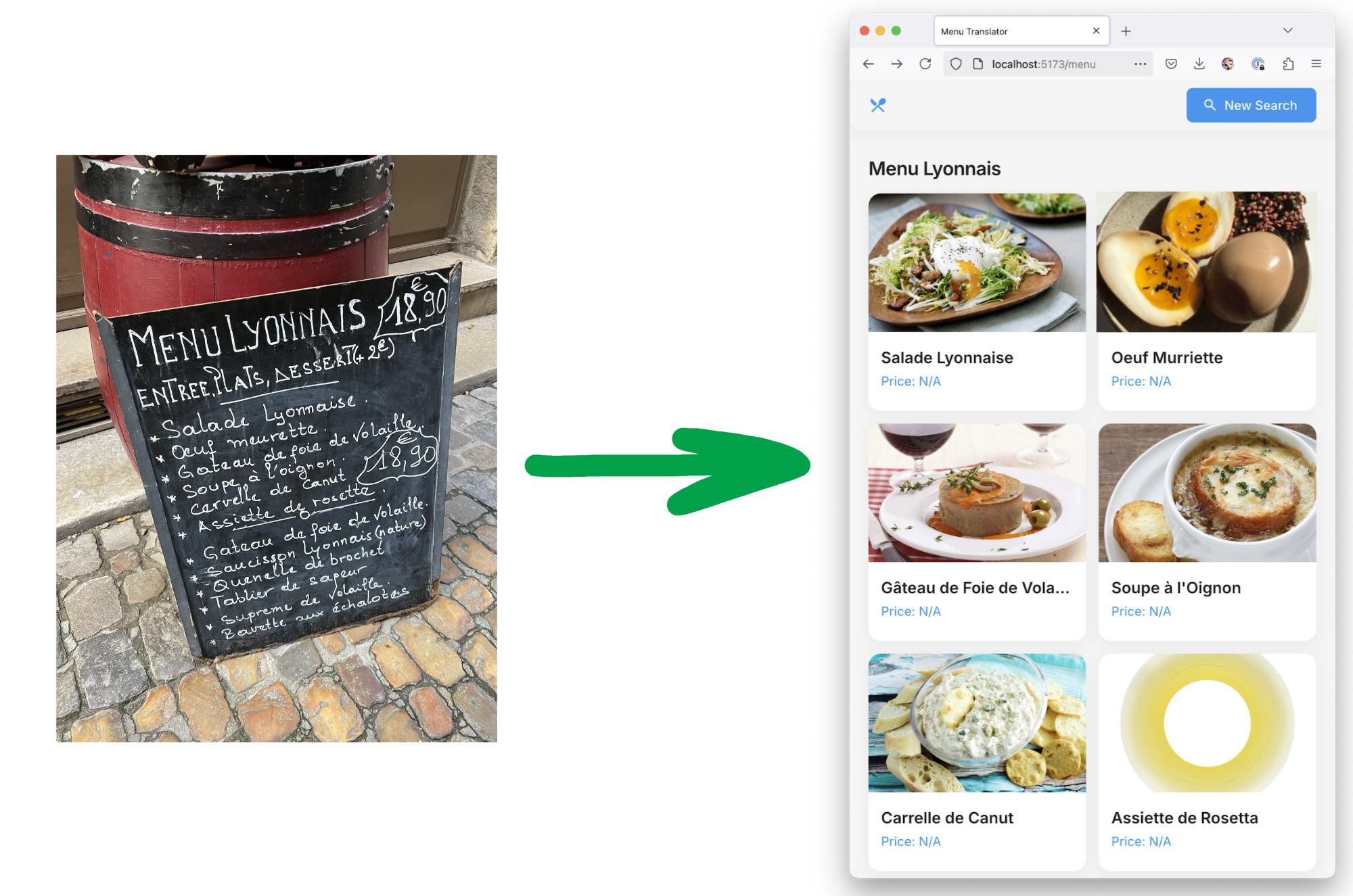

Вот мы тут говорим об эмерджентной квантовости в нейросетях, при этом квантовость подразумевает и квантованность (дискретность), но вышла работа с ровно противоположной направленностью — изучают непрерывность, https://arxiv.org/abs/2504.03933, и это из окружения Michael Wooldridge, который про агентские системы ещё 20 лет назад учебник писал. "Language Models Are Implicitly Continuous" -- Language is typically modelled with discrete sequences. However, the most successful approaches to language modelling, namely neural networks, are continuous and smooth function approximators. In this work, we show that Transformer-based language models implicitly learn to represent sentences as continuous-time functions defined over a continuous input space. This phenomenon occurs in most state-of-the-art Large Language Models (LLMs), including Llama2, Llama3, Phi3, Gemma, Gemma2, and Mistral, and suggests that LLMs reason about language in ways that fundamentally differ from humans. Our work formally extends Transformers to capture the nuances of time and space continuity in both input and output space. Our results challenge the traditional interpretation of how LLMs understand language, with several linguistic and engineering implications. И там weird results (https://x.com/MarroSamuele/status/1909597362302878189):- LLMs have a concept of “a third of an action” or “a fourth of an event”- LLMs can interpolate between Boolean operators, creating weird non-discrete operators- Embedding linearity also works in the output spaceНеудивительно, конечно. Просто в эту сторону размышления шли ещё во времена Software 2.0 (differentiable programming, нейросети тут часть этих "научаемых алгоритмов"), и тогда много интересовались всяким relaxing для дискретных плохо дифференцируемых функций — вот я писал в 2019 "Дифференцируемое всё: от чёрно-белой картины мира к рябенькой", https://ailev.livejournal.com/1464563.html, это было крайне перспективно, нейросети представлялись очень частным видом дифференцируемых программ. Но потом пошли ходы на графовые модели (нейросети, работающие с графами, в том числе графами знаний), распределённые представления дискретности, а токены стали "нашим всем": их превращают в непрерывное представление сетью, а выход наоборот, дискретизуют в токены, а непрерывное представление тоже пытаются квантизовать до 1bit сети, до знаменитых 1.58 бита на вес -- https://arxiv.org/abs/2402.17764. Но там опять DroidSpeak и Coconut говорят про то, что "давайте поработаем с непрерывными представлениями" в латентном пространстве. И тут вот работа про implicit continuous LLM говорит: "гляньте, мы совсем забыли, о чём там разговаривали лет пять назад, но давайте эту непрерывность протянем ещё и на выход, поищем недискретные представления не только на входе, но и на выходе -- все эти трети действий и четверти событий". Ситуация сегодня тличается тем, что пять лет назад разговоров было много, а LLM, где это всё можно померить и обсудить — не было. Вот, померили. Я бы это назвал по аналогии "квантовой гравитацией в нейросетях" (конечно, с кучей оговорок -- ибо физики тут же укажут на неаккуратность в терминологии): одновременно в нейросетях обсуждается и emergent quantumness, и emergent continuousness. При этом чуток различают квантованность и квантовость: -- дискретность, которая именно дискретность. И тут и дискретность "малое число бит", и дискретность символов/токенов по сравнению с непрерывными векторными представлениями в семантическом многомерном пространстве-- квантование -- это вообще про квантование весов на малое число бит представления, но у квантовых физиков -- совсем другое, применение хитрой математики. -- квантованность, которая у физиков иногда про дискретность, а иногда про применение квантования, которое про квантовость на планковских масштабах-- квантовость, которая иногда про физику планковских масштабов, но иногда -- квантовоподобность, то есть описание чего угодно (например, поведения LLM) хитрой математикой, а вовсе не квантовость микромира. -- квантовоподобность как отрыв неклассической хитрой математики вроде квантовой теории поля, всех эти гильбертовых пространств и неколмогоровских вероятностей от описания физического микромира планковских масштабов и приложение к описанию чего угодно: психологии, финансам, строению вселенной на всех масштабах (квантовая гравитация), а в нашем случае -- к описанию того, что происходит в LLM, ибо сегодня в рамках классической математики 18 века с её непрерывными функциями плохо понимается, что там происходит. А тут квантовоподобность, всё квантовано (но это может не означать, что дискретно!). Поэтому признаем, что договориться там всем не будет удаваться ещё долго, ибо "косил косой косой косой", надо каждый раз разбираться, что там за "квантовость" имеется ввиду каждым новым собеседником. Основная фишка в оторванности математики планковских масштабов для описания всего подряд. Примерно так это дают и Хренников, и Ванчурин с Кацнельсоном. Но у Ванчурина с Кацнельсоном

- LLMs have a concept of “a third of an action” or “a fourth of an event”

- LLMs can interpolate between Boolean operators, creating weird non-discrete operators

- Embedding linearity also works in the output space

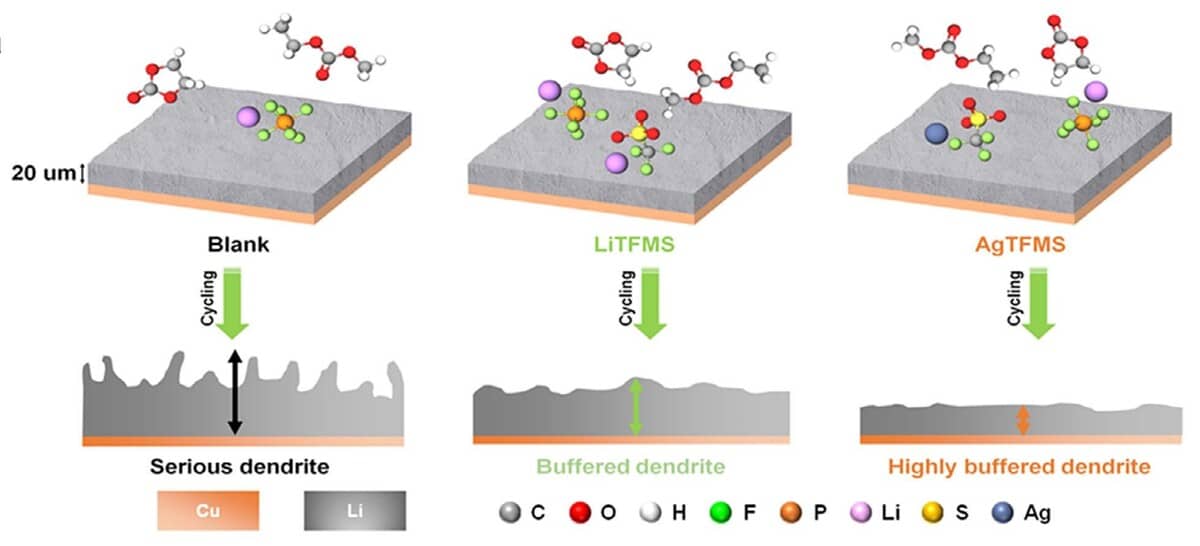

Неудивительно, конечно. Просто в эту сторону размышления шли ещё во времена Software 2.0 (differentiable programming, нейросети тут часть этих "научаемых алгоритмов"), и тогда много интересовались всяким relaxing для дискретных плохо дифференцируемых функций — вот я писал в 2019 "Дифференцируемое всё: от чёрно-белой картины мира к рябенькой", https://ailev.livejournal.com/1464563.html, это было крайне перспективно, нейросети представлялись очень частным видом дифференцируемых программ. Но потом пошли ходы на графовые модели (нейросети, работающие с графами, в том числе графами знаний), распределённые представления дискретности, а токены стали "нашим всем": их превращают в непрерывное представление сетью, а выход наоборот, дискретизуют в токены, а непрерывное представление тоже пытаются квантизовать до 1bit сети, до знаменитых 1.58 бита на вес -- https://arxiv.org/abs/2402.17764.

Но там опять DroidSpeak и Coconut говорят про то, что "давайте поработаем с непрерывными представлениями" в латентном пространстве. И тут вот работа про implicit continuous LLM говорит: "гляньте, мы совсем забыли, о чём там разговаривали лет пять назад, но давайте эту непрерывность протянем ещё и на выход, поищем недискретные представления не только на входе, но и на выходе -- все эти трети действий и четверти событий". Ситуация сегодня тличается тем, что пять лет назад разговоров было много, а LLM, где это всё можно померить и обсудить — не было. Вот, померили.

Я бы это назвал по аналогии "квантовой гравитацией в нейросетях" (конечно, с кучей оговорок -- ибо физики тут же укажут на неаккуратность в терминологии): одновременно в нейросетях обсуждается и emergent quantumness, и emergent continuousness. При этом чуток различают квантованность и квантовость:

-- дискретность, которая именно дискретность. И тут и дискретность "малое число бит", и дискретность символов/токенов по сравнению с непрерывными векторными представлениями в семантическом многомерном пространстве

-- квантование -- это вообще про квантование весов на малое число бит представления, но у квантовых физиков -- совсем другое, применение хитрой математики.

-- квантованность, которая у физиков иногда про дискретность, а иногда про применение квантования, которое про квантовость на планковских масштабах

-- квантовость, которая иногда про физику планковских масштабов, но иногда -- квантовоподобность, то есть описание чего угодно (например, поведения LLM) хитрой математикой, а вовсе не квантовость микромира.

-- квантовоподобность как отрыв неклассической хитрой математики вроде квантовой теории поля, всех эти гильбертовых пространств и неколмогоровских вероятностей от описания физического микромира планковских масштабов и приложение к описанию чего угодно: психологии, финансам, строению вселенной на всех масштабах (квантовая гравитация), а в нашем случае -- к описанию того, что происходит в LLM, ибо сегодня в рамках классической математики 18 века с её непрерывными функциями плохо понимается, что там происходит. А тут квантовоподобность, всё квантовано (но это может не означать, что дискретно!).

Поэтому признаем, что договориться там всем не будет удаваться ещё долго, ибо "косил косой косой косой", надо каждый раз разбираться, что там за "квантовость" имеется ввиду каждым новым собеседником.

Основная фишка в оторванности математики планковских масштабов для описания всего подряд. Примерно так это дают и Хренников, и Ванчурин с Кацнельсоном. Но у Ванчурина с Кацнельсоном тут термином про этот отрыв правильной математики просто quantumness, а у Хренникова про это более аккуратно -- quantum-like. Но и у Хренникова книжка его про quantum-like (квантовоподобность) назвается Ubiquitous quantum structure, а quantum-like закопано внутри книжки. Все эти ходы на то, чтобы применять к нейросетям квантовую математику, оторвав её от планковских масштабов, https://www.sciencedirect.com/science/article/pii/S0303264720301994 и https://arxiv.org/abs/2012.05082 про разное, терминология разная, но суть -- одна "берём современную математику, а не математику 18 века".

Все эти игры с математикой и интерпретациями игрались обычно на полянке квантовой гравитации. И там тоже были игры математики с субстратом:

-- в глубоких нейронных сетях мы можем считать, что нейроны с непрерывными функциями, бесконечноразрядные real. Их математика как раз такая. А потом оказывается, что они на FB16 только если свезло и богатый, а так -- выходят на те самые 1bit реализации, и I4 тут вполне себе "физика нейросети", аппаратура для этой математики. Математика, которая существенно ограничена физикой интерпретатора. Дискретность тут оказывается не только интерфейсной для символьного ввода-вывода для непрерывной обработки, но и реализационной основой, субстратом.

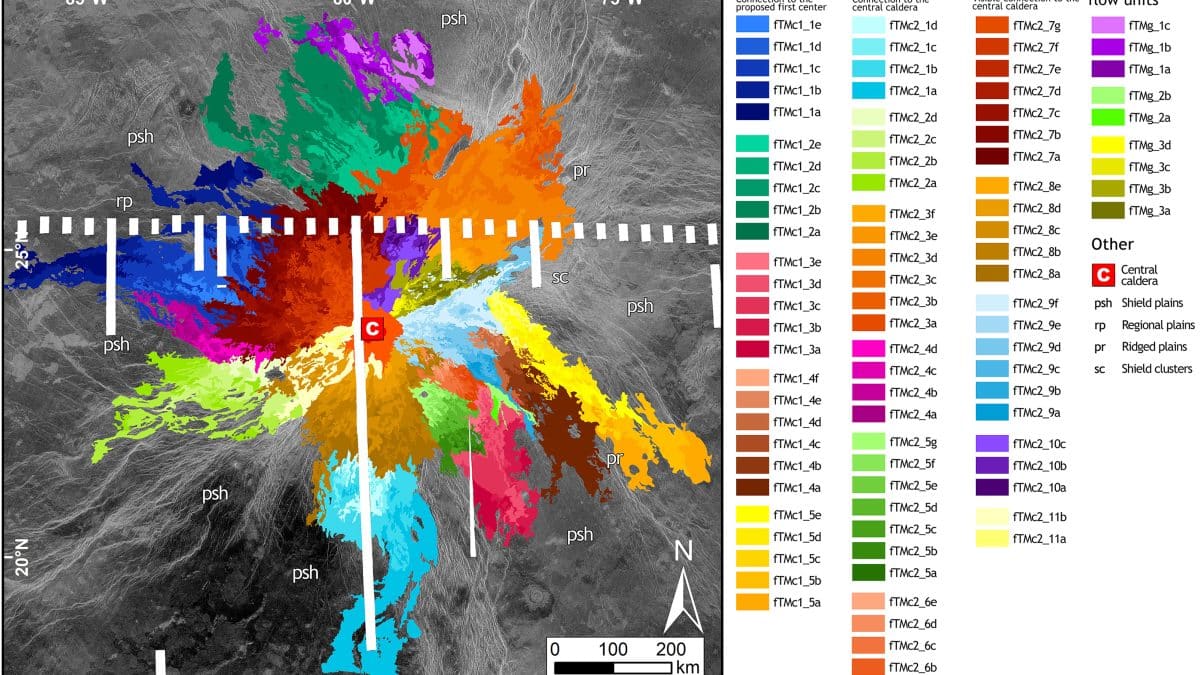

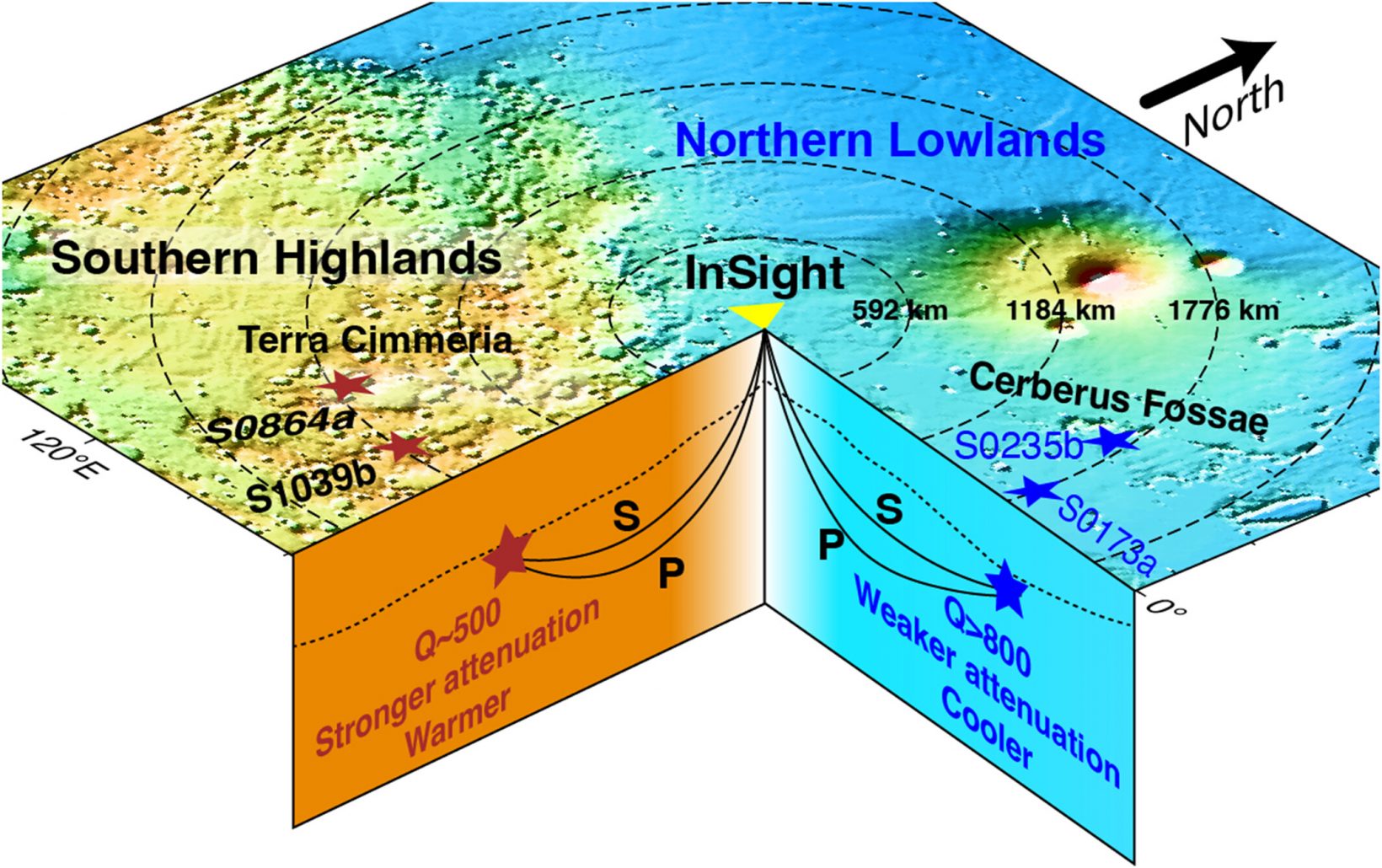

-- в квантовой гравитации всё то же самое: там или пространство-время непрерывно, или таки они дискретны. По слухам (лично не проверял), некоторые теории квантовой гравитации предполагают, что само пространство-время на планковском масштабе может быть фундаментально дискретным. Скажем, петлевая квантовая гравитация (LQG, https://ru.wikipedia.org/wiki/Петлевая_квантовая_гравитация ) с ее дискретными спектрами операторов площади и объема против теории струн, изначально формулируемой на непрерывном фоне. При этом не только операторы площади и объема могут иметь дискретные спектры, но и может быть квантована сама геометрия. Это не просто дискретность значений наблюдаемых в пространстве, а дискретность самого "контейнера" - пространства-времени. Таким образом, дискретность может быть не только свойством спектров операторов, действующих на некотором (возможно, непрерывном) многообразии, но и свойством самой структуры реальности на фундаментальном уровне. И таких теорий некоторое количество, например, https://en.wikipedia.org/wiki/Causal_sets. Если фундаментальные степени свободы самой геометрии (переменные, от которых зависит "волновая функция Вселенной") окажутся дискретными, то это будет иметь гораздо более глубокие последствия для всех интерпретаций квантовой механики. Ах, и тут можно совсем уж спекулятивно ткнуть в https://geometricdeeplearning.com/ -- там ведь геометрические интерпретации для LLM.

И вот тут пошли игры между дискретностью и непрерывностью, обсуждаемые в терминах квантовости или квантовоподобности. В чат приглашается новая математика.

Далее мы можем пообсуждать в том числе и нейроны в чисто спайковой модели (где "да" и "нет"), и даже классический компьютер, который тоже вполне себе имеет дискретную "геометрию" — и поэтому будет описываться как не умеющий работать с полбитом и четвертьбитом.

Но там можно дальше сказать, что на нём можно подобное смоделировать — но для этого запустить какой-нибудь специальный виртуальный мир, где придумать уже любой вариант квантовой механики, хоть классический, хоть неклассический, хоть моделировать прямо квантовый компьютер. И вот тут возникает важная проблема — проблема эффективности, зачем это всё. И мы дальше ищем физический вычислитель, который может это всё виртуальное вычислить реально. И тут опять попадаем в мир квантованности или неквантованности в измерениях и квантовости и неквантовости в алгоритмике, которую делают промеж этих измерений.

Сложно всё, увы. Идея, конечно, в том, чтобы поднять математику с описания чего-то на планковском уровне на уровень описания чего-то другого. И дать интерпретацию, иначе не договоримся — а с интерпретациями в квантовой физике пока (до сих пор) беда, только с вычислениями неплохо. Но я не сторонник лагеря "заткнись и вычисляй".

Мне нравится Эвереттовская интерпретация. Но если оторвать квантовоподобную математику от планковских масштабов (со всеми тамошними проблемами интерпретации) -- какая там могла бы быть интерпретация? С чего бы там интерпретация наладилась для описания явлений на непланковских масштабах? Тут можно даже предположить, что LLM с её одновременными ходами на квантованность и непрерывность -- хорошая игрушечная модель для изучения квантовой гравитации, там ведь требуется объяснить, как квантованность/дискретность на планковских масштабах связана с непрерывностью на масштабах ОТО. Но если взять наоборот, то тоже забавно -- что там будет суперпозицией в LLM? А множество вселенных -- это возможность порождения следующих токенов с какой-то вероятностью? "Возможные виртуальные токенные/символьные миры", забавно, льюисовщина-эверетовщина в нейросетях. А если на выходе не токены, как предложено, а что-то непрерывное, все эти "трети действий" и "четверти событий"?!

Мутно, но интересно. Виртуальная физика нейронных сетей, переходящая в реальную физику (вселенная как нейросеть) -- программа Ванчурина, и наоборот -- реальная физика, через отрыв математики от планковских масштабов превращающаяся в виртуальную физику -- программа Хренникова. Меня давно учили, что между софтом и хардом в компьютерах граница размыта. Получается, что хард тут и будет интерпретацией математики, и математика описанием харда.

Это мной написано по итогам обсуждения в gonzo-обзорах статьи Гуськова и Ванчурина про ковариантный градиентный спуск, трёхдневной давности: https://arxiv.org/abs/2504.05279. A journey from physics to machine learning and back to physics. Along the way, we unified classical algorithms such as SGD, RMSProp, and Adam, developed new algorithms with superior learning efficiency, and identified a mechanism for the emergence of curved geometry. Ванчурин там написал (https://t.me/c/1334131803/54059): "Статья про ковариантный градиентный спуск (CGD) преследовала три основные цели: 1) Показать, как правильно записывать уравнение градиентного спуска — с использованием ковариантных объектов, пригодных для работы в любых системах отсчёта и в пространствах произвольной кривизны. 2) Объединить все основные статистические алгоритмы, основанные на градиентном спуске, и показать, чем они отличаются. Например, сразу становится понятно, почему работает Adam и что в нём можно было бы улучшить. 3) Привести пример простого алгоритма CGD, который работает значительно лучше, чем Adam, а также другого алгоритма, который обобщает и улучшает первый. Также важно отметить, что CGD — это не алгоритм второго порядка, а статистический алгоритм первого порядка, который через статистику узнаёт не только о производных высших порядков (как и другие статистические алгоритмы первого порядка), но и о правильной геометрии — что здесь является ключевым". Это в ответ на то, "а что там такого нового, и чем отличается от алгоритмов второго порядка, которые очень хороши, но слишком вычислительно затратны".

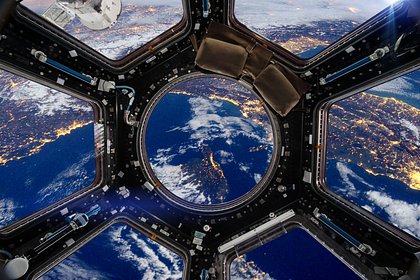

В любом случае: дискретность и непрерывность, квантовость и квантовоподобность -- это всё очень интересно, но пока безрезультатно, увы. Ни о каких SoTA говорить не приходится, никакого выхода в практику. Возможно, пока. Ибо deep learning тоже довольно долго было без выхода в практику, да и с искусственными спутниками Земли тоже не сразу сложилось. В любом случае, разговор не только про квантовые компьютеры, но и про абсолютно неквантовые (но, возможно, квантовоподобно описываемые, и то ли дискретные, то ли непрерывные) нейросети, в том числе современные и грядущие LLM, world models и всякое такое прочее.

Но если нет практических результатов, а теории все сомнительны и явно не мейнстрим, то зачем писал? Ну, считайте это работой онтолога, который предупреждает, что слова "дискретный", "непрерывный", "квант", "квантовость", "квантование", "квантовоподобность" у разных людей могут в разных ситуациях обозначать абсолютно разное -- и договориться в этой предметной области людям будет крайне трудно, ибо там "косил косой косой косой". LLM тоже с таким очень плохо работают, так что вы предупреждены.

Но интересно, очень интересно. Подрывы обычно происходят в самом низу системного стека, а в этом разговоре как раз затрагивается этот низ -- низ масштабов, в том числе и планковских, где "там внизу до чёртиков места" (https://en.wikipedia.org/wiki/There%27s_Plenty_of_Room_at_the_Bottom, и всегда помним о выходе на компьютеры с альтернативной физикой -- квантовые, оптические, мемристорные).