ChatGPT en llamas. Algo que hacemos todos le está costando millones de dólares

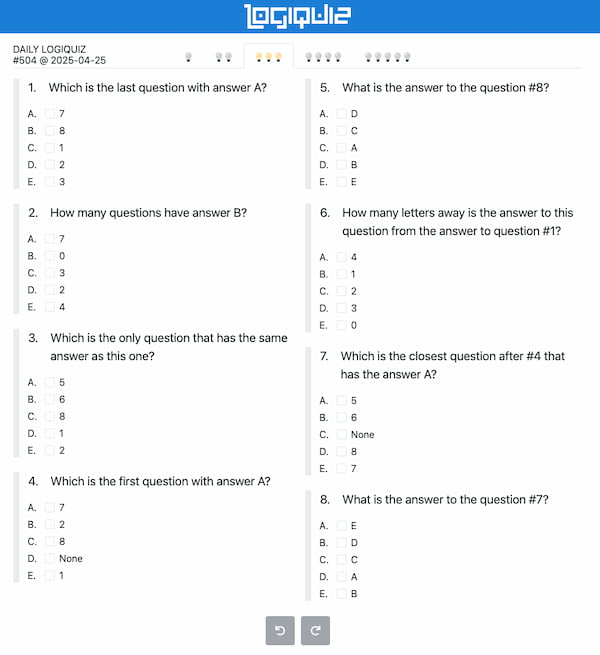

Nuestros modales digitales están generando un problema inesperado para OpenAI. La costumbre de escribir "por favor" y "gracias" al interactuar con ChatGPT representa un coste real para la empresa. Estas expresiones de cortesía cotidianas obligan a los servidores a procesar datos adicionales, aumentando el consumo eléctrico y generando gastos que pocos usuarios conocen.Según Futurism, estos hábitos de educación le cuestan a OpenAI decenas de millones de dólares anuales. Sam Altman, director ejecutivo de la compañía, ha confirmado que estas fórmulas de cortesía incrementan significativamente el número de tokens procesados en cada interacción, multiplicando así el gasto energético en sus instalaciones.La factura oculta de la cortesía digitalCada consulta realizada a ChatGPT requiere diez veces más energía que una búsqueda en Google (2,9 vatios-hora frente a 0,3). Con más de mil millones de consultas diarias, el sistema consume aproximadamente 2,9 millones de kilovatios-hora cada día, equivalente al consumo anual de 800 hogares estadounidenses. Un simple "gracias" añade 0,0002 kWh adicionales por cada interacción.Esta información se revela mientras OpenAI enfrenta críticas por su generador de imágenes y las preocupaciones sobre copyright. La empresa atraviesa múltiples controversias públicas, especialmente tras las declaraciones donde Altman reconoce haber exagerado en su comunicación sobre la IA para captar más atención mediática.Los centros de datos dedicados a la inteligencia artificial ya representan el 2% del consumo eléctrico mundial. Las proyecciones para 2030 indican que podrían alcanzar el 9,1% en Estados Unidos. En términos más concretos, cuando ChatGPT genera un texto de 100 palabras, consume la misma energía que 14 bombillas LED funcionando durante una hora.La controversia se extiende también a otros ámbitos. OpenAI ha manifestado que resulta imposible entrenar sistemas de IA sin utilizar contenidos con copyright, postura que ha provocado demandas de importantes medios como The New York Times, a cuyos argumentos la empresa ha respondido negando parte de las acusaciones.Un estudio reciente reveló que el 67% de usuarios americanos utiliza lenguaje formal con chatbots. Del total, un 55% lo hace por considerarlo "moralmente apropiado", mientras que un 12% teme una futura rebelión de las máquinas y busca ganar su simpatía anticipadamente. Estos datos reflejan nuestra compleja relación con la tecnología.Sherry Turkle, investigadora del MIT, señala que aunque las IA carecen de conciencia, las tratamos como entidades "parcialmente vivas", justificando así nuestro trato respetuoso. Por su parte, Altman ha comentado con ironía que este gasto representa "dinero bien invertido, nunca se sabe", dejando entrever un toque de humor ante esta peculiar situación.Las cifras resultan significativas: un correo electrónico de 100 palabras generado por ChatGPT consume 0,14 kWh, equivalente al gasto de nueve hogares en Washington D.C. durante una hora. Proyectando estos datos, si el 10% de estadounidenses utilizara el servicio semanalmente durante un año, consumirían electricidad equivalente a la de toda Washington D.C. durante 20 días.Las reacciones no se han hecho esperar. Elon Musk ha prohibido el uso de dispositivos Apple en sus empresas si integran tecnología de OpenAI. Mientras tanto, Altman busca soluciones e invierte en proyectos de energía nuclear y solar como Helion Energy y Exowatt, a la vez que optimiza sus infraestructuras para reducir el consumo.El dilema plantea una cuestión fundamental: ¿debemos priorizar la eficiencia energética o mantener las convenciones sociales incluso con máquinas? Encontrar un equilibrio entre cortesía y sostenibilidad podría ser el verdadero desafío en nuestra relación con la inteligencia artificial.El artículo ChatGPT en llamas. Algo que hacemos todos le está costando millones de dólares fue publicado originalmente en Andro4all.

Nuestros modales digitales están generando un problema inesperado para OpenAI. La costumbre de escribir "por favor" y "gracias" al interactuar con ChatGPT representa un coste real para la empresa. Estas expresiones de cortesía cotidianas obligan a los servidores a procesar datos adicionales, aumentando el consumo eléctrico y generando gastos que pocos usuarios conocen.

Según Futurism, estos hábitos de educación le cuestan a OpenAI decenas de millones de dólares anuales. Sam Altman, director ejecutivo de la compañía, ha confirmado que estas fórmulas de cortesía incrementan significativamente el número de tokens procesados en cada interacción, multiplicando así el gasto energético en sus instalaciones.

La factura oculta de la cortesía digital

Cada consulta realizada a ChatGPT requiere diez veces más energía que una búsqueda en Google (2,9 vatios-hora frente a 0,3). Con más de mil millones de consultas diarias, el sistema consume aproximadamente 2,9 millones de kilovatios-hora cada día, equivalente al consumo anual de 800 hogares estadounidenses. Un simple "gracias" añade 0,0002 kWh adicionales por cada interacción.

Esta información se revela mientras OpenAI enfrenta críticas por su generador de imágenes y las preocupaciones sobre copyright. La empresa atraviesa múltiples controversias públicas, especialmente tras las declaraciones donde Altman reconoce haber exagerado en su comunicación sobre la IA para captar más atención mediática.

Los centros de datos dedicados a la inteligencia artificial ya representan el 2% del consumo eléctrico mundial. Las proyecciones para 2030 indican que podrían alcanzar el 9,1% en Estados Unidos. En términos más concretos, cuando ChatGPT genera un texto de 100 palabras, consume la misma energía que 14 bombillas LED funcionando durante una hora.

La controversia se extiende también a otros ámbitos. OpenAI ha manifestado que resulta imposible entrenar sistemas de IA sin utilizar contenidos con copyright, postura que ha provocado demandas de importantes medios como The New York Times, a cuyos argumentos la empresa ha respondido negando parte de las acusaciones.

Un estudio reciente reveló que el 67% de usuarios americanos utiliza lenguaje formal con chatbots. Del total, un 55% lo hace por considerarlo "moralmente apropiado", mientras que un 12% teme una futura rebelión de las máquinas y busca ganar su simpatía anticipadamente. Estos datos reflejan nuestra compleja relación con la tecnología.

Sherry Turkle, investigadora del MIT, señala que aunque las IA carecen de conciencia, las tratamos como entidades "parcialmente vivas", justificando así nuestro trato respetuoso. Por su parte, Altman ha comentado con ironía que este gasto representa "dinero bien invertido, nunca se sabe", dejando entrever un toque de humor ante esta peculiar situación.

Las cifras resultan significativas: un correo electrónico de 100 palabras generado por ChatGPT consume 0,14 kWh, equivalente al gasto de nueve hogares en Washington D.C. durante una hora. Proyectando estos datos, si el 10% de estadounidenses utilizara el servicio semanalmente durante un año, consumirían electricidad equivalente a la de toda Washington D.C. durante 20 días.

Las reacciones no se han hecho esperar. Elon Musk ha prohibido el uso de dispositivos Apple en sus empresas si integran tecnología de OpenAI. Mientras tanto, Altman busca soluciones e invierte en proyectos de energía nuclear y solar como Helion Energy y Exowatt, a la vez que optimiza sus infraestructuras para reducir el consumo.

El dilema plantea una cuestión fundamental: ¿debemos priorizar la eficiencia energética o mantener las convenciones sociales incluso con máquinas? Encontrar un equilibrio entre cortesía y sostenibilidad podría ser el verdadero desafío en nuestra relación con la inteligencia artificial.

El artículo ChatGPT en llamas. Algo que hacemos todos le está costando millones de dólares fue publicado originalmente en Andro4all.