OpenAI riduce i test di sicurezza sui modelli di intelligenza artificiale: cresce la preoccupazione

OpenAI sta riducendo gli sforzi dedicati al controllo e alla valutazione della sicurezza nello sviluppo dei suoi modelli AI.

OpenAI sta riducendo gli sforzi dedicati al controllo e alla valutazione della sicurezza dei suoi prossimi modelli di intelligenza artificiale. È quanto riferisce il Financial Times, citando otto fonti interne all’azienda. Secondo il report, le squadre incaricate internamente di analizzare i potenziali rischi dei nuovi sistemi hanno avuto a disposizione soltanto pochi giorni per svolgere i controlli, una finestra temporale molto più ristretta rispetto agli standard precedenti.

Questa riduzione della durata e della profondità dei test di sicurezza si accompagna a un’associazione preoccupante: meno risorse impiegate, minore attenzione al contenimento dei rischi. Gli insider parlano di un processo che oggi appare “notevolmente meno rigoroso” rispetto al passato. Un segnale che alimenta l’allarme tra gli esperti del settore, in un momento in cui l’intelligenza artificiale continua ad evolversi a una velocità vertiginosa.

OpenAI: la corsa all’AI contro la Cina

OpenAI è prossima al lancio di un nuovo sistema AI, internamente identificato con il nome in codice “o3”, previsto per la prossima settimana. Anche se non è stata annunciata una data ufficiale, la rapidità con cui procede lo sviluppo e la diffusione di questo modello sembra legata all’urgenza di mantenere il primato in un mercato sempre più competitivo.

Tra i concorrenti più dinamici si distinguono attori emergenti provenienti dalla Cina, come DeepSeek, che stanno accelerando i loro programmi di ricerca e sviluppo sui sistemi di intelligenza artificiale generativa. In un contesto di pressione globale crescente, OpenAI appare intenta a privilegiare l’innovazione tecnologica a scapito di controlli approfonditi, alimentando un dibattito sempre più acceso tra sviluppo e sorveglianza etica.

Da addestramento a inferenza: cambiano i rischi

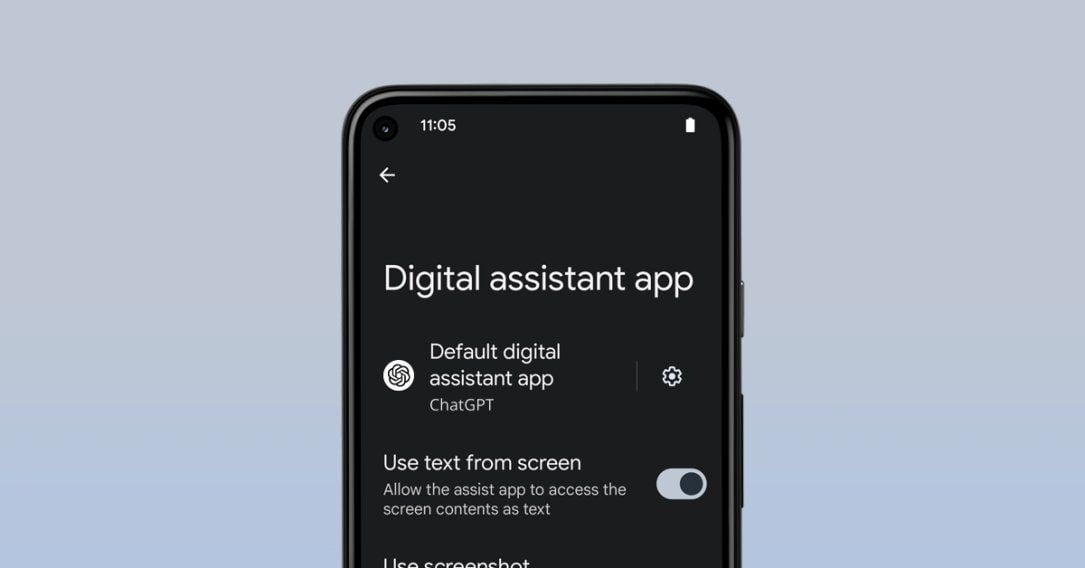

Un ulteriore fattore di complessità riguarda il passaggio dalla fase di addestramento dei modelli, in cui vasti insiemi di dati vengono utilizzati per “insegnare” alle IA come pensare, comprendere e rispondere, a quella di inferenza, dove i modelli sono messi operativamente in funzione per generare contenuti e gestire dati in tempo reale.

Questa fase operativa introduce una nuova serie di rischi: comportamenti imprevisti, dall’imprecisione nelle risposte fino a veri e propri abusi tecnologici su larga scala. In mancanza di test adeguati, questi potenziali pericoli possono emergere direttamente nell’interazione con gli utenti, senza essere intercettati in ambienti sicuri e controllati.

Fiducia degli investitori, nonostante i dubbi

Malgrado le preoccupazioni interne e i timori sollevati dall’ambiente dell’intelligenza artificiale, la fiducia degli investitori nei confronti di OpenAI non sembra aver vacillato. All’inizio di aprile, l’azienda ha chiuso un nuovo round di finanziamento da 40 miliardi di dollari, guidato dal colosso giapponese SoftBank, portando la valutazione complessiva della società a 300 miliardi di dollari.

Questo risultato testimonia quanto il settore dell’AI continui ad attrarre capitali su scala globale. Investitori e aziende scommettono sull’innovazione, anche a fronte di un indebolimento dei protocolli di sicurezza. Tuttavia, l’abbandono progressivo di strutture di verifica solide potrebbe rappresentare, nel medio-lungo periodo, un boomerang in termini di credibilità e stabilità tecnologica.

Equilibrio tra innovazione e responsabilità

Le notizie emerse evidenziano una tensione crescente che attraversa l’intero comparto dell’intelligenza artificiale: l’urgenza di produrre soluzioni sempre più avanzate si scontra con la necessità di presidiare le implicazioni etiche e i rischi sistemici. La riduzione delle risorse volte alla supervisione di sicurezza solleva interrogativi fondamentali: fino a dove si può spingere il progresso in assenza di regole chiare ed efficaci?

Al momento, OpenAI non ha pubblicamente commentato né smentito quanto riportato dal Financial Times. Ma questo silenzio, in un momento di evidente cambiamento strategico, non fa che alimentare l’incertezza su come l’azienda intenda gestire il delicato bilanciamento tra responsabilità e competitività.

L’industria dell’AI in bilico

L’evoluzione dell’intelligenza artificiale si gioca oggi su più fronti simultanei: sviluppo tecnologico, etica, sicurezza e competitività economica. OpenAI, come uno degli attori principali del settore, si trova al centro di queste dinamiche, e le decisioni prese oggi avranno impatti determinanti su come l’IA verrà integrata nella nostra quotidianità in futuro.

Se da un lato la velocità con cui i nuovi modelli vengono sviluppati può apparire entusiasmante, dall’altro emergono crescenti preoccupazioni verso le modalità con cui questi modelli vengono valutati e messi in circolazione. La posta in gioco non è soltanto tecnologica, ma riguarda l’intero equilibrio tra progresso e responsabilità collettiva.

La comunità scientifica e il pubblico globale si aspettano risposte chiare: la domanda non è solo “Cosa può fare l’intelligenza artificiale?”, ma soprattutto “Come possiamo assicurarci che lo faccia in modo sicuro, trasparente e benefico per la società?”.

/https://www.ilsoftware.it/app/uploads/2025/02/NVIDIA.jpg)

/https://www.html.it/app/uploads/2025/04/netflix.jpg)