El modelo open source de DeepSeek le habla 'de tú a tú' a los grandes de la IA: están 'haciendo magia' a la hora de mejorarlo

La carrera por la supremacía en la inteligencia artificial tiene un renovado contrincante que ha llegado para alterar por completo el ranking que teníamos hasta ahora con las diferentes IA. DeepSeek ha presentado el modelo R1 0528, una actualización (no un nuevo modelo) que se ha situado como líder indiscutible entre los modelos de IA de código abierto. Pero no se ha quedado ahí: también ha logrado el segundo puesto mundial en el prestigioso Artificial Analysis Intelligence Index. De esta manera, se sitúa codo a codo con Gemini 2.5 Pro de Google y supera a otros modelos de gran relevancia como Grok 3 mini, Llama 4 Maverick o Anthropic con Claude 4. El salto que ha dado DeepSeek R1 0528 ha sido muy notable en el ranking: ha pasado de tener 60 puntos en el índice hasta los 68. Como decimos, esto lo coloca por delante de Grok 3 mini (67 puntos), Llama Nemotron Ultra de NVIDIA (61 puntos) y Llama 4 Maverick de Meta (51 puntos). La clave del éxito ha sido el poder post-entrenamiento Pero lo verdaderamente llamativo de este sorpasso es que esta mejora se ha logrado a través de una actualización post-entrenamiento. Es decir, no han tenido que modificar la arquitectura base del modelo, algo a lo que estamos acostumbrados con muchas otras empresas que van sacando nuevos modelos para superar al anterior. Actualmente, DeepSeek R1-0528 sigue siendo un modelo de 671 mil millones de parámetros que se basa en la arquitectura V3/R1. De esta manera, se ha demostrado la creciente importancia de las técnicas de post-entrenamiento y, sobre todo, del aprendizaje por refuerzo (RL). DeepSeek ha demostrado que puede tener un modelo potente y económico (algo que ya causó cierta caída en las acciones de Nvidia), y ahora, además, no necesita gastar grandes sumas de dinero en un reentrenamiento desde cero ni en cambios arquitectónicos costosos. Ha conseguido obtener mejoras sustanciales (tanto como para codearse con Gemini 2.5 Pro). Estos avances en el aprendizaje por refuerzo son una gran noticia para todos los laboratorios que tienen una capacidad de GPU mucho más limitada. En Genbeta Si la pregunta es qué distribución Linux instalar para seguir usando tu PC tras el adiós de Windows 10, hay más y mejores respuestas que nunca Los resultados de este sistema de entrenamiento hablan por sí solos: el modelo ha mejorado en diversas áreas, como por ejemplo AIME 2024 (con 21 puntos más en matemáticas de competición), LiveCodeBench (con 15 puntos más), o el Humanity's Last Exam (con seis puntos más en razonamiento y conocimiento). De esta manera, este avance de DeepSeek tiene importantes implicaciones en su competencia. La reducción de la brecha entre modelos abiertos y cerrados es cada vez más evidente, dejando a los grandes modelos en una posición incómoda. Además, el hecho de que sea posible realizar mejoras sustanciales mediante post-entrenamiento abre nuevas vías para perfeccionar los modelos de IA de forma eficiente. Lo que está claro es que este desarrollo va a tener un fuerte impacto en la competitividad global. Mientras Estados Unidos se mantenía como el líder indiscutible en IA, China ha comenzado a posicionarse como un actor muy fuerte con este tipo de avances. Imágenes | Solen Feyissa En Genbeta | Llevo décadas usando ALT + Tab en Windows. Y acabo de aprender que lo estaba usando mal: es más cómodo de lo que creía - La noticia El modelo open source de DeepSeek le habla 'de tú a tú' a los grandes de la IA: están 'haciendo magia' a la hora de mejorarlo fue publicada originalmente en Genbeta por José Alberto Lizana .

La carrera por la supremacía en la inteligencia artificial tiene un renovado contrincante que ha llegado para alterar por completo el ranking que teníamos hasta ahora con las diferentes IA. DeepSeek ha presentado el modelo R1 0528, una actualización (no un nuevo modelo) que se ha situado como líder indiscutible entre los modelos de IA de código abierto.

Pero no se ha quedado ahí: también ha logrado el segundo puesto mundial en el prestigioso Artificial Analysis Intelligence Index. De esta manera, se sitúa codo a codo con Gemini 2.5 Pro de Google y supera a otros modelos de gran relevancia como Grok 3 mini, Llama 4 Maverick o Anthropic con Claude 4.

El salto que ha dado DeepSeek R1 0528 ha sido muy notable en el ranking: ha pasado de tener 60 puntos en el índice hasta los 68. Como decimos, esto lo coloca por delante de Grok 3 mini (67 puntos), Llama Nemotron Ultra de NVIDIA (61 puntos) y Llama 4 Maverick de Meta (51 puntos).

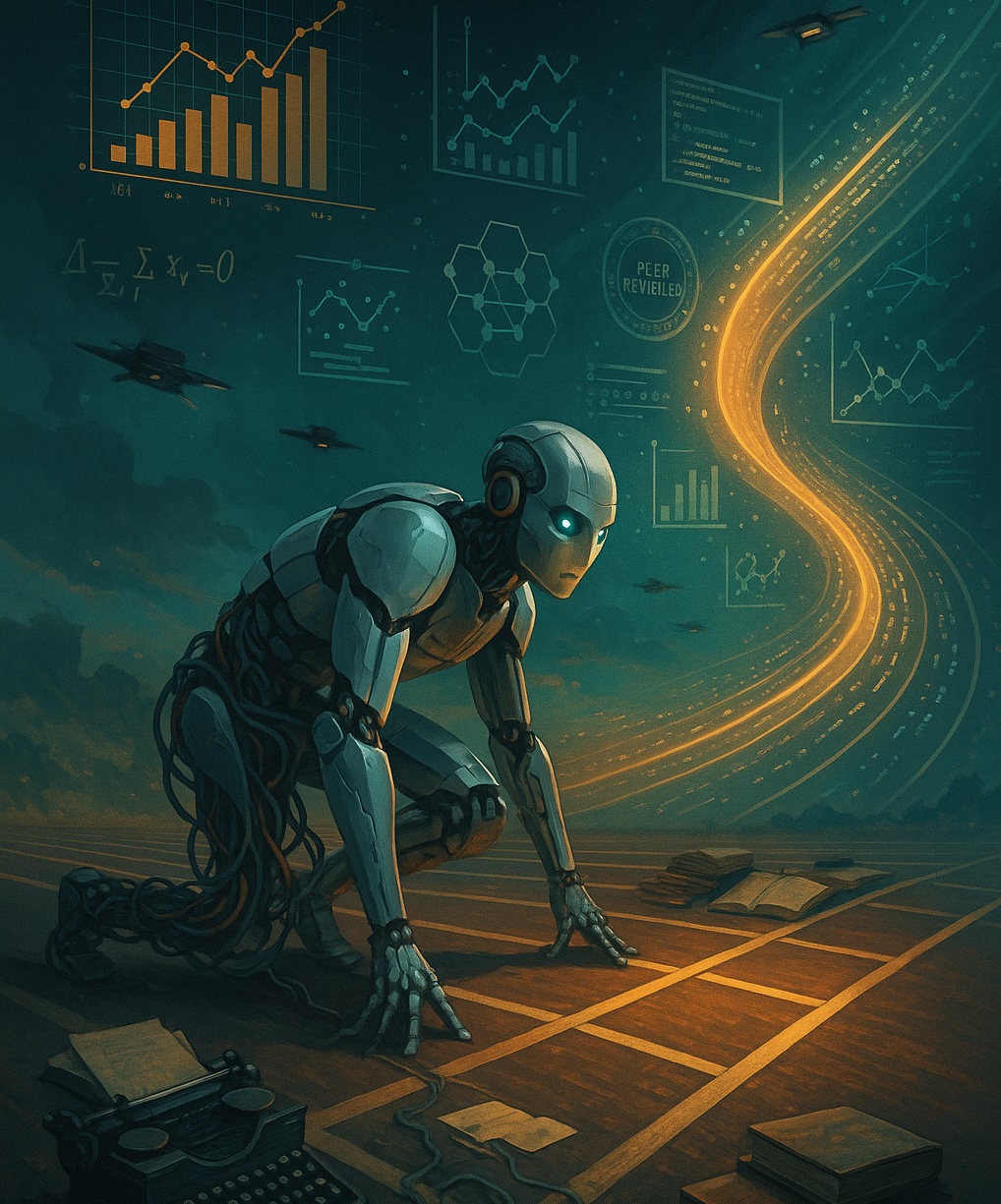

La clave del éxito ha sido el poder post-entrenamiento

Pero lo verdaderamente llamativo de este sorpasso es que esta mejora se ha logrado a través de una actualización post-entrenamiento. Es decir, no han tenido que modificar la arquitectura base del modelo, algo a lo que estamos acostumbrados con muchas otras empresas que van sacando nuevos modelos para superar al anterior.

Actualmente, DeepSeek R1-0528 sigue siendo un modelo de 671 mil millones de parámetros que se basa en la arquitectura V3/R1. De esta manera, se ha demostrado la creciente importancia de las técnicas de post-entrenamiento y, sobre todo, del aprendizaje por refuerzo (RL).

DeepSeek ha demostrado que puede tener un modelo potente y económico (algo que ya causó cierta caída en las acciones de Nvidia), y ahora, además, no necesita gastar grandes sumas de dinero en un reentrenamiento desde cero ni en cambios arquitectónicos costosos. Ha conseguido obtener mejoras sustanciales (tanto como para codearse con Gemini 2.5 Pro).

Estos avances en el aprendizaje por refuerzo son una gran noticia para todos los laboratorios que tienen una capacidad de GPU mucho más limitada.

Los resultados de este sistema de entrenamiento hablan por sí solos: el modelo ha mejorado en diversas áreas, como por ejemplo AIME 2024 (con 21 puntos más en matemáticas de competición), LiveCodeBench (con 15 puntos más), o el Humanity's Last Exam (con seis puntos más en razonamiento y conocimiento).

De esta manera, este avance de DeepSeek tiene importantes implicaciones en su competencia. La reducción de la brecha entre modelos abiertos y cerrados es cada vez más evidente, dejando a los grandes modelos en una posición incómoda. Además, el hecho de que sea posible realizar mejoras sustanciales mediante post-entrenamiento abre nuevas vías para perfeccionar los modelos de IA de forma eficiente.

Lo que está claro es que este desarrollo va a tener un fuerte impacto en la competitividad global. Mientras Estados Unidos se mantenía como el líder indiscutible en IA, China ha comenzado a posicionarse como un actor muy fuerte con este tipo de avances.

Imágenes | Solen Feyissa

-

La noticia

El modelo open source de DeepSeek le habla 'de tú a tú' a los grandes de la IA: están 'haciendo magia' a la hora de mejorarlo

fue publicada originalmente en

Genbeta

por

José Alberto Lizana

.