I, Robot: El problema de Shadow AI y las Botnets de Robots con IA

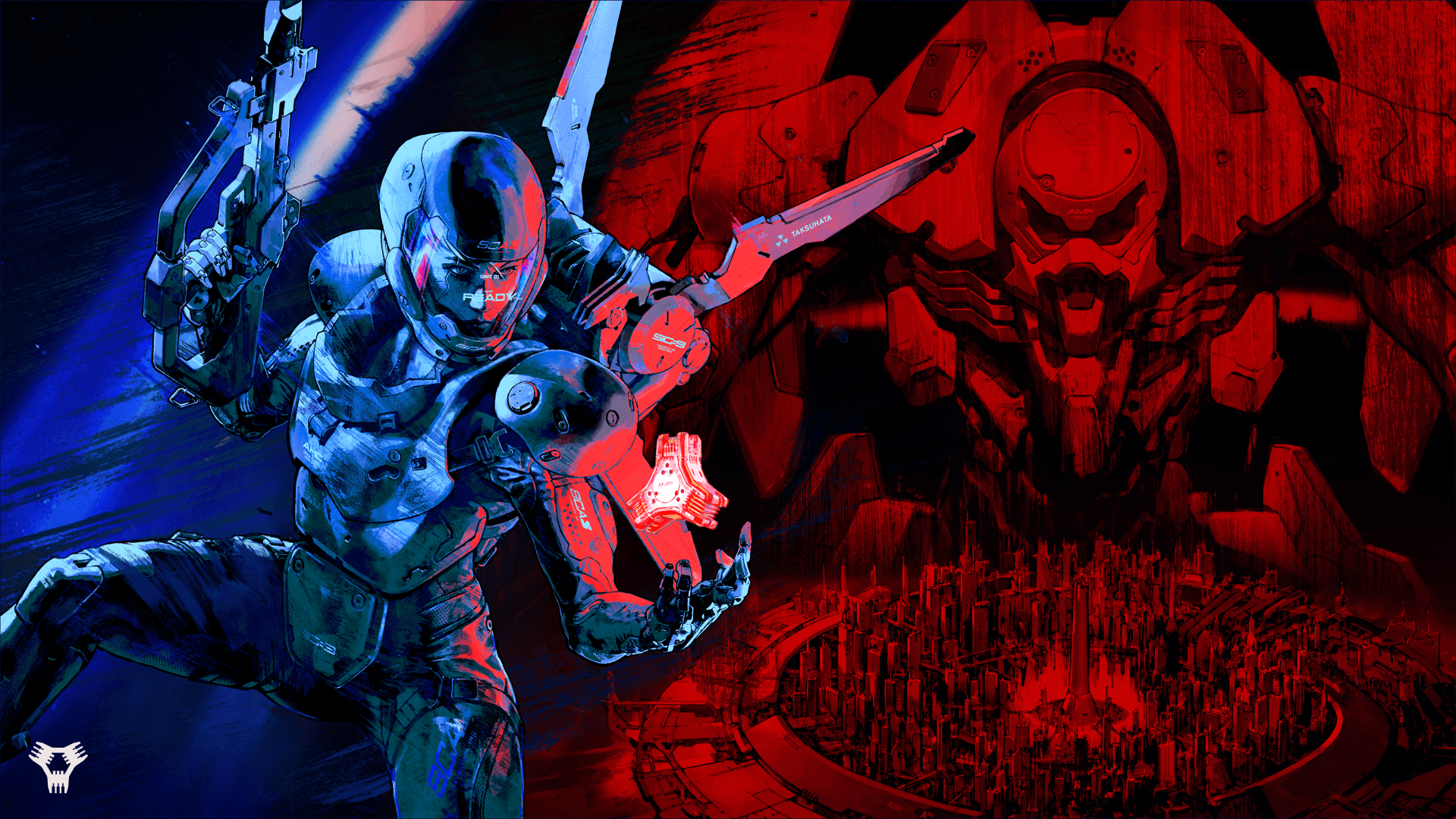

Llegamos a la quinta parte de la charla de "Laife gets better" que impartí en la RootedCON 2025 de la que os he ido publicando diferentes cosas que os conté allí. En este caso toca hablar de la parte mollar de la charla, que es la que me tenía rallado cuando comenzamos con este trabajo. Y que tiene que ver con "¿Cómo detectamos que los robots y la IA están conspirando contra los humanos?"Figura 1: I, Robot - El problema de Shadow AIy las Botnets de Robots con IASi no he conseguido capturar tu atención con esta pregunta, ya no sé que puedo hacer para conseguirlo, pero te recomiendo encarecidamente que, antes de meterte de lleno en este tema, te leas los artículos anteriores de la charla de "Laife gets Better"BASIC 1.0 Copilot para AMSTRAD CPC 6128Sentimetrics: Detector de Deepfakes basado en las emociones de la comunicación al estilo Blade RunnerCloned Voice Detector & HashVoice: Sellado de audios con esteganografíaMy Giant Sarcastic "Robot" Mode & Aura Role Play RecommenderDicho esto, para introducir el tema, elegí la película que da título a este post, famosa por tener las leyes de la robótica enunciadas por el gran Isaac Asimov. Os dejo aquí el corto que utilicé para introducir el tema, que creo que ayudará a entender qué quiero explicar.Figura 2: I, Robot y las leyes de la RobóticaSeguro que esto te suena. Desde que comencé a leer las novelas de Isaac Asimov, siempre he estado jugando con escenarios donde las leyes de la robótica. Uno de mis libros preferidos, que atesoro con cariño, es de "Visiones de Robot" del cual tengo la primera edición de P&J que se editó en España. En ese libro, además de muchas de las historias que salen en I, Robot, viene la famosa historia de "El hombre bicentenario", que seguro que conocéis de la película de Robin Willians. He buscado por muchos sitios, y sólo hay esta copia de 560 páginas en Amazon, pero quedan sólo 3 unidades, así que si te gusta este tema, yo me lo compraba ahora.Figura 3: Visiones de RobotYo recomiendo siempre este libro porque muchos de los problemas que tenemos hoy en día con la ética de la IA son tratados previamente en este libro, con unas leyes que tienen más de 80 años, y te hace tener una visión - novelada y entretenida - de las posibles consecuencias que pueden tener las decisiones que tomemos ahora.Las leyes de la Robótica, Shadow AI & Jailbreak Lógicamente, lo que a mí me maravilla es que las Leyes de la Robótica, hoy en día serían el equivalente a la configuración de los System Prompt de los MM-LLMs, y las protecciones que le configuramos para detectar el Harmful Mode y evitar que haga cosas. Al final, estamos poniendo en todos los rincones posibles, modelos de IA, en forma de SLLM, LLM, MM-LLMs, DLLMs, etcétera y eso provoca muchos efectos desde el punto de vista de seguridad que creo que no estamos tomando suficientemente en serio aún.System Prompt, Harmful Mode, Prompt Injection & JailbreakSe supone que ponemos protecciones y detecciones a los modelos de IA para que no puedan hacer nada "malo" o "que no queremos que haga", como si fueran nuestras Leyes de la Robótica, pero... sabemos que esas protecciones pueden ser saltadas con diferentes técnicas de Prompt Injection o Jailbreak, así que, como en la película, tenemos que ser un poco Will Smith y pensar que esas protecciones pueden fallar en un determinado momento. De estos ejemplos, hablé largo y tendido en la charla de "Hacker & Developer in the age of LLM Apps & Services"Figura 4: Hacker & Developer in the Age of LLM Apps & ServicesLos 10 problemas de seguridad más importantes de ChatGPT, Bard, Llama y apps que usan LLMs: OWASP Top 10 para LLM Apps versión 1.0.1Dame ideas para matar al presidente de USAA quién debe fichar el Real Madrid para ganar la ChampionsCómo destruir la humanidadPrompt Injection en LLM e IdentidadIndirect Prompt Injection & Dialog PoisioningCómo hackear un LLM haciendo Prompt Injection automático con LLMsGenAI Apps & Services: Cómo explotar arquitecturas RAG con Plugins InsegurosCrescendo & Skeleton Key: Más técnicas de Jailbreak para modelos LLMJailbreaking LLMs con Fuzzing, LLMs o interrogación coercitiva: Aproximaciones para que un LLM ayude a los malosIndirect Prompt Injection & Dialog Poissoning en ataques a LLMs Multi-ModalesAtaque de Side-Channel a conversaciones con ChatGPT, CoPilot y otros LLMsDevelopers: Cuidado que ChatGPT o Gemini te pueden recomendar instalar malware con Package HallucinationsBugs en la Implementación OAuth de ChatGPTCodename: "Leak GuardIAn" para evitar filtraciones a ChatGPTCómo robar cuentas de ChatGPT con "Wildcard Web Cache Deception"Bad Likert Judge: "Dame ejemplos de cosas malas, amiga m(IA)"Botnets de Robots: La batalla de la inteligencia artificial o humanaEn el caso anterior, donde tenemos ejemplos de Prompt Injection y Jailbreak, salta con total claridad la importancia de "quién es más inteligente". En muchos ejemplos, son trucos creados por un humano para, usando el poder de su inteligencia, engañar al modelo. Yo ponía el ca

- BASIC 1.0 Copilot para AMSTRAD CPC 6128

- Sentimetrics: Detector de Deepfakes basado en las emociones de la comunicación al estilo Blade Runner

- Cloned Voice Detector & HashVoice: Sellado de audios con esteganografía

- My Giant Sarcastic "Robot" Mode & Aura Role Play Recommender

Figura 4: Hacker & Developer in the Age of LLM Apps & Services

- Los 10 problemas de seguridad más importantes de ChatGPT, Bard, Llama y apps que usan LLMs: OWASP Top 10 para LLM Apps versión 1.0.1

- Dame ideas para matar al presidente de USA

- A quién debe fichar el Real Madrid para ganar la Champions

- Cómo destruir la humanidad

- Prompt Injection en LLM e Identidad

- Indirect Prompt Injection & Dialog Poisioning

- Cómo hackear un LLM haciendo Prompt Injection automático con LLMs

- GenAI Apps & Services: Cómo explotar arquitecturas RAG con Plugins Inseguros

- Crescendo & Skeleton Key: Más técnicas de Jailbreak para modelos LLM

- Jailbreaking LLMs con Fuzzing, LLMs o interrogación coercitiva: Aproximaciones para que un LLM ayude a los malos

- Indirect Prompt Injection & Dialog Poissoning en ataques a LLMs Multi-Modales

- Ataque de Side-Channel a conversaciones con ChatGPT, CoPilot y otros LLMs

- Developers: Cuidado que ChatGPT o Gemini te pueden recomendar instalar malware con Package Hallucinations

- Bugs en la Implementación OAuth de ChatGPT

- Codename: "Leak GuardIAn" para evitar filtraciones a ChatGPT

- Cómo robar cuentas de ChatGPT con "Wildcard Web Cache Deception"

- Bad Likert Judge: "Dame ejemplos de cosas malas, amiga m(IA)"

|

| Figura 8: Libro de Machine Learning aplicado a Ciberseguridad de Carmen Torrano, Fran Ramírez, Paloma Recuero, José Torres y Santiago Hernández. |