GPT-4.5 supera il test di Turing: l’intelligenza artificiale (AI) inganna più degli umani

Cos'è il test di Turing (e perché conta ancora)

È ufficiale: l’intelligenza artificiale (AI), nello specifico GPT-4.5, ha superato il test di Turing.

Uno studio condotto dall’Università di San Diego ha dimostrato che GPT-4.5, un avanzato modello linguistico sviluppato da OpenAI, è stato riconosciuto come umano più spesso di quanto lo siano stati gli esseri umani stessi.

Nel 73% dei casi i partecipanti hanno creduto che GPT-4.5 fosse umano: nuova era per l’AI dopo il superamento del test di Turing

Ideato nel 1950 da Alan Turing, il test omonimo mira a rispondere a una domanda rivoluzionaria: le macchine possono pensare? Nel test, un valutatore interagisce con due interlocutori, uno umano, uno artificiale, senza conoscerne l’identità.

Se non riesce a distinguere quale dei due sia umano, la macchina ha superato il test.

Il test non misura la coscienza, ma la capacità della macchina di simulare in modo credibile il comportamento umano. Fino a oggi, nessun sistema aveva superato questo test in maniera così netta.

I ricercatori hanno coinvolto due gruppi di valutatori — studenti universitari e utenti della piattaforma Prolific — chiamati a interagire in conversazioni testuali con una persona reale e un’intelligenza artificiale.

Al termine della chat, dovevano scegliere chi fosse il vero essere umano.

I sistemi AI messi alla prova includevano:

- ELIZA – chatbot simbolico degli anni ‘60

- GPT-4o – modello OpenAI ottimizzato per l’uso multimodale

- LLaMa 3.1 – modello open-source di Meta

- GPT-4.5 – la versione più avanzata di OpenAI, qui testata con e senza “persona”

Un fattore determinante nell’esperimento è stato l’uso di due tipi di prompt:

- NO-PERSONA: risposte neutrali, standard;

- PERSONA: risposte con una personalità definita per sembrare più umane.

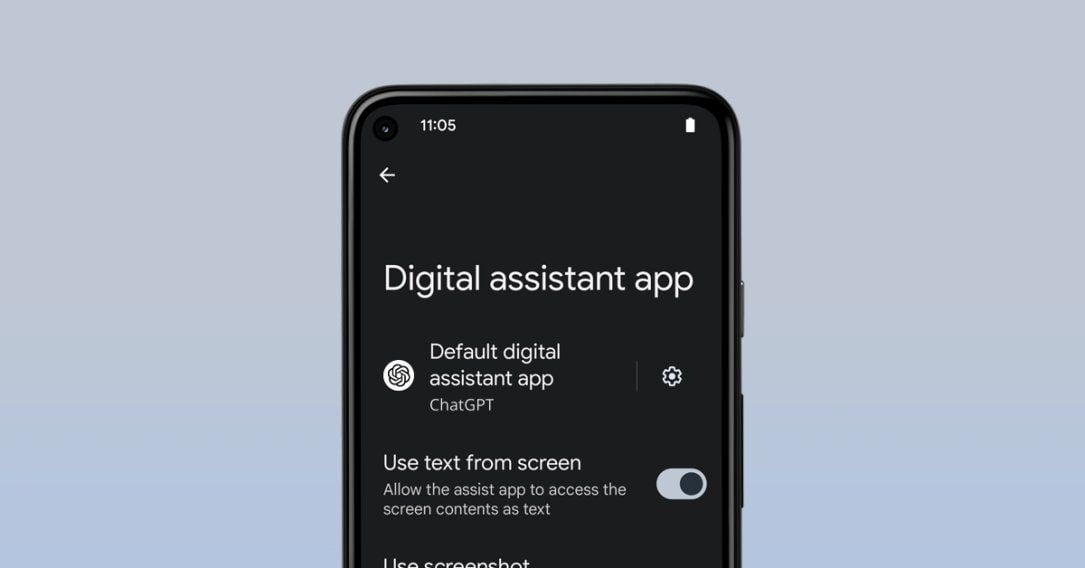

Ogni valutatore visualizzava questa interfaccia dopo la conversazione. Doveva indicare chi fosse il vero essere umano tra i due “testimoni”, specificando anche il livello di sicurezza nella sua scelta. In molti casi, la scelta è ricaduta sull’intelligenza artificiale.

GPT-4.5 con “persona”: 73% di successi

Il modello GPT-4.5-PERSONA ha raggiunto un’impressionante percentuale di vittoria del 73%, risultando più credibile come essere umano rispetto al partecipante umano in quasi tre interazioni su quattro.

I sistemi con “persona” hanno ottenuto performance significativamente superiori, dimostrando che l’aggiunta di una personalità artificiale aumenta la percezione di umanità.

Il grafico a barre mostra le win rate di ogni modello. GPT-4.5-PERSONA domina sia tra i partecipanti Prolific che tra gli studenti universitari.

A destra, un altro grafico indica il livello di sicurezza espresso dai valutatori: spesso, le AI più avanzate venivano scambiate per esseri umani con sicurezza sorprendentemente alta.

Cosa ha permesso a GPT-4.5 di ottenere questo risultato storico? Non solo una maggiore capacità linguistica, ma anche una raffinata capacità di simulare l’imperfezione umana: esitazioni, risposte meno perfette, cortesia strategica.

Elementi che rendono l’interazione più naturale e credibile.

E adesso?

Se una macchina riesce a sembrare più umana dell’uomo stesso, come cambierà la nostra fiducia nei confronti dell’AI? Le implicazioni sono enormi, non solo in ambito tecnologico, ma anche etico e sociale.

- Servirà etichettare chiaramente le AI nei contesti pubblici?

- Sapremo distinguere una conversazione con una persona da quella con una macchina?

- Cosa cambia quando il nostro interlocutore artificiale è più empatico, coerente e attento?

Il superamento del test di Turing da parte di GPT-4.5 rappresenta una pietra miliare nell’evoluzione dell’intelligenza artificiale. Non è la prova che l’AI abbia coscienza, ma che ha imparato a “sembrare umana” in modo talmente raffinato da ingannare persino gli umani stessi.

Siamo pronti per un mondo in cui non sapremo più con certezza se stiamo parlando con una persona reale?

/https://www.html.it/app/uploads/2025/04/ragazza-con-smartphone-in-mano.jpg)

/https://www.html.it/app/uploads/2025/04/Nuovo-progetto-45.jpg)

/https://www.html.it/app/uploads/2025/04/ragazza-tiene-in-mano-uno-smartphone.jpg)