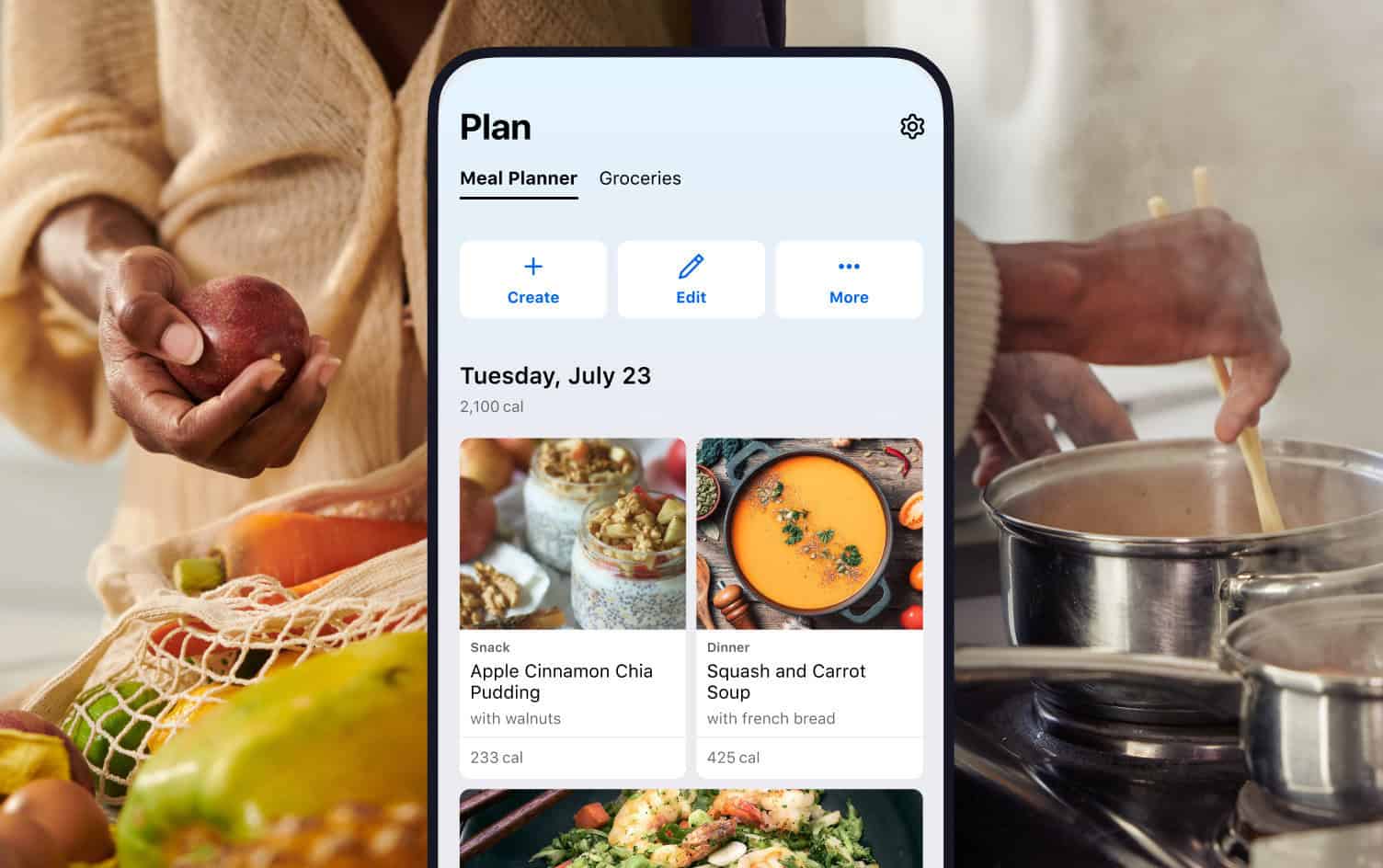

OpenAI GPT o3 e o4-mini: i modelli avanzati di OpenAI poco affidabili?

I nuovi modelli di OpenAI, GPT o3 e o4-mini, mostrano alti tassi di allucinazione, creando dubbi su affidabilità AI in contesti critici.

/https://www.ilsoftware.it/app/uploads/2024/09/ragionamento-intelligenza-artificiale-open-source.jpg)

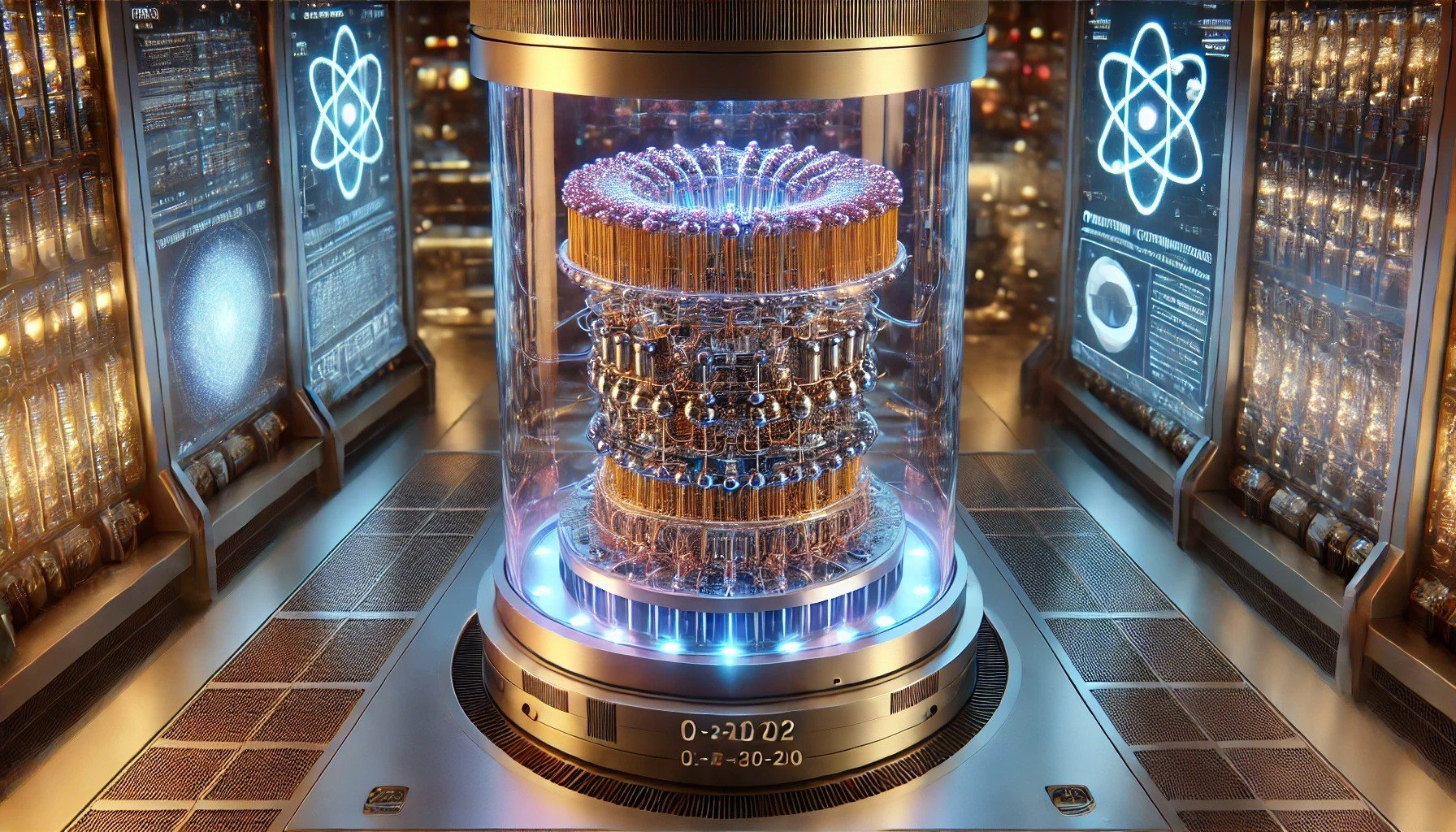

Gli ultimi sviluppi dei modelli di Intelligenza Artificiale di OpenAI, come GPT o3 e o4-mini, hanno suscitato un acceso dibattito per quanto concerne il fenomeno delle allucinazioni. Sebbene rappresentino un significativo passo avanti nell’emulazione del ragionamento umano, i tassi di errore nelle risposte specialmente in ambiti di conoscenza generale, hanno raggiunto livelli preoccupanti, sollevando dubbi sull’affidabilità dell’AI in contesti critici.

Un recente studio ha rivelato che GPT o3 commette errori nel 33% dei casi, raddoppiando il tasso del suo predecessore, mentre o4-mini registra un tasso di errore del 48%. In situazioni di conoscenza generale, le percentuali salgono ulteriormente, con rispettivamente il 51% e il 79% di risposte errate. Questo deterioramento delle performance rappresenta una sfida significativa per l’applicazione dell’AI in settori sensibili come la sanità, l’educazione e il sistema legale.

GPT o3 compie un errore ogni tre risposte

Secondo gli esperti, il problema potrebbe derivare dalla complessità crescente dei modelli di ragionamento. Questi sistemi, progettati per replicare processi cognitivi umani, creano connessioni logiche sofisticate che, sebbene apparentemente convincenti, possono portare a conclusioni completamente errate. La maggiore creatività e capacità di espressione di questi modelli, sottolineata da OpenAI, sembra contribuire al fenomeno delle allucinazioni.

Il fenomeno non è solo tecnico, ma anche sociale: un ricercatore indipendente ha evidenziato come i modelli AI, cercando di pensare come gli umani, ereditino anche le loro peggiori tendenze, come l’invenzione di fatti. Questo limita gravemente la fiducia degli utenti, specialmente quando si tratta di affermazioni palesemente false, come la dichiarazione che “Lincoln conduceva un podcast“.

Le implicazioni sono gravi: l’affidabilità è un pilastro fondamentale per l’adozione dell’AI in ambiti dove la precisione è imprescindibile. Gli attuali tassi di errore rappresentano un ostacolo all’integrazione dell’AI in settori professionali, minando il potenziale innovativo di questi strumenti. La contraddizione tra le straordinarie capacità logiche e la tendenza a generare informazioni false rende evidente la necessità di un bilanciamento tra innovazione e affidabilità.

![[VENDO] sito completo strumentiseo.it](https://forum.mrw.it/styles/io/images/logo_mrw.png)

/https://www.ilsoftware.it/app/uploads/2023/05/Progetto-senza-titolo-8.jpg)