Los agentes son la gran promesa de la IA. También apuntan a convertirse en la nueva arma favorita de los ciberdelincuentes

Los agentes de IA no son el futuro: ya están aquí. Mientras los chatbots como ChatGPT o Gemini siguen ganando terreno en tareas que van desde resolver dudas cotidianas hasta ayudarte en tareas de programación, las grandes tecnológicas han empezado a dar pasos decididos hacia una nueva generación de sistemas mucho más prometedores. Son capaces de ejecutar tareas, tomar decisiones y adaptarse al entorno. No solo responden: actúan. Y ese cambio se presenta como un avance muy potente. OpenAI está desarrollando Operator, un asistente que puede navegar por páginas, reservar viajes o gestionar archivos. Anthropic prueba su propio agente con funciones similares en entornos controlados. Google trabaja en Jarvis, su futuro mayordomo digital. La idea es clara: delegar tareas reales en inteligencias artificiales. Pero esa misma autonomía que los convierte en aliados útiles también los convierte en un riesgo potencial para la ciberseguridad. Autonomía peligrosa. A diferencia de los bots tradicionales, los agentes de IA no se limitan a seguir instrucciones predefinidas. Pueden controlar un sistema operativo o tomar decisiones en función del contexto. En manos equivocadas, esta autonomía podría facilitar ataques complejos sin necesidad de expertos humanos. Algunas pruebas de laboratorio ya muestran cómo estos modelos pueden replicar operaciones que antes requerían conocimientos técnicos avanzados, como automatizar tareas de espionaje o manipular configuraciones del sistema. La amenaza empieza a asomar. Aunque no hay evidencia de que estén involucrados en ciberataques a gran escala, sí han comenzado a aparecer señales. Plataformas como LLM Agent Honeypot, diseñadas para detectar accesos sospechosos, han registrado interacciones con posibles agentes de IA. En dos casos confirmados, los agentes respondieron a instrucciones embebidas con una rapidez típica de modelos de lenguaje, lo que apunta a su creciente sofisticación. No hablamos aún de ofensivas organizadas, pero sí de una fase de tanteo cada vez más real. Más baratos, más rápidos, más escalables. Como apunta MIT Technology Review, uno de los mayores riesgos es el potencial para escalar. Un agente puede ejecutar acciones automatizadas cientos de veces por una fracción del coste de un equipo humano. Para los delincuentes, eso significa ampliar operaciones con una eficiencia inédita. Si hoy los ataques masivos requieren inversión y personal especializado, mañana podrían lanzarse automáticamente, seleccionando objetivos y explorando vulnerabilidades sin supervisión constante. Esquema de funcionamiento de funcionamiento de LLM Agent Honeypot Detectarlos no es tan fácil. Aunque las herramientas de ciberseguridad actuales son eficaces frente a amenazas sofisticadas, los agentes introducen un nuevo tipo de reto. A diferencia del malware clásico, estos sistemas pueden razonar, adaptarse al entorno y modificar su comportamiento en tiempo real. Esa capacidad de mimetizarse con el tráfico legítimo obliga a repensar los métodos de detección y a desarrollar técnicas específicas para identificar patrones propios de la inteligencia artificial. La industria aún está explorando hasta dónde pueden llegar estos sistemas. Algunas investigaciones muestran que, ante instrucciones ambiguas, ciertos agentes pueden ejecutar acciones inesperadas. Aunque todavía necesitan apoyo humano para completar ataques complejos, su evolución es rápida. Y lo más inquietante no es lo que pueden hacer hoy, sino lo que podrían llegar a hacer mañana. Y lo harán en un escenario cada vez más adverso. De acuerdo a datos de CheckPoint, en el tercer trimestre de 2024, los ciberataques aumentaron un 75% respecto al mismo periodo del año anterior. Cada organización sufrió de media 1.876 ataques semanales. Sectores como educación, gobierno o sanidad figuran entre los más golpeados, y regiones como África, Europa y Latinoamérica registraron crecimientos alarmantes. La industria del hardware, por ejemplo, vio crecer los ataques un 191% en solo un año. En Xataka El director del INCIBE llama "arma de destrucción masiva" a DeepSeek: la señal de alarma viene por su accesibilidad Más de 1.200 incidentes de ransomware fueron reportados solo en ese trimestre, afectando sobre todo a fabricantes, hospitales y administraciones públicas. Si ese tipo de ataques se delega a agentes de IA capaces de seleccionar objetivos y lanzar ofensivas en cadena, el impacto podría dispararse. El panorama global se está tensando, y los agentes podrían ser el multiplicador que los atacantes estaban esperando. Imágenes | Xataka con ChatGPT | Palisade Research En Xataka | Hay una persona que sabe más que nadie en el mundo sobre robos de contraseñas. Y acaban de robarle la suya - La noticia Los agentes son la gran promesa de la IA. También apuntan a conve

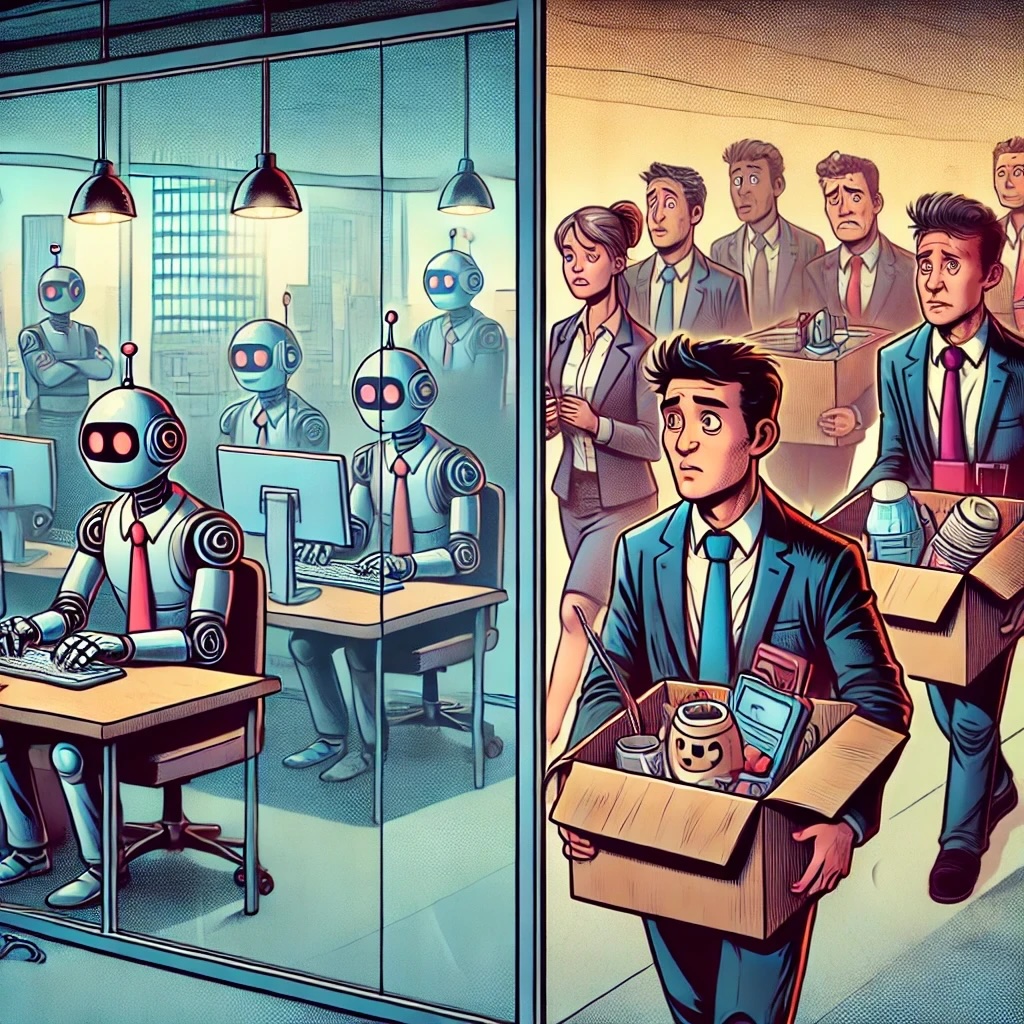

Los agentes de IA no son el futuro: ya están aquí. Mientras los chatbots como ChatGPT o Gemini siguen ganando terreno en tareas que van desde resolver dudas cotidianas hasta ayudarte en tareas de programación, las grandes tecnológicas han empezado a dar pasos decididos hacia una nueva generación de sistemas mucho más prometedores. Son capaces de ejecutar tareas, tomar decisiones y adaptarse al entorno. No solo responden: actúan. Y ese cambio se presenta como un avance muy potente.

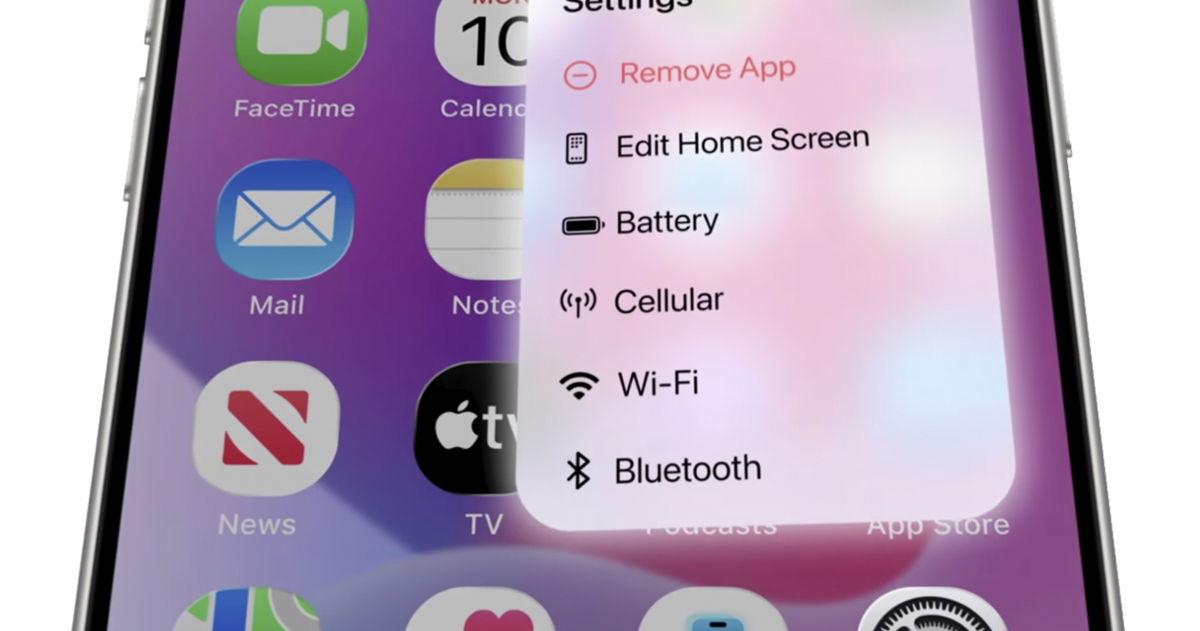

OpenAI está desarrollando Operator, un asistente que puede navegar por páginas, reservar viajes o gestionar archivos. Anthropic prueba su propio agente con funciones similares en entornos controlados. Google trabaja en Jarvis, su futuro mayordomo digital. La idea es clara: delegar tareas reales en inteligencias artificiales. Pero esa misma autonomía que los convierte en aliados útiles también los convierte en un riesgo potencial para la ciberseguridad.

Autonomía peligrosa. A diferencia de los bots tradicionales, los agentes de IA no se limitan a seguir instrucciones predefinidas. Pueden controlar un sistema operativo o tomar decisiones en función del contexto. En manos equivocadas, esta autonomía podría facilitar ataques complejos sin necesidad de expertos humanos. Algunas pruebas de laboratorio ya muestran cómo estos modelos pueden replicar operaciones que antes requerían conocimientos técnicos avanzados, como automatizar tareas de espionaje o manipular configuraciones del sistema.

La amenaza empieza a asomar. Aunque no hay evidencia de que estén involucrados en ciberataques a gran escala, sí han comenzado a aparecer señales. Plataformas como LLM Agent Honeypot, diseñadas para detectar accesos sospechosos, han registrado interacciones con posibles agentes de IA. En dos casos confirmados, los agentes respondieron a instrucciones embebidas con una rapidez típica de modelos de lenguaje, lo que apunta a su creciente sofisticación. No hablamos aún de ofensivas organizadas, pero sí de una fase de tanteo cada vez más real.

Más baratos, más rápidos, más escalables. Como apunta MIT Technology Review, uno de los mayores riesgos es el potencial para escalar. Un agente puede ejecutar acciones automatizadas cientos de veces por una fracción del coste de un equipo humano. Para los delincuentes, eso significa ampliar operaciones con una eficiencia inédita. Si hoy los ataques masivos requieren inversión y personal especializado, mañana podrían lanzarse automáticamente, seleccionando objetivos y explorando vulnerabilidades sin supervisión constante.

Esquema de funcionamiento de funcionamiento de LLM Agent Honeypot

Esquema de funcionamiento de funcionamiento de LLM Agent Honeypot

Detectarlos no es tan fácil. Aunque las herramientas de ciberseguridad actuales son eficaces frente a amenazas sofisticadas, los agentes introducen un nuevo tipo de reto. A diferencia del malware clásico, estos sistemas pueden razonar, adaptarse al entorno y modificar su comportamiento en tiempo real. Esa capacidad de mimetizarse con el tráfico legítimo obliga a repensar los métodos de detección y a desarrollar técnicas específicas para identificar patrones propios de la inteligencia artificial.

La industria aún está explorando hasta dónde pueden llegar estos sistemas. Algunas investigaciones muestran que, ante instrucciones ambiguas, ciertos agentes pueden ejecutar acciones inesperadas. Aunque todavía necesitan apoyo humano para completar ataques complejos, su evolución es rápida. Y lo más inquietante no es lo que pueden hacer hoy, sino lo que podrían llegar a hacer mañana.

Y lo harán en un escenario cada vez más adverso. De acuerdo a datos de CheckPoint, en el tercer trimestre de 2024, los ciberataques aumentaron un 75% respecto al mismo periodo del año anterior. Cada organización sufrió de media 1.876 ataques semanales. Sectores como educación, gobierno o sanidad figuran entre los más golpeados, y regiones como África, Europa y Latinoamérica registraron crecimientos alarmantes. La industria del hardware, por ejemplo, vio crecer los ataques un 191% en solo un año.

Más de 1.200 incidentes de ransomware fueron reportados solo en ese trimestre, afectando sobre todo a fabricantes, hospitales y administraciones públicas. Si ese tipo de ataques se delega a agentes de IA capaces de seleccionar objetivos y lanzar ofensivas en cadena, el impacto podría dispararse. El panorama global se está tensando, y los agentes podrían ser el multiplicador que los atacantes estaban esperando.

Imágenes | Xataka con ChatGPT | Palisade Research

En Xataka | Hay una persona que sabe más que nadie en el mundo sobre robos de contraseñas. Y acaban de robarle la suya

-

La noticia

Los agentes son la gran promesa de la IA. También apuntan a convertirse en la nueva arma favorita de los ciberdelincuentes

fue publicada originalmente en

Xataka

por

Javier Marquez

.