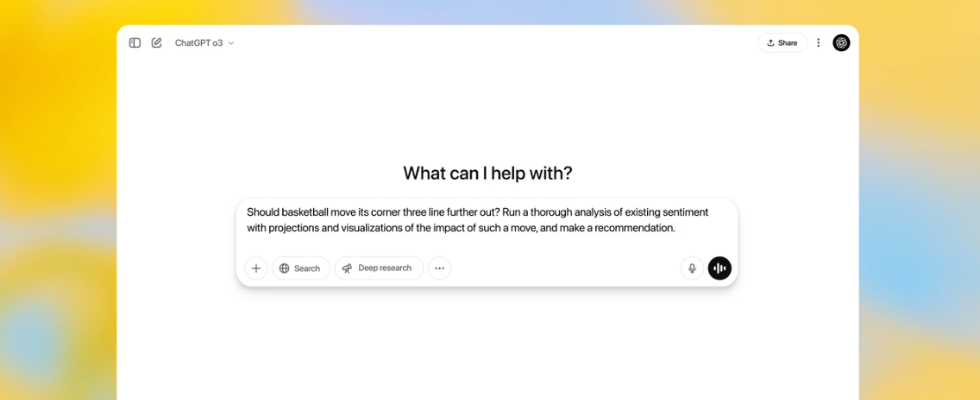

Das bisher schlauesten OpenAI-Modelle sind da: o3 und o4-mini können alle ChatGPT Tools kombinieren

o3 und o4-mini denken länger nach und bieten erstmals umfassenden ChatGPT Tool Support. Dazu liefert OpenAI den Open Source Coding Agent Codex CLI, der lokal läuft.

Eine bewegte Woche für einen der größten Player im Digitalraum: Zuerst stellte das inzwischen weltberühmte KI-Unternehmen OpenAI die schnellen, intelligenten und günstigen Modelle der 4.1-Reihe vor und erstaunte damit Developer und User. Dann wurde ein Test für eine von OpenAI gestützte Netflix-Suche bekannt, während Insider-Informationen auf den etwaigen Aufbau eines von Social Networks OpenAIs hinwiesen. Und kurz vor den Osterfeiertagen stellte das Unternehmen dann noch zwei neue Modelle vor, die nicht weniger als die „intelligentesten und leistungsfähigsten“ aus dem Hause der ChatGPT-Mutter sein sollen. Nebenbei wurde ein Coding Agent gelauncht, der auf lokalen Terminals läuft und als Open Source bereitgestellt wird.

o3 und o4-mini von OpenAI: Alle ChatGPT Tools im Kombination verwenden

o3 und o4-mini sind die neuesten Modelle der o-Serie. Nach Angaben von OpenAI sind diese darauf ausgelegt, länger und intensiver nachzudenken, bevor sie antworten. Besonders vorteilhaft für User ist der umfassende Tool Support. um ersten Mal können die Reasoning-Modelle alle ChatGPT Tools eigenständig nutzen – darunter Web-Browsing, Python, Bildverständnis und Bildgenerierung. So lassen sich komplexe, mehrstufige Probleme effektiver lösen und autonomes Handeln durch die Modell und ein agentisch handelndes ChatGPT Tool wird unterstützt.

Introducing OpenAI o3 and o4-mini—our smartest and most capable models to date.

For the first time, our reasoning models can agentically use and combine every tool within ChatGPT, including web search, Python, image analysis, file interpretation, and image generation. pic.twitter.com/rDaqV0x0wE— OpenAI (@OpenAI) April 16, 2025

Eine spezielle Neuerung haben diese beiden Modelle, denen neben einer optimierten Befehlsbefolgung besondere Fähigkeiten beim Coding, bei Mathematik sowie wissenschaftlichen Aufgaben und solchen, die Reasoning erfordern, zugeschrieben werden, in petto. Es sind die ersten Modelle von OpenAI, die mit Bildern denken können. Laut dem Unternehmen sehen sie Bilder nicht nur, sondern können visuelle Informationen direkt in ihre Argumentationskette integrieren. User können also Inhalte wie Whiteboards, Diagramme oder Skizzen hochladen – sogar in geringer Qualität. Das Modell versteht sie trotzdem. Es kann außerdem Werkzeuge nutzen, um Bilder in Echtzeit anzupassen – etwa durch Drehen oder Zoomen – und diese Anpassungen in seinen Denkprozess einbeziehen, wie OpenAI erklärt.

OpenAI o3 and o4-mini are our first models to integrate uploaded images directly into their chain of thought.

That means they don’t just see an image—they think with it. https://t.co/hSJkzeuNQR— OpenAI (@OpenAI) April 16, 2025

Während o3 als besonders kraftvolles Modell für umfassende Aufgaben gilt, das 20 Prozent weniger Fehler als das Modell o1 machen soll, ist o4-mini auf Schnelligkeit und Kosteneffizienz ausgelegt. Es hat daher deutlich höhere Nutzungslimits zu bieten. Beide Modelle wurden im Rahmen des bislang strengsten Sicherheitsprogramms von OpenAI getestet und gemäß dem neuesten Preparedness Framework evaluiert. Bei der Nutzung sollen die Modelle noch natürlicher und menschlicher wirken als die vorangegangenen, OpenAI schreibt:

[…] Compared to previous iterations of our reasoning models, these two models should also feel more natural and conversational, especially as they reference memory and past conversations to make responses more personalized and relevant.

OpenAI o3, o4-mini und o4-mini-high sind für Plus, Pro und Team User ab sofort verfügbar. Sie ersetzen o1, o3-mini und o3-mini-high. Sie sind auch über die API nutzbar (Chat Completions + Responses API). Und ChatGPT Enterprise sowie Edu User sollen in einer Woche Zugang erhalten.

Noch mehr Details zu den Modellen findest du im Blog Post des Unternehmens und in der Aufzeichnung des Livestreams, in dem Unternehmenspräsident Greg Brockman und sein Team diese vorgestellt haben.

Neuer Coding Agent als Zusatz-Feature

OpenAI stellt ebenfalls Codex CLI vor. Dabei handelt es sich um einen Open Source Coding Agent, der direkt auf deinem PC laufen kann. Er ist ab jetzt verfügbar und soll die Modelle o3 und o4-mini im Coding-Kontext noch leichter nutzbar machen. Mit dieser Kombination kannst du schnell aus natürlicher Sprache funktionierenden Code erstellen, der deine Projekte fördert – ohne umfassendes Vorwissen.

Meet Codex CLI—an open-source local coding agent that turns natural language into working code. Tell Codex CLI what to build, fix, or explain, then watch it bring your ideas to life. pic.twitter.com/jjPZdRIgrm— OpenAI Developers (@OpenAIDevs) April 16, 2025

Zur Unterstützung früher Projekte startet OpenAI zudem eine Förderinitiative in Höhe von einer Million US-Dollar. Die Förderungen werden als Teilbeträge im Rahmen von je 25.000 US-Dollar und in Form von API-Guthaben vergeben.

GPT-4.1 von OpenAI ist da

– und setzt neue Maßstäbe

,regionOfInterest=(240,151)&hash=5390aa4521f70a5cca126b5909b7cd598957b6af2bf94138f860a160b14c5007#)

,regionOfInterest=(1148,807)&hash=f56a8b955ad9f1c8bf3c88ef72c0f85966e37a70651cb94012fa71f2da45bc9f#)

:quality(80)/p7i.vogel.de/wcms/18/e9/18e9a988d3ca7593fb3324e8abc33e56/0124025380v2.jpeg?#)

:quality(80)/p7i.vogel.de/wcms/24/c4/24c463bcbdd29c1d6b870b676a7c91c1/0123887278v1.jpeg?#)

:quality(80)/p7i.vogel.de/wcms/57/ee/57eedd11c2043e71aadc1828a06e3063/0124267466v2.jpeg?#)

:quality(80)/p7i.vogel.de/wcms/c4/b5/c4b5f9ba2c6a913088a84b641e36de3f/0124266663v2.jpeg?#)