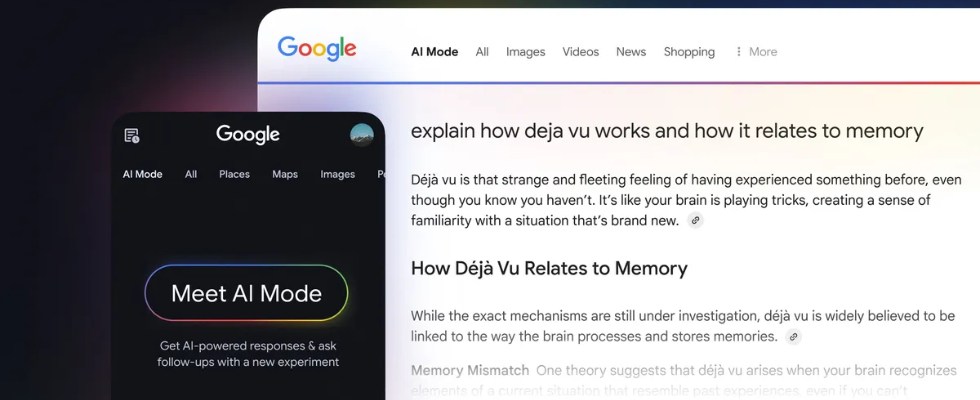

Google bringt multimodale Suche in den AI Mode

Der neue AI Mode von Google übertrifft die AI Overviews, kommt für Millionen weiterer User und ermöglicht die visuelle Suche mit Lens.

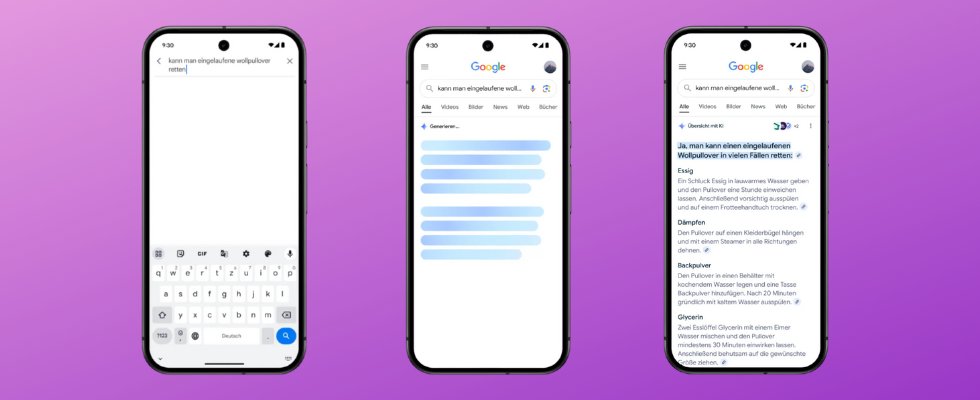

Für den noch jungen AI Mode in der Suche hat Google ein großes Update bereitgestellt. Der Modus, welcher Usern erlaubt, nuancierte Fragen zu stellen und eine ausführliche Antwort zu erhalten, für die es ohne den Modus mehrere Anfragen gebraucht hätte, wird in den USA über das Search Lab Millionen neuer User zur Verfügung gestellt. Und jetzt können diese Nutzer:innen den Modus multimodal einsetzen, um auch hochkomplexe Fragen beantwortet zu bekommen. Sie können mit Text, Stimme, der Kamera oder auch Bilder via Lens suchen.

AI Mode expands the types of questions you can ask, so you can search anything, effortlessly.

We’re finding that people are using AI Mode for more complicated tasks, like comparisons and how-tos. And they’re asking longer, more open-ended questions to get to the heart of what… pic.twitter.com/nqQ6LQGxLf— Google (@Google) April 7, 2025

Googles Mega-KI-Update:

AI Mode offiziell eingeführt und AI Overviews mit Gemini 2.0

AI Mode soll die Suche bereichern: In Deutschland noch nicht verfügbar

Im Vergleich zu den AI Overviews bietet der AI Mode deutlich ausführlichere Antworten, etwa auf Fragen, die mehr rationale Evaluierung, Vergleichsgrößen oder weiterführende Sondierungen benötigen. Der AI Mode soll Usern erlauben, nuancierte Fragen zu stellen und eine ausführliche Antwort zu erhalten, für die es ohne den Modus mehrere Anfragen gebraucht hätte. Dabei unterstützt eine maßgeschneiderte Version von Gemini 2.0 den neuen Modus. Das neue Sucherlebnis ist direkt in die Suche integriert und kombiniert die Fähigkeiten von Googles Vorzeige-KI-Modell mit relevanten Suchmechanismen. Shopping-Daten, Echtzeitinformationen und die wichtigsten Quellen werden herangezogen, um verständliche und passende Antworten zu finden. Dafür fasst Google diverse verwandte Suchkontexte zu Unterthemen parallel zusammen und kreiert eine auf die Suchintention zugeschnittene Antwort.

Diese Antworten werden inzwischen auch bei multimodalen Suchen ausgespielt. Robby Stein, VP of Product für die Google Search, erklärt auf dem Blog The Keyword:

With AI Mode’s new multimodal understanding, you can snap a photo or upload an image, ask a question about it and get a rich, comprehensive response with links to dive deeper. This experience brings together powerful visual search capabilities in Lens with a custom version of Gemini, so you can easily ask complex questions about what you see […].

Search what you see, so das Motto. Passenderweise hat Google jüngst auch für die Gemini App einen Screensharing-Modus auszurollen begonnen. Dank Gemini soll der AI Mode die diversen in Bildern oder Live-Bildern integrierten Kontexte verstehen können. Farben, Materialien, Formen und Objekte kann die KI einordnen, so Stein. Das soll dazu beitragen, möglichst umfassende und nuancierte Antworten zu liefern. Dafür liefert Google ein visuelles Beispiel.

Die Antworten aus dem AI Mode können für User, die noch mehr erfahren wollen, auch nur der Ausgangspunkt für Follow-up-Fragen sein.

Der AI Mode ist bisher nur in den USA für via Google Labs registrierte User nutzbar. Ein Roll-out-Datum für Deutschland steht noch nicht fest. Dafür sorgen die AI Overviews seit Kurzem auch hierzulande für Aufsehen. Diese sollen laut Google nicht nur die Search-Erfahrung der User optimieren, sondern Publishern auch mehr Referral Traffic bescheren. Doch in der Praxis bleibt letzterer Effekt bislang noch vielfach aus, wie ein Bericht von Julia Love und Davey Alba für Bloomberg zeigt.

Google says AI Overviews drive more traffic to publishers. But it has never shared data to back up that claim. @daveyalba & I spoke to 25 creators who painted a very different picture. Several have gone out of business. One is on food stamps. Our latest:https://t.co/SEBiqdk71n— Julia Love (@byJuliaLove) April 7, 2025

,regionOfInterest=(242,144)&hash=3c7078e06fdbee532a3e7c42460625c7e74c91b810634207697e4b13e2d0d22e#)

![SEO-Monatsrückblick März 2025: Google AIO in DE, AI Mode, LLMs + mehr [Search Camp 369]](https://blog.bloofusion.de/wp-content/uploads/2025/03/Search-Camp-Canva-369.png)

![Deals: 800€ Rabatt! - Siemens stiehlt mit diesem Kaffeevollautomat De'Longhi und Co. die Show! [Anzeige]](https://images.cgames.de/images/gamestar/4/siemens-tq515d03-kaffeevollautomat-mediamarkt-16042025-teaser_6349055.jpg?#)

:quality(80)/p7i.vogel.de/wcms/0e/c2/0ec2d29c3bc2ca85ae4c89e9a67d9bb4/0124012543v1.jpeg?#)

:quality(80)/p7i.vogel.de/wcms/24/d5/24d528e59e6a8e4e523e0a10bedb4e78/0123782471v1.jpeg?#)

:quality(80)/p7i.vogel.de/wcms/fc/2a/fc2a4ff355808804fb1a421247b95eb6/0124162737v2.jpeg?#)

:quality(80)/p7i.vogel.de/wcms/39/4b/394ba401c109713ae7263c2ce6802871/0123851691v1.jpeg?#)