Apple presenta FastVLM, il modello AI che potrebbe alimentare i suoi futuri occhiali smart

Apple presenta FastVLM, il modello AI che potrebbe alimentare i suoi futuri occhiali smart Da mesi si rincorrono indiscrezioni sui progetti di Apple legati a dispositivi indossabili dotati di intelligenza artificiale. Secondo gli analisti, i concorrenti diretti dei Meta Ray-Ban saranno lanciati sul mercato nel 2027, insieme a una nuova generazione di AirPods dotati di fotocamere integrate e funzionalità AI avanzate. Oggi, però, Apple ha fornito un’indicazione concreta su [...]

Apple presenta FastVLM, il modello AI che potrebbe alimentare i suoi futuri occhiali smart

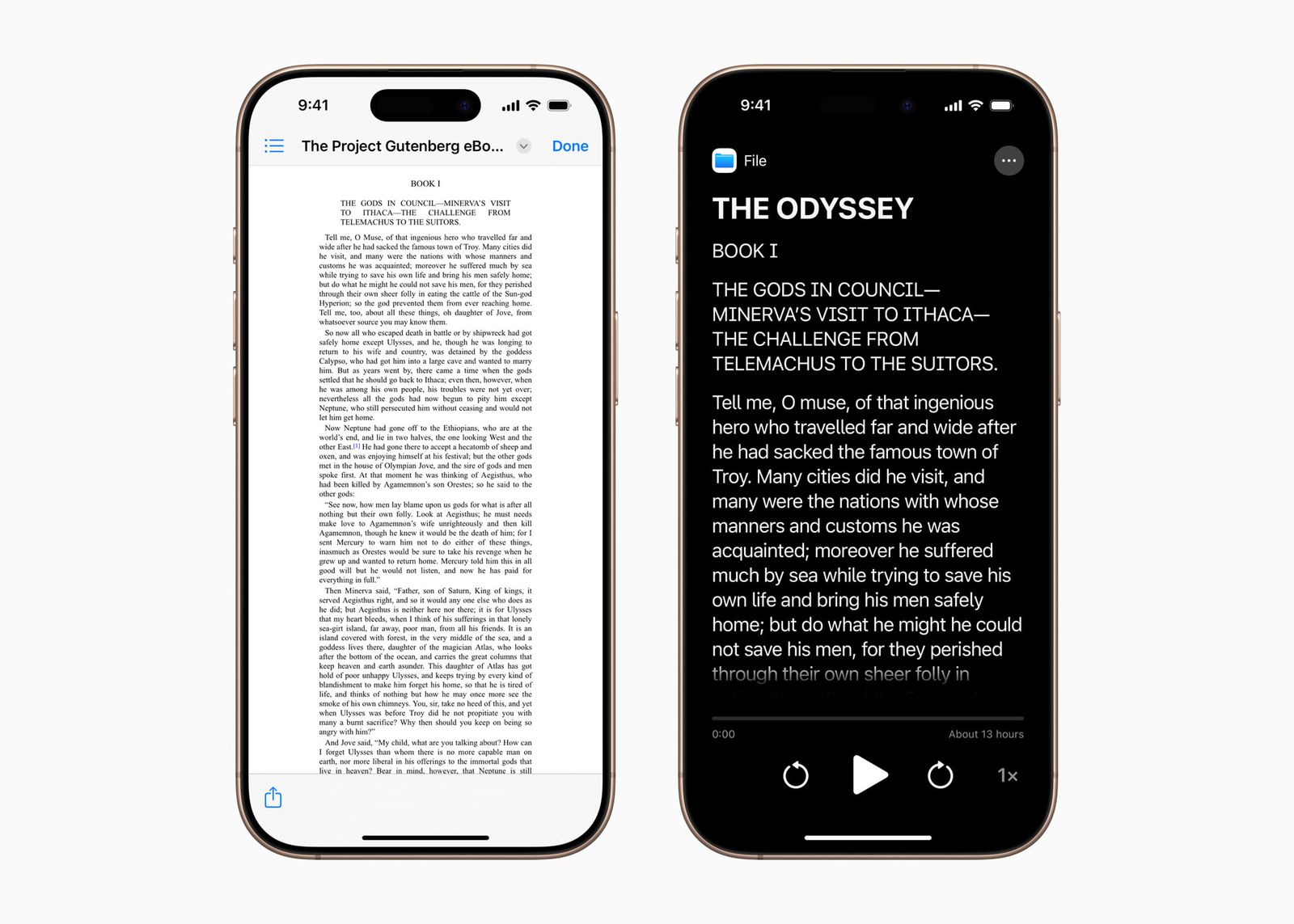

Da mesi si rincorrono indiscrezioni sui progetti di Apple legati a dispositivi indossabili dotati di intelligenza artificiale. Secondo gli analisti, i concorrenti diretti dei Meta Ray-Ban saranno lanciati sul mercato nel 2027, insieme a una nuova generazione di AirPods dotati di fotocamere integrate e funzionalità AI avanzate.

Oggi, però, Apple ha fornito un’indicazione concreta su come intende far funzionare la sua intelligenza artificiale su questi futuri dispositivi, e tutto ruota attorno a un modello chiamato FastVLM.

Nel 2023, il team di Apple dedicato alla ricerca sull’apprendimento automatico ha presentato MLX, un framework open source progettato per funzionare in modo efficiente sui chip Apple Silicon. MLX permette di eseguire modelli AI direttamente sui dispositivi locali, senza dipendere dal cloud, e questo approccio è familiare agli sviluppatori che sono abituati agli strumenti più diffusi nel mondo dell’AI.

Ed è proprio su MLX che si basa FastVLM, il nuovo modello di linguaggio visivo (VLM) sviluppato da Apple. Questo modello è stato progettato per garantire un’elaborazione ad alta risoluzione praticamente istantanea, riducendo al contempo il carico computazionale rispetto a soluzioni simili.

Ecco come Apple descrive il suo lavoro:

“Dopo un’analisi approfondita dell’efficienza in termini di risoluzione dell’immagine, latenza visiva, numero di token e dimensione del modello, introduciamo FastVLM: un modello che ottimizza il bilanciamento tra latenza, dimensioni e precisione.”

Il cuore di FastVLM è FastViTHD, un encoder progettato per garantire prestazioni elevate con immagini ad alta risoluzione. Questo encoder è fino a 3,2 volte più veloce e 3,6 volte più compatto rispetto ai modelli concorrenti. Questo elemento è fondamentale per garantire l’elaborazione dei dati direttamente sul dispositivo, senza la necessità di inviarli a server esterni.

Un altro punto di forza è la riduzione del numero di token generati, aspetto cruciale nella fase di inferenza, ovvero il momento in cui il modello interpreta i dati e produce una risposta. Apple afferma che FastVLM ha un tempo di primo token fino a 85 volte più rapido rispetto ad altri modelli, il che si traduce in un’interazione quasi istantanea.

Velocità, efficienza e privacy: queste le tre parole chiave che descrivono la direzione che Apple sembra voler intraprendere con i suoi futuri dispositivi smart.

Il codice sorgente di FastVLM è già disponibile su GitHub, mentre la ricerca completa è stata pubblicata su ArXiv. Non si tratta di una lettura semplice, ma gli appassionati di intelligenza artificiale e gli utenti curiosi di scoprire le mosse future di Apple potrebbero trovarla estremamente interessante.

/https://www.html.it/app/uploads/2025/05/s25-edge.jpg)

/https://www.html.it/app/uploads/2025/05/x-community.jpg)