Google enseñó por primera vez sus nuevas gafas con una demo real: un imprevisto en directo y una apuesta que apunta lejos

La historia de Google con las gafas no ha terminado. Todo lo contrario. Tras años de silencio, la compañía ha vuelto a ponerlas sobre el escenario. Y lo ha hecho con un proyecto que recupera un nombre familiar: Project Aura. No es la primera vez que lo escuchamos. Lleva sonando desde los tiempos de las Google Glass, que acabaron en un rincón oscuro de la historia tecnológica. Pero esta vez, el enfoque es muy distinto. Durante el Google I/O 2025, donde también vimos propuestas como AI Mode o Beam, la compañía mostró en directo el estado de desarrollo de sus nuevas gafas de realidad mixta. Una propuesta que nace en colaboración con Xreal y que, según los responsables del proyecto, quiere llevar la experiencia Android al universo XR con naturalidad, contexto y respuestas en tiempo real. Una demo en directo, sin trucos ni retoques. Todo empezó cuando Shahram Izadi, responsable del área de dispositivos, lanzó una pregunta al público registrada en un vídeo publicado en YouTube: “¿Quién se apunta a ver una demostración anticipada de las gafas Android XR?” La respuesta llegó desde bambalinas. Nishtha Bhatia, parte del equipo, apareció en escena de forma remota y comenzó a mostrar el funcionamiento real de las gafas. Lo primero que vimos fue una interfaz superpuesta en tiempo real sobre el entorno. A través de la cámara integrada, las gafas mostraban lo que tenía delante mientras Bhatia recibía mensajes, reproducía música, consultaba direcciones o interactuaba con Gemini, el asistente conversacional, todo mediante comandos de voz. Sin sacar el móvil. Sin pulsar nada. En uno de los momentos más llamativos, la demo mostró cómo podía preguntar qué banda era la autora de un cuadro que estaba observando. Gemini respondió, aunque con algún que otro retardo atribuible a problemas de conexión. También pidió que se reprodujera una canción de la banda en YouTube Music, lo que ocurrió sin intervención manual. Todo quedó registrado en la imagen compartida en tiempo real. En Xataka La búsqueda tal y como la conocíamos ha terminado. El AI Mode de Google ya no entrega resultados, conversa Traducción en vivo y un pequeño fallo sobre el escenario. La prueba final consistió en una conversación entre Izadi y Bhatia en distintos idiomas. Ella habló en hindi, él en farsi. Las gafas, mediante Gemini, ofrecían una traducción simultánea con interpretación de voz. El sistema funcionó correctamente durante unos segundos, pero los responsables decidieron interrumpir la demo cuando detectaron un fallo. A pesar del traspiés, el mensaje quedó claro: Google quiere volver a jugar en el terreno de las gafas conectadas, esta vez con una base más madura, apoyada en su ecosistema de servicios, en Gemini y en colaboraciones con actores clave del mundo XR. La diferencia, al menos por ahora, está en el enfoque: experiencias prácticas, en tiempo real, sin adornos ni promesas a largo plazo. Imágenes | Google En Xataka | Google ya tiene una IA agéntica capaz de programar por ti: se llama Jules y busca plantarle cara a OpenAI - La noticia Google enseñó por primera vez sus nuevas gafas con una demo real: un imprevisto en directo y una apuesta que apunta lejos fue publicada originalmente en Xataka por Javier Marquez .

La historia de Google con las gafas no ha terminado. Todo lo contrario. Tras años de silencio, la compañía ha vuelto a ponerlas sobre el escenario. Y lo ha hecho con un proyecto que recupera un nombre familiar: Project Aura. No es la primera vez que lo escuchamos. Lleva sonando desde los tiempos de las Google Glass, que acabaron en un rincón oscuro de la historia tecnológica. Pero esta vez, el enfoque es muy distinto.

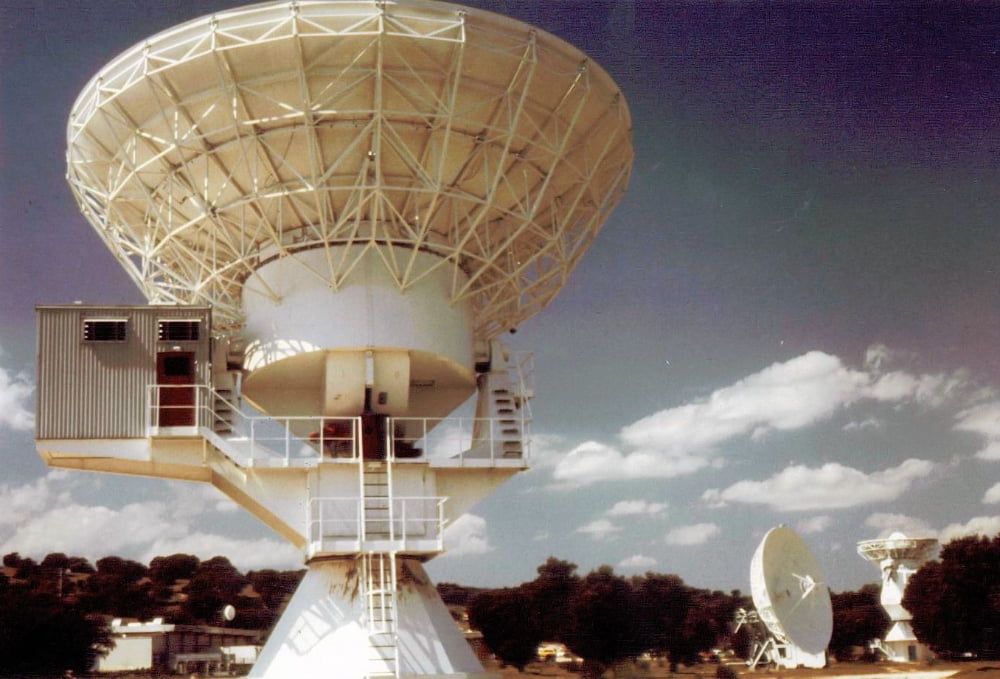

Durante el Google I/O 2025, donde también vimos propuestas como AI Mode o Beam, la compañía mostró en directo el estado de desarrollo de sus nuevas gafas de realidad mixta. Una propuesta que nace en colaboración con Xreal y que, según los responsables del proyecto, quiere llevar la experiencia Android al universo XR con naturalidad, contexto y respuestas en tiempo real.

Una demo en directo, sin trucos ni retoques. Todo empezó cuando Shahram Izadi, responsable del área de dispositivos, lanzó una pregunta al público registrada en un vídeo publicado en YouTube: “¿Quién se apunta a ver una demostración anticipada de las gafas Android XR?” La respuesta llegó desde bambalinas. Nishtha Bhatia, parte del equipo, apareció en escena de forma remota y comenzó a mostrar el funcionamiento real de las gafas.

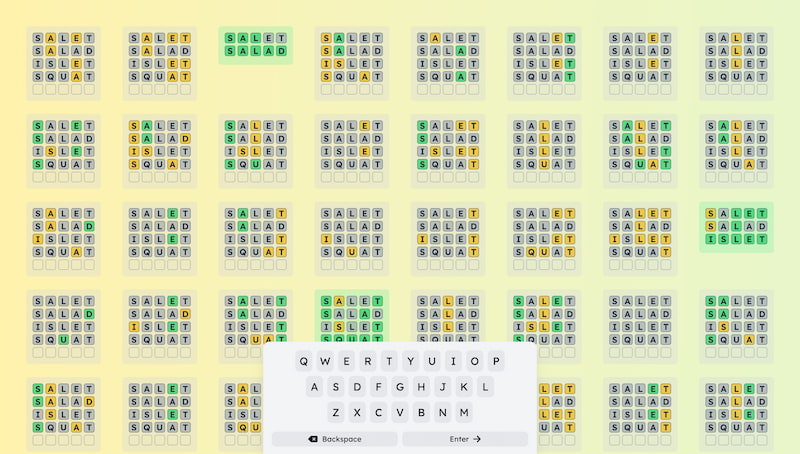

Lo primero que vimos fue una interfaz superpuesta en tiempo real sobre el entorno. A través de la cámara integrada, las gafas mostraban lo que tenía delante mientras Bhatia recibía mensajes, reproducía música, consultaba direcciones o interactuaba con Gemini, el asistente conversacional, todo mediante comandos de voz. Sin sacar el móvil. Sin pulsar nada.

En uno de los momentos más llamativos, la demo mostró cómo podía preguntar qué banda era la autora de un cuadro que estaba observando. Gemini respondió, aunque con algún que otro retardo atribuible a problemas de conexión. También pidió que se reprodujera una canción de la banda en YouTube Music, lo que ocurrió sin intervención manual. Todo quedó registrado en la imagen compartida en tiempo real.

Traducción en vivo y un pequeño fallo sobre el escenario. La prueba final consistió en una conversación entre Izadi y Bhatia en distintos idiomas. Ella habló en hindi, él en farsi. Las gafas, mediante Gemini, ofrecían una traducción simultánea con interpretación de voz. El sistema funcionó correctamente durante unos segundos, pero los responsables decidieron interrumpir la demo cuando detectaron un fallo.

A pesar del traspiés, el mensaje quedó claro: Google quiere volver a jugar en el terreno de las gafas conectadas, esta vez con una base más madura, apoyada en su ecosistema de servicios, en Gemini y en colaboraciones con actores clave del mundo XR. La diferencia, al menos por ahora, está en el enfoque: experiencias prácticas, en tiempo real, sin adornos ni promesas a largo plazo.

Imágenes | Google

En Xataka | Google ya tiene una IA agéntica capaz de programar por ti: se llama Jules y busca plantarle cara a OpenAI

-

La noticia

Google enseñó por primera vez sus nuevas gafas con una demo real: un imprevisto en directo y una apuesta que apunta lejos

fue publicada originalmente en

Xataka

por

Javier Marquez

.