Neue KI-Technologien könnten Apples Smart Glasses deutlich verbessern

Apples Zukunft in der Wearable-Technologie nimmt immer klarere Formen an. Im Zuge einer wachsenden Welle von Spekulationen scheint das Unternehmen im Stillen die Grundlagen für eine neue Produktkategorie zu schaffen. Das mittelfristige Ziel sind KI-gesteuerte Smart Glasses, die direkt mit den Ray-Ban Wearables von Meta konkurrieren könnten. Obwohl diese Kamera-Brillen voraussichtlich erst um 2027 auf […]

Apples Zukunft in der Wearable-Technologie nimmt immer klarere Formen an. Im Zuge einer wachsenden Welle von Spekulationen scheint das Unternehmen im Stillen die Grundlagen für eine neue Produktkategorie zu schaffen. Das mittelfristige Ziel sind KI-gesteuerte Smart Glasses, die direkt mit den Ray-Ban Wearables von Meta konkurrieren könnten. Obwohl diese Kamera-Brillen voraussichtlich erst um 2027 auf den Markt kommen werden, hat Apple bereits damit begonnen, die grundlegenden Technologien zu enthüllen, die sie antreiben könnten.

Fotocredit: Apple

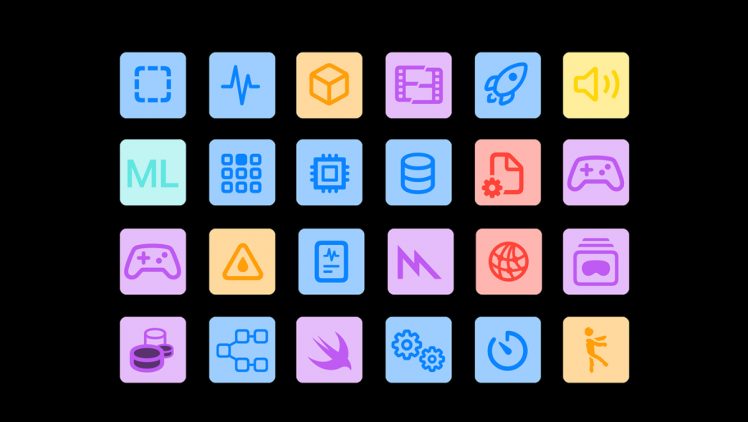

Das Machine Learning Framework hinter den Kulissen

Im Jahr 2023 stellte Apple MLX vor, ein Framework für maschinelles Lernen, das speziell für die eigenen Apple Silicon Chips entwickelt wurde. MLX wurde mit Blick auf Leistung sowie Benutzerfreundlichkeit entwickelt und bietet Entwicklern eine vertraute Plattform zum Trainieren und Ausführen von KI-Modellen direkt auf Apple-Geräten.

MLX ist die Antwort von Apple auf die Herausforderung, fortschrittliche KI lokal auszuführen. Seine leichtgewichtige Architektur ermöglicht es, die Ressourcenbeschränkungen von mobiler Hardware zu berücksichtigen. Diese Fähigkeit schafft die Voraussetzungen für reaktionsschnelle, geräteinterne Intelligenz in Produkten wie Smart Glasses und AirPods der nächsten Generation.

FastVLM zeigt, was die KI von Apple leisten kann

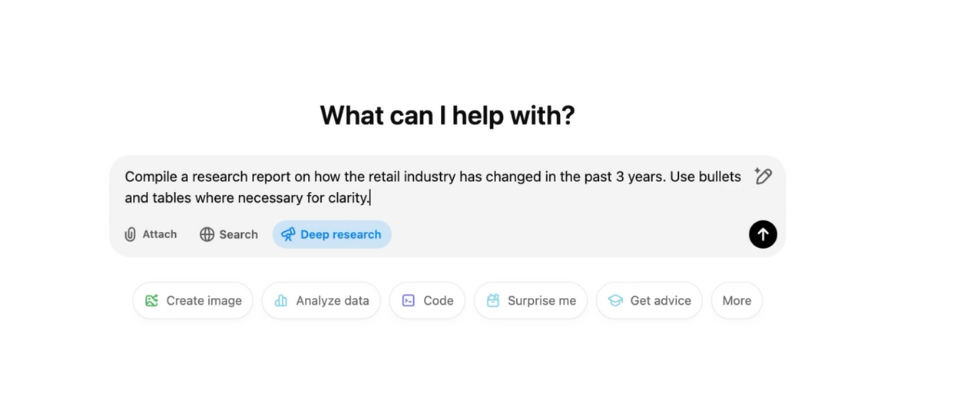

Um die Leistungsfähigkeit von MLX zu demonstrieren, hat Apple ein neues Visual Language Model namens FastVLM auf GitHub veröffentlicht. Das Modell wurde entwickelt, um hochauflösende Bilder nahezu in Echtzeit zu verarbeiten und dabei weit weniger Rechenleistung zu verbrauchen als traditionelle Lösungen.

Wie Apple erklärt, stellt das Herzstück von FastVLM ein Encoder namens FastViTHD dar, der entwickelt wurde, um hochauflösende visuelle Eingaben effizient zu verarbeiten. Im Vergleich zu anderen Modellen seiner Klasse soll FastViTHD bis zu 3,2 Mal schneller und 3,6 Mal kleiner sein. Diese Leistung ist wichtig, wenn ein Gerät seine Umgebung schnell erfassen muss, ohne auf eine externe Datenverbindung angewiesen zu sein.

Eine weitere wichtige Neuerung liegt in der Art und Weise, wie FastVLM mit der Ausgabe umgeht. Das Modell erzeugt während der Inferenz (der Phase, in der es die Eingaben analysiert und eine Antwort erzeugt) weniger Token. Laut Apple bietet FastVLM eine 85-fache Verbesserung der „Zeit bis zum ersten Token“ im Vergleich zu ähnlichen Modellen. Das bedeutet, dass die Nutzer schnellere Antworten erhalten, was eine nahtlosere Echtzeit-Interaktion mit KI-Funktionen ermöglicht.

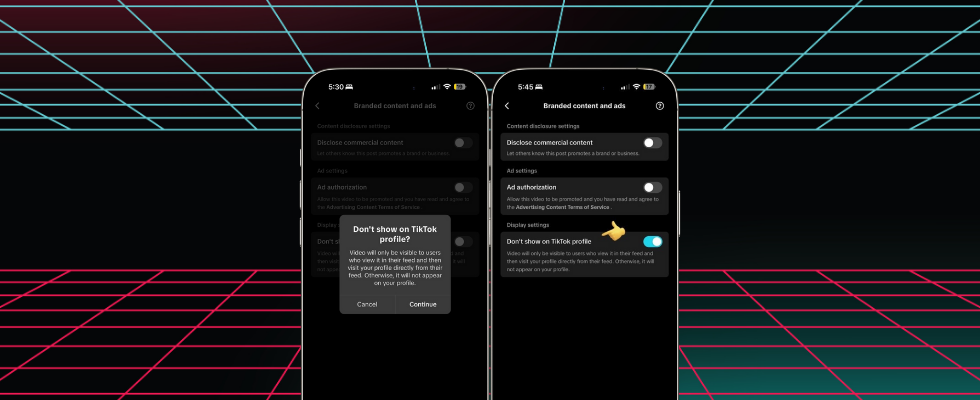

Wie Apples KI Wearables verändern kann

Bei all den Fortschritten handelt es sich nicht nur um reine technologische Machbarkeitsstudien. Sie haben wichtige Auswirkungen auf die Benutzerfreundlichkeit und Attraktivität der kommenden Wearables von Apple. Indem die KI-Aufgaben auf dem Gerät verbleiben, kann Apple eine höhere Geschwindigkeit, einen stärkeren Schutz der Privatsphäre und ein zuverlässigeres Erlebnis bieten, insbesondere in Situationen, in denen die Konnektivität eingeschränkt ist.

Für Apples künftige Smart Glasses könnten MLX und FastVLM es den Geräten ermöglichen, visuelle Szenen zu interpretieren, bei der Navigation zu helfen, Objekte zu erkennen oder kontextbezogene Informationen sofort bereitzustellen. Das alles würde deutlich schneller und effizienter vonstattengehen, als es bisher möglich war.

FastVLM ist auf GitHub verfügbar, wobei ein ausführlicher Bericht auf arXiv veröffentlicht wurde.

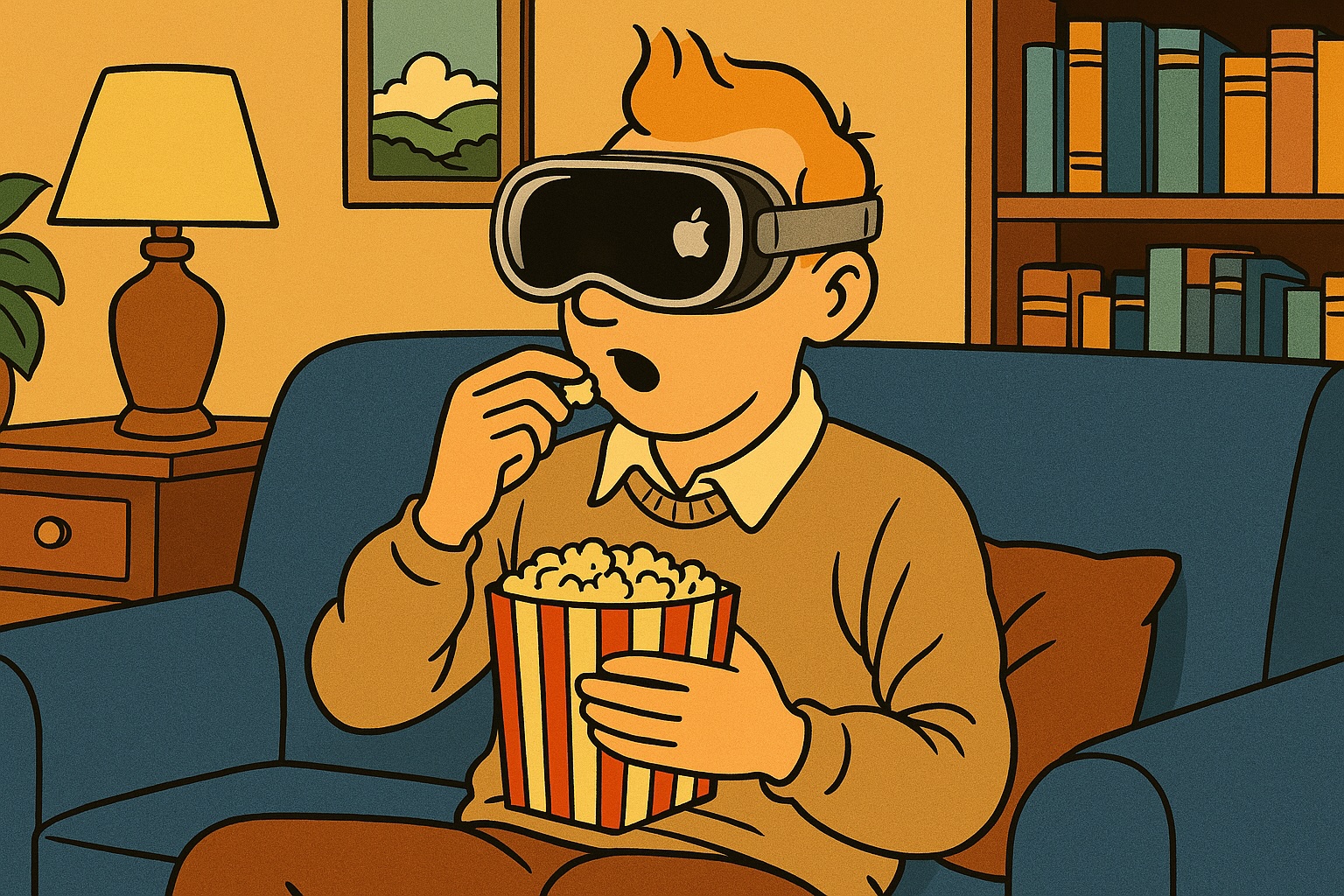

Apples Smart-Glasses-Fahrplan

Apples langfristiges Ziel ist es, eine branchenführende AR-Brille zu entwickeln. Die größte Hürde ist die enorme Herausforderung, eine leichte, elegante und gleichzeitig fortschrittliche AR-Brille zu entwickeln, ohne die Akkulaufzeit oder die Leistung zu beeinträchtigen. Das Unternehmen muss herausfinden, wie man Kameras, Sensoren und ein Display in etwas packen kann, das nicht wie ein Headset aussieht.

Während die Apple Glasses mit AR-Funktionen noch einige Jahre bis zur Marktreife benötigen, plant Apple zuvor ein Produkt zu bringen, das an die Ray-Ban-Brillen von Meta erinnert. Anders als die Vision Pro würde diese Brille nicht über AR verfügen, sondern soll Kameras, Mikrofone, Audiofunktionen und KI-gesteuerte Funktionen bieten. Stellt euch die Brille als eine elegante Möglichkeit vor, mit Siri zu interagieren und die Welt um euch herum mit Kameras zu erfassen, ohne das iPhone zücken zu müssen.

,regionOfInterest=(240,151)&hash=5390aa4521f70a5cca126b5909b7cd598957b6af2bf94138f860a160b14c5007#)

![„Einsatz von Apple Intelligence im Unternehmen“ [Sponsor]](https://www.iphoneblog.de/wp-content/uploads/2025/05/iphoneblog.de_apple_intelligence_mark_zimmermann.jpeg)

![99 SEO-Fragen: Wichtiges SEO-Wissen für Unternehmen [Search Camp 372]](https://blog.bloofusion.de/wp-content/uploads/2025/04/Search-Camp-Canva-372.png)

:quality(80)/p7i.vogel.de/wcms/18/10/18100ba0424090f9dc61d393bd34b067/0124589228v2.jpeg?#)

:quality(80)/p7i.vogel.de/wcms/fb/22/fb22b335a6e9505750452f10ade85398/0124653767v1.jpeg?#)

:quality(80)/p7i.vogel.de/wcms/64/df/64df5242e91ca49307f4d95b8528d368/0122758754v1.jpeg?#)

:quality(80)/p7i.vogel.de/wcms/8c/c6/8cc6e09853a659b0c3c0de55c77a795c/0124643416v1.jpeg?#)