Android 16 und die Zukunft der Barrierefreiheit: Wie neue KI‑gestützte Funktionen Apps inklusiver machen

Warum digitale Inklusion 2025 wichtiger ist denn je Barrierefreiheit (Accessibility) ist längst kein Nischenthema mehr. Weltweit leben laut WHO rund 1,3 Milliarden Menschen mit einer Form von Behinderung – das sind fast 17 % der Weltbevölkerung. Dabei geht es nicht nur um dauerhafte Einschränkungen wie Blindheit oder motorische Handicaps. Auch situative Barrieren – etwa grelles Sonnenlicht, laute Umgebungen oder [&hellip Der Beitrag Android 16 und die Zukunft der Barrierefreiheit: Wie neue KI‑gestützte Funktionen Apps inklusiver machen erschien zuerst auf Androidmag.

Warum digitale Inklusion 2025 wichtiger ist denn je

Barrierefreiheit (Accessibility) ist längst kein Nischenthema mehr. Weltweit leben laut WHO rund 1,3 Milliarden Menschen mit einer Form von Behinderung – das sind fast 17 % der Weltbevölkerung. Dabei geht es nicht nur um dauerhafte Einschränkungen wie Blindheit oder motorische Handicaps. Auch situative Barrieren – etwa grelles Sonnenlicht, laute Umgebungen oder schlicht Müdigkeit – betreffen jeden von uns. Genau hier setzt Android 16 an: Die neue Version des Betriebssystems liefert ein ganzes Bündel an APIs und KI‑Funktionen, die Inklusion vom Rand in das Zentrum der App‑Entwicklung rücken.

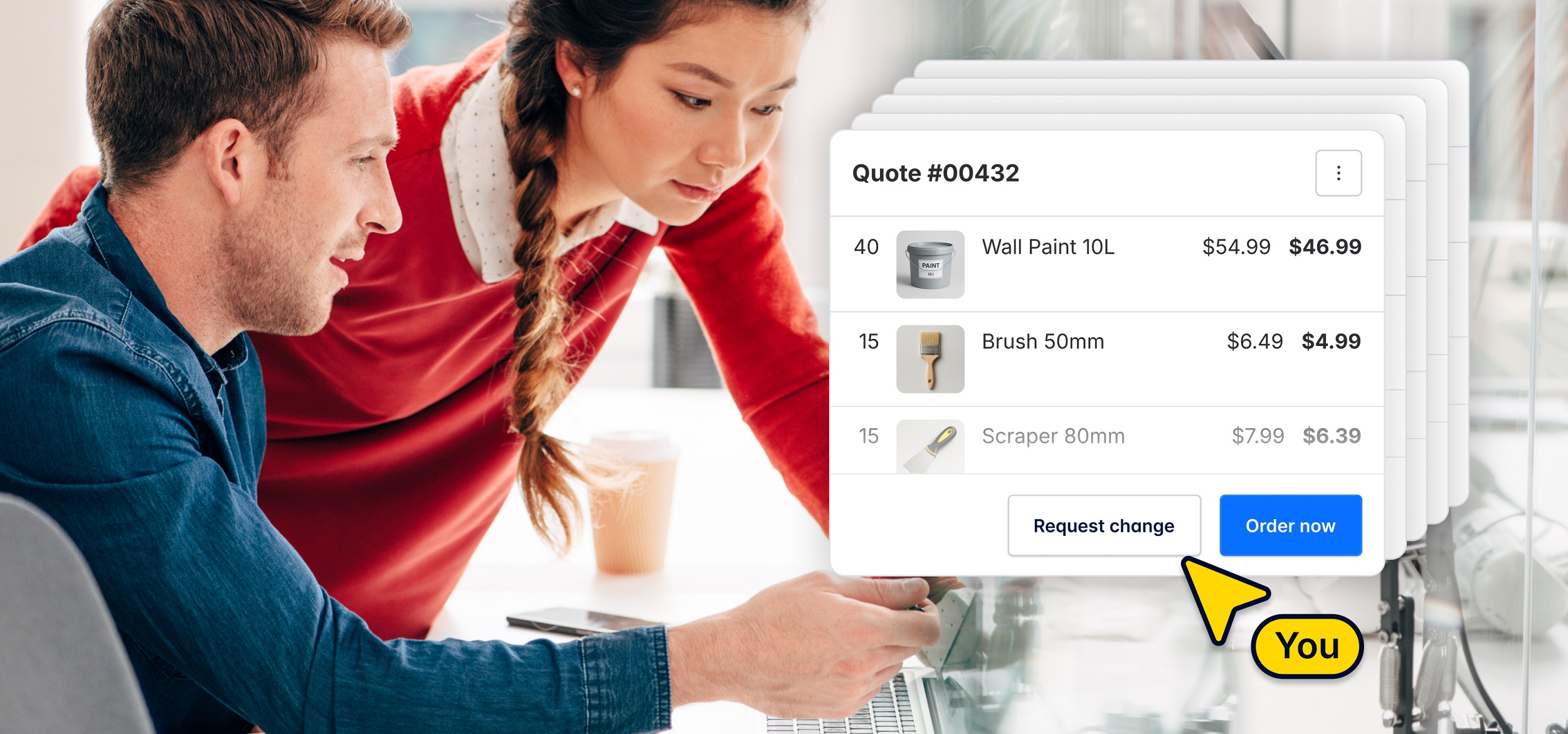

Bildquelle: unsplash.com

Überblick: Die wichtigsten Accessibility‑Neuerungen in Android 16

Adaptive Haptik und kontextabhängige Vibrationen

Mit den neuen Haptic‑Feedback‑APIs können Entwickler erstmals feinstufig definieren, wie stark, wie lang und in welchem Frequenzbereich ihre Apps vibrieren – angepasst an Gerätekategorie und Nutzungskontext. Für gehörlose Menschen, die auf haptische Hinweise angewiesen sind, lassen sich so subtilere, aber trotzdem wahrnehmbare Signale gestalten. Gleichzeitig profitieren Gamer:innen, wenn Controller‑Vibrationen exakter mit Spielsituationen korrespondieren. Die zweite Developer Preview hebt dabei explizit die neuen haptischen Muster hervor.

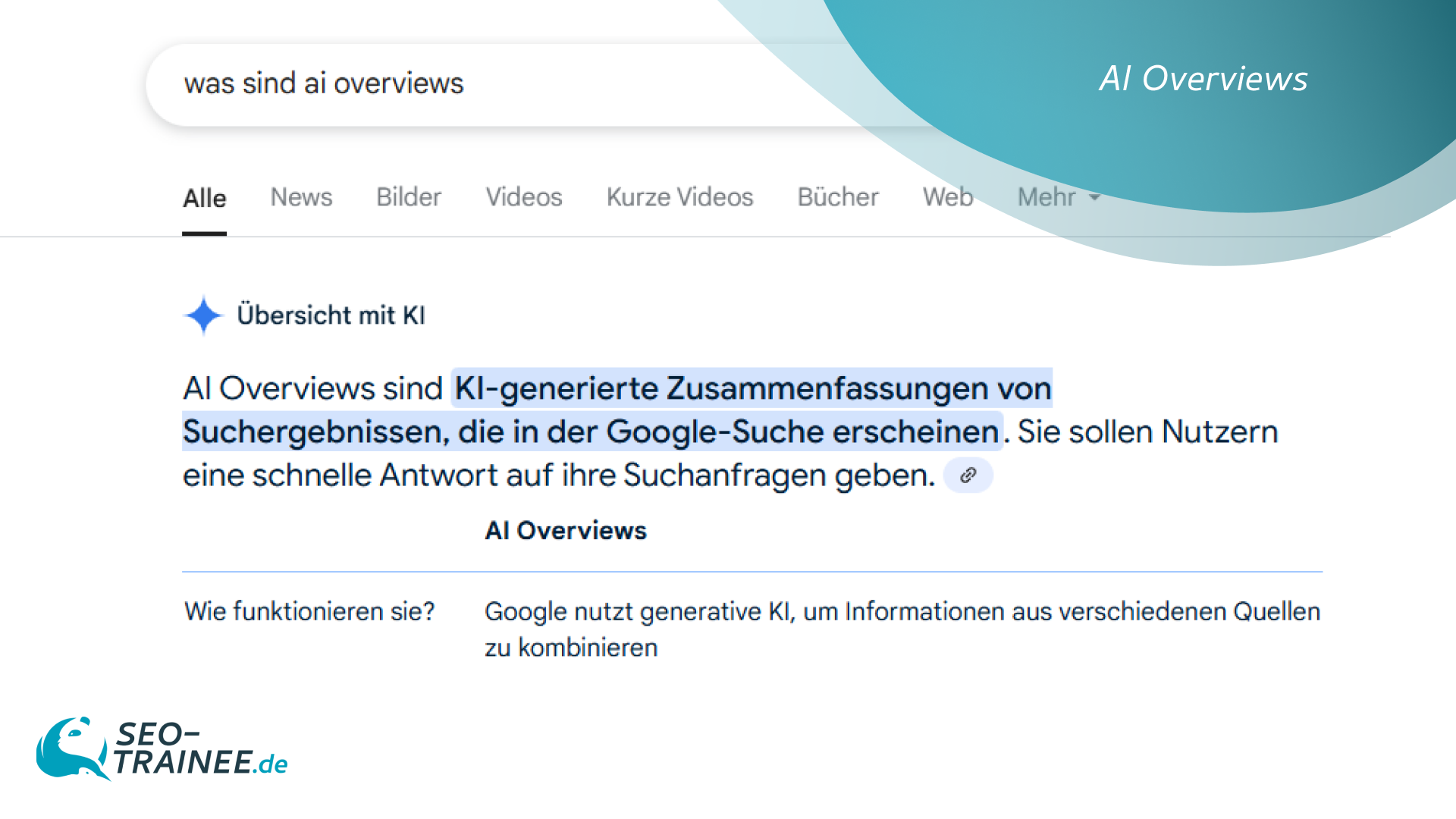

Live Captions 2.0 – Untertitel in Echtzeit und in Farbe

Google poliert die Live‑Caption‑Funktion gründlich auf. Untertitel werden jetzt nicht nur für Audio‑ und Videostreams erstellt, sondern dank multimodaler KI auch für Face‑to‑Face‑Gespräche und Telefonate. Neue Stimmanalyse‑Algorithmen betonen Emotionen, indem sie z. B. Lachen oder ironische Tonlagen gesondert kennzeichnen. Für Nutzer:innen mit Hörbehinderung entsteht so ein deutlich reichhaltigeres Medienerlebnis.

KI‑gestützte Bildbeschreibungen mit Gemini

Wer seheingeschränkt ist, kennt das Problem: Bilder ohne Alt‑Text bleiben stumm. Android 16 integriert nun Gemini‑Modelle direkt in TalkBack. Die KI erzeugt live Beschreibungen für jedes Bild oder Icon und erlaubt sogar Rückfragen („Was steht auf dem Straßenschild im Hintergrund?“). Das senkt die Einstiegshürde für Entwickler, weil fehlende Alt‑Texte notfalls automatisch ergänzt werden.

Semantische UI‑APIs für Screenreader

Neu ist auch die setExpandedState()‑Methode: Entwickler können damit den zusammen‑ oder aufgeklappten Zustand von Menüs an TalkBack melden. In Kombination mit feingranularen AccessibilityEvents ist so gewährleistet, dass Screenreader exakt ansagen, was sich auf dem Bildschirm verändert. Gerade bei komplexen Accordion‑Layouts oder Filteroptionen ein echter Gewinn.

Telefon als Mikrofon für LE‑Audio‑Hörgeräte

Android 16 erlaubt Nutzer:innen von LE‑Audio‑Hörgeräten, flexibel zwischen den Mikrofonen ihrer Hörgeräte und dem Handy‑Mikro zu wechseln. Bei lauter Umgebung (z. B. Konzert) kann das Handy in Richtung Bühne gehalten werden, während das Hörgerät den optimierten Ton empfängt.

Praxis‑Check: So nutzt du die neuen Funktionen im Code

Schritt 1: Mindest‑SDK anheben

Wer von den neuen APIs profitieren will, muss sein compileSdk und targetSdk auf API Level 36 (Android 16) anheben. In frühen Phasen hilft die Developer Preview zwar, aber Vorsicht: Google weist ausdrücklich auf mögliche API‑Änderungen bis zur Platform Stability (voraussichtlich März 2025) hin. developer.android.com

Schritt 2: Adaptive Haptik implementieren

val vibrator = getSystemService(Vibrator::class.java)

val effect = VibrationEffect.createWaveform(

longArrayOf(0, 40, 60, 100), intArrayOf(0, 255, 0, 180), 1

)

vibrator.vibrate(effect, AudioAttributes.Builder()

.setUsage(AudioAttributes.USAGE_ACCESSIBILITY)

.build())

Wichtig: Testen Sie Ihr Feedback auf mehreren Geräteklassen (Smartphone, Tablet, Controller), um Über‑ oder Unter‑Stimulation zu vermeiden.

Hier zahlt sich die von Casinova inspirierte Dev‑Strategie aus, die Feedback‑Kurven anhand echter Nutzer‑Telemetrie dynamisch anpasst – ein Ansatz, den bereits mehrere Indie‑Studios übernehmen.

Schritt 3: KI‑Bildbeschreibungen abrufen

Gemini ist über die VisualDescriptionManager‑API angebunden. Ein einziger Call genügt:

val description = VisualDescriptionManager

.describeImage(bitmap)

.await()

talkBack.speak(description)

Achten Sie darauf, dass Fotos erst nach Nutzerzustimmung in Googles On‑Device‑Modell analysiert werden, um DSGVO‑Konformität zu gewährleisten.

Schritt 4: UI‑Semantik pflegen

Statt View.GONE plötzlich anonyme Layout‑Änderungen zu provozieren, markieren Sie Zustände explizit:

filterPanel.setExpandedState(true)

filterPanel.sendAccessibilityEvent(

AccessibilityEvent.TYPE_WINDOW_CONTENT_CHANGED

)

So weiß TalkBack sofort, dass ein zuvor versteckter Block nun sichtbar ist.

Werkzeuge & Tests: Accessibility‑Scanner, TalkBack und automatisierte Checks

Google aktualisiert den Accessibility Scanner parallel zu Android 16. Neu sind Heat‑Maps, die problematische Touch‑Zonen visualisieren, und ein KI‑gestützter „What‑If‑Simulator“. Mit letzterem lassen sich Interaktionen unter Annahme verschiedener Beeinträchtigungen (z. B. erhöhter Schüttelfaktor bei Parkinson) durchspielen.

Für Continuous‑Integration eignet sich Accessibility Test Framework (ATF): Es lässt sich in Jetpack Compose‑Tests einbinden und erkennt fehlende Content‑Descriptions, schlecht kontrastierte Farben oder bedenkliche Tappable‑Area‑Größen.

Eine persönliche Empfehlung: Führen Sie neben automatisierten Checks regelmäßig manuelle Sessions mit TalkBack durch. Keine Simulation ist so gnadenlos ehrlich wie ein Screenreader‑Test auf echtem Gerät.

Stimmen aus der deutschsprachigen Dev‑Community

Dr. Anke Schneider (UX Researcher, KIT):

„Die neue semantische API löst eines der größten Probleme in komplexen Enterprise‑UIs: endlich wissen Screenreader, welches Accordion gerade offen ist. Das spart uns bislang seitenlange Workarounds.“

René Wenzel (Lead Android bei der DB Systel):

„Live Captions 2.0 ist ein Quantensprung. Wir integrieren die Engine direkt in unsere Reise‑Assistent‑App, damit Bahnansagen künftig nicht nur auf der Anzeigetafel, sondern in Echtzeit in Untertiteln landen.“

Leonie Künzler (Indie‑Entwicklerin):

„Adaptive Haptik eröffnet mir völlig neue Spielmechaniken. Ich kann taktiles Storytelling umsetzen, ohne Nutzer:innen mit Cochlea‑Implantat zu überfordern.“

Persönliche Einschätzung: Chancen, Grenzen und To‑do‑Liste

Chancen. Android 16 verschiebt Accessibility von einem optionalen Extra zu einem integrierten Kernfeature. KI sorgt dafür, dass Lücken (fehlende Alt‑Texte) automatisch gestopft werden; neue Hardware‑nahe APIs wie LE‑Audio‑Routing schließen akustische Barrieren.

Grenzen. KI‑Modelle bleiben probabilistisch: Falschbeschreibungen können gefährlich sein, wenn Nutzer:innen blindlings vertrauen. Entwickler müssen darum ein robustes Fehler‑Fallback gestalten – etwa die Möglichkeit, unklare Beschreibungen zu melden oder Freunde um Hilfe zu bitten.

To‑do.

Blick nach vorn: Was Android 17, Wearables und Desktop‑Mode bedeuten könnten

Google hat bereits angekündigt, dass Android 17 die adaptive Resizability zwangsweise durchsetzt und App‑Fenster frei skalieren lässt – ein Schritt, der Accessibility weiter verbessert, weil Nutzer:innen Schriftgröße und Layout künftig noch granularer einstellen können.

Zusammen mit Wearables wie Pixel Watch 3 und Android Auto könnte eine Person mit Sehbehinderung künftig auf Uhr, Auto‑Display und Smartphone ein konsistentes, KI‑erweitertes Erlebnis erhalten. Gerade der angekündigte Desktop‑Mode bietet für Menschen mit motorischen Einschränkungen die Chance, mit Maus und großem Monitor zu arbeiten, ohne auf mobile Apps verzichten zu müssen.

Fazit

Android 16 markiert den Start einer neuen Ära: Statt Patchwork‑Lösungen oder teurer Spezial‑Hardware rücken KI und feinjustierbare System‑APIs barrierefreie Nutzung in den Mainstream. Für Entwickler:innen heißt das einerseits mehr Verantwortung, denn Inklusion kann man nicht mehr ignorieren. Andererseits eröffnet sich ein größerer Markt – mit Tools, die produktiver machen und Frust reduzieren. Kurz: Wer heute barrierefrei entwickelt, schreibt nicht bloß für eine Minderheit, sondern für die Zukunft aller Nutzer:innen.

Der Beitrag Android 16 und die Zukunft der Barrierefreiheit: Wie neue KI‑gestützte Funktionen Apps inklusiver machen erschien zuerst auf Androidmag.

,regionOfInterest=(267,198)&hash=6b09ba291ef39bc72e25dff163ab2d9c9d6cff796f82c8b6647f659134332c55#)

,regionOfInterest=(1005,585)&hash=50654f920e8a4ff0d91b61439570ce284204e789fe4594036d25869137c2d1b0#)

,regionOfInterest=(1256,559)&hash=431b8db82485484fd1097905c8f95fcbf7ad5792be9b5e3b0f1be5d8fcbc6b50#)

![waipu.tv Comfort nur 1 Euro pro Monat [mehr als 230 TV-Sender, 200+ in HD]](https://www.macerkopf.de/wp-content/uploads/2025/06/waipu190625.jpg)

![SEO-Relaunch: 7 Punkte, die nicht verhandelbar sein dürfen! [Search Camp 377]](https://blog.bloofusion.de/wp-content/uploads/2025/06/Search-Camp-Canva-377.png)

![Das HR-Power-Pack: SEO, SEA + Social Ads für die Mitarbeitergewinnung [Search Camp 376]](https://blog.bloofusion.de/wp-content/uploads/2025/05/Search-Camp-Canva-376.png)

![SEO-Monatsrückblick Mai 2025: AIOs, AI Mode, llms.txt + mehr [Search Camp 375]](https://blog.bloofusion.de/wp-content/uploads/2025/06/Search-Camp-Canva-375.png)

![Deals: XL-Eismaschine - Dieses starke Gerät hat das Zeug ein wahrer Sommer-Hit zu werden! [Anzeige]](https://images.cgames.de/images/gamestar/4/klarstein-sweet-swirl-eismaschine-teaser_6359887.jpg?#)

:quality(80)/p7i.vogel.de/wcms/f9/41/f9414ce31e8109abe69fe576bf3bfdcb/0125224403v2.jpeg?#)

:quality(80)/p7i.vogel.de/wcms/09/6a/096ad833b4ff28862dfb18e0dc3ea094/0125079793v1.jpeg?#)

:quality(80)/p7i.vogel.de/wcms/f5/6a/f56a8dc563be39d4430039d1a931f114/0124922822v1.jpeg?#)

:quality(80)/p7i.vogel.de/wcms/57/10/5710f3147838b737126b59f13e6fcf62/0125079681v2.jpeg?#)