Google testet Search Live: Kommt jetzt der Voice Shift in der Suche?

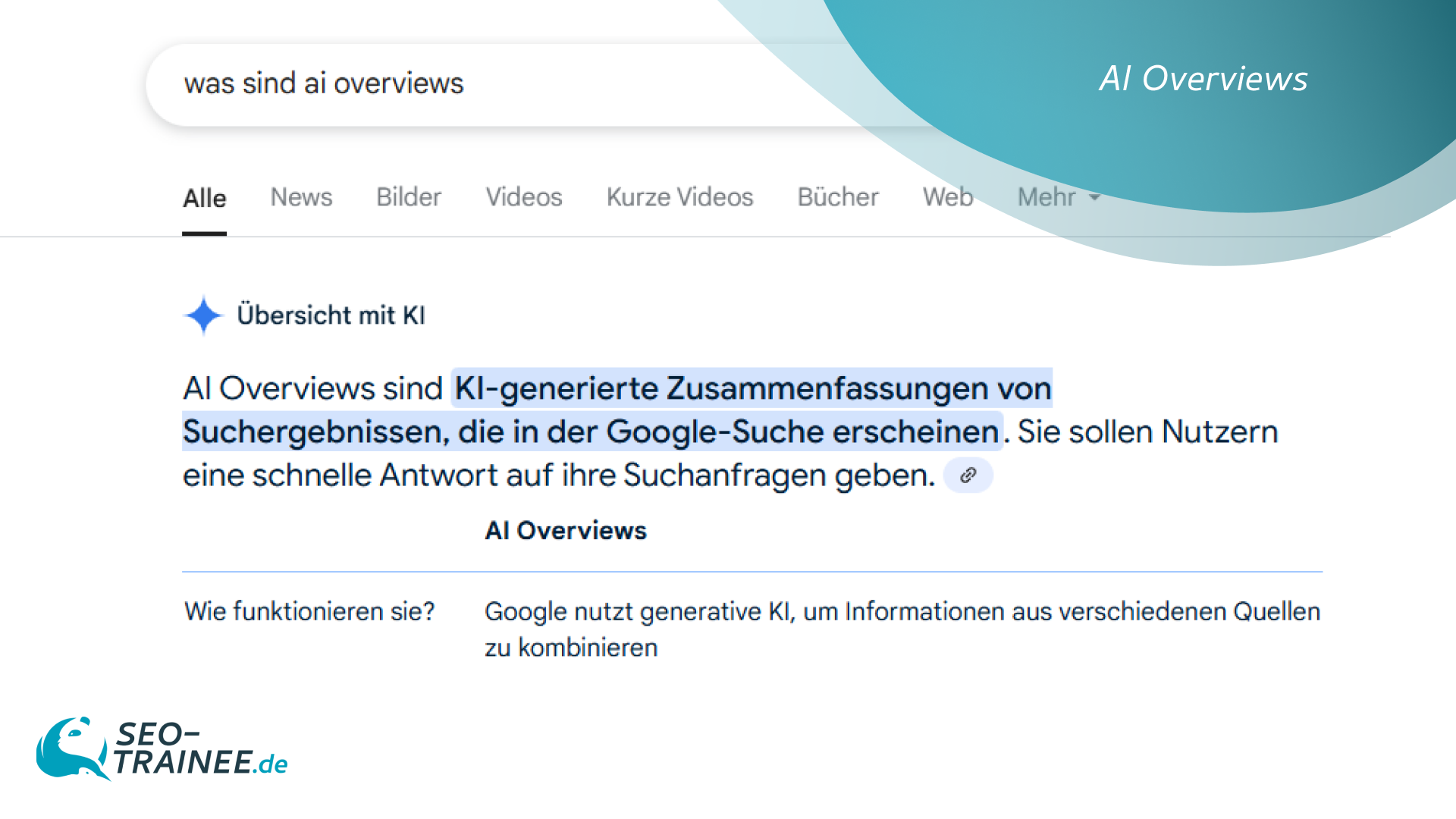

Der Gatekeeper der Suche stellt um: Google bringt mit Search Live erstmals KI-Voice-Chats in die mobile Suche. Das verändert, wie Nutzer:innen Fragen stellen – und wie Marken künftig Sichtbarkeit in Sprachdialogen erzielen können.

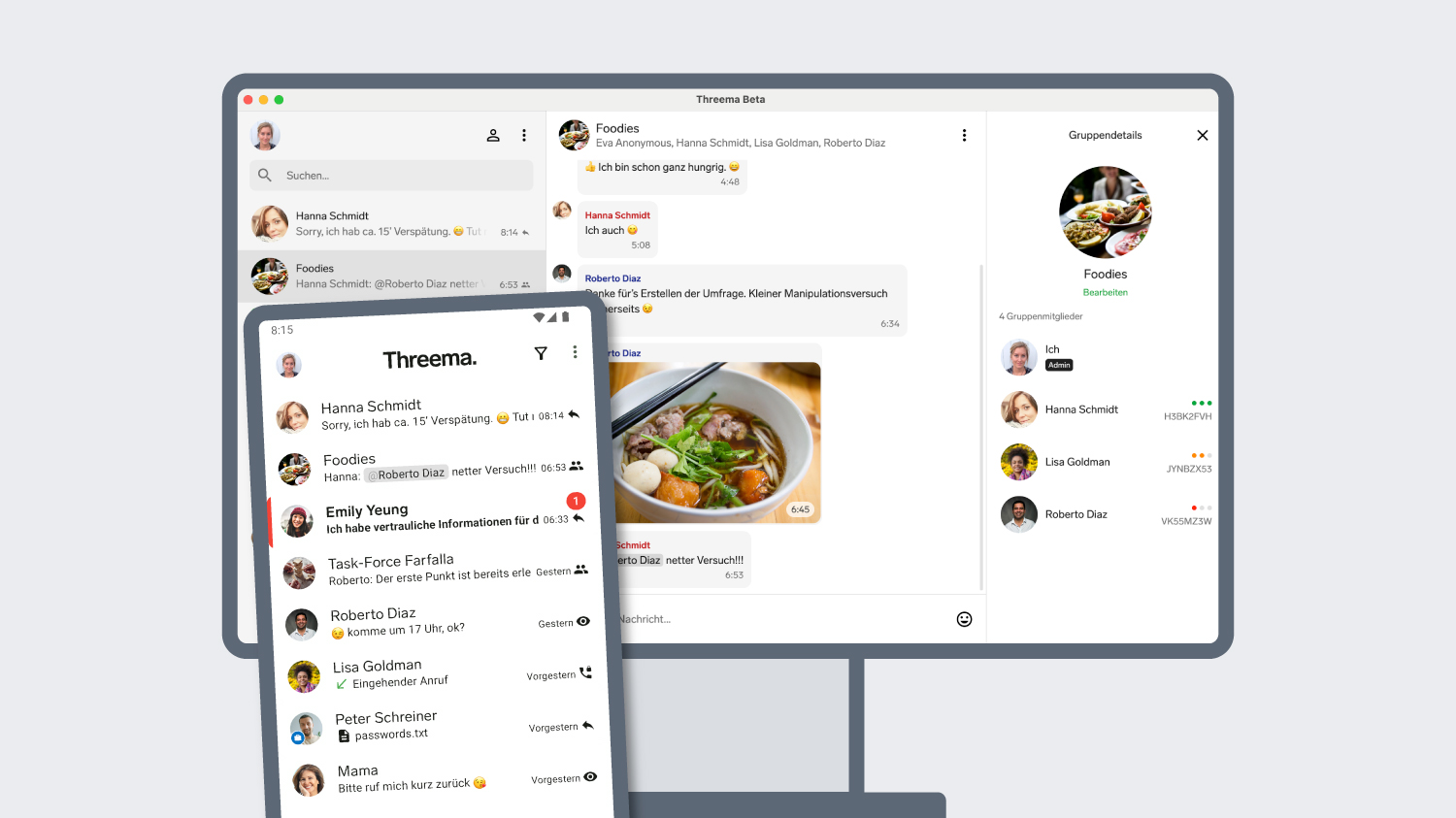

Während OpenAI mit dem Advanced Voice Mode für ChatGPT und dem multimodalen GPT-4o längst Maßstäbe bei Voice AI setzt, startet Google jetzt mit einer Beta für Search Live in den USA. Technologisch mag der Rückstand bestehen – doch der entscheidende Hebel liegt woanders: Search Live ist direkt in Googles mobile Suche integriert. Und dort beginnen täglich Milliarden von Suchanfragen.

Damit könnte Google trotz späterem Einstieg eine deutlich größere Alltagsreichweite erzielen als eigenständige KI-Chatbots wie ChatGPT oder Claude.

Das Konzept: Nutzer:innen führen per Sprache einen Echtzeitdialog mit der Gemini-KI. Antworten kommen als gesprochene Sätze zurück – ergänzt um passende Links. Search Live könnte damit das Suchverhalten grundlegend verändern und den Weg für eine AI-first-Suche ebnen.

Neben OpenAI investieren auch Anthropic und Apple massiv in KI-gestützte Voice Experiences. Google muss liefern, um seine Marktstellung bei der Suche zu behaupten.

Konversationen mit Google:

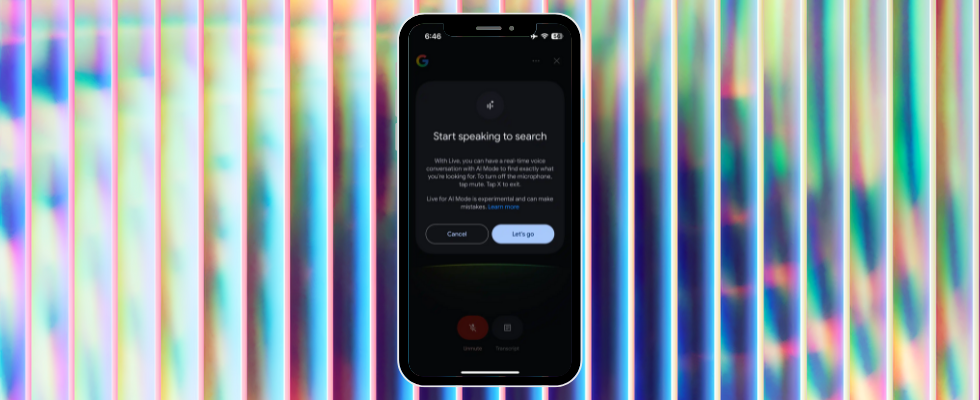

Search Live kommt in die App

Sprechen statt tippen: So funktioniert Googles Search Live

Mit Search Live will Google zeigen, wie sich KI-basierte Sucherlebnisse anfühlen können. Nutzer:innen stellen ihre Fragen per Sprache und erhalten direkt gesprochene Antworten.

Im Gegensatz zu herkömmlicher Sprachsuche bleibt es dabei nicht bei einzelnen Kommandos: Die Gemini-KI ermöglicht echte Folgefragen, der Dialog läuft flüssig weiter. Dabei bleibt das Feature auch im Hintergrund aktiv. Wer zwischendurch in eine andere App wechselt, kann das Gespräch trotzdem fortsetzen.

Auf Threads ansehen

Der von The Verge dokumentierte Google-Test zeigt: Während der Unterhaltung blendet Google passende Links zum Thema ein. Diese machen die Ergebnisse greifbar und führen tiefer in die Recherche. Über einen Transkript-Button lassen sich zudem die Antworten als Textversion anzeigen.

Wie Google im eigenen Blog beschreibt, basiert Search Live auf einer speziell angepassten Version des Gemini-Modells. Dieses wurde gezielt für die Anforderungen der Sprachsuche optimiert und greift auf die Qualitäts- und Informationssysteme der klassischen Google-Suche zurück. Ergänzend setzt Google auf die sogenannte „Query Fan-out“-Technologie: Dabei wird eine Anfrage automatisch in mehrere Varianten aufgespalten, um breitere, vielfältigere und kontextuell relevantere Inhalte aus dem Web zusammenzuführen. So sollen Nutzer:innen in den Voice Chats nicht nur eine direkte Antwort erhalten, sondern ein facettenreicheres Bild des jeweiligen Themas – inklusive ergänzender Links zur weiteren Vertiefung.

Google vs. OpenAI: Wer macht bei KI-Sprachsuche künftig das Rennen?

Mit Search Live will Google in einem Bereich aufschließen, den OpenAI aktuell anführt. Bereits im Sommer 2024 brachte OpenAI den Advanced Voice Mode für ChatGPT auf den Markt – im Oktober 2024 wurde er auch in Deutschland ausgerollt. Inzwischen ermöglicht GPT-4o fließende Sprachinteraktion, emotionale Stimmlagen und multimodale Nutzung. Im Mai dieses Jahres zog Anthropic mit einer Voice-Funktion für Claude nach, während Apples geplante LLM Siri bislang noch auf sich warten lässt, so ein Bloomberg-Bericht.

Googles Search Live setzt zunächst auf reine Sprachdialoge. Doch der entscheidende Unterschied liegt in der Einbettung: Während ChatGPT und Claude als separate Apps laufen, dockt Search Live direkt in der mobilen Google-Suche an. Damit könnte Google Milliarden Nutzer:innen erreichen – ohne Hürde beim Interface oder bei der App-Installation.

Für Google geht es um mehr als reine Technologie: Wer langfristig in der Alltagssuche relevant bleiben will, muss auch bei Voice-first Interfaces überzeugende Lösungen bieten. Denn KI-Sprachmodelle beginnen, das Suchverhalten vieler Nutzer:innen schrittweise zu verändern – und könnten mittelfristig neue Erwartungen an Sucherlebnisse prägen.

Multimodalität in Sicht: Bald auch mit Kamera

Doch Google denkt schon weiter. In den kommenden Monaten soll Search Live um Kamerafunktionen erweitert werden. Nutzer:innen könnten dann zeigen, worüber sie sprechen – etwa Produkte oder Sehenswürdigkeiten.

Damit nähert sich das Feature an multimodale Systeme wie ChatGPT Vision oder Metas neue AI-Modelle an. Für Google selbst bleibt die Sprachsuche aber ein wichtiger Hebel, um die klassischen Sucherlebnisse fit für das KI-Zeitalter zu machen. Wer tiefer in die jüngsten Modell-Updates eintauchen will, findet bei uns Details zur Optimierung von Gemini 2.5.

Intelligenter denn je:

Google optimiert Gemini 2.5 Pro

Google macht bringt Voice-Optionen in die Suche– und das dürfte SEO und UX bald verändern

Mit Search Live zeigt Google, wie ein künftiges KI-first Interface in der mobilen Suche aussehen könnte. Die klassische Suchleiste verliert an Dominanz, Sprachdialoge und Echtzeitantworten treten in den Vordergrund.

Für Nutzer:innen wird die Schwelle zur KI-Interaktion niedriger. Für SEO und Content-Strategien heißt das: Wer gefunden werden will, muss künftig noch stärker auf prägnante, konversationsfähige Inhalte setzen.

Google selbst liefert mit Search Live einen Vorgeschmack – der zeigt: Die Zeiten rein textbasierter Suche gehen zu Ende.

,regionOfInterest=(267,198)&hash=6b09ba291ef39bc72e25dff163ab2d9c9d6cff796f82c8b6647f659134332c55#)

,regionOfInterest=(1005,585)&hash=50654f920e8a4ff0d91b61439570ce284204e789fe4594036d25869137c2d1b0#)

,regionOfInterest=(1256,559)&hash=431b8db82485484fd1097905c8f95fcbf7ad5792be9b5e3b0f1be5d8fcbc6b50#)

![waipu.tv Comfort nur 1 Euro pro Monat [mehr als 230 TV-Sender, 200+ in HD]](https://www.macerkopf.de/wp-content/uploads/2025/06/waipu190625.jpg)

![SEO-Relaunch: 7 Punkte, die nicht verhandelbar sein dürfen! [Search Camp 377]](https://blog.bloofusion.de/wp-content/uploads/2025/06/Search-Camp-Canva-377.png)

![Das HR-Power-Pack: SEO, SEA + Social Ads für die Mitarbeitergewinnung [Search Camp 376]](https://blog.bloofusion.de/wp-content/uploads/2025/05/Search-Camp-Canva-376.png)

![SEO-Monatsrückblick Mai 2025: AIOs, AI Mode, llms.txt + mehr [Search Camp 375]](https://blog.bloofusion.de/wp-content/uploads/2025/06/Search-Camp-Canva-375.png)

![Deals: XL-Eismaschine - Dieses starke Gerät hat das Zeug ein wahrer Sommer-Hit zu werden! [Anzeige]](https://images.cgames.de/images/gamestar/4/klarstein-sweet-swirl-eismaschine-teaser_6359887.jpg?#)

:quality(80)/p7i.vogel.de/wcms/f9/41/f9414ce31e8109abe69fe576bf3bfdcb/0125224403v2.jpeg?#)

:quality(80)/p7i.vogel.de/wcms/09/6a/096ad833b4ff28862dfb18e0dc3ea094/0125079793v1.jpeg?#)

:quality(80)/p7i.vogel.de/wcms/f5/6a/f56a8dc563be39d4430039d1a931f114/0124922822v1.jpeg?#)

:quality(80)/p7i.vogel.de/wcms/57/10/5710f3147838b737126b59f13e6fcf62/0125079681v2.jpeg?#)