GPT-4.1 von OpenAI ist da – und setzt neue Maßstäbe

OpenAI veröffentlicht GPT-4.1, mini und nano – drei Modelle, die sich deutlich vom Vorgänger GPT-4o abheben. Mit größerem Kontextfenster, präziserer Befolgung von Anweisungen und einer deutlich günstigeren API-Preisstruktur könnten sie sich schnell als neuer Standard im KI-Alltag etablieren – besonders für Developer, die auf Effizienz und Skalierbarkeit setzen.

Key Takeaways zur GPT-4.1-Serie von OpenAI

- Die 4.1-Familie besteht aus drei Modellen: GPT-4.1, 4.1 mini und 4.1 nano bieten abgestufte Leistungsniveaus für unterschiedliche Anforderungen – von High-End Coding bis hin zu schnellen Klassifikationen.

- Ein Kontextfenster mit bis zu einer Million Tokens erlaubt es den Modellen, extrem große Textmengen – etwa ganze Repositories – auf einmal zu analysieren. Das ist besonders für Unternehmen im Bereich Legal Tech oder Data Management spannend.

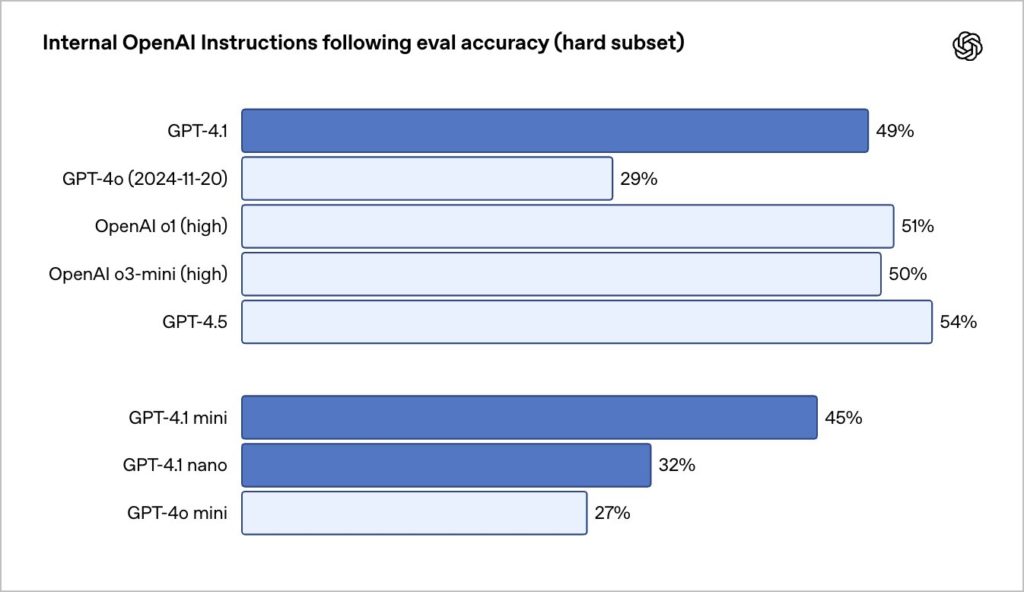

- Deutlich bessere Instruction-Following-Fähigkeiten: GPT-4.1 folgt komplexen Anweisungen wesentlich präziser als frühere Modelle – mit 49 Prozent Genauigkeit gegenüber 29 Prozent bei GPT-4o.

- Preis-Leistungs-Verhältnis überzeugt: Die Modelle sind nicht nur leistungsfähiger, sondern auch günstiger als ihre Vorgänger:innen. GPT-4.1 nano etwa kostet nur 0,10 US-Dollar pro eine Million Tokens Eingabe.

- KI-Expert:innen sehen enormes Potenzial: Tech Influencer Jens Polomski hebt hervor, dass das Zusammenspiel aus Intelligenz, Preis und Kontextlänge erstmals wirklich rund sei – und rechnet mit rascher Integration der Modelle in viele Tools.

OpenAIs GPT-4.1-Serie: Mehr Kontext, mehr Können, weniger Kosten

Die KI-Entwicklung rast weiter – und OpenAI legt mit der 4.1-Serie gleich dreifach nach: GPT-4.1, GPT-4.1 mini und GPT-4.1 nano. Drei neue Modelle, ein Ziel: Developer, Toolbuilder und Unternehmen sollen bei geringeren Kosten und schnellerer Antwortgeschwindigkeit dennoch von starker Performance profitieren. Erste Tests in der Praxis zeigen, dass diese Zusicherung kein reines Marketing-Versprechen ist. Laut OpenAI handelt es sich bei der neuen 4.1-Serie um ein bedeutendes Upgrade, das speziell für den Einsatz im Bereich praxisnaher Software-Entwicklung konzipiert wurde.

The GPT-4.1 family is a major upgrade over GPT-4o for real-world software engineering work.

It’s significantly more skilled at frontend coding, suggesting clean diffs, structured responses, reliable tool use, and more. pic.twitter.com/tYQ9rUcEQu— OpenAI Developers (@OpenAIDevs) April 14, 2025

Die Modelle zeigen deutliche Verbesserungen bei der Code-Generierung, dem Befolgen von Anweisungen und beim Verarbeiten großer Textmengen. Auch der Tech Influencer Jens Polomski betont in einem LinkedIn-Beitrag das Potenzial der Serie.

Er hebt besonders hervor, dass die neuen Modelle nicht nur ein deutlich größeres Kontextfenster von einer Million Tokens bieten, sondern auch über einen aktuelleren Wissensstand (bis Juni 2024) verfügen. Für ihn ist das ein klarer Fortschritt gegenüber bisherigen Versionen. Zwar sieht er beim Thema Geschwindigkeit noch Raum für Optimierung, doch insgesamt empfindet er das Update als äußerst spannend – insbesondere, weil GPT-4.1 erstmals das Zusammenspiel aus Intelligenz, Kosten und Effizienz auf ein neues Level hebt. Seinem Eindruck nach dürften viele Anbieter:innen das Modell bald in ihre Tools integrieren, da die API-Preise konkurrenzfähig und praxisnah gestaltet sind. Er kündigt zudem an, in den kommenden Tagen noch weitere Beiträge zu den neuen Modellen zu veröffentlichen.

Dreifach-Upgrade: GPT-4.1, 4.1 mini und 4.1 nano im Vergleich

OpenAI positioniert die 4.1-Familie klar entlang eines Spektrums aus Intelligenz, Geschwindigkeit und Preis:

- GPT-4.1: Das neue Flaggschiff unter den Modellen bietet die höchste Intelligenzleistung, ist besonders geeignet für komplexe Aufgaben wie Software-Entwicklung, die Verarbeitung mehrerer Dokumente oder juristische Recherchen. Mit 55 Prozent beim SWE-Bench Verified übertrifft es nicht nur GPT-4o (33 Prozent), sondern auch GPT-4.5 (38 Prozent).

- GPT-4.1 mini: Ein ausgewogener Mittelweg aus Leistung und Effizienz. Das Modell erreicht 24 Prozent SWE-Bench-Genauigkeit, 45 Prozent bei der Befolgung von Anweisungen (interne Tests) und kostet nur 0,40 US-Dollar pro eine Million Tokens Eingabe. Auch bei der Bildverarbeitung (MMMU: 73 Prozent) liegt es vor GPT-4o mini (56 Prozent).

- GPT-4.1 nano: Das schnellste und günstigste Modell der Serie. Für nur 0,10 US-Dollar pro eine Million Tokens Eingabe eignet es sich ideal für leichtere Aufgaben wie Klassifikation, Autovervollständigung oder einfache Agent-Logiken mit kurzen Kontexten. Trotz der kompakten Größe kann das Modell ebenfalls mit bis zu einer Million Kontexttokens umgehen.

Im offiziellen Video zur Einführung von GPT-4.1 veranschaulicht OpenAI, welche konkreten Verbesserungen die neuen Modelle mitbringen. In der Demo wird auch gezeigt, wie effizient GPT-4.1 bei realen Entwickler:innen-Workflows agiert, etwa bei Tool-Aufrufen und der Bearbeitung großer Dateien.

Langkontext-Verarbeitung: Eine Million Token als neuer Standard

Ein zentrales Feature aller drei Modelle: Sie verarbeiten bis zu einer Million Tokens Kontext.

All three models can now handle up to 1 million tokens of context (over 8× the React codebase!), so they can process large repositories and lots of long documents.

To showcase improvements in long-context understanding, we’re releasing OpenAI MRCR, a new open-source eval that… pic.twitter.com/dfTvez7XpE— OpenAI Developers (@OpenAIDevs) April 14, 2025

Damit sind sie laut OpenAI in der Lage, mehrere tausend Seiten Text, umfangreiche Code-Sammlungen oder lange Gesprächsprotokolle gleichzeitig auszuwerten – ohne, dass Informationen in der Mitte des Kontexts verloren gehen. Besonders für den Einsatz in der Rechtsberatung, im unternehmensweiten Wissens-Management oder bei der Analyse großer Textmengen ist das ein echter Durchbruch.

Zur Qualitätsmessung dieser Fähigkeit hat OpenAI das OpenAI-MRCR (Multi-Round Coreference) eingeführt – ein Testverfahren, das prüft, ob ein Modell mehrere relevante Informationen aus langen Kontexten korrekt extrahieren und voneinander unterscheiden kann. GPT-4.1 zeigt in diesem Kontext eine stabile und präzise Leistung, selbst bei maximaler Kontextlänge.

GPT-4.1 ist deutlich präziser

In der internen Auswertung zur Befolgung komplexer Anweisungen erzielt GPT-4.1 eine Genauigkeit von 49 Prozent, GPT-4.1 mini liegt bei 45 Prozent, GPT-4.1 nano bei 32 Prozent. Zum Vergleich: GPT-4o kommt hier auf 29 Prozent, GPT-4o mini nur auf 27 Prozent.

Diese Genauigkeit wird besonders bei verschachtelten Prompts deutlich, etwa bei der Aufforderung: „Sortiere nach Alphabet, aber schließe alle Ergebnisse mit weniger als drei Zeichen aus und gib die Länge jedes Wortes an.“ Solche komplexen Anforderungen konnten frühere Modelle oft nur unzuverlässig umsetzen – GPT-4.1 hingegen meistert sie. Für Entwickler:innen bedeutet das verlässlichere Abläufe bei der Erstellung von Agents und Workflows. Weitere Hintergründe zur Modellstrategie liefert unser Artikel zum Open-Weight-Modell von OpenAI.

Was OpenAIs neues Open-Weight-Modell ausmacht

Coding: GPT-4.1 überzeugt mit Struktur, Präzision und Tool-Integration

Auch beim Programmieren setzt GPT-4.1 Maßstäbe: Ob bei der Erstellung moderner Frontends mit React oder beim Erzeugen von strukturierten Code Diffs – das Modell liefert konsistente, verständliche und sauber formatierte Ergebnisse. Qodo hat GPT-4.1 in einem internen Test gegen andere Modelle antreten lassen: In 55 Prozent der Fälle war es der klare Favorit. Windsurf berichtet sogar von einer um 60 Prozent höheren Treffergenauigkeit im Vergleich zu GPT-4o.

More details on model performance, a full eval rundown, and real-world results from developers at @windsurf_ai , @QodoAI , @_hex_tech , @BlueJLegal , @thomsonreuters and @OneCarlyle in our blog.https://t.co/4vBawhLADy— OpenAI Developers (@OpenAIDevs) April 14, 2025

Ein besonders hilfreiches Feature: GPT-4.1 kann bis zu 32.768 Tokens ausgeben. Damit lassen sich ganze Dateien effizient generieren oder verändern – ideal für Entwickler:innen, die mit längeren Code-Abschnitten oder Texten arbeiten.

Visuelle Aufgaben? Kein Problem!

GPT-4.1 und insbesondere GPT-4.1 mini zeigen auch bei der Bildverarbeitung starke Leistungen. In Benchmarks wie MMMU, MathVista und CharXiv liegt die Serie konstant über GPT-4o. Das macht sie besonders attraktiv für kreative Anwendungsfelder wie visuelle Content-Erstellung, UI-Design oder das automatische Auswerten von Schaubildern. Wer mehr zur Bildverarbeitung mit KI wissen will, findet im Beitrag zur visuellen Bildgenerierung mit GPT-4o weitere Informationen.

ChatGPT bekommt eine neue visuelle Dimension:

OpenAI führt Bildgenerierung mit GPT-4o ein

Preisstruktur: Deutlich günstiger bei ähnlicher Leistung

Die Modelle der GPT-4.1-Familie zeichnen sich durch eine Kombination aus Leistungsfähigkeit und kosteneffizienter Preisstruktur aus.Modell Input / eine Million Tokens Zwischengespeicherter Input Output / eine Million Tokens GPT-4.1 2 US-Dollar 0,50 US-Dollar 8 US-Dollar GPT-4.1 mini 0,40 US-Dollar 0,10 US-Dollar 1,60 US-Dollar GPT-4.1 nano 0,10 US-Dollar 0,25 US-Dollar 0,40 US-Dollar

Besonders spannend: Für häufige Prompts gibt es 75 Prozent Rabatt auf zwischengespeicherte Eingaben. Zudem bietet OpenAI alle drei Modelle auch über die Batch API an – mit weiteren 50 Prozent Rabatt.

GPT-4.5 geht, GPT-4.1 übernimmt

Mit dem Launch der neuen Modellreihe verabschiedet sich OpenAI offiziell von GPT-4.5 – die Preview-Version wird zum 14. Juli 2025 aus der API entfernt. Viele der geschätzten Stärken wie Kreativität, stilistische Feinheit und humorvolle Ausdrucksweise sind in die neue 4.1-Serie eingeflossen – ergänzt durch bessere Performance, geringere Kosten und schnellere Reaktionszeiten.

One last note: we’ll also begin deprecating GPT-4.5 Preview in the API today as GPT-4.1 offers improved or similar performance on many key capabilities at lower latency and cost. GPT-4.5 in the API will be turned off in three months, on July 14, to allow time to transition (and…— OpenAI Developers (@OpenAIDevs) April 14, 2025

GPT-4.1, mini und nano sind damit mehr als nur Versions-Updates: Sie sind praxisnahe Werkzeuge für Developer, Unternehmen und Kreativschaffende, die smarte Assistenzsysteme, automatisierte Recherchelösungen oder multimodale Anwendungen entwickeln.

,regionOfInterest=(1029,772)&hash=f6d43959338da8730f2364bfbf7e06c06bb2beb8ccfbb9fc1befe896e501bdb3#)

![SEO-Monatsrückblick März 2025: Google AIO in DE, AI Mode, LLMs + mehr [Search Camp 369]](https://blog.bloofusion.de/wp-content/uploads/2025/03/Search-Camp-Canva-369.png)

![Deals: Magic: The Gathering - Die Drachen sind los im neuen und besten Set des Jahres [Anzeige]](https://images.cgames.de/images/gamestar/4/dragonstorm-teaser_6348938.jpg?#)

:quality(80)/p7i.vogel.de/wcms/ff/b4/ffb40046e35d80b012f5d322d3606e21/0124003211v1.jpeg?#)

:quality(80)/p7i.vogel.de/wcms/b7/71/b771a4a0199910c14f6223162383d75f/0124144076v1.jpeg?#)

:quality(80)/p7i.vogel.de/wcms/77/81/778160cdf42db195f3bb723282065ce2/0122969592v1.jpeg?#)

:quality(80)/p7i.vogel.de/wcms/82/3d/823d8418492c6bca797a6454b0d0bca5/0123745610v2.jpeg?#)