iOS 26 erkennt ob euer Kameraobjektiv verschmutzt ist

Zu den zahlreichen kleinen Neuerungen, auf die Apple im Rahmen der Ankündigung von iOS 26 nicht näher eingegangen ist, gehört auch eine Funktion namens „Lens Cleaning Hints“. Apple greift dabei auf Funktionen aus dem Bereich maschinelles Lernen zurück, um Verschmutzungen auf der Kameralinse zu erkennen. Die Software kann den Benutzer dann auf diesen Umstand hinweisen […] Der Beitrag iOS 26 erkennt ob euer Kameraobjektiv verschmutzt ist erschien zuerst auf iphone-ticker.de.

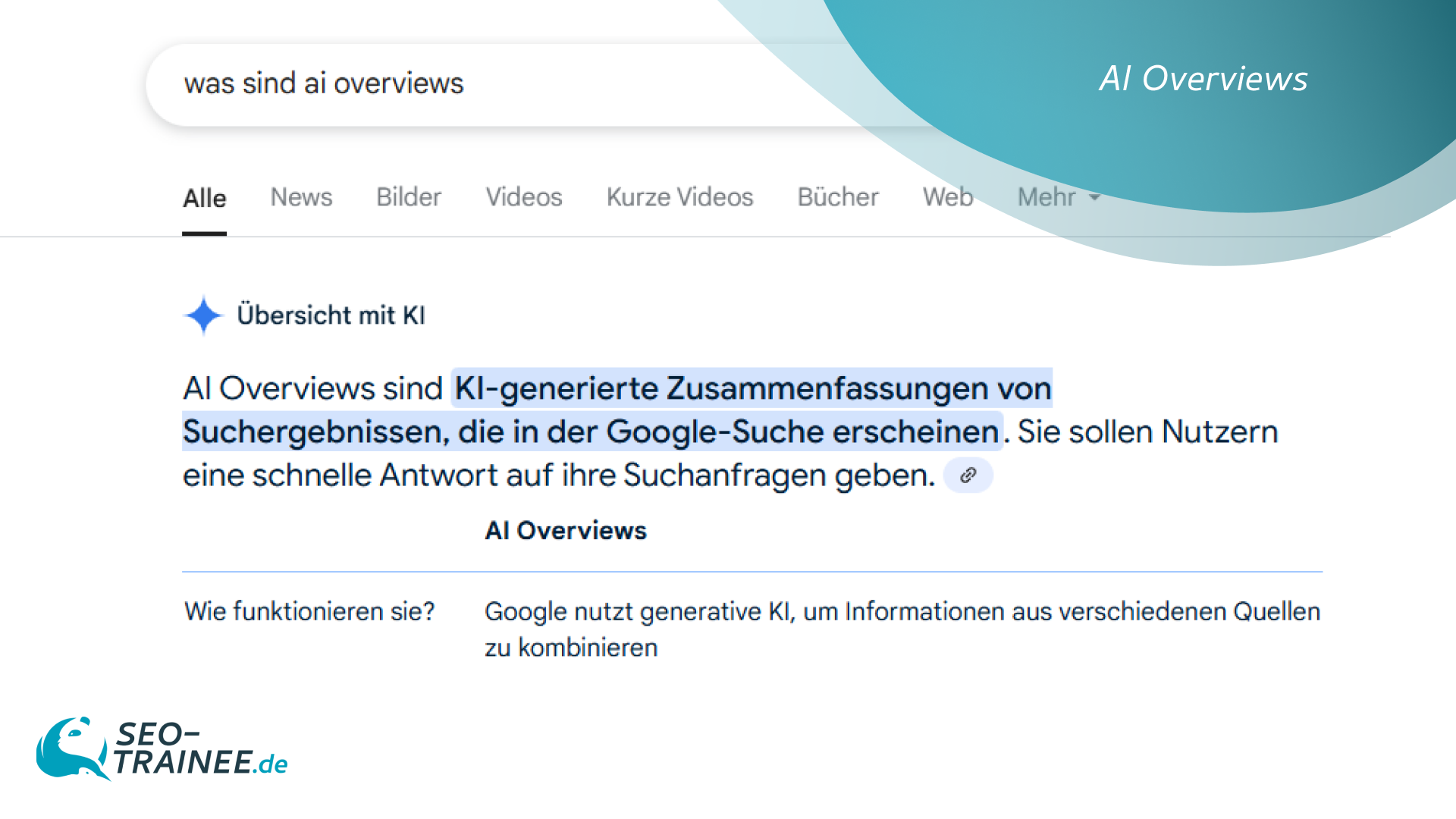

Zu den zahlreichen kleinen Neuerungen, auf die Apple im Rahmen der Ankündigung von iOS 26 nicht näher eingegangen ist, gehört auch eine Funktion namens „Lens Cleaning Hints“.

Apple greift dabei auf Funktionen aus dem Bereich maschinelles Lernen zurück, um Verschmutzungen auf der Kameralinse zu erkennen. Die Software kann den Benutzer dann auf diesen Umstand hinweisen und ist dabei auch in der Lage, den Grad der Verschmutzung der Kamera auf einer Skala von 0,1 bis 1 zu bestimmen.

Beispielbilder: Apple

Die Analyse erfolgt unter Verwendung von maschinellen Lernfunktionen lokal auf dem iPhone. Dabei werden im Hintergrund mehrere vom Nutzer aufgenommene Bilder verglichen, um beispielsweise Schlieren auf der Linse zu erkennen, die durch eine ungewollte Berührung mit den Fingern entstanden sind.

Meldung ab bestimmtem Schwellwert

Die Möglichkeit zur Erkennung von Verschmutzungen auf der Kameralinse wurde in Apples Vision-Framework integriert und steht auf diesem Weg allen Entwicklern zur Verfügung, die ihre Apps um eine solche Funktion erweitern wollen.

Beispielsweise kann eine Kamera-App ihren Nutzer auf dieser Basis dazu anweisen, die Objektive zu reinigen, bevor man damit neue Bilder aufnimmt. Dabei entscheidet der Entwickler nicht nur ob, sondern auch wann eine solche Meldung angezeigt wird. Der Hinweis lässt sich mit einem bestimmten Grad der Verschmutzung verbinden. Dabei muss sich der Entwickler dafür entscheiden, ob er lieber einen sehr frühen Hinweis anzeigen will und damit verbunden die Gefahr von Falschmeldungen akzeptiert oder den Nutzer erst dann warnen will, wenn die Objektive definitiv verschmutzt und die Bildqualität bereits massiv nachgelassen hat.

Apps können auch Bildästhetik und -qualität abfragen

Das Vision-Framework von Apple steht Entwicklern seit mehreren Jahren zur Verfügung und bietet die Möglichkeit, auf interessante Funktionen im Zusammenhang mit der Fotos-App und der Nutzung der Kamera zuzugreifen. Beispielsweise kann man damit auch vorhandene Bilder auf ihre Ästhetik oder die Qualität von darauf abgebildeten Gesichtern untersuchen, was sich Anwendungen wie PhotoSort zunutze machen.

Der Beitrag iOS 26 erkennt ob euer Kameraobjektiv verschmutzt ist erschien zuerst auf iphone-ticker.de.

,regionOfInterest=(267,198)&hash=6b09ba291ef39bc72e25dff163ab2d9c9d6cff796f82c8b6647f659134332c55#)

,regionOfInterest=(1005,585)&hash=50654f920e8a4ff0d91b61439570ce284204e789fe4594036d25869137c2d1b0#)

,regionOfInterest=(1256,559)&hash=431b8db82485484fd1097905c8f95fcbf7ad5792be9b5e3b0f1be5d8fcbc6b50#)

![waipu.tv Comfort nur 1 Euro pro Monat [mehr als 230 TV-Sender, 200+ in HD]](https://www.macerkopf.de/wp-content/uploads/2025/06/waipu190625.jpg)

![SEO-Relaunch: 7 Punkte, die nicht verhandelbar sein dürfen! [Search Camp 377]](https://blog.bloofusion.de/wp-content/uploads/2025/06/Search-Camp-Canva-377.png)

![Das HR-Power-Pack: SEO, SEA + Social Ads für die Mitarbeitergewinnung [Search Camp 376]](https://blog.bloofusion.de/wp-content/uploads/2025/05/Search-Camp-Canva-376.png)

![SEO-Monatsrückblick Mai 2025: AIOs, AI Mode, llms.txt + mehr [Search Camp 375]](https://blog.bloofusion.de/wp-content/uploads/2025/06/Search-Camp-Canva-375.png)

![Deals: XL-Eismaschine - Dieses starke Gerät hat das Zeug ein wahrer Sommer-Hit zu werden! [Anzeige]](https://images.cgames.de/images/gamestar/4/klarstein-sweet-swirl-eismaschine-teaser_6359887.jpg?#)

:quality(80)/p7i.vogel.de/wcms/f9/41/f9414ce31e8109abe69fe576bf3bfdcb/0125224403v2.jpeg?#)

:quality(80)/p7i.vogel.de/wcms/09/6a/096ad833b4ff28862dfb18e0dc3ea094/0125079793v1.jpeg?#)

:quality(80)/p7i.vogel.de/wcms/f5/6a/f56a8dc563be39d4430039d1a931f114/0124922822v1.jpeg?#)

:quality(80)/p7i.vogel.de/wcms/57/10/5710f3147838b737126b59f13e6fcf62/0125079681v2.jpeg?#)