Pensábamos que las nuevas IA alucinaban más que nunca. En realidad, el problema lo tiene OpenAI

La inteligencia artificial está experimentando un avance sin precedentes en capacidades y razonamiento, pero también nos enfrentamos a un fenómeno curioso: mientras algunos modelos mejoran su precisión, otros parecen estar incrementando sus tasas de alucinación. Los datos recientes revelan una tendencia que contradice la narrativa dominante en el sector. Y es que si bien los últimos modelos de razonamiento de OpenAI (o3 y o4-mini) nos han deleitado con funciones avanzadas sorprendentes, su tasa de alucinación es preocupante, aunque esto no parece estar extendiéndose en el resto de modelos de otras compañías. Índice de Contenidos (3) Hay modelos con tasas de alucinación muy bajas, pero ni o3 ni o4-mini están entre ellos Más inteligentes pero menos fiables El complicado camino hacia la AGI Hay modelos con tasas de alucinación muy bajas, pero ni o3 ni o4-mini están entre ellos Cuando hablamos de "alucinaciones" en IA nos referimos a esas respuestas inventadas que los sistemas generan con total convicción pero que carecen de fundamento real. Un problema que, según algunas conversaciones en torno al rendimiento de los modelos de IA, parecía estar empeorando con cada nueva generación de modelos más avanzados. Imagen: Vectara Sin embargo, los datos del benchmark de Vectara (Hallucination Leaderboard) muestran una realidad diferente. Según esta clasificación actualizada a finales de abril de 2025, las tasas de alucinación de los principales modelos de lenguaje no solo no están aumentando de forma generalizada, sino que algunos de los sistemas más recientes presentan los índices más bajos. El gráfico revela que modelos como Google Gemini-2.0-Flash-001 (0,7%), Google Gemini-2.0-Pro-Exp (0,8%) y Vectara Mockingbird-2-Echo (0,9%) lideran la clasificación con tasas inferiores al 1%, muy por debajo de la media. En este panorama generalmente positivo destaca una notable excepción: OpenAI. Mientras sus competidores parecen estar mejorando en precisión, los nuevos modelos de la compañía muestran un comportamiento no deseado en términos de alucinación. En Genbeta Zuckerberg reconoce que Facebook ya no sirve para conectar amigos y familia. Y afirma que será la IA quien se haga 'amiga' nuestra El modelo o3-mini-high de OpenAI registra una tasa de alucinación del 0,8%, lo que parece prometedor. Sin embargo, esta cifra contrasta fuertemente con los problemas reconocidos por la propia compañía en sus modelos de razonamiento más avanzados, como o3 y o4-mini. Según Ethan Mollick, profesor en Wharton y experto en IA, el modelo o3 presenta una tasa de alucinación del 6,8%, una cifra alarmante cuando se compara con sus competidores directos. Esta situación es particularmente preocupante porque ocurre precisamente en los modelos que OpenAI está promoviendo como su tecnología más avanzada para resolución de problemas complejos. Más inteligentes pero menos fiables La situación plantea una paradoja interesante: los modelos con mayores capacidades de razonamiento de OpenAI, aquellos diseñados para realizar tareas más complejas y actuar con mayor autonomía, son también los que presentan mayores problemas de fiabilidad en sus respuestas. De igual manera, Mollick también menciona al laureado DeepSeek R1, con una tasa de alucinación del 14,3% según el benchmark, una cifra bastante más seria. Mientras tanto, compañías como Google parecen haber encontrado un mejor equilibrio entre potencia y precisión. Sus modelos Gemini más recientes no solo ofrecen capacidades avanzadas sino que mantienen tasas de alucinación notablemente bajas. En Genbeta He puesto a la IA a ver todo lo que hago en mi navegador y sorprende tanto como asusta: así transforma Copilot mi forma de navegar El complicado camino hacia la AGI Los datos sugieren que el enfoque de OpenAI, que prioriza capacidades de razonamiento cada vez más sofisticadas, podría estar sacrificando la fiabilidad básica de sus sistemas. De igual forma, ninguna compañía quiere que sus modelos no sean fiables, por lo que al menos tranquiliza que OpenAI sea consciente de que sus propios modelos tienen una mayor tasa de alucinación, ya que eso les ayudará a corregir antes los problemas que esto ocasione. Esta claro que nos encontramos en un momento vital para la evolución de la IA generativa. La carrera por lograr una inteligencia artificial general (AGI) está produciendo sistemas cada vez más potentes, pero el verdadero desafío será conseguir que esta potencia esté respaldada por una fiabilidad equivalente. Imagen de portada | Levart_Photographer En Genbeta | Un mapa detalla la investigación sobre cómo empresas de IA del mundo

La inteligencia artificial está experimentando un avance sin precedentes en capacidades y razonamiento, pero también nos enfrentamos a un fenómeno curioso: mientras algunos modelos mejoran su precisión, otros parecen estar incrementando sus tasas de alucinación.

Los datos recientes revelan una tendencia que contradice la narrativa dominante en el sector. Y es que si bien los últimos modelos de razonamiento de OpenAI (o3 y o4-mini) nos han deleitado con funciones avanzadas sorprendentes, su tasa de alucinación es preocupante, aunque esto no parece estar extendiéndose en el resto de modelos de otras compañías.

Índice de Contenidos (3)

Hay modelos con tasas de alucinación muy bajas, pero ni o3 ni o4-mini están entre ellos

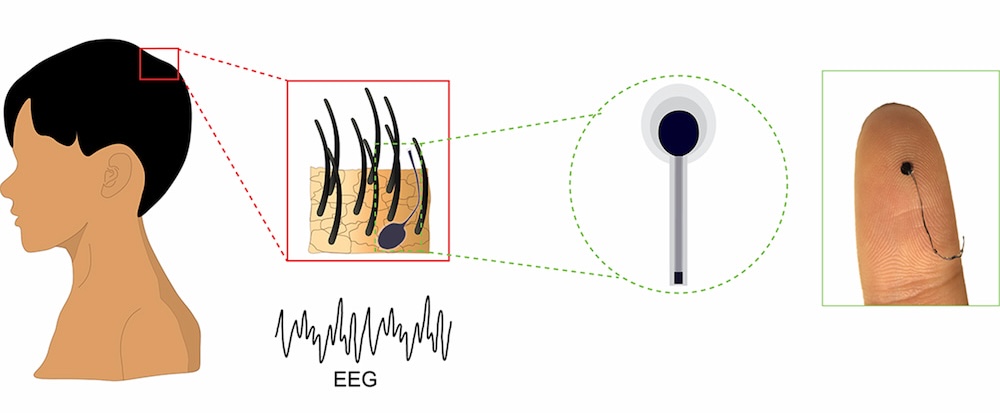

Cuando hablamos de "alucinaciones" en IA nos referimos a esas respuestas inventadas que los sistemas generan con total convicción pero que carecen de fundamento real. Un problema que, según algunas conversaciones en torno al rendimiento de los modelos de IA, parecía estar empeorando con cada nueva generación de modelos más avanzados.

Imagen: Vectara

Imagen: Vectara

Sin embargo, los datos del benchmark de Vectara (Hallucination Leaderboard) muestran una realidad diferente. Según esta clasificación actualizada a finales de abril de 2025, las tasas de alucinación de los principales modelos de lenguaje no solo no están aumentando de forma generalizada, sino que algunos de los sistemas más recientes presentan los índices más bajos.

El gráfico revela que modelos como Google Gemini-2.0-Flash-001 (0,7%), Google Gemini-2.0-Pro-Exp (0,8%) y Vectara Mockingbird-2-Echo (0,9%) lideran la clasificación con tasas inferiores al 1%, muy por debajo de la media.

En este panorama generalmente positivo destaca una notable excepción: OpenAI. Mientras sus competidores parecen estar mejorando en precisión, los nuevos modelos de la compañía muestran un comportamiento no deseado en términos de alucinación.

El modelo o3-mini-high de OpenAI registra una tasa de alucinación del 0,8%, lo que parece prometedor. Sin embargo, esta cifra contrasta fuertemente con los problemas reconocidos por la propia compañía en sus modelos de razonamiento más avanzados, como o3 y o4-mini.

Según Ethan Mollick, profesor en Wharton y experto en IA, el modelo o3 presenta una tasa de alucinación del 6,8%, una cifra alarmante cuando se compara con sus competidores directos. Esta situación es particularmente preocupante porque ocurre precisamente en los modelos que OpenAI está promoviendo como su tecnología más avanzada para resolución de problemas complejos.

Más inteligentes pero menos fiables

La situación plantea una paradoja interesante: los modelos con mayores capacidades de razonamiento de OpenAI, aquellos diseñados para realizar tareas más complejas y actuar con mayor autonomía, son también los que presentan mayores problemas de fiabilidad en sus respuestas.

De igual manera, Mollick también menciona al laureado DeepSeek R1, con una tasa de alucinación del 14,3% según el benchmark, una cifra bastante más seria. Mientras tanto, compañías como Google parecen haber encontrado un mejor equilibrio entre potencia y precisión. Sus modelos Gemini más recientes no solo ofrecen capacidades avanzadas sino que mantienen tasas de alucinación notablemente bajas.

El complicado camino hacia la AGI

Los datos sugieren que el enfoque de OpenAI, que prioriza capacidades de razonamiento cada vez más sofisticadas, podría estar sacrificando la fiabilidad básica de sus sistemas. De igual forma, ninguna compañía quiere que sus modelos no sean fiables, por lo que al menos tranquiliza que OpenAI sea consciente de que sus propios modelos tienen una mayor tasa de alucinación, ya que eso les ayudará a corregir antes los problemas que esto ocasione.

Esta claro que nos encontramos en un momento vital para la evolución de la IA generativa. La carrera por lograr una inteligencia artificial general (AGI) está produciendo sistemas cada vez más potentes, pero el verdadero desafío será conseguir que esta potencia esté respaldada por una fiabilidad equivalente.

Imagen de portada | Levart_Photographer

-

La noticia

Pensábamos que las nuevas IA alucinaban más que nunca. En realidad, el problema lo tiene OpenAI

fue publicada originalmente en

Genbeta

por

Antonio Vallejo

.