KI und Stromverbrauch: So viel Energie fressen ChatGPT und Co.

Ein Nutzeranfrage bei ChatGPT verbraucht einer Studie zufolge etwa zehnmal mehr Strom als eine Google-Suche. Lässt sich der Stromverbrauch verringern?Stromfresser ChatGPT: So viel Energie kostet eine KI-AnfrageDer Einsatz von Künstlicher Intelligenz wie ChatGPT oder Gemini bringt nicht nur Fortschritte in der Technologie, sondern auch erhebliche Umweltkosten mit sich. Laut einer Untersuchung von BestBrokers verbraucht eine einzelne Anfrage an ChatGPT etwa 2,9 Wattstunden Strom. Das ist rund zehnmal mehr als bei einer herkömmlichen Google-Suche, die mit etwa 0,3 Wattstunden auskommt. Doch was bedeutet das konkret?Das ist der Stromverbrauch von ChatGPT im JahrHochgerechnet auf ein Jahr ergibt sich für ChatGPT ein Stromverbrauch von etwa 226,82 Millionen Wattstunden allein für die Beantwortung von Nutzeranfragen. Dies entspricht jährlichen Stromkosten von rund 30 Millionen US-Dollar.Der Energieaufwand übersteigt den gesamten Jahresstromverbrauch von zwölf kleinen Ländern wie Grenada, Samoa oder Gibraltar. Für einen einzelnen Tag würde die verbrauchte Energiemenge sogar ausreichen, um ein ganzes Land wie Belgien oder Finnland vollständig mit Strom zu versorgen.Zum Vergleich: Mit dieser Energiemenge könnten etwa 3,13 Millionen Elektrofahrzeuge mit einer durchschnittlichen Batteriekapazität von 72,4 kWh vollständig aufgeladen werden.Ihr zockt gerne an der Konsole? Wie viel Strom eure Konsolen verbrauchen, zeigen wir euch in unserem Video:LinkPlayStation, Switch und Xbox: So viel Stromkosten verursachen KonsolenVerbraucht ChatGPT doch weniger Strom als gedacht?Zu einem anderen Schluss kommt das Team von Epoch AI. Ihren Berechnungen nach verbraucht GPT-4o im Schnitt etwa 0,3 Wattstunden. Grund für den niedrigeren Verbrauch: Effizientere Modelle, sparsamere Hardware und eine geringere Annahme der Tokenanzahl. 0,3 Wattstunden entsprechen dem Energieverbrauch einer LED-Lampe in wenigen Minuten. Selbst bei täglicher Nutzung macht ChatGPT nur einen winzigen Bruchteil des durchschnittlichen US-Haushaltsverbrauchs aus. Dennoch könnte der Energiebedarf mit leistungsfähigeren KI-Modellen künftig wieder steigen.So wird der Stromverbrauch von ChatGPT bestimmtDie unterschiedlichen Ergebnisse zeigen, dass sich der tatsächliche Stromverbrauch nicht exakt ermitteln lässt. Beide Studien können nur Richtwerte angeben. Klar ist, dass Künstliche Intelligenz sehr energieintensiv ist und das hat großen Einfluss auf die CO2-Emissionen.Der Energiebedarf von ChatGPT wird durch mehrere technische Faktoren beeinflusst. Entscheidend sind dabei sowohl die Architektur des KI-Modells als auch die Infrastruktur der Rechenzentren:Modellgröße: Große Sprachmodelle wie GPT-4 bestehen aus Milliarden Parametern. Je umfangreicher das Modell, desto mehr Rechenleistung und Strom sind nötig. Nutzung und Inferenz: Jede Nutzereingabe wird in Echtzeit berechnet. Das geschieht auf spezialisierten Chips (GPUs oder TPUs), die bei längeren oder komplexeren Anfragen deutlich mehr Strom benötigen. Training: Noch vor der Nutzung steht das Training. Dieser Prozess, bei dem riesige Datenmengen verarbeitet werden, dauert oft Wochen oder Monate und ist besonders energiehungrig. Rechenzentrum und Kühlung: Server, Netzwerke und die Kühlung der Hardware verbrauchen zusätzlich Energie. Neuere Rechenzentren sind zwar effizienter, aber der Kühlbedarf bleibt hoch. Wachsende Nutzung: Je mehr Menschen ChatGPT nutzen, desto höher wird der Gesamtverbrauch. Besonders zu Stoßzeiten steigt der Energiebedarf.Wie lässt sich der Stromverbrauch von ChatGPT senken?KI-Anbieter wie OpenAI arbeiten aktiv daran, die Energieeffizienz ihrer Systeme zu verbessern:Eine wichtige Rolle spielt dabei die Weiterentwicklung der Modelle. Neue Versionen sind so konzipiert, dass sie für jede Anfrage weniger Rechenleistung benötigen. Die Hardware wird weiter optimiert. Moderne Chips liefern mehr Leistung bei geringerem Stromverbrauch. Rechenzentren selbst setzen vermehrt auf umweltfreundliche Energiequellen, etwa Wind- oder Solarkraft und innovative Kühltechniken wie Flüssigkeitskühlung.Auch die Nutzer können zur Effizienz beitragen. Wer Fragen präzise formuliert, reduziert die nötige Rechenarbeit. Wiederholte Anfragen oder vage Eingaben treiben hingegen den Verbrauch in die Höhe. Zusätzlich hilft es, ChatGPT zu Randzeiten zu verwenden, wenn die Serverlast geringer ist. Das entlastet die Infrastruktur und spart ebenfalls Energie.

Ein Nutzeranfrage bei ChatGPT verbraucht einer Studie zufolge etwa zehnmal mehr Strom als eine Google-Suche. Lässt sich der Stromverbrauch verringern?

Stromfresser ChatGPT: So viel Energie kostet eine KI-Anfrage

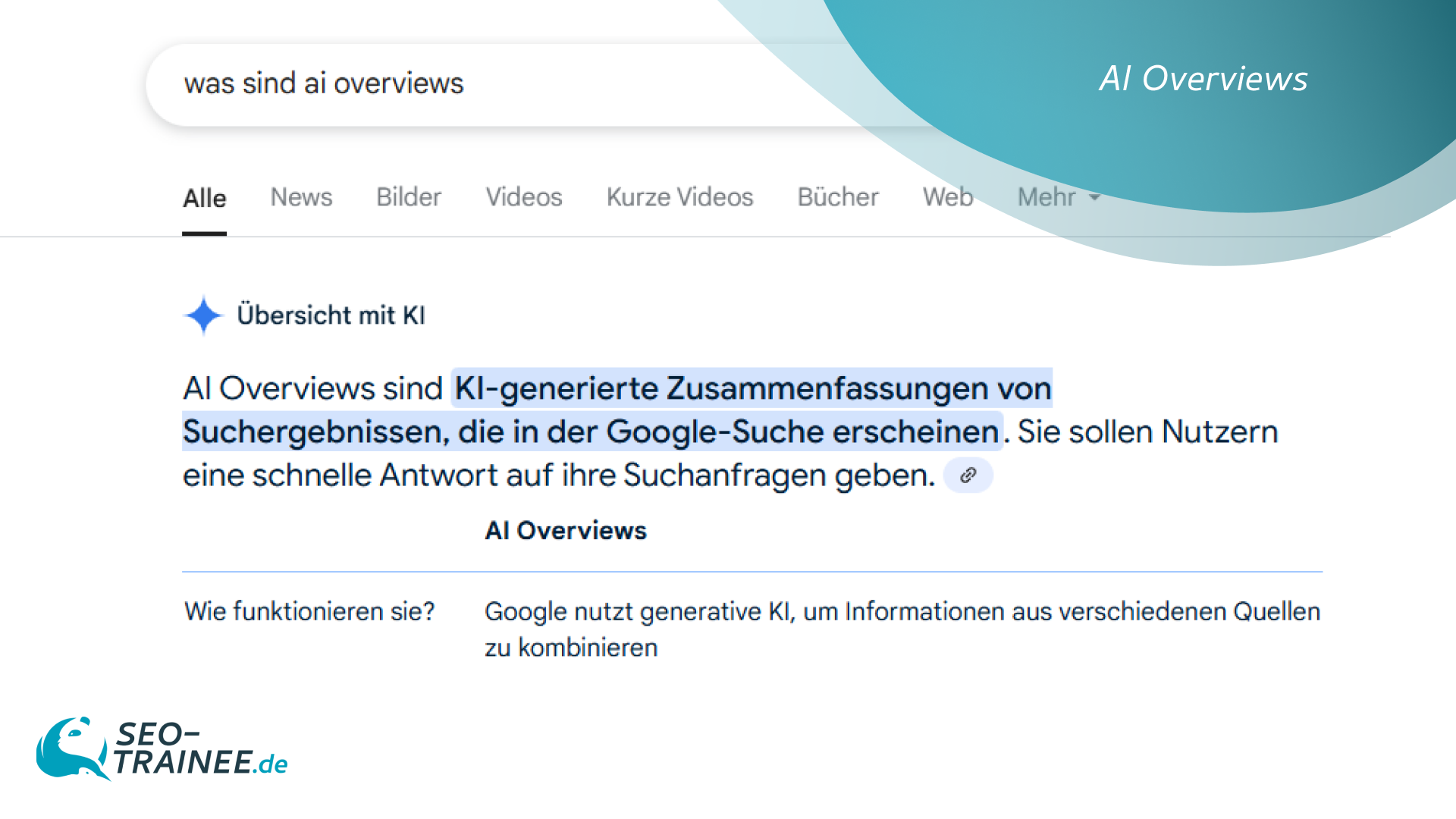

Der Einsatz von Künstlicher Intelligenz wie ChatGPT oder Gemini bringt nicht nur Fortschritte in der Technologie, sondern auch erhebliche Umweltkosten mit sich. Laut einer Untersuchung von BestBrokers verbraucht eine einzelne Anfrage an ChatGPT etwa 2,9 Wattstunden Strom. Das ist rund zehnmal mehr als bei einer herkömmlichen Google-Suche, die mit etwa 0,3 Wattstunden auskommt. Doch was bedeutet das konkret?

Das ist der Stromverbrauch von ChatGPT im Jahr

Hochgerechnet auf ein Jahr ergibt sich für ChatGPT ein Stromverbrauch von etwa 226,82 Millionen Wattstunden allein für die Beantwortung von Nutzeranfragen. Dies entspricht jährlichen Stromkosten von rund 30 Millionen US-Dollar.

Der Energieaufwand übersteigt den gesamten Jahresstromverbrauch von zwölf kleinen Ländern wie Grenada, Samoa oder Gibraltar. Für einen einzelnen Tag würde die verbrauchte Energiemenge sogar ausreichen, um ein ganzes Land wie Belgien oder Finnland vollständig mit Strom zu versorgen.

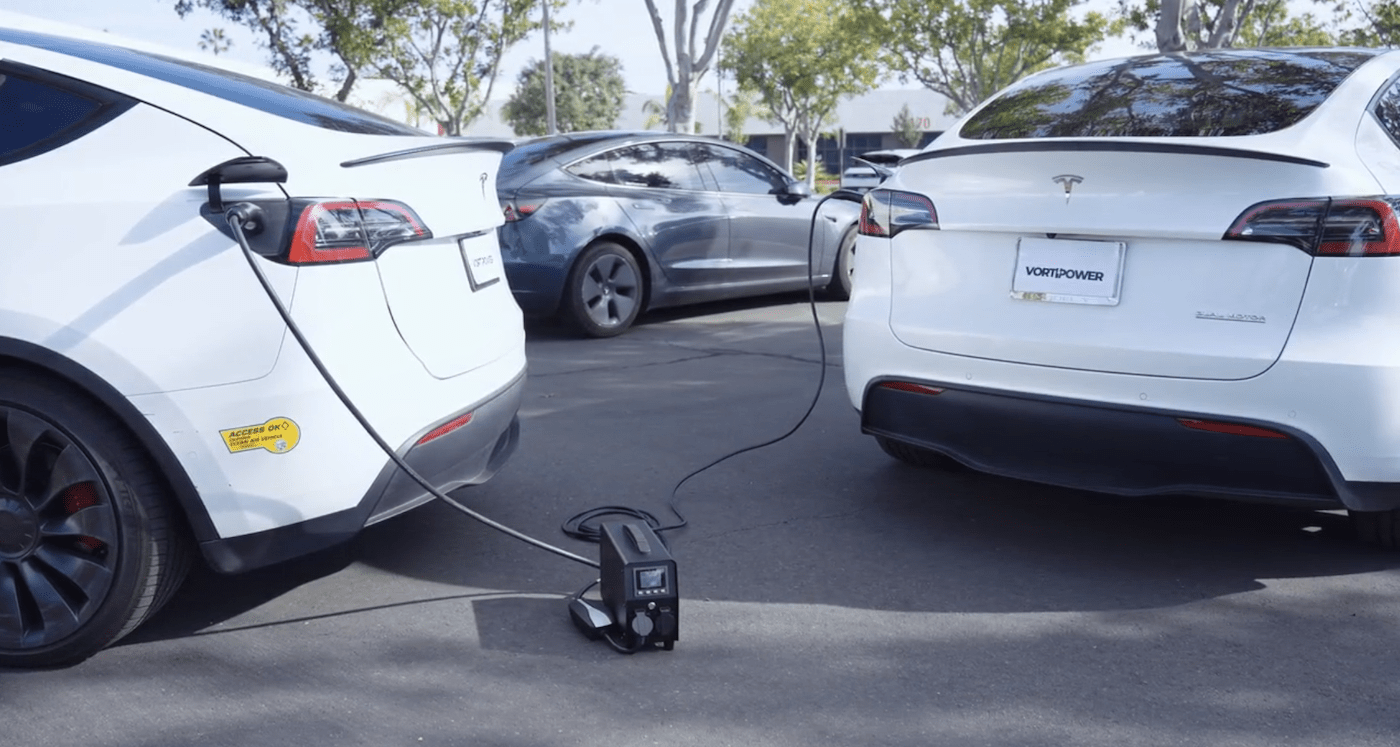

Zum Vergleich: Mit dieser Energiemenge könnten etwa 3,13 Millionen Elektrofahrzeuge mit einer durchschnittlichen Batteriekapazität von 72,4 kWh vollständig aufgeladen werden.

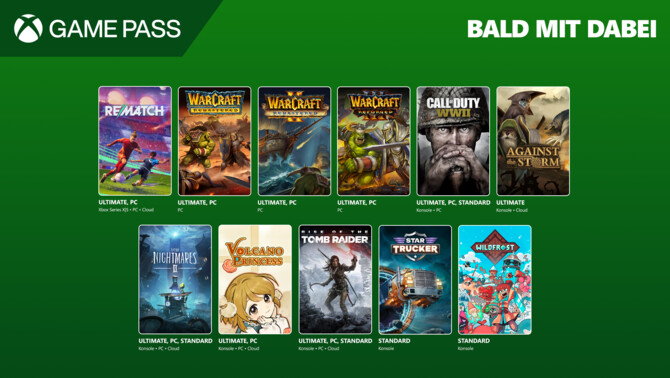

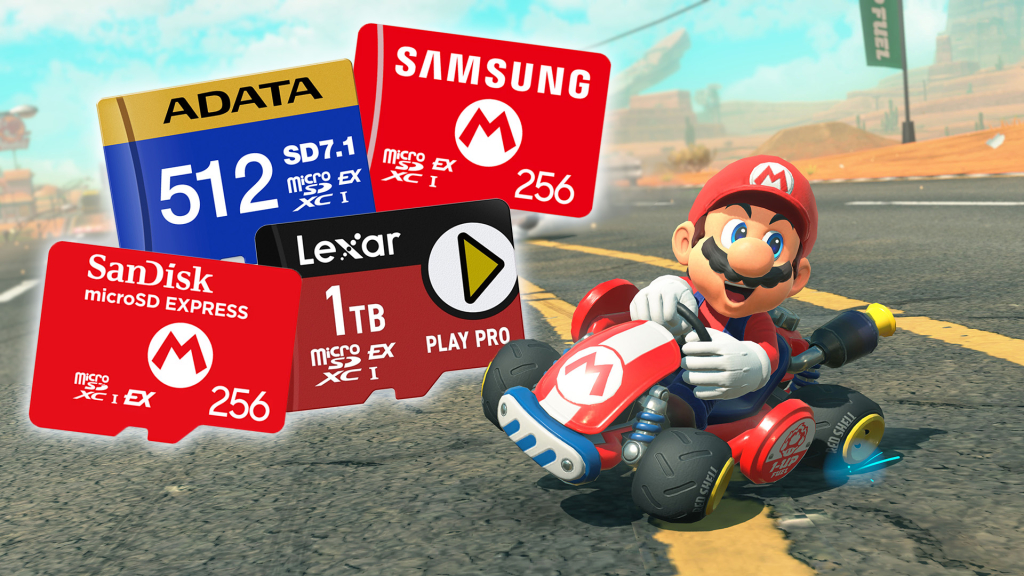

Ihr zockt gerne an der Konsole? Wie viel Strom eure Konsolen verbrauchen, zeigen wir euch in unserem Video:LinkPlayStation, Switch und Xbox: So viel Stromkosten verursachen Konsolen

Verbraucht ChatGPT doch weniger Strom als gedacht?

Zu einem anderen Schluss kommt das Team von Epoch AI. Ihren Berechnungen nach verbraucht GPT-4o im Schnitt etwa 0,3 Wattstunden. Grund für den niedrigeren Verbrauch: Effizientere Modelle, sparsamere Hardware und eine geringere Annahme der Tokenanzahl.

0,3 Wattstunden entsprechen dem Energieverbrauch einer LED-Lampe in wenigen Minuten. Selbst bei täglicher Nutzung macht ChatGPT nur einen winzigen Bruchteil des durchschnittlichen US-Haushaltsverbrauchs aus. Dennoch könnte der Energiebedarf mit leistungsfähigeren KI-Modellen künftig wieder steigen.

So wird der Stromverbrauch von ChatGPT bestimmt

Die unterschiedlichen Ergebnisse zeigen, dass sich der tatsächliche Stromverbrauch nicht exakt ermitteln lässt. Beide Studien können nur Richtwerte angeben. Klar ist, dass Künstliche Intelligenz sehr energieintensiv ist und das hat großen Einfluss auf die CO2-Emissionen.

Der Energiebedarf von ChatGPT wird durch mehrere technische Faktoren beeinflusst. Entscheidend sind dabei sowohl die Architektur des KI-Modells als auch die Infrastruktur der Rechenzentren:Modellgröße: Große Sprachmodelle wie GPT-4 bestehen aus Milliarden Parametern. Je umfangreicher das Modell, desto mehr Rechenleistung und Strom sind nötig. Nutzung und Inferenz: Jede Nutzereingabe wird in Echtzeit berechnet. Das geschieht auf spezialisierten Chips (GPUs oder TPUs), die bei längeren oder komplexeren Anfragen deutlich mehr Strom benötigen. Training: Noch vor der Nutzung steht das Training. Dieser Prozess, bei dem riesige Datenmengen verarbeitet werden, dauert oft Wochen oder Monate und ist besonders energiehungrig. Rechenzentrum und Kühlung: Server, Netzwerke und die Kühlung der Hardware verbrauchen zusätzlich Energie. Neuere Rechenzentren sind zwar effizienter, aber der Kühlbedarf bleibt hoch. Wachsende Nutzung: Je mehr Menschen ChatGPT nutzen, desto höher wird der Gesamtverbrauch. Besonders zu Stoßzeiten steigt der Energiebedarf.

Wie lässt sich der Stromverbrauch von ChatGPT senken?

KI-Anbieter wie OpenAI arbeiten aktiv daran, die Energieeffizienz ihrer Systeme zu verbessern:Eine wichtige Rolle spielt dabei die Weiterentwicklung der Modelle. Neue Versionen sind so konzipiert, dass sie für jede Anfrage weniger Rechenleistung benötigen. Die Hardware wird weiter optimiert. Moderne Chips liefern mehr Leistung bei geringerem Stromverbrauch. Rechenzentren selbst setzen vermehrt auf umweltfreundliche Energiequellen, etwa Wind- oder Solarkraft und innovative Kühltechniken wie Flüssigkeitskühlung.

Auch die Nutzer können zur Effizienz beitragen. Wer Fragen präzise formuliert, reduziert die nötige Rechenarbeit. Wiederholte Anfragen oder vage Eingaben treiben hingegen den Verbrauch in die Höhe. Zusätzlich hilft es, ChatGPT zu Randzeiten zu verwenden, wenn die Serverlast geringer ist. Das entlastet die Infrastruktur und spart ebenfalls Energie.

,regionOfInterest=(225,152)&hash=ffd23fabdf1869757dfb76efeee20728411bdd5dd733efea8e636a2a3ce50444#)

![waipu.tv Comfort nur 1 Euro pro Monat [mehr als 230 TV-Sender, 200+ in HD]](https://www.macerkopf.de/wp-content/uploads/2025/06/waipu190625.jpg)

![SEO-Relaunch: 7 Punkte, die nicht verhandelbar sein dürfen! [Search Camp 377]](https://blog.bloofusion.de/wp-content/uploads/2025/06/Search-Camp-Canva-377.png)

![Das HR-Power-Pack: SEO, SEA + Social Ads für die Mitarbeitergewinnung [Search Camp 376]](https://blog.bloofusion.de/wp-content/uploads/2025/05/Search-Camp-Canva-376.png)

![SEO-Monatsrückblick Mai 2025: AIOs, AI Mode, llms.txt + mehr [Search Camp 375]](https://blog.bloofusion.de/wp-content/uploads/2025/06/Search-Camp-Canva-375.png)

![Deals: XL-Eismaschine - Dieses starke Gerät hat das Zeug ein wahrer Sommer-Hit zu werden! [Anzeige]](https://images.cgames.de/images/gamestar/4/klarstein-sweet-swirl-eismaschine-teaser_6359887.jpg?#)

:quality(80)/p7i.vogel.de/wcms/f9/41/f9414ce31e8109abe69fe576bf3bfdcb/0125224403v2.jpeg?#)

:quality(80)/p7i.vogel.de/wcms/09/6a/096ad833b4ff28862dfb18e0dc3ea094/0125079793v1.jpeg?#)

:quality(80)/p7i.vogel.de/wcms/f5/6a/f56a8dc563be39d4430039d1a931f114/0124922822v1.jpeg?#)

:quality(80)/p7i.vogel.de/wcms/57/10/5710f3147838b737126b59f13e6fcf62/0125079681v2.jpeg?#)