Check Point Research presenta il primo AI Security Report

Check Point Software Technologies Ltd. ha presentato il suo primo AI Security Report, un documento che esamina in maniera approfondita come i cybercriminali stiano... L'articolo Check Point Research presenta il primo AI Security Report proviene da Batista70.

Check Point Software Technologies Ltd. ha presentato il suo primo AI Security Report, un documento che esamina in maniera approfondita come i cybercriminali stiano utilizzando le armi dell’intelligenza artificiale per costruire e distribuire strumenti progettati per un uso malevolo.

L’intelligenza artificiale, oltre a rimodellare i settori, ha anche reso labili i confini tra verità e inganno nel mondo digitale. I criminali informatici ora utilizzano l’IA generativa e i modelli linguistici di grandi dimensioni (LLM) per delegittimare e distruggere la fiducia nell’identità digitale. Nel panorama odierno, non si può più credere a ciò che si vede, si sente o si legge online. L’impersonificazione basata sull’intelligenza artificiale aggira anche i più sofisticati sistemi di verifica dell’identità, rendendo chiunque una potenziale vittima di truffe su larga scala.

“La rapida adozione dell’intelligenza artificiale da parte dei criminali informatici sta già ridisegnando il panorama delle minacce”, ha dichiarato Lotem Finkelstein, Director di Check Point Research. “Mentre alcuni servizi clandestini sono diventati più avanzati, tutti i segnali indicano un cambiamento imminente: l’ascesa dei cosiddetti gemelli digitali. Non si tratta di semplici sosia visivi o sonori, ma di repliche guidate dall’intelligenza artificiale in grado di imitare il pensiero e il comportamento umano. Non è un futuro lontano, è proprio dietro l’angolo”.

Al centro di questi sviluppi c’è la capacità dell’IA di impersonare e manipolare in modo convincente le identità digitali, dissolvendo il confine tra autentico e falso. Il rapporto individua quattro aree principali in cui questa erosione della fiducia è più visibile:

- Impersonificazione e ingegneria sociale potenziate dall’intelligenza artificiale. Gli attori delle minacce utilizzano l’intelligenza artificiale per generare e-mail di phishing realistiche e in tempo reale, impersonificazioni audio e video deepfake. In particolare, di recente gli aggressori hanno imitato il ministro della Difesa italiano utilizzando l’audio generato dall’IA, dimostrando che nessuna voce, volto o parola scritta online è al sicuro dalla contraffazione.

- Avvelenamento e disinformazione dei dati LLM. Attori malintenzionati manipolano i dati di addestramento dell’IA per alterarne i risultati. Un caso che ha coinvolto la rete di disinformazione russa Pravda ha mostrato che i chatbot dell’IA hanno ripetuto narrazioni false il 33% delle volte, sottolineando la necessità di una solida integrità dei dati nei sistemi di IA.

- Malware e data mining creati dall’IA. I criminali informatici sfruttano l’IA per creare e ottimizzare il malware, automatizzare le campagne DDoS e perfezionare le credenziali rubate. Servizi come Gabbers Shop utilizzano l’intelligenza artificiale per convalidare e ripulire i dati rubati, aumentandone il valore di rivendita e l’efficienza del targeting.

- Armamento e dirottamento dei modelli di IA. Dagli account LLM rubati ai Dark LLM personalizzati come FraudGPT e WormGPT, gli aggressori stanno aggirando i meccanismi di sicurezza e commercializzando l’IA come strumento di hacking e frode sul dark web.

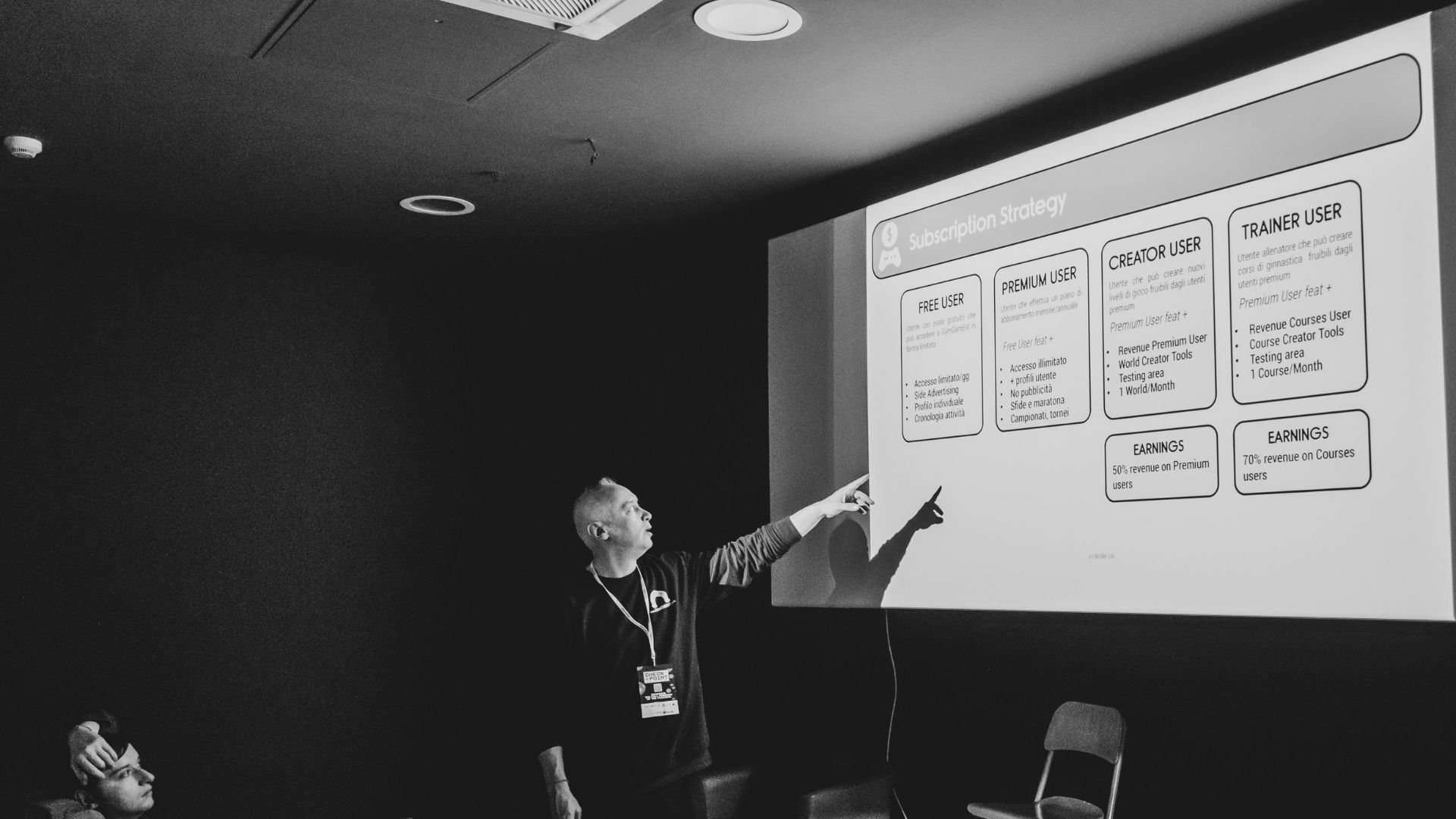

Strategie difensive:

Il rapporto sottolinea che i difensori devono ormai partire dal presupposto che l’intelligenza artificiale sia incorporata nelle campagne avversarie. Per contrastare questo fenomeno, le organizzazioni dovrebbero adottare strutture di sicurezza informatica consapevoli dell’intelligenza artificiale, tra cui:

- Rilevamento assistito dall’intelligenza artificiale e caccia alle minacce. Sfruttare l’IA per rilevare le minacce e gli artefatti generati dall’IA, come i contenuti sintetici di phishing e i deepfake.

- Verifica dell’identità avanzata e dell’identità potenziata. Superare i metodi tradizionali e implementare controlli di identità a più livelli che tengano conto dell’impersonificazione basata sull’intelligenza artificiale attraverso testi, voci e video, riconoscendo che la fiducia nell’identità digitale non è più garantita.

- Threat Intelligence nel contesto dell’IA. Dotare i team di sicurezza degli strumenti necessari per riconoscere e rispondere alle tattiche guidate dall’intelligenza artificiale.

“In quest’era guidata dall’intelligenza artificiale, i team di sicurezza informatica devono tenere il passo degli aggressori integrando l’intelligenza artificiale nelle loro difese”, aggiunge Finkelstein. “Questo rapporto non solo evidenzia i rischi, ma fornisce una tabella di marcia per proteggere gli ambienti AI in modo sicuro e responsabile”.

L’AI Security Report 2025 di Check Point è disponibile per il download qui.

L'articolo Check Point Research presenta il primo AI Security Report proviene da Batista70.

/https://www.ilsoftware.it/app/uploads/2023/07/hacker-malware-3.jpg)

/https://www.ilsoftware.it/app/uploads/2025/02/Incogni-tool-privacy.jpg)

/https://www.ilsoftware.it/app/uploads/2025/03/143.jpg)

/https://www.html.it/app/uploads/2025/02/visual-studio-code.png)

![Xbox Game Pass, ecco gli ultimi giochi gratis di maggio [AGG.]](https://cdn.spaziogames.it/storage/media/2023/06/2518/xbox-game-pass.jpg)