El CEO de Google dijo que no sabían por qué su IA aprendía cosas inesperadas. Estamos empezando a entenderlo

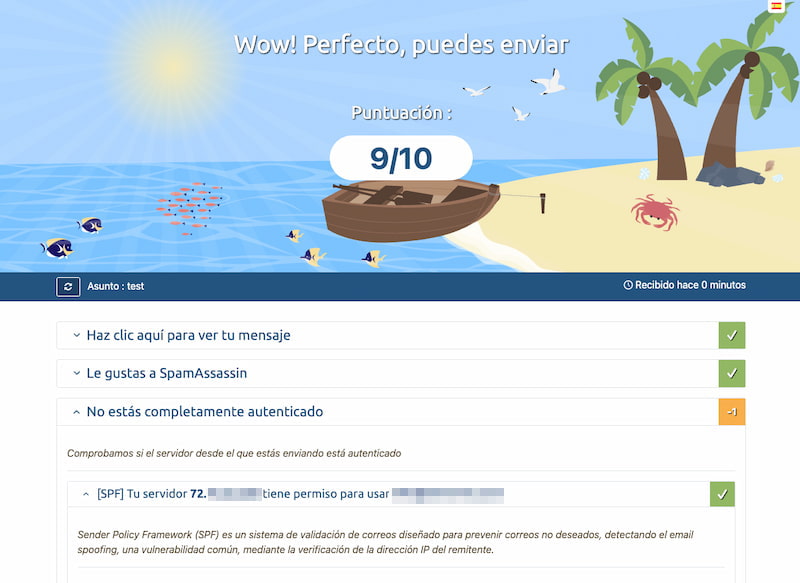

Los investigadores de la empresa de inteligencia artificial o IA Anthropic, creadores de Claude, afirman haber logrado un avance muy importante en la comprensión de cómo funcionan exactamente los grandes modelos de lenguaje (LLM por sus siglas en inglés). Concretamente, dicen poder comprender ahora mejor sus cajas negras. Uno de los problemas de las herramientas de IA que usamos, basada en grandes modelos lingüísticos (LLM), es que los modelos son cajas negras. Podemos saber qué instrucciones les damos y qué resultados producen, pero cómo llegan exactamente a una respuesta concreta es un misterio, incluso para investigadores y desarrolladores de las diferentes soluciones de inteligencia artificial que usamos a menudo. En Genbeta Un desarrollador preguntó qué IA es mejor para programar. Los más de 28.000 votos fueron muy contundentes Por ejemplo, en el caso de Google, su CEO Sundar Pichai, ya explicó en el pasado que en el "sector llamamos una "caja negra" cuando algo no se entiende completamente”. Es decir, que ni sus creadores pueden decir muy bien por qué una IA hizo algo, por qué hubo un error en el proceso hasta llegar al resultado. Con el problema de las cajas negras resulta difícil predecir las probabilidades de que un modelo vaya a arrojar información errónea. Como publicaba a finales de 2023 Scientific American, las cajas negras de IA se refieren al funcionamiento interno de sistemas de inteligencia artificial que son invisibles para el usuario: una IA "puede proporcionar información y obtener resultados, pero "no puede examinar el código del sistema o la lógica que produjo el resultado". Ahora Anthropic dice tener mayor claridad en este asunto. La firma ha realizado una investigación que ofrece una vía para resolver algunos de estos problemas y, para ello, los científicos crearon una herramienta para descifrar cómo "piensan" los LLM. Esta investigación sirve para comprender sus herramientas y también cualquier otra IA. Qué ha analizado Anthropic Básicamente, lo que los investigadores de Anthropic han creado para la comprensión de la IA se parece a los escáneres fMRI que los neurocientíficos utilizan para escanear el cerebro de los sujetos humanos de investigación y descubrir qué regiones cerebrales parecen desempeñar el papel más importante en diferentes aspectos de la cognición. Tras inventar esta herramienta similar a la IRMf, Anthropic la aplicó al modelo Claude 3.5 Haiku de Anthropic. De este modo, pudieron resolver varias cuestiones clave sobre el funcionamiento de Claude y, de acuerdo con la información compartida, creen que puede servir para la mayoría de los LLM. En Genbeta Unos profesores avisan de que la IA supone una amenaza para el pensamiento crítico de los estudiantes: "escribir también es pensar" Los investigadores de Anthropic y otros centros estudian los grandes modelos lingüísticos como si fueran fenómenos naturales y no programas informáticos creados por el hombre. Esto se debe a que los modelos se entrenan, no se programan, tal y como explican desde el Instituto Tecnológico de Massachusetts o MIT. Entre otros asuntos, afirman desde la empresa que se plantearon cuestiones para luego resolverlas y comprender mejor a su IA, Quisieron saber, por ejemplo, que si Claude puede hablar docenas de idiomas, cuál es el idioma que más usa en sus procesos. O también plantearon cómo formula Claude un texto, si se centra sólo en predecir la palabra siguiente o planifica alguna vez. En Genbeta Todas las IA mostraban menos coeficiente intelectual que un humano medio en esta prueba. Esta ha roto la barrera Por otro lado, decidieron mirar dentro de Claude 3.5 Haiku, realizando estudios en profundidad de tareas sencillas representativas de diez comportamientos cruciales del modelo, incluyendo del uso de idiomas y cómo desarrolla textos. Otra de sus pruebas se basó en comprender cómo realizar cálculos matemáticos y los científicos demostraron con un gráfico el complejo proceso que Claude usa para realizar cuentas y obtener los resultados. Qué encontró Anthropic Según recoge el MIT, Anthropic analizó 10 comportamientos diferentes en Claude. Uno de ellos es el uso de diferentes idiomas. "¿Tiene Claude una parte que habla francés y otra que habla chino, y así sucesivamente?" ha sido una de las cuestiones planteadas. El equipo descubrió que Claude utilizaba componentes independientes de cualquier idioma para responder a una pregunta o resolver un problema y luego elegía un idioma específico cuando respondía. Le preguntaron: "¿Qué es lo contrario de pequeño?" en inglés, francés y chino, y vieron que Claude utilizará primero los componentes independientemente de la lengua para dar una respuesta. En Genbeta La biblioteca de prompts de Anth

Los investigadores de la empresa de inteligencia artificial o IA Anthropic, creadores de Claude, afirman haber logrado un avance muy importante en la comprensión de cómo funcionan exactamente los grandes modelos de lenguaje (LLM por sus siglas en inglés). Concretamente, dicen poder comprender ahora mejor sus cajas negras.

Uno de los problemas de las herramientas de IA que usamos, basada en grandes modelos lingüísticos (LLM), es que los modelos son cajas negras. Podemos saber qué instrucciones les damos y qué resultados producen, pero cómo llegan exactamente a una respuesta concreta es un misterio, incluso para investigadores y desarrolladores de las diferentes soluciones de inteligencia artificial que usamos a menudo.

Por ejemplo, en el caso de Google, su CEO Sundar Pichai, ya explicó en el pasado que en el "sector llamamos una "caja negra" cuando algo no se entiende completamente”. Es decir, que ni sus creadores pueden decir muy bien por qué una IA hizo algo, por qué hubo un error en el proceso hasta llegar al resultado. Con el problema de las cajas negras resulta difícil predecir las probabilidades de que un modelo vaya a arrojar información errónea.

Como publicaba a finales de 2023 Scientific American, las cajas negras de IA se refieren al funcionamiento interno de sistemas de inteligencia artificial que son invisibles para el usuario: una IA "puede proporcionar información y obtener resultados, pero "no puede examinar el código del sistema o la lógica que produjo el resultado".

Ahora Anthropic dice tener mayor claridad en este asunto. La firma ha realizado una investigación que ofrece una vía para resolver algunos de estos problemas y, para ello, los científicos crearon una herramienta para descifrar cómo "piensan" los LLM. Esta investigación sirve para comprender sus herramientas y también cualquier otra IA.

Qué ha analizado Anthropic

Básicamente, lo que los investigadores de Anthropic han creado para la comprensión de la IA se parece a los escáneres fMRI que los neurocientíficos utilizan para escanear el cerebro de los sujetos humanos de investigación y descubrir qué regiones cerebrales parecen desempeñar el papel más importante en diferentes aspectos de la cognición.

Tras inventar esta herramienta similar a la IRMf, Anthropic la aplicó al modelo Claude 3.5 Haiku de Anthropic. De este modo, pudieron resolver varias cuestiones clave sobre el funcionamiento de Claude y, de acuerdo con la información compartida, creen que puede servir para la mayoría de los LLM.

Los investigadores de Anthropic y otros centros estudian los grandes modelos lingüísticos como si fueran fenómenos naturales y no programas informáticos creados por el hombre. Esto se debe a que los modelos se entrenan, no se programan, tal y como explican desde el Instituto Tecnológico de Massachusetts o MIT.

Entre otros asuntos, afirman desde la empresa que se plantearon cuestiones para luego resolverlas y comprender mejor a su IA, Quisieron saber, por ejemplo, que si Claude puede hablar docenas de idiomas, cuál es el idioma que más usa en sus procesos. O también plantearon cómo formula Claude un texto, si se centra sólo en predecir la palabra siguiente o planifica alguna vez.

Por otro lado, decidieron mirar dentro de Claude 3.5 Haiku, realizando estudios en profundidad de tareas sencillas representativas de diez comportamientos cruciales del modelo, incluyendo del uso de idiomas y cómo desarrolla textos.

Otra de sus pruebas se basó en comprender cómo realizar cálculos matemáticos y los científicos demostraron con un gráfico el complejo proceso que Claude usa para realizar cuentas y obtener los resultados.

Qué encontró Anthropic

Según recoge el MIT, Anthropic analizó 10 comportamientos diferentes en Claude. Uno de ellos es el uso de diferentes idiomas. "¿Tiene Claude una parte que habla francés y otra que habla chino, y así sucesivamente?" ha sido una de las cuestiones planteadas.

El equipo descubrió que Claude utilizaba componentes independientes de cualquier idioma para responder a una pregunta o resolver un problema y luego elegía un idioma específico cuando respondía. Le preguntaron: "¿Qué es lo contrario de pequeño?" en inglés, francés y chino, y vieron que Claude utilizará primero los componentes independientemente de la lengua para dar una respuesta.

Tras eso, elegirá una lengua concreta para responder. Esto sugiere que los grandes modelos lingüísticos pueden aprender cosas en una lengua y aplicarlas en otras.

Anthropic también observó cómo Claude resolvía problemas matemáticos sencillos. El equipo descubrió que el modelo parece haber desarrollado sus propias estrategias internas, distintas de las que ha visto en sus datos de entrenamiento.

Una tercera tarea que estudió Anthropic fue la escritura de poemas. Los investigadores querían saber si el modelo se limitaba a improvisar, prediciendo una palabra a cada vez. Pero no fue así y descubrieron que Claude, de alguna manera, mira hacia delante, eligiendo la palabra al final de la línea siguiente.

Según la empresa: "Estos hallazgos no sólo son interesantes desde el punto de vista científico, sino que suponen un avance significativo hacia nuestro objetivo de comprender los sistemas de IA y asegurarnos de que son fiables".

Además, la firma dice que tiene el objetivo y la esperanza de que resulten útiles a otros grupos y, potencialmente, en otros ámbitos: por ejemplo, las técnicas de interpretabilidad se han utilizado en campos como la imagen médica y la genómica, "ya que diseccionar los mecanismos internos de los modelos entrenados para aplicaciones científicas puede revelar nuevos conocimientos sobre la ciencia".

La empresa se ha sorprendido con muchos hallazgos

En sus conclusiones, Anthropic afirma que se ha sorprendido con muchos de sus descubrimientos. Por ejemplo, en el estudio del caso de la poesía, "nos habíamos propuesto demostrar que el modelo no planificaba con antelación, y descubrimos que sí lo hacía".

Otro ejemplo es que "en una respuesta a un ejemplo de fuga de la cárcel, descubrimos que el modelo reconocía que se le había pedido información peligrosa mucho antes de ser capaz de reconducir la conversación".

Aunque la firma dice estar convencida de que sus hallazgos son ahora muy útiles para los fabricantes de otras IA y para clarificar más cómo es todo el proceso hasta llegar a resultados, "reconocemos las limitaciones de nuestro enfoque actual. Incluso en indicaciones cortas y sencillas, nuestro método sólo capta una fracción del cálculo total realizado por Claude, y los mecanismos que vemos pueden tener algunos artefactos basados en nuestras herramientas que no reflejan lo que ocurre en el modelo subyacente".

Y afirma que "en la actualidad se necesitan varias horas de esfuerzo humano para comprender los circuitos que vemos, incluso en indicaciones con sólo decenas de palabras. Para llegar a los miles de palabras que soportan las complejas cadenas de pensamiento que utilizan los modelos modernos, tendremos que mejorar tanto el método como (quizá con ayuda de la IA) la forma de dar sentido a lo que vemos con él".

Qué sucede en OpenAI y Google con las cajas negras

En junio del pasado año, OpenAI daba un gran paso adelante en la investigación de la inteligencia artificial al descubrir una manera de entender mejor cómo funcionan sus 'modelos de lenguaje'. Concretamente, la firma que ha creado ChatGPT desarrolló nuevas metodologías que permiten escalar sus autoencoders dispersos a decenas de millones de características en modelos de IA avanzados.

Como explicaba OpenAI en ese momento, las activaciones neuronales de los modelos tienen patrones impredecibles que dificultan su estudio. Los codificadores dispersos llegan para brindar un poco de luz. Estos eran capaces de recuperar decenas de millones de características de los modelos para entenderlos mejor. De todos modos, desde junio de 2024 OpenAI no ha compartido información relevante de novedades al respecto de este tema.

En cuanto a Google, sus propios directivos explicaron abiertamente que es normal no entender todos los procesos por los que una IA llega a un resultado. En abril de 2023, expertos de Google explicaban que las herramientas de inteligencia artificial de la empresa estaban aprendiendo habilidades que no se esperaba que tuvieran.

Por ejemplo, un programa de IA de Google se adaptó, por sí solo, después de que se le preguntara en el idioma de Bangladesh", el cual no estaba entrenado para conocer”. A esto, un entrevistador de CBS les cuestionaba: “ustedes no entienden completamente cómo funciona, y sin embargo, ¿la han puesto a disposición de la sociedad?”. El CEO, Sundar Pichai respondió que no es algo grave y es que, alegó que “tampoco creo que entendamos del todo cómo funciona la mente humana”.

Imagen | Foto de Sam Moghadam en Unsplash

-

La noticia

El CEO de Google dijo que no sabían por qué su IA aprendía cosas inesperadas. Estamos empezando a entenderlo

fue publicada originalmente en

Genbeta

por

Bárbara Bécares

.