Kennzeichnungspflicht für KI-Inhalte: Die Position der BRAK

Mit der neuen EU-Verordnung über künstliche Intelligenz (KI-VO), die am 1. August 2024 in Kraft getreten ist, stehen Anbieter und Betreiber von KI-Systemen vor neuen Transparenzpflichten. Insbesondere der Artikel 50 KI-VO regelt, dass KI-generierte Inhalte klar als solche gekennzeichnet werden müssen. Die Bundesrechtsanwaltskammer (BRAK) nimmt in ihrer aktuellen Stellungnahme hierzu kritisch Stellung und fordert teilweise […]

Mit der neuen EU-Verordnung über künstliche Intelligenz (KI-VO), die am 1. August 2024 in Kraft getreten ist, stehen Anbieter und Betreiber von KI-Systemen vor neuen Transparenzpflichten. Insbesondere der Artikel 50 KI-VO regelt, dass KI-generierte Inhalte klar als solche gekennzeichnet werden müssen. Die Bundesrechtsanwaltskammer (BRAK) nimmt in ihrer aktuellen Stellungnahme hierzu kritisch Stellung und fordert teilweise strengere Regelungen.

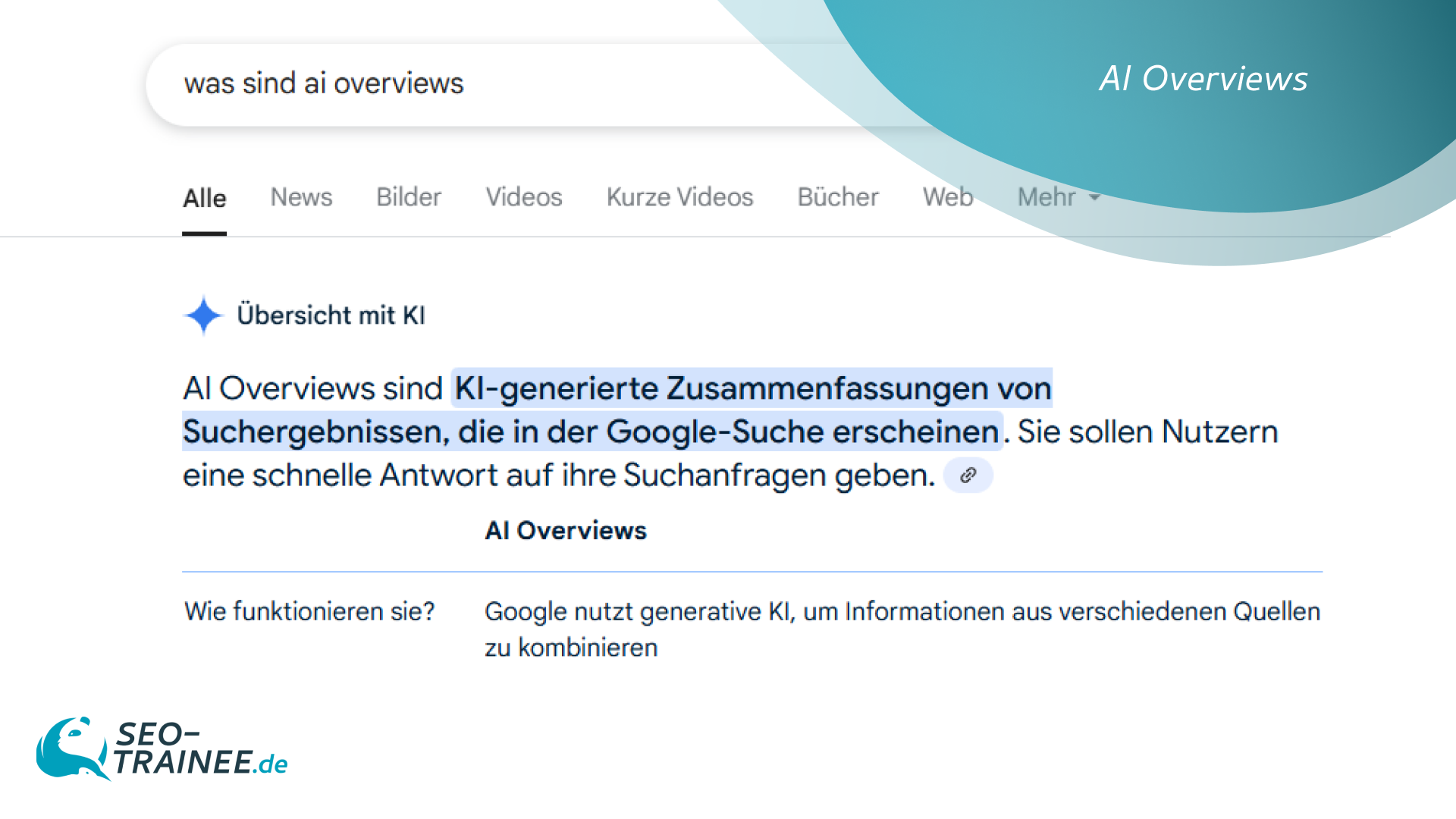

Kennzeichnungspflichten für KI-Inhalte

Ab dem 2. August 2026 müssen nach Artikel 50 KI-VO:

- KI-Interaktionen mit Menschen erkennbar sein.

- KI-generierte Texte, Bilder, Videos und Audios als solche markiert werden.

- Deepfakes ausdrücklich als manipulierte Inhalte gekennzeichnet werden.

Interaktion mit natürlichen Personen:

Anbieter müssen gewährleisten, dass Nutzer informiert werden, wenn sie mit einem KI-System interagieren, es sei denn, dies ist aufgrund der Umstände und des Nutzungskontexts offensichtlich.

Kennzeichnung synthetischer Inhalte:

KI-Systeme, die synthetische, künstliche Audio-, Bild-, Video- oder Textinhalte erzeugen, müssen sicherstellen, dass diese Ausgaben in maschinenlesbarem Format gekennzeichnet und als künstlich erzeugt oder manipuliert erkennbar sind.

Offenlegung von Deepfakes:

Betreiber müssen sicherstellen, dass durch das KI-System erzeugte Deepfake-Inhalte als solche offengelegt werden.

Die BRAK argumentiert in ihrer Stellungnahme, dass auch privat oder ehrenamtlich erstellte KI-Inhalte der Kennzeichnungspflicht unterliegen sollten, um Irreführung zu vermeiden.

Ausnahmen der Kennzeichnungspflichten

Dabei gelten für KMU erleichterte Dokumentations- und Berichtspflichten, sofern die Sicherheit nicht beeinträchtigt wird. Grundlegende Transparenzpflichten wie die Kennzeichnung von Deepfakes oder Emotionserkennung müssen aber auch KMU erfüllen – ggf. mit technischen Hilfsmitteln und Beratung.

Offensichtlichkeit der KI-Nutzung:

Wenn klar erkennbar ist, dass es sich um ein KI-System handelt (z. B. bei einem sprechenden Roboter mit offensichtlich maschineller Stimme), entfällt die Pflicht zur aktiven Offenlegung.

Ausnahmen für rechtmäßige Strafverfolgung:

Bei der Verwendung synthetischer Inhalte zu Zwecken der Strafverfolgung oder verdeckten Ermittlungen, können Transparenzpflichten eingeschränkt werden, wenn:

- eine entsprechende Rechtsgrundlage im nationalen Recht besteht,

- die Nutzung verhältnismäßig und erforderlich ist.

Kritik an Emotionserkennungssystemen

Besonders kritisch sieht die BRAK den Einsatz von Emotionserkennungssystemen und biometrischen Kategorisierungssystemen. Hier bestünden erhebliche rechtliche Bedenken, insbesondere in Bezug auf den Datenschutz und mögliche Grundrechtsverletzungen.

Private Rechtsdurchsetzung stärken

Die BRAK fordert zudem effektive rechtliche Möglichkeiten für Einzelpersonen, Verstöße gegen die KI-Verordnung zu ahnden. Dies könne durch:

- Erweiterung des Wettbewerbsrechts,

- privatrechtliche Klagemöglichkeiten,

- nationale Regelungen zur Kennzeichnungspflicht erreicht werden.

Plädoyer für mehr Schutz

Die KI-VO setzt einen wichtigen Schritt in Richtung Transparenz und Regulierung von KI-Systemen. Die BRAK plädiert für eine striktere Auslegung der Kennzeichnungspflicht, um Manipulation und Irreführung zu verhindern. Zudem sollten nationale Regelungen ergänzt werden, um den Verbraucherschutz zu stärken. Emotionserkennungssysteme sind tatsächlich aus datenschutzrechtlicher Sicht besonders problematisch. Sie greifen tief in die Privatsphäre der Nutzer ein und bergen Risiken der Diskriminierung oder Fehlinterpretation. Sie ermöglichen auch eine neue Form der Leistungs- und Verhaltenskontrolle. Ein Beispiel, werden zum Beispiel Microsoft Teams Sitzungen transkribiert und mit einer Emotionserkennung versehen, kann ein Mitarbeiter mit den entsprechenden Berechtigungen eine Auswertung durchführen, mit welcher Stimmung der Mitarbeiter welche Beiträge in den Teams Meetings beigetragen hat. Zudem birgt die erwähnte und erweiterte Rechtsdurchsetzung potenzielle Nachteile. So könnten Abmahnungen missbräuchlich genutzt werden, um Unternehmen oder gerade auch Einzelpersonen unter Druck zu setzen. Unbedingt vermieden sollten rechtliche Möglichkeiten, welche sich leicht für Abmahnmissbrauch instrumentalisieren lassen könnten.

Gefällt Ihnen der Beitrag?

Dann unterstützen Sie uns doch mit einer Empfehlung per:

TWITTER FACEBOOK E-MAIL XING

Oder schreiben Sie uns Ihre Meinung zum Beitrag:

HIER KOMMENTIEREN

© www.intersoft-consulting.de

,regionOfInterest=(225,152)&hash=ffd23fabdf1869757dfb76efeee20728411bdd5dd733efea8e636a2a3ce50444#)

![waipu.tv Comfort nur 1 Euro pro Monat [mehr als 230 TV-Sender, 200+ in HD]](https://www.macerkopf.de/wp-content/uploads/2025/06/waipu190625.jpg)

![SEO-Relaunch: 7 Punkte, die nicht verhandelbar sein dürfen! [Search Camp 377]](https://blog.bloofusion.de/wp-content/uploads/2025/06/Search-Camp-Canva-377.png)

![Das HR-Power-Pack: SEO, SEA + Social Ads für die Mitarbeitergewinnung [Search Camp 376]](https://blog.bloofusion.de/wp-content/uploads/2025/05/Search-Camp-Canva-376.png)

![SEO-Monatsrückblick Mai 2025: AIOs, AI Mode, llms.txt + mehr [Search Camp 375]](https://blog.bloofusion.de/wp-content/uploads/2025/06/Search-Camp-Canva-375.png)

![Deals: XL-Eismaschine - Dieses starke Gerät hat das Zeug ein wahrer Sommer-Hit zu werden! [Anzeige]](https://images.cgames.de/images/gamestar/4/klarstein-sweet-swirl-eismaschine-teaser_6359887.jpg?#)

:quality(80)/p7i.vogel.de/wcms/f9/41/f9414ce31e8109abe69fe576bf3bfdcb/0125224403v2.jpeg?#)

:quality(80)/p7i.vogel.de/wcms/09/6a/096ad833b4ff28862dfb18e0dc3ea094/0125079793v1.jpeg?#)

:quality(80)/p7i.vogel.de/wcms/f5/6a/f56a8dc563be39d4430039d1a931f114/0124922822v1.jpeg?#)

:quality(80)/p7i.vogel.de/wcms/57/10/5710f3147838b737126b59f13e6fcf62/0125079681v2.jpeg?#)